Micro-YOLO:探索目标检测压缩模型的有效方法(附论文下载)

点击下方“AI算法与图像处理”,一起进步!

重磅干货,第一时间送达

计算机视觉研究院专栏

作者:Edison_G

深度学习模型在目标检测的性能上取得了重大突破。然而,在传统模型中,例如Faster R-CNN和YOLO,由于计算资源有限和功率预算紧张,这些网络的规模使其难以部署在嵌入式移动设备上。

深度学习模型在目标检测的性能上取得了重大突破。然而,在传统模型中,例如Faster R-CNN和YOLO,由于计算资源有限和功率预算紧张,这些网络的规模使其难以部署在嵌入式移动设备上。

深度学习领域的加速发展极大地促进了目标检测的发展,其在人脸检测、自动驾驶、机器人视觉和视频监控等方面的广泛应用。随着目标检测的蓬勃发展,近年来提出了几种深度卷积神经网络模型,例如R-CNN、SSD和YOLO等。然而,随着网络变得越来越复杂,这些模型的规模不断增加,这使得在现实生活中将这些模型部署到嵌入式设备上变得越来越困难。因此,开发一种高效快速的物体检测模型以在不影响目标检测质量的情况下减小参数大小至关重要。

二、背景

随着目标检测网络系列不断变得更加复杂,减少权重参数和计算成本变得很重要。模型压缩方法分为低秩分解、知识蒸馏、剪枝和量化,其中剪枝已被证明是通过去除冗余参数来降低网络复杂度的有效方法(A survey of model compression and acceleration for deep neural networks)。

为了解决目标检测网络问题,有几种最先进的工作技术可以减少YOLO架构中的参数数量。(YOLO-LITE: a real-time object detection algorithm optimized for non-GPU computers) 开发了YOLO-Lite网络,其中从YOLOv2-tiny中删除了批量归一化层以加速目标检测。该网络在PASCAL VOC 2007和COCO数据集上分别实现了33.81%和12.26%的mAP。(Yolo nano: a highly compact you only look once convolutional neural network for object detection) 创建了一个高度紧凑的网络YOLO-nano,它是一个基于YOLO网络的8位量化模型,并在PASCAL VOC 2007数据集上进行了优化。该网络在PASCAL VOC 2007数据集上实现了3.18M模型大小和69.1%mAP。

三、概要

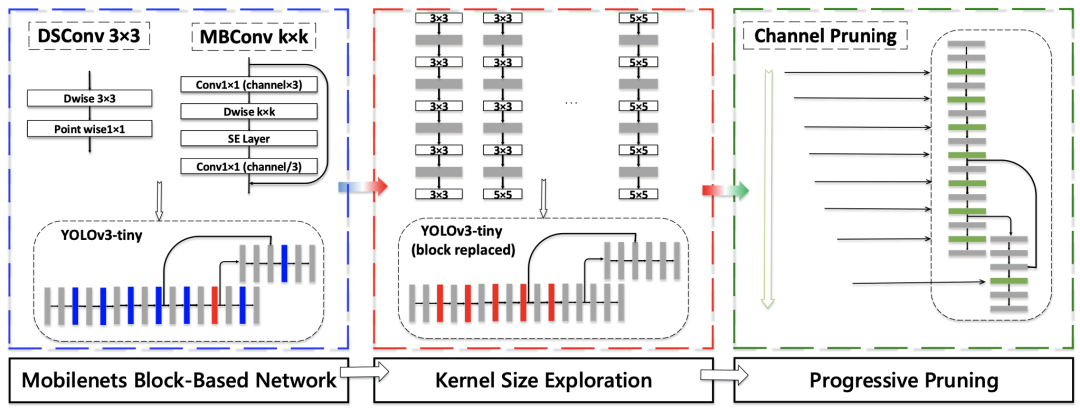

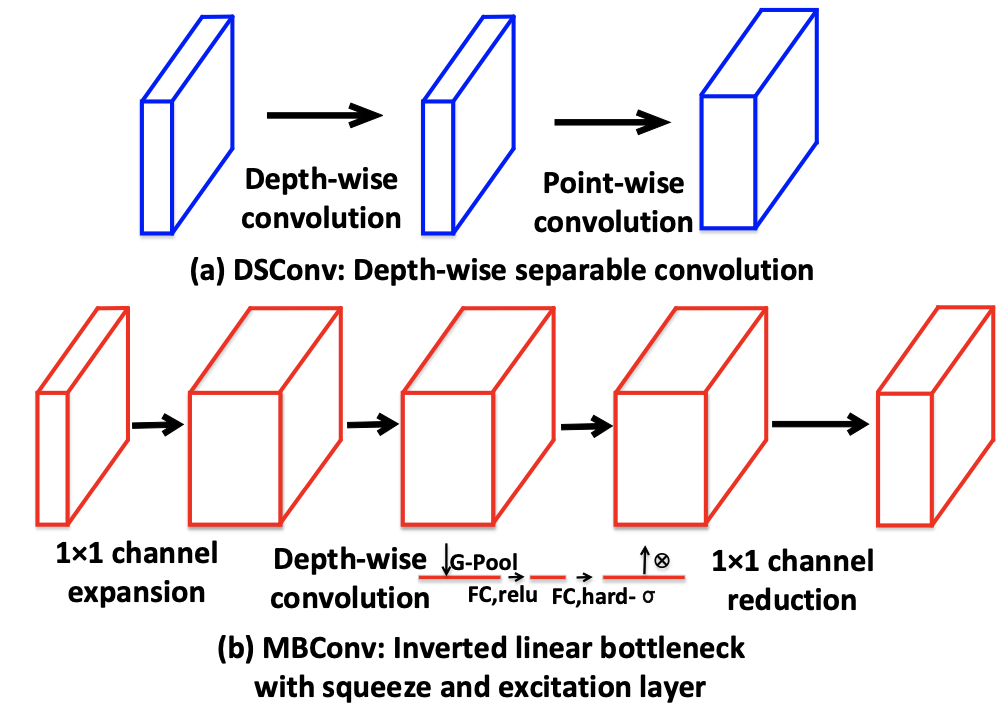

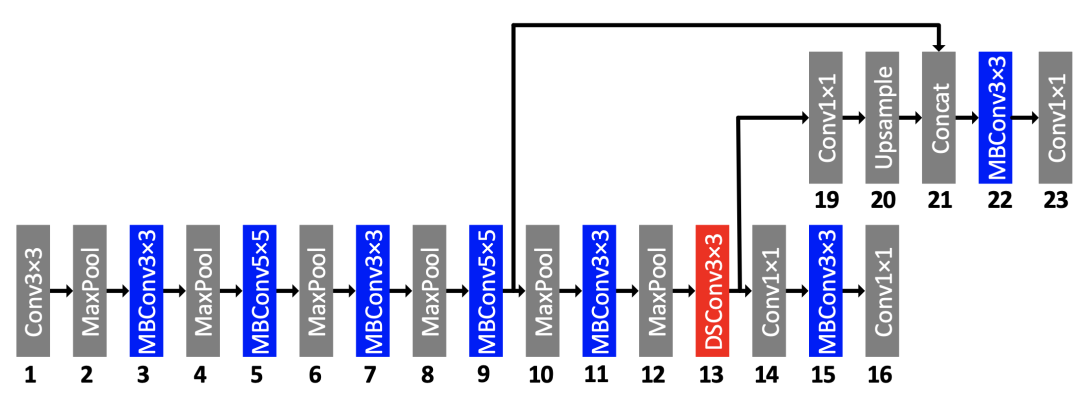

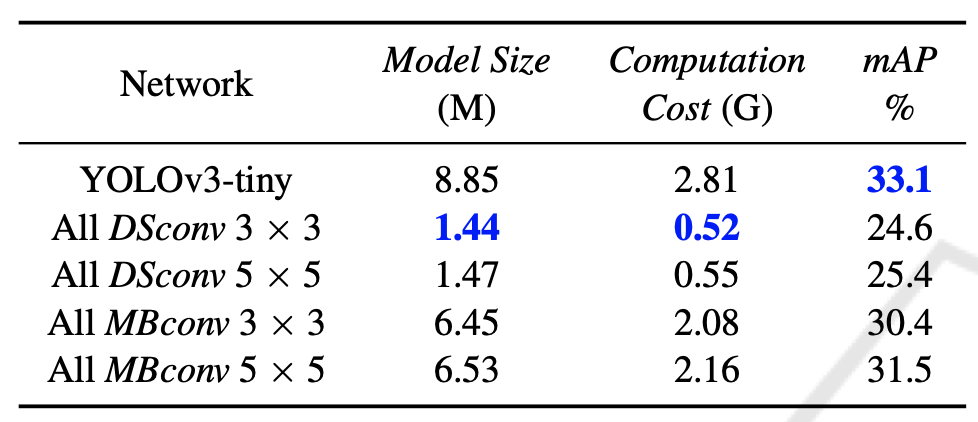

因此,研究者就提出了一种新的基于轻量级CNN的目标检测模型,即基于YOLOv3-Tiny的Micro-YOLO,它在保持检测性能的同时显着减少了参数数量和计算成本。研究者建议将YOLOv3-tiny网络中的卷积层替换为深度分布偏移卷积(DSConv:https://arxiv.org/abs/1901.01928v1)和带有squeeze和excitation块的移动反向瓶颈卷积 (MBConv:主要源自于EfficientNet),并设计渐进式通道级剪枝算法以最小化数量参数并最大化检测性能。因此,与原始YOLOv3-tiny网络相比,所提出的Micro-YOLO网络将参数数量减少了3.46倍,乘法累加操作(MAC)减少了2.55倍,同时在COCO数据集上评估的mAP略微减少了0.7%。

四、新框架介绍

Micro-YOLO

Progressive Channel Pruning

在确定新提出的Micro-YOLO网络的架构后,研究者可以通过使用剪枝技术进一步减少权重参数。在提出的工作中,研究者采用了粗粒度剪枝,因为DSConv和MBConv层主要由1×1内核大小组成,这为细粒度剪枝留下了最小的空间。(Rethinking the value of network pruning) 表明修剪后的架构本身,而不是一组继承的“重要”权重,对最终模型的效率更重要,这表明在某些情况下修剪可能是有用的一种架构搜索范式。因此,研究者提出了一种渐进式剪枝方法来在修改后的网络中搜索“更薄”的架构。具体伪代码流程如下:

五、实验

新提出的框架图

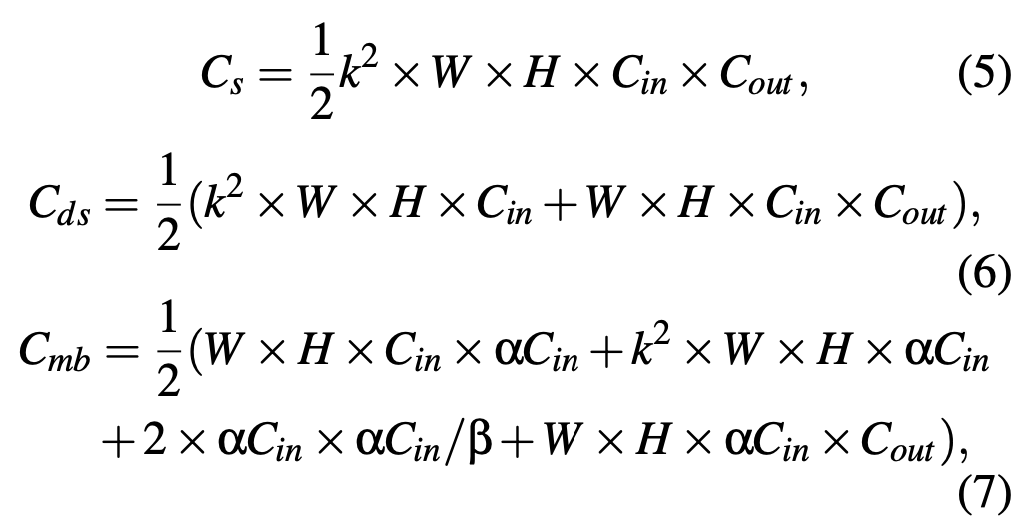

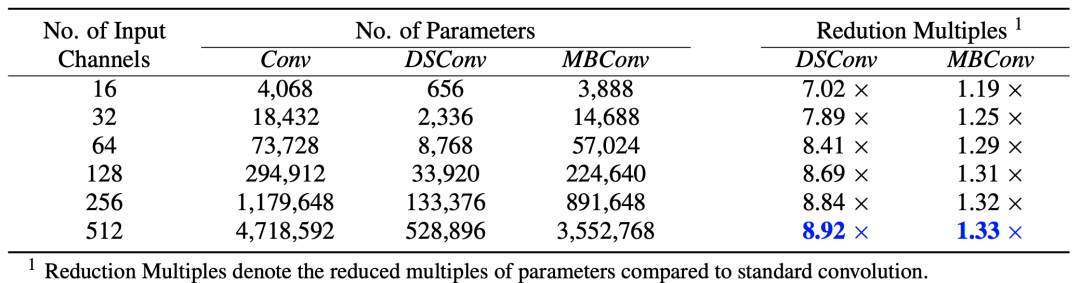

不同卷积类型和相同内核大小的不同输入通道所需的参数数量

不同卷积类型的参数量

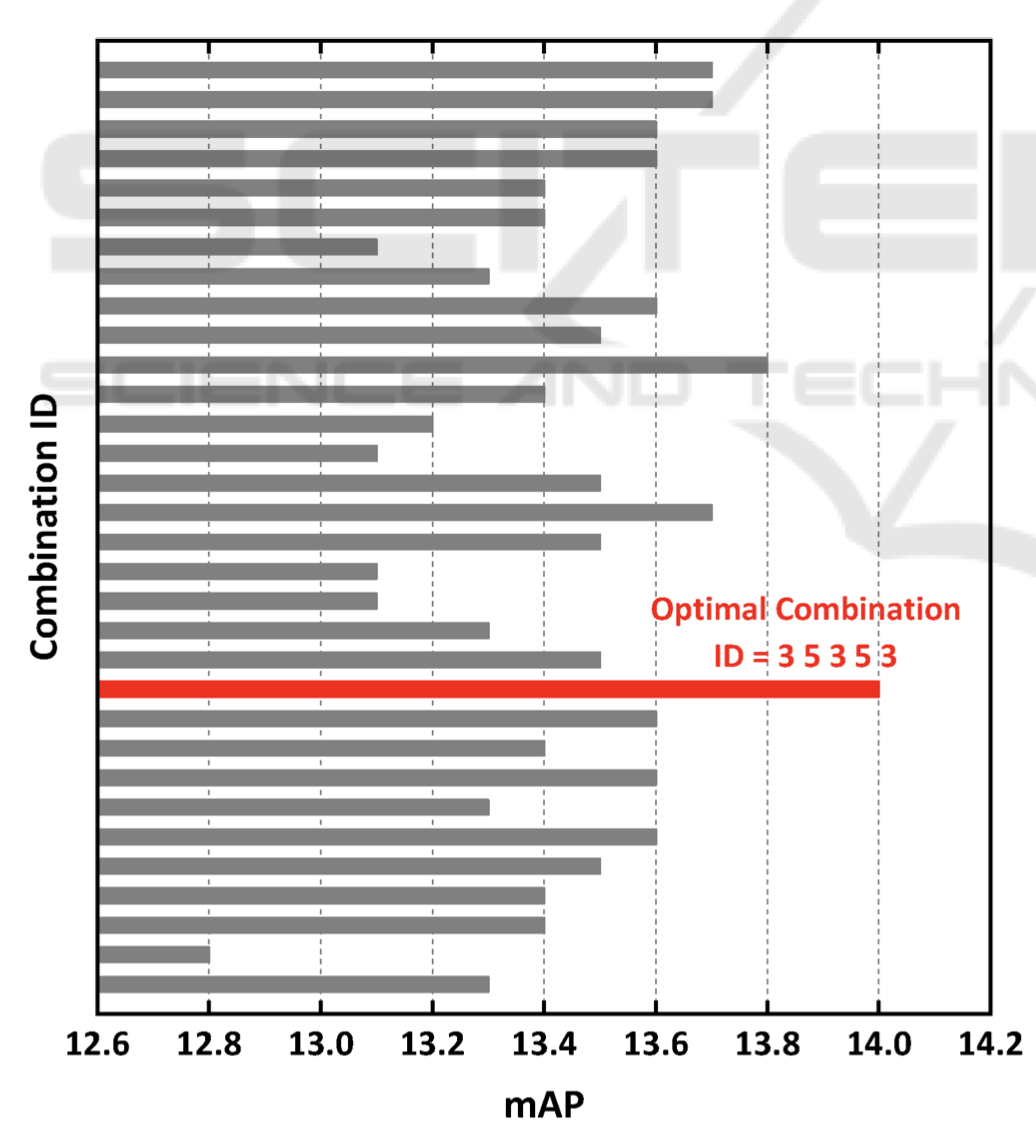

内核大小探索结果。不同的条形表示内核大小的不同组合。为简单起见,仅以红色显示最佳内核大小组合,如下图:

最后看下检测效果:

交流群

欢迎加入公众号读者群一起和同行交流,目前有美颜、三维视觉、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群

个人微信(如果没有备注不拉群!) 请注明:地区+学校/企业+研究方向+昵称

下载1:何恺明顶会分享

在「AI算法与图像处理」公众号后台回复:何恺明,即可下载。总共有6份PDF,涉及 ResNet、Mask RCNN等经典工作的总结分析

下载2:终身受益的编程指南:Google编程风格指南

在「AI算法与图像处理」公众号后台回复:c++,即可下载。历经十年考验,最权威的编程规范!

下载3 CVPR2021 在「AI算法与图像处理」公众号后台回复:CVPR,即可下载1467篇CVPR 2020论文 和 CVPR 2021 最新论文