打破Batch Size的玄学!有关 batch size 的设置范围,其实不必那么拘谨

导读

GPU 对 2 的幂次的 batch 可以发挥更好性能?今天来打破这个认知!著名机器学习博主用理论推导和实验结果证明:选择批大小作为 2 的幂或 8 的倍数在实践中会并不会产生明显的差异。

前言

理论背景

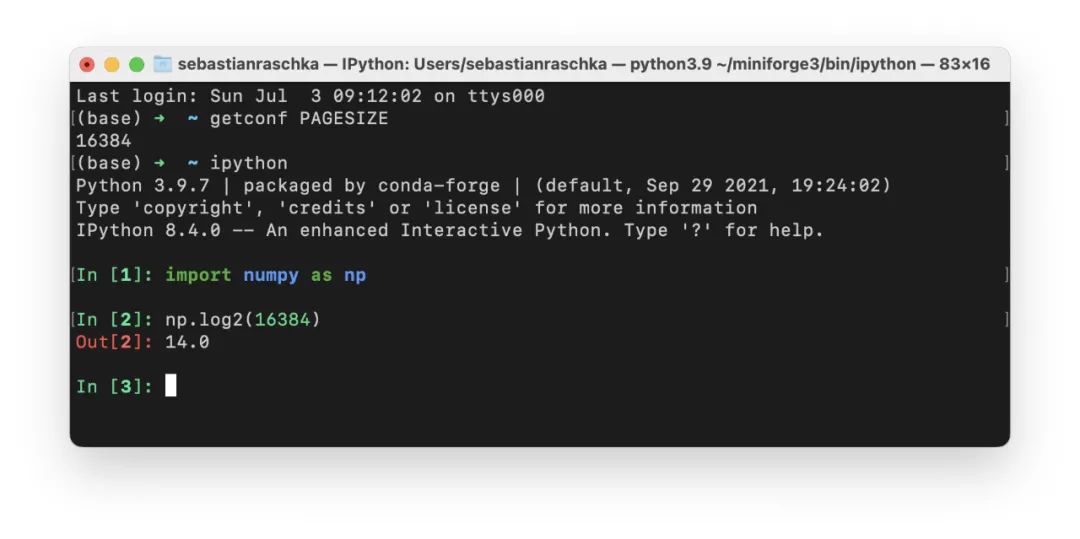

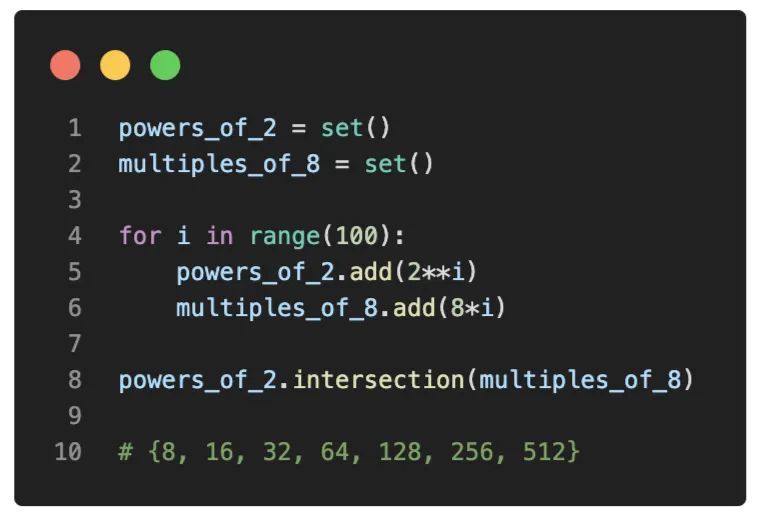

内存对齐

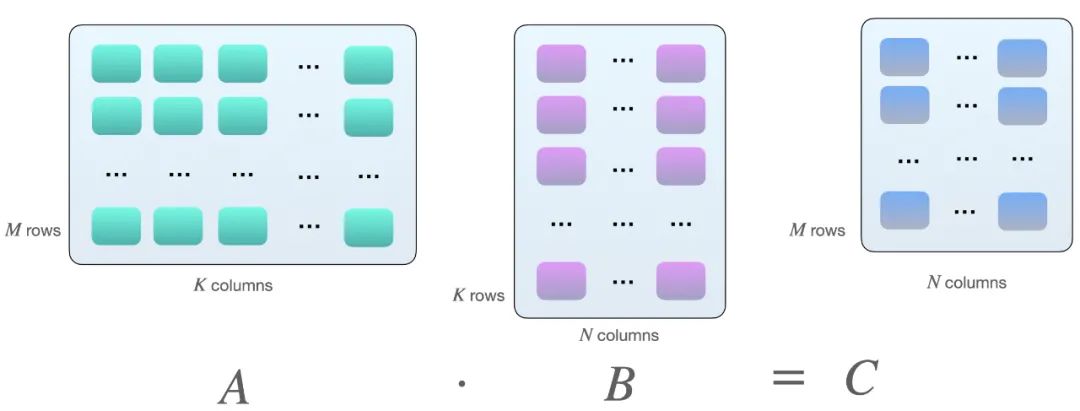

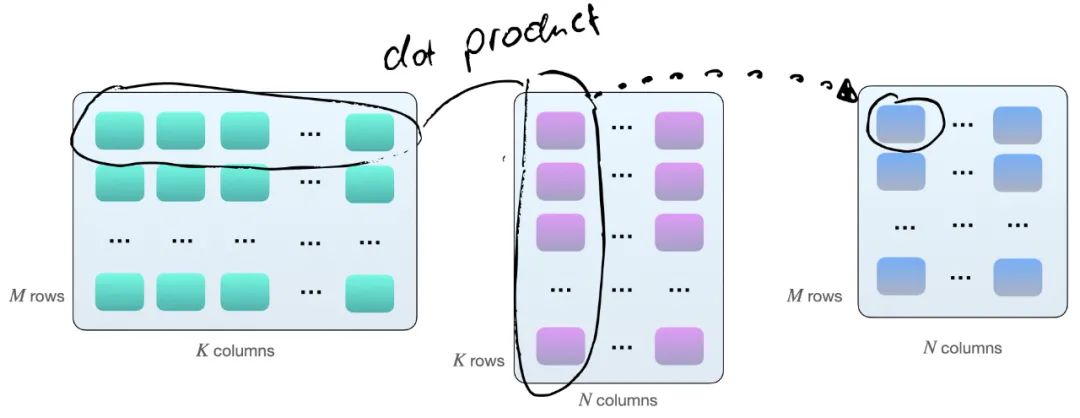

矩阵乘法和 Tensor Core

简单的 Benchmark

小 Batch Size 基准

最大 Batch Size 基准

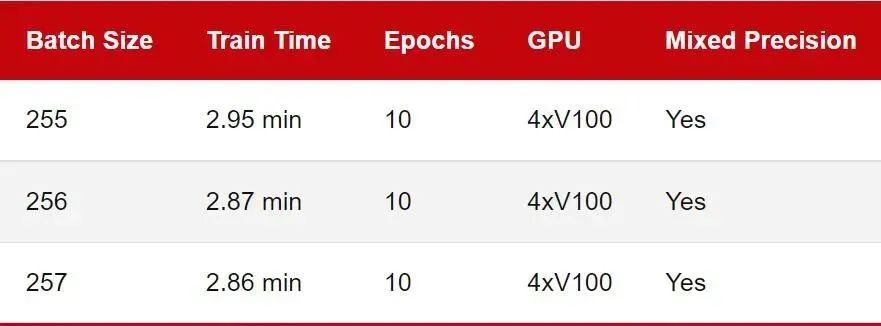

多GPU训练

基准测试注意事项

其他资源和讨论

显卡是否有 Tensor Core; 显卡是否支持混合精度训练; 在像 DeiT 这样的无卷积视觉转换器。

结论

评论