逐渐离谱,这波地位稳了!

自提出之日起,Transformer 模型已经在 CV、NLP 等多个领域中「大展拳脚」,例如我之前写过的马赛克克星算法还原图像、AI 打王者荣耀等算法,都是基于 Transformer 实现的。

Transformer为什么这么有实力?因为它在分类、检测等任务上展现了极其强劲的性能。而且骨干网络上的发展也推动了下游任务的发展,Swin Transformer更是成了屠榜般的存在,在工业界具有广阔的应用前景。所以引起了人工智能研究生的强烈兴趣。

但要想啃透CV Transformer 难度不小:一方面,Transformer本是应用于NLP的论文,其中很多内容都形成了共识,在论文中并不会去详细介绍这些共识内容,例如QKV是什么,embedding是什么等,对于其他方向的人看到这些就很难理解。

另一方面,近小半年,Transformer+CV的论文就已经有40多篇。学术研究更新之快,与脱发速度成正比

那么这些Transformer+CV的论文要怎么学习才能又好又快地吃透呢?

无非三个步骤:泛读、精读、代码复现。

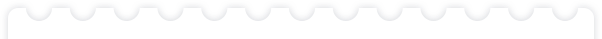

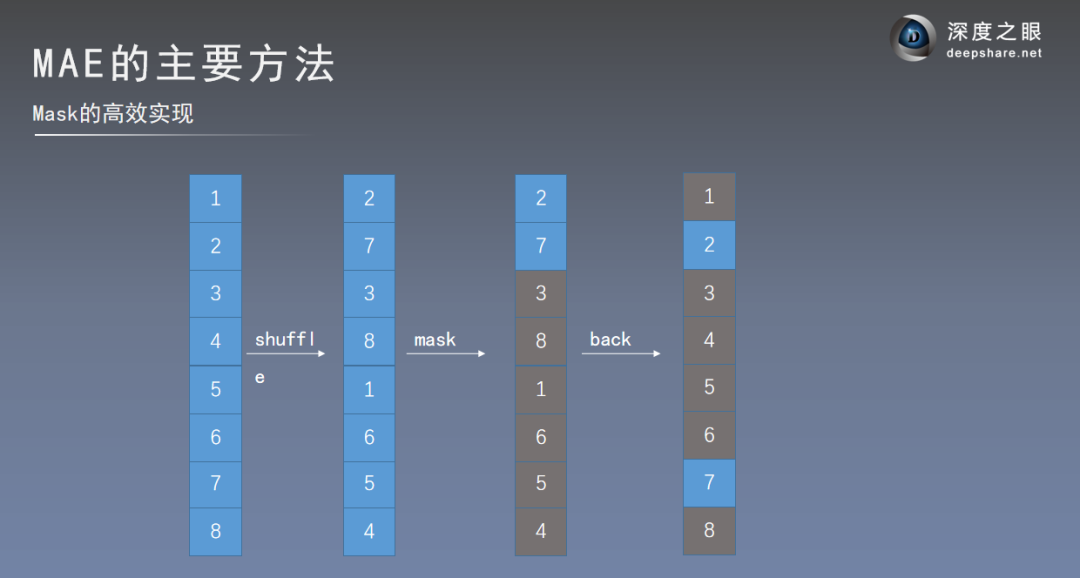

这次我们请来了现处科研一线的——电子羊老师,推出【ViT】+【MAE】论文精讲直播,为期2天,彻底夯实 CV Transformer 基础。

直播嘉宾:

—— 直播内容与安排 ——

1、4月22日20:00直播

1.论文研究背景、成果及意义

2.论文精读

3.论文总结

4.学习路径推荐

2、4月23日20:00直播

1.MAE简介

2.PreTrain FineTune

3.为什么分类任务如此重要?

4.MAE的主要方法

5.MAE实验结果

↓ 前方福利 ↓

原价399元,现在0.1元领取!

👆扫码添加客服 即可领取↓

免费资料:《CV transformer经典论文》

(限99份,手慢无)

评论

图片

表情

视频

全部评论