北大陈宝权组图灵班本科生:用于图像编辑的自条件生成对抗网络|SIGGRAPH 2022

新智元报道

新智元报道

【新智元导读】本文是 SIGGRAPH 2022入选论文「Self-Conditioned Generative Adversarial Networks for Image Editing」的解读。

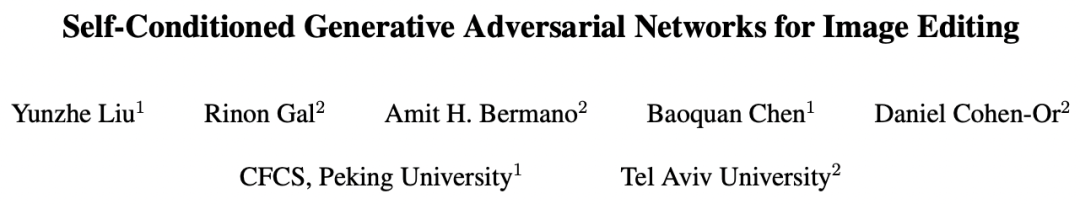

「Self-Conditioned Generative Adversarial Networks for Image Editing」由北京大学陈宝权课题组和特拉维夫大学合作,第一作者刘云蛰为北京大学图灵班2018级本科生。

论文地址:https://arxiv.org/abs/2202.04040

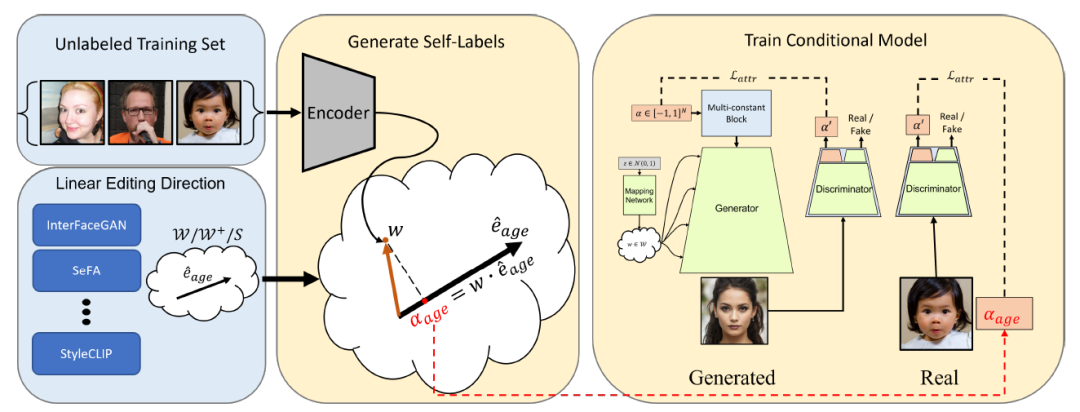

文章提出了一种提高生成对抗网络(GANs)在数据分布边缘的生成效果的方法。在此基础上,相关的编辑算法的效果也得到了改进。

实验证明,作者的方法成功提高了 StyleGAN 这一广泛认可的人脸生成模型在边缘侧的生成、编辑效果。

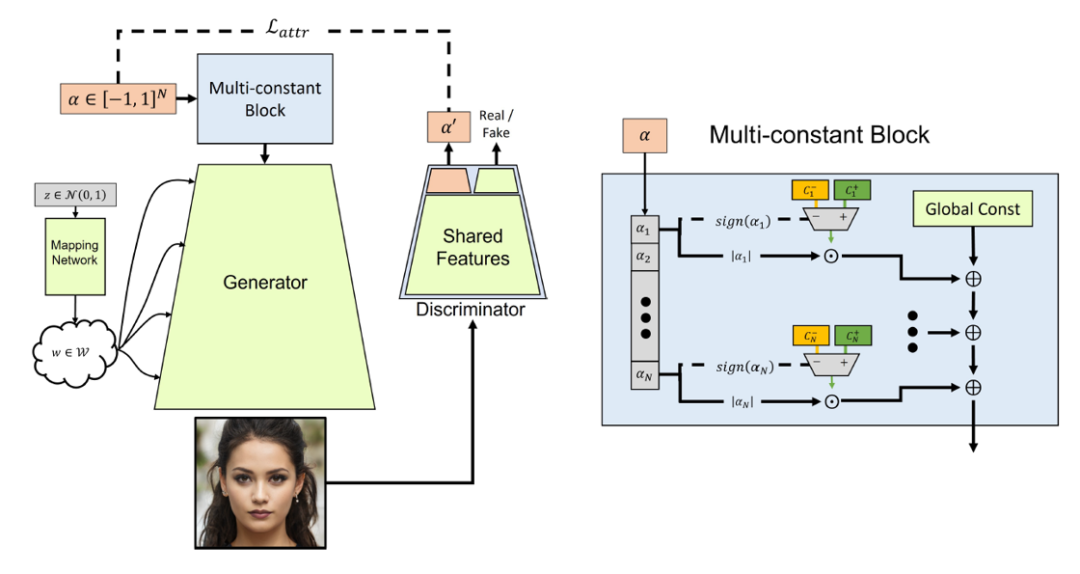

图1. 人脸位姿编辑结果

上:InterFaceGAN,下:Ours

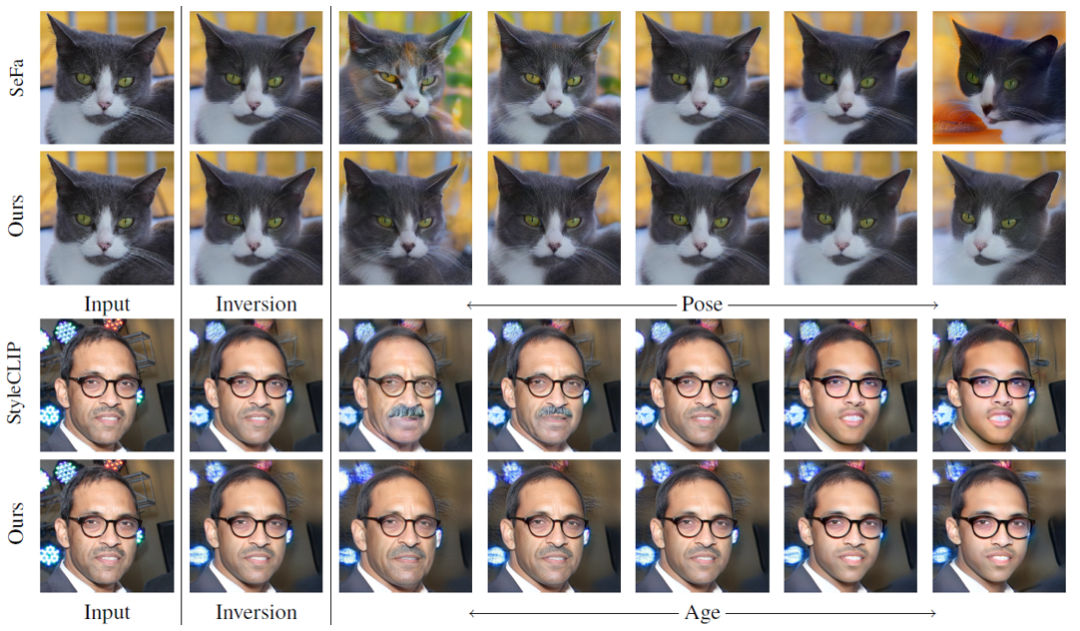

图4. 其他编辑结果

评论