CycleGAN 生成对抗网络图像处理工具

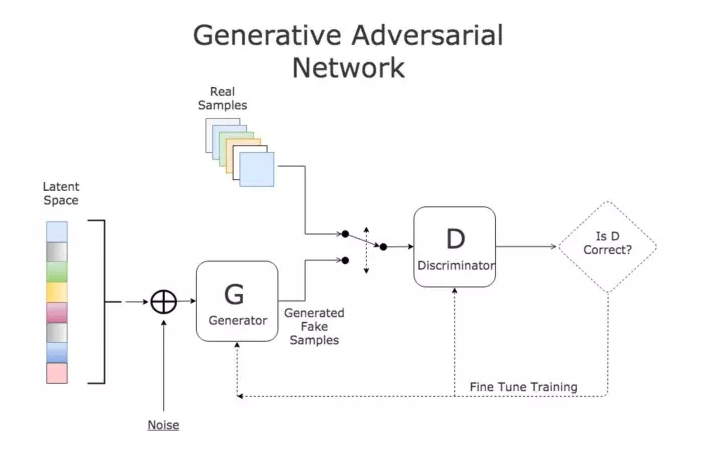

1. GAN简介

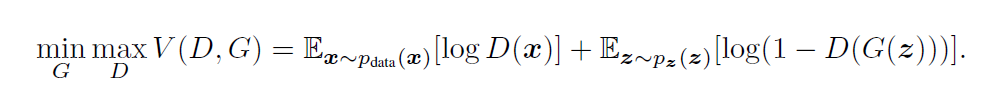

通过对抗的方式,去学习数据分布的生成式模型。GAN是无监督的过程,能够捕捉数据集的分布,以便于可以从随机噪声中生成同样分布的数据

D判别式模型:学习真假边界,判断数据是真的还是假的 G生成式模型:学习数据分布并生成数据

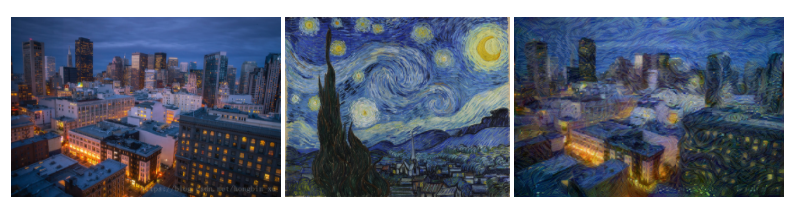

2. 实战cycleGAN 风格转换

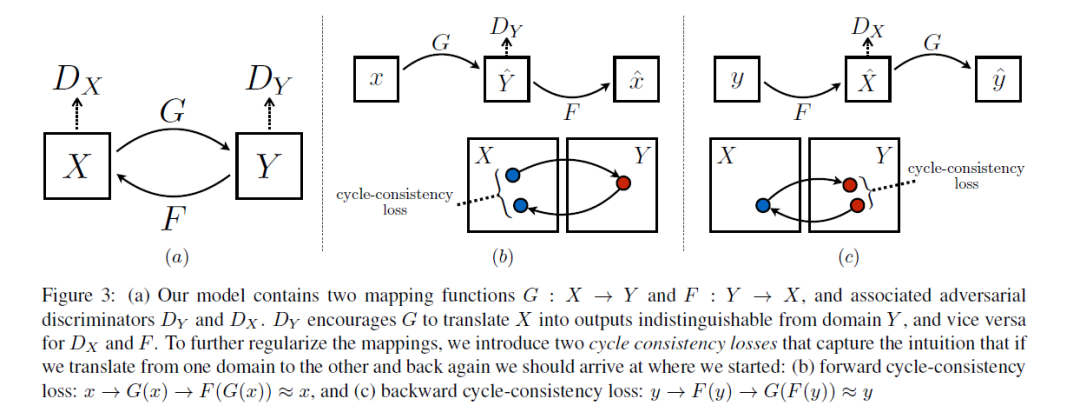

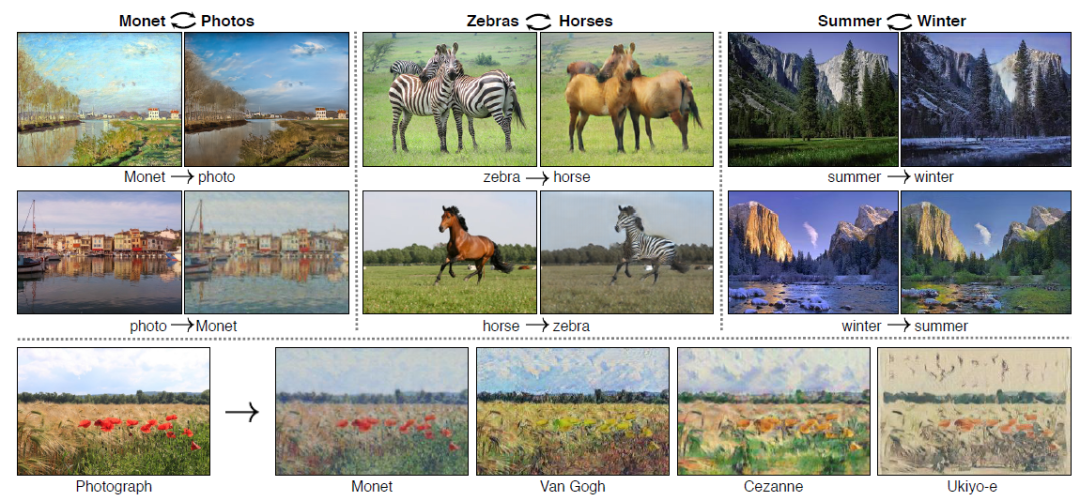

2.1 cycleGAN简介

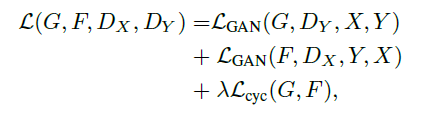

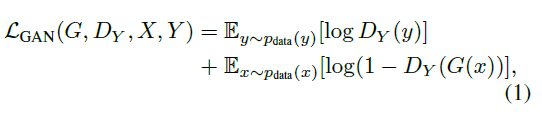

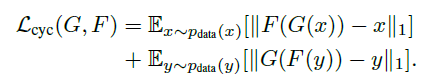

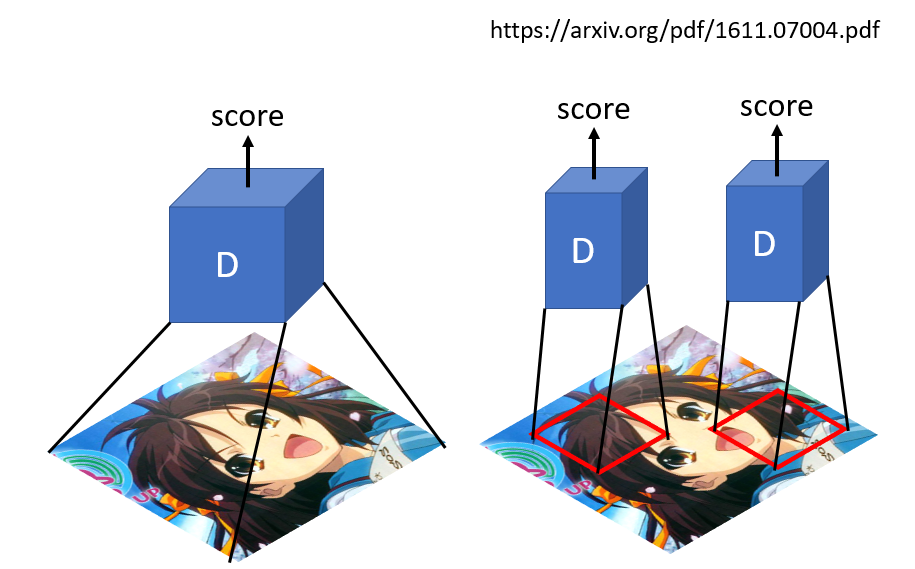

两路GAN:两个生成器[ G:X->Y , F:Y->X ] 和两个判别器[Dx, Dy], G和Dy目的是生成的对象,Dy(正类是Y领域)无法判别。同理F和Dx也是一样的。 cycle consistency:G是生成Y的生成器, F是生成X的生成器,cycle consistency是为了约束G和F生成的对象的范围, 是的G生成的对象通过F生成器能够回到原始的领域如:x->G(x)->F(G(x))=x

2.2 实现cycleGAN

2.2.1 生成器

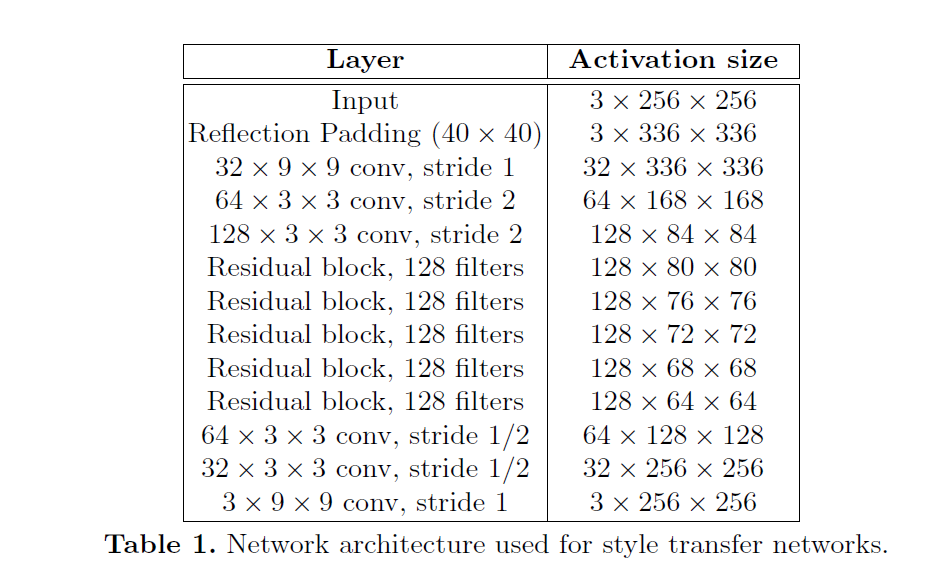

Perceptual Losses for Real-Time Style Transfer and Super-Resolution: Supplementary Material。大致可以分为:下采样 + residual 残差block + 上采样,如下图(摘自论文):

# 残差block

class ResidualBlock(nn.Module):

def __init__(self, in_features):

super(ResidualBlock, self).__init__()

self.block = nn.Sequential(

nn.ReflectionPad2d(1),

nn.Conv2d(in_features, in_features, 3),

nn.InstanceNorm2d(in_features),

nn.ReLU(inplace=True),

nn.ReflectionPad2d(1),

nn.Conv2d(in_features, in_features, 3),

nn.InstanceNorm2d(in_features),

)

def forward(self, x):

return x + self.block(x)

class GeneratorResNet(nn.Module):

def __init__(self, input_shape, num_residual_blocks):

super(GeneratorResNet, self).__init__()

channels = input_shape[0]

# Initial convolution block

out_features = 64

model = [

nn.ReflectionPad2d(channels),

nn.Conv2d(channels, out_features, 7),

nn.InstanceNorm2d(out_features),

nn.ReLU(inplace=True),

]

in_features = out_features

# Downsampling

for _ in range(2):

out_features *= 2

model += [

nn.Conv2d(in_features, out_features, 3, stride=2, padding=1),

nn.InstanceNorm2d(out_features),

nn.ReLU(inplace=True),

]

in_features = out_features

# Residual blocks

for _ in range(num_residual_blocks):

model += [ResidualBlock(out_features)]

# Upsampling

for _ in range(2):

out_features //= 2

model += [

nn.Upsample(scale_factor=2),

nn.Conv2d(in_features, out_features, 3, stride=1, padding=1),

nn.InstanceNorm2d(out_features),

nn.ReLU(inplace=True),

]

in_features = out_features

# Output layer

model += [nn.ReflectionPad2d(channels), nn.Conv2d(out_features, channels, 7), nn.Tanh()]

self.model = nn.Sequential(*model)

def forward(self, x):

return self.model(x)

2.2.2 判别器

class Discriminator(nn.Module):

def __init__(self, input_shape):

super(Discriminator, self).__init__()

channels, height, width = input_shape

# Calculate output shape of image discriminator (PatchGAN)

self.output_shape = (1, height // 2 ** 4, width // 2 ** 4)

def discriminator_block(in_filters, out_filters, normalize=True):

"""Returns downsampling layers of each discriminator block"""

layers = [nn.Conv2d(in_filters, out_filters, 4, stride=2, padding=1)]

if normalize:

layers.append(nn.InstanceNorm2d(out_filters))

layers.append(nn.LeakyReLU(0.2, inplace=True))

return layers

self.model = nn.Sequential(

*discriminator_block(channels, 64, normalize=False),

*discriminator_block(64, 128),

*discriminator_block(128, 256),

*discriminator_block(256, 512),

nn.ZeroPad2d((1, 0, 1, 0)),

nn.Conv2d(512, 1, 4, padding=1)

)

def forward(self, img):

return self.model(img)

2.2.3 训练

# Losses

criterion_GAN = torch.nn.MSELoss()

criterion_cycle = torch.nn.L1Loss()

criterion_identity = torch.nn.L1Loss()

cuda = torch.cuda.is_available()

input_shape = (opt.channels, opt.img_height, opt.img_width)

# Initialize generator and discriminator

G_AB = GeneratorResNet(input_shape, opt.n_residual_blocks)

G_BA = GeneratorResNet(input_shape, opt.n_residual_blocks)

D_A = Discriminator(input_shape)

D_B = Discriminator(input_shape)

# Optimizers

optimizer_G = torch.optim.Adam(

itertools.chain(G_AB.parameters(), G_BA.parameters()), lr=opt.lr, betas=(opt.b1, opt.b2)

)

optimizer_D_A = torch.optim.Adam(D_A.parameters(), lr=opt.lr, betas=(opt.b1, opt.b2))

optimizer_D_B = torch.optim.Adam(D_B.parameters(), lr=opt.lr, betas=(opt.b1, opt.b2))

# Learning rate update schedulers

lr_scheduler_G = torch.optim.lr_scheduler.LambdaLR(

optimizer_G, lr_lambda=LambdaLR(opt.n_epochs, opt.epoch, opt.decay_epoch).step

)

lr_scheduler_D_A = torch.optim.lr_scheduler.LambdaLR(

optimizer_D_A, lr_lambda=LambdaLR(opt.n_epochs, opt.epoch, opt.decay_epoch).step

)

lr_scheduler_D_B = torch.optim.lr_scheduler.LambdaLR(

optimizer_D_B, lr_lambda=LambdaLR(opt.n_epochs, opt.epoch, opt.decay_epoch).step

)

训练数据是成对的数据,但是是非配对的数据,即A和B是没有直接的联系的。A是原图,B是风格图 生成器训练 GAN loss:判别器判别A和B生成的两个图fake_A、fake_B与GT的loss Cycle loss:反过来fake_A和fake_B 生成的图与A和B像素上差异 判别器训练: loss_real: 判别A/B和GT的MSELoss loss_fake:判别生成的fake_A/fake_B与GT的MSELoss

for epoch in range(opt.epoch, opt.n_epochs):

for i, batch in enumerate(dataloader):

# 数据是成对的数据,但是是非配对的数据,即A和B是没有直接的联系的

real_A = Variable(batch["A"].type(Tensor))

real_B = Variable(batch["B"].type(Tensor))

# Adversarial ground truths

valid = Variable(Tensor(np.ones((real_A.size(0), *D_A.output_shape))), requires_grad=False)

fake = Variable(Tensor(np.zeros((real_A.size(0), *D_A.output_shape))), requires_grad=False)

# ------------------

# Train Generators

# ------------------

G_AB.train()

G_BA.train()

optimizer_G.zero_grad()

# Identity loss

loss_id_A = criterion_identity(G_BA(real_A), real_A)

loss_id_B = criterion_identity(G_AB(real_B), real_B)

loss_identity = (loss_id_A + loss_id_B) / 2

# GAN loss

fake_B = G_AB(real_A)

loss_GAN_AB = criterion_GAN(D_B(fake_B), valid)

fake_A = G_BA(real_B)

loss_GAN_BA = criterion_GAN(D_A(fake_A), valid)

loss_GAN = (loss_GAN_AB + loss_GAN_BA) / 2

# Cycle loss

recov_A = G_BA(fake_B)

loss_cycle_A = criterion_cycle(recov_A, real_A)

recov_B = G_AB(fake_A)

loss_cycle_B = criterion_cycle(recov_B, real_B)

loss_cycle = (loss_cycle_A + loss_cycle_B) / 2

# Total loss

loss_G = loss_GAN + opt.lambda_cyc * loss_cycle + opt.lambda_id * loss_identity

loss_G.backward()

optimizer_G.step()

# -----------------------

# Train Discriminator A

# -----------------------

optimizer_D_A.zero_grad()

# Real loss

loss_real = criterion_GAN(D_A(real_A), valid)

# Fake loss (on batch of previously generated samples)

# fake_A_ = fake_A_buffer.push_and_pop(fake_A)

loss_fake = criterion_GAN(D_A(fake_A_.detach()), fake)

# Total loss

loss_D_A = (loss_real + loss_fake) / 2

loss_D_A.backward()

optimizer_D_A.step()

# -----------------------

# Train Discriminator B

# -----------------------

optimizer_D_B.zero_grad()

# Real loss

loss_real = criterion_GAN(D_B(real_B), valid)

# Fake loss (on batch of previously generated samples)

# fake_B_ = fake_B_buffer.push_and_pop(fake_B)

loss_fake = criterion_GAN(D_B(fake_B_.detach()), fake)

# Total loss

loss_D_B = (loss_real + loss_fake) / 2

loss_D_B.backward()

optimizer_D_B.step()

loss_D = (loss_D_A + loss_D_B) / 2

# --------------

# Log Progress

# --------------

# Determine approximate time left

batches_done = epoch * len(dataloader) + i

batches_left = opt.n_epochs * len(dataloader) - batches_done

time_left = datetime.timedelta(seconds=batches_left * (time.time() - prev_time))

prev_time = time.time()

# Update learning rates

lr_scheduler_G.step()

lr_scheduler_D_A.step()

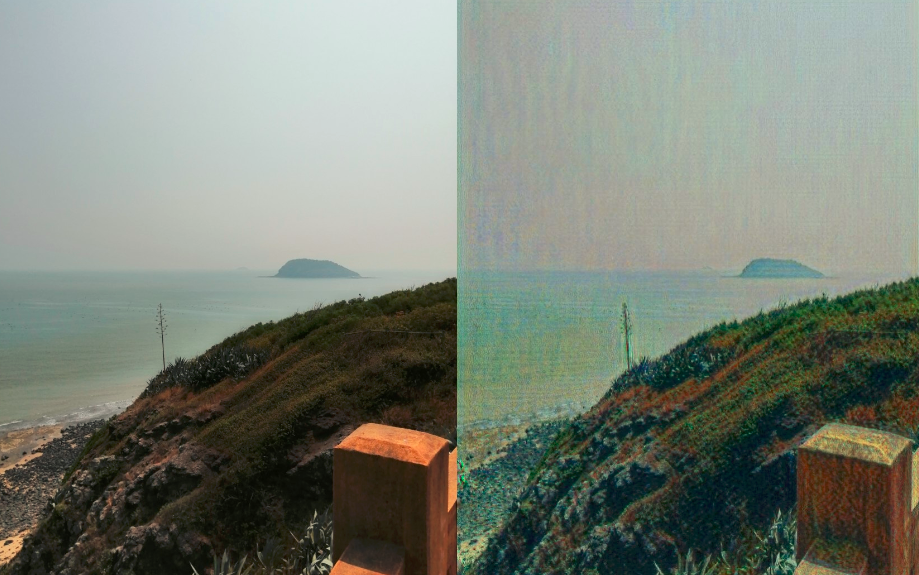

lr_scheduler_D_B.step()2.2.4 结果展示

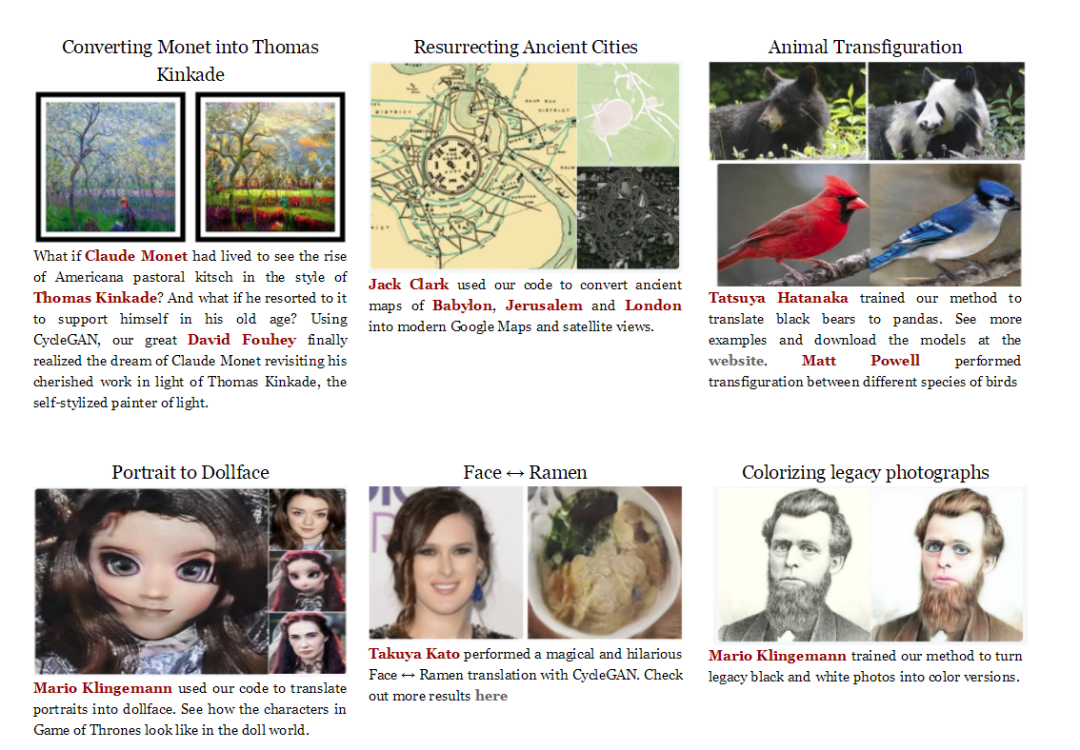

2.2.5 cycleGAN其他用途

3. 总结

GAN是学习数据中分布,并生成同样分布但全新的数据 CycleGAN是两路GAN:两个生成器和两个判别器;为了保证生成器的生成的图片与输入图存在一定的关系,不是随机生产的图片, 引入cycle consistency,判定A->fake_B->recove_A和A的差异 生成器:下采样 + residual 残差block + 上采样 判别器: 不是一个图生成一个判定值,而是patchGAN方式,生成很N*N个值,而后取均值

作者简介:wedo实验君, 数据分析师;热爱生活,热爱写作

赞 赏 作 者

更多阅读

特别推荐

点击下方阅读原文加入社区会员

评论