RDMA网络最新技术

一年一度的云栖大会近日在杭州如约举行。今年的云栖大会上阿里云发布了第四代神龙架构,其中弹性 RDMA 加速能力尤其值得关注。基于弹性 RDMA,阿里云操作系统 Alibaba Cloud Linux 3 和龙蜥社区操作系统 Anolis OS 在网络方面基于社区 SMC-R 优化形成兼容 socket 的 RDMA 产品方案,旨在帮助云上应用无修改的享受 RDMA 带来的性能提升。本文将为您阐述 SMC-R 的产生背景、原理架构以及部分性能数据。

来源:云巅论剑

作者:古闻、无牙、荣旸

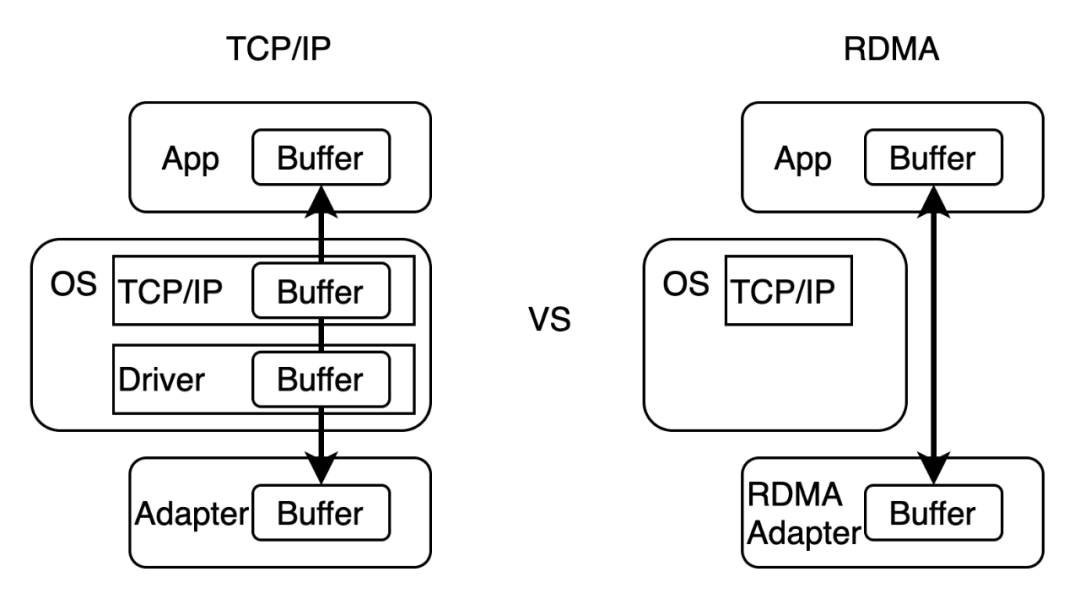

从 TCP 到 RDMA

从 verbs 到 socket

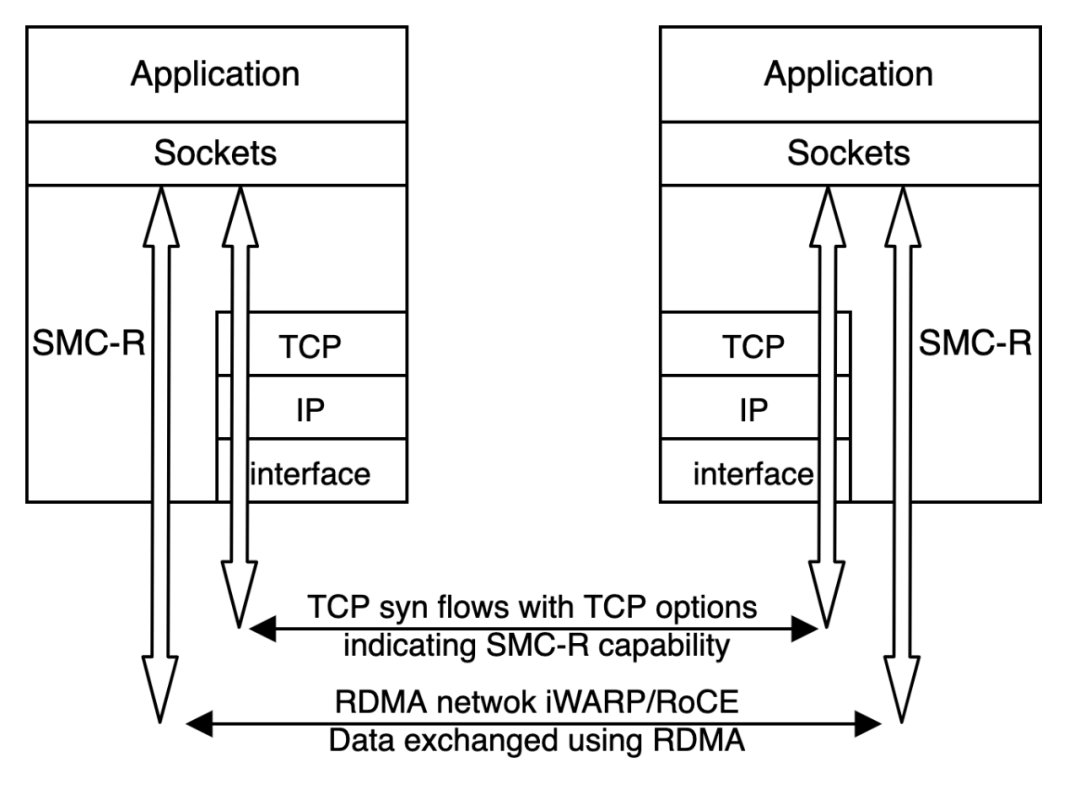

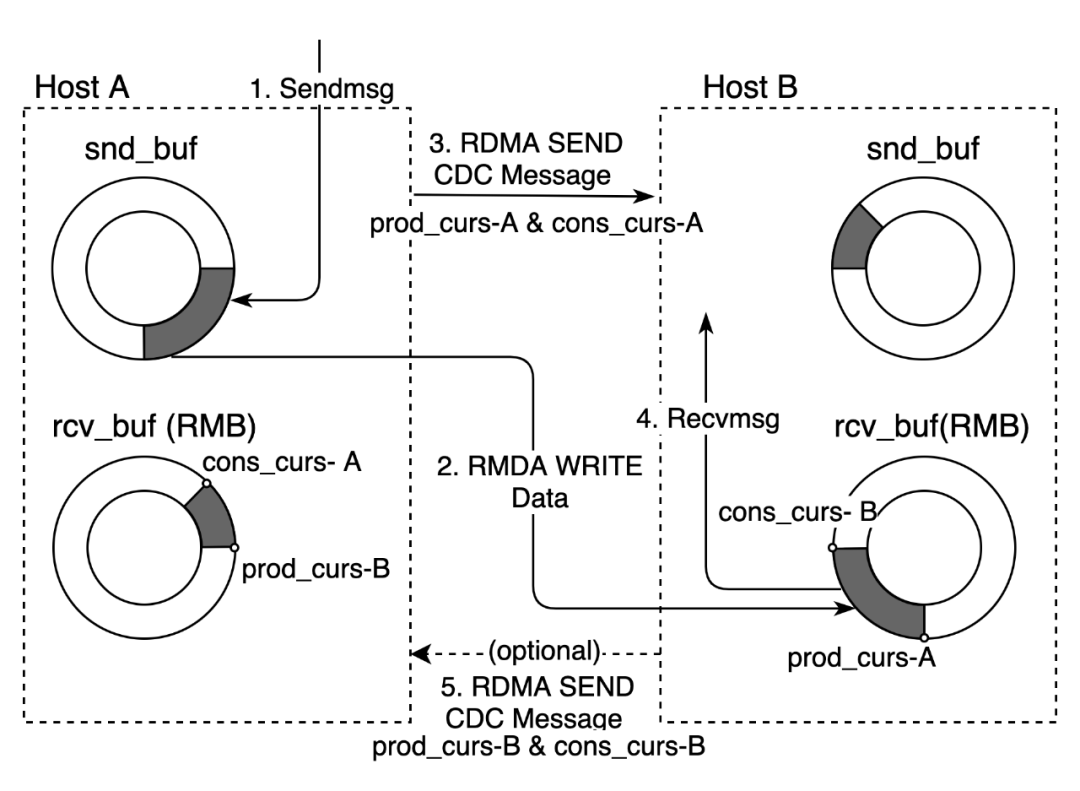

兼备 socket 和 RDMA 的内核实现:SMC-R

更轻薄的协议栈;

使用 RDMA 进行通信,网络时延更低、CPU 占用更少、吞吐量更高;

高效可靠的远程环形缓冲区直接访问。

兼容 socket 接口的 RDMA 可靠流式传输; 自动协议协商和安全回退 TCP 能力; net namespace 和应用维度的协议栈无损透明替换; 底层兼容弹性 RDMA iWARP 和标准 RoCE 网络。

性能表现

CPU:Intel(R) Xeon(R) Platinum 8269CY CPU @ 2.50GHz 104 核

网卡:弹性 RDMA * 1

OS:Alibaba Cloud Linux 3

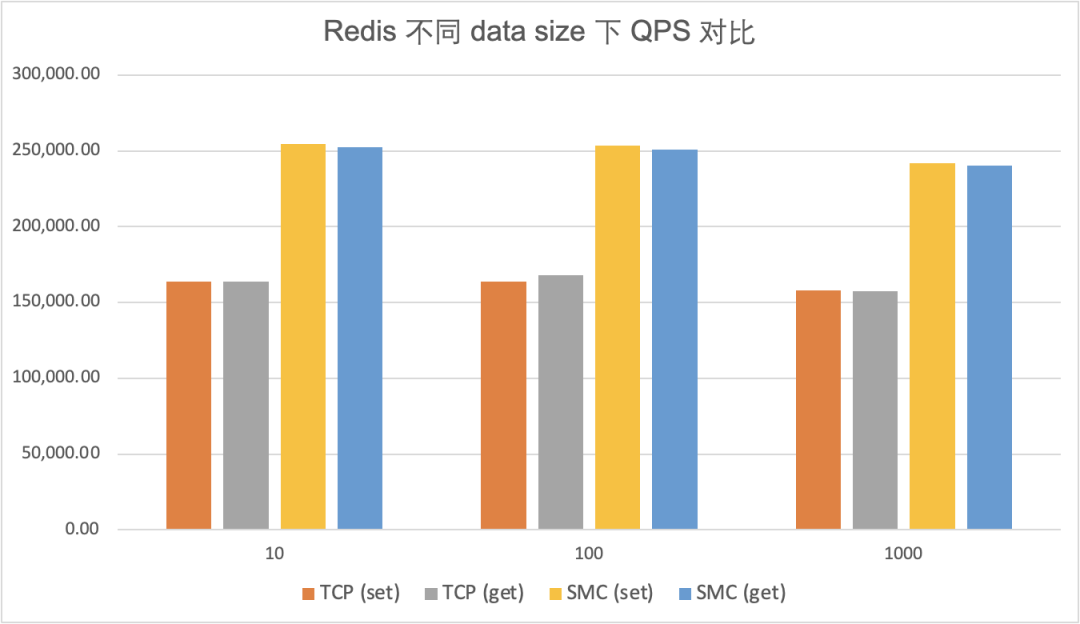

不同 data size 场景下,redis-benchmark 测试 SMC-R 对比 TCP 性能数据

不同 clients 数量场景下,redis-benchmark 测试 SMC-R 对比 TCP 性能数据

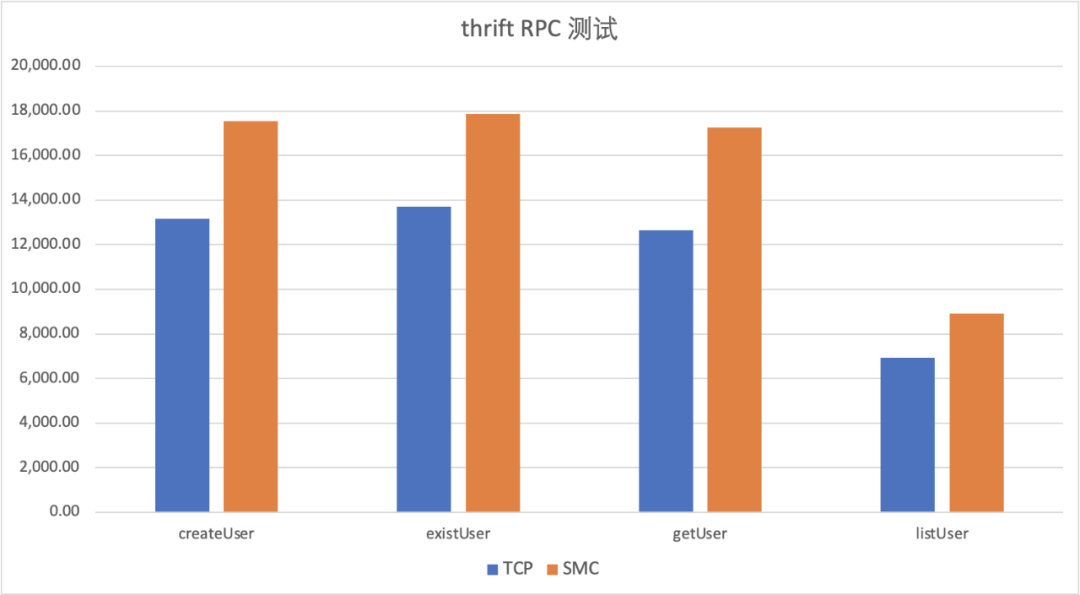

不同类型 RPC 接口下使用 TCP 和 SMC-R 所得 QPS 对比

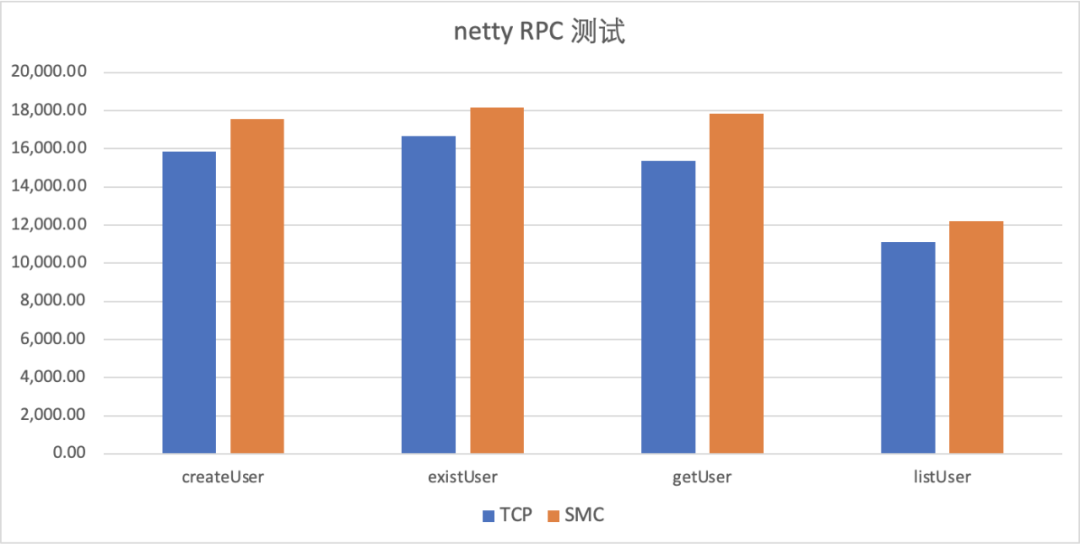

不同类型 RPC 接口下使用 TCP 和 SMC-R 所得 QPS 对比

有收获,点个在看

评论