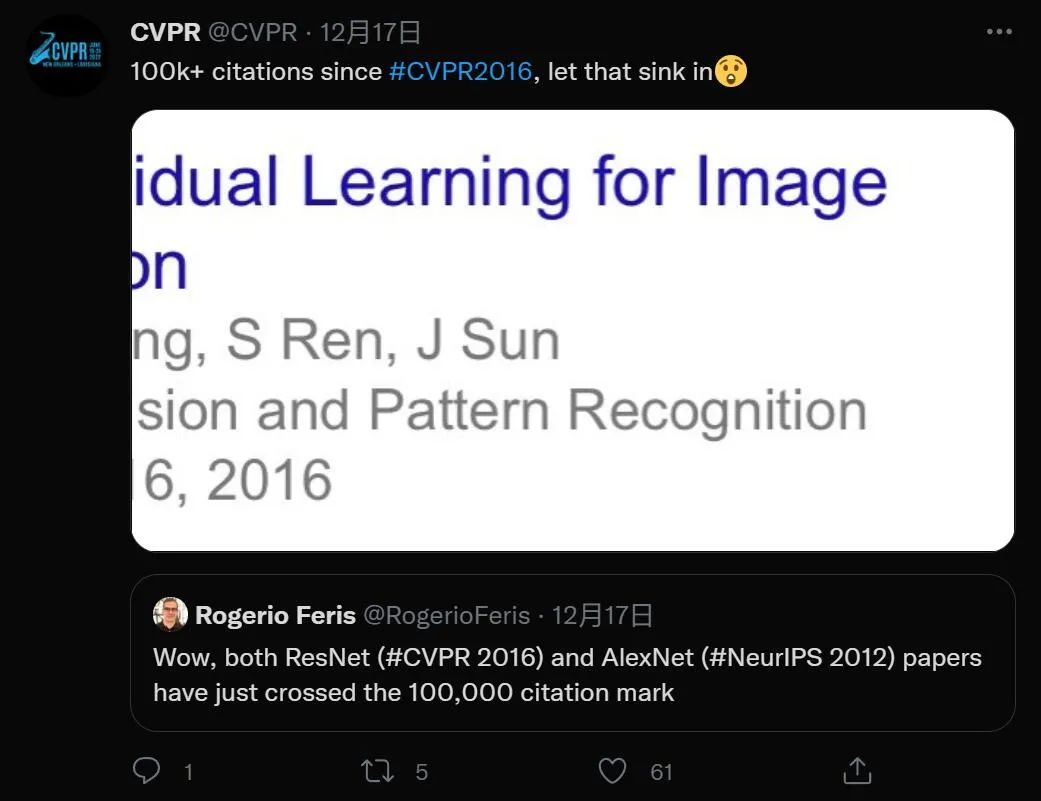

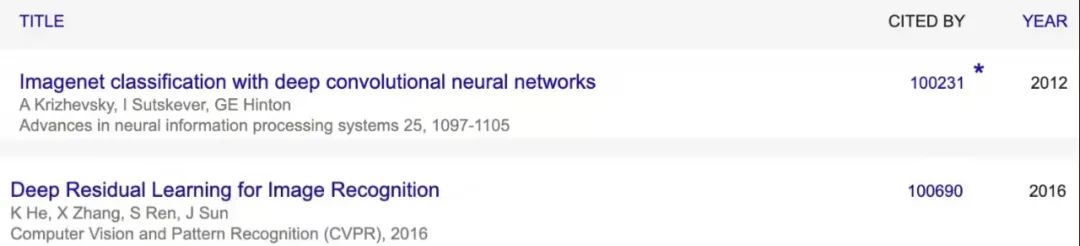

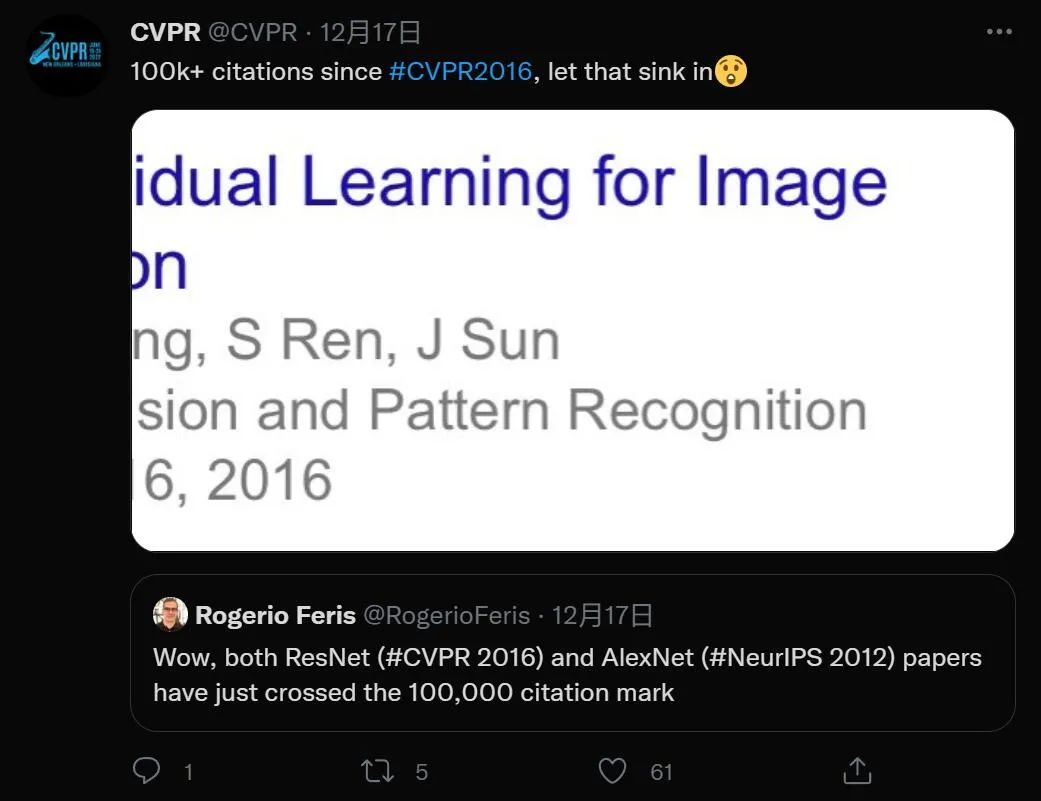

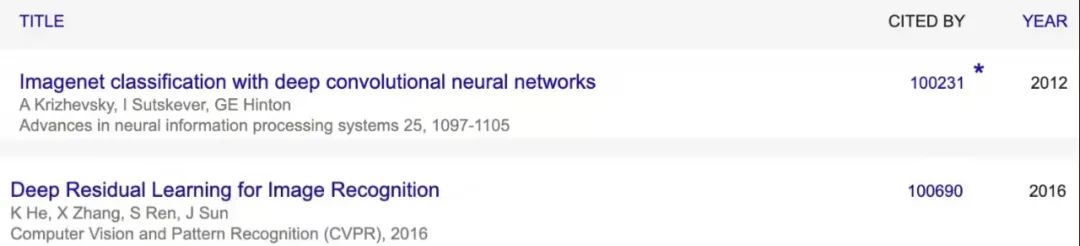

何恺明的ResNet论文,被引量刚刚突破10万大关

点击上方“视学算法”,选择加"星标"或“置顶”

重磅干货,第一时间送达

导读

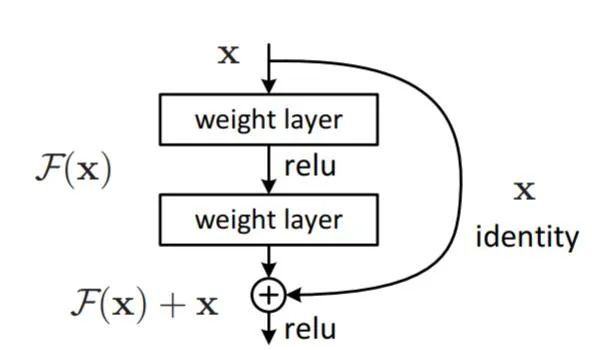

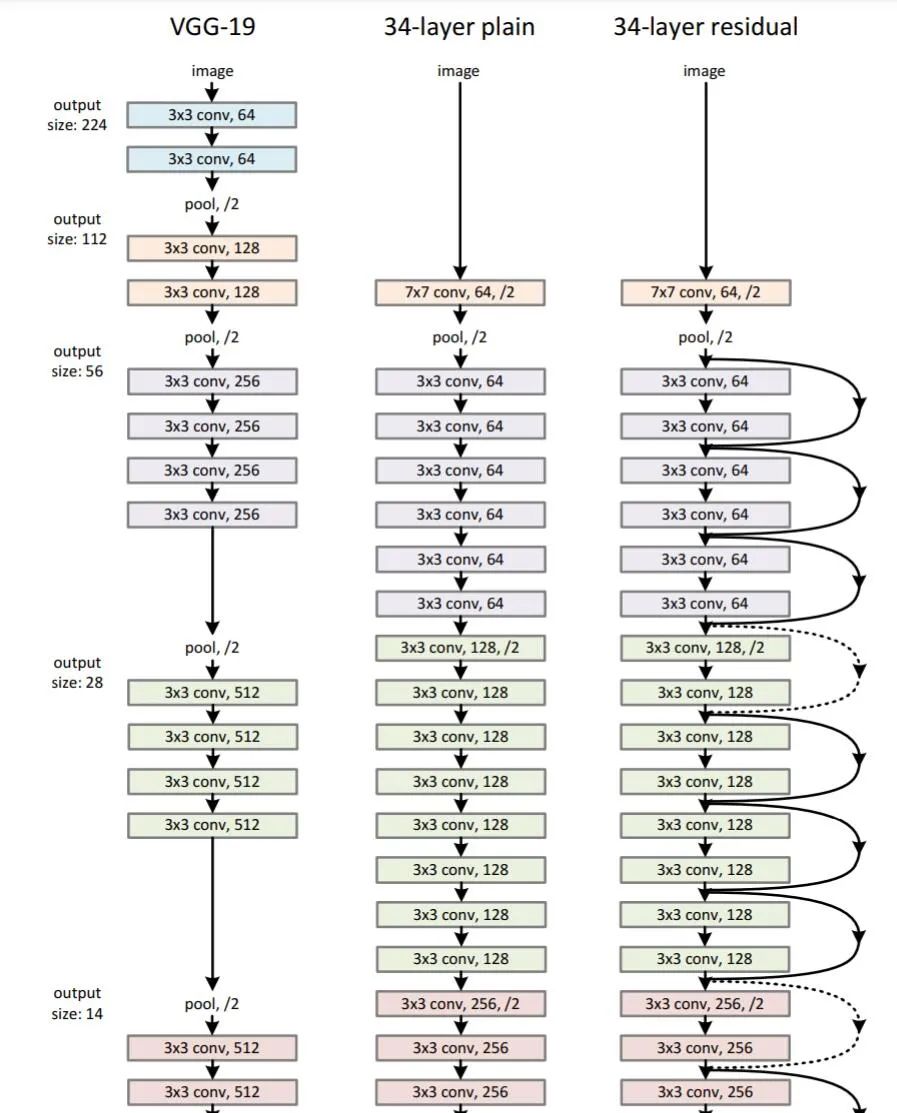

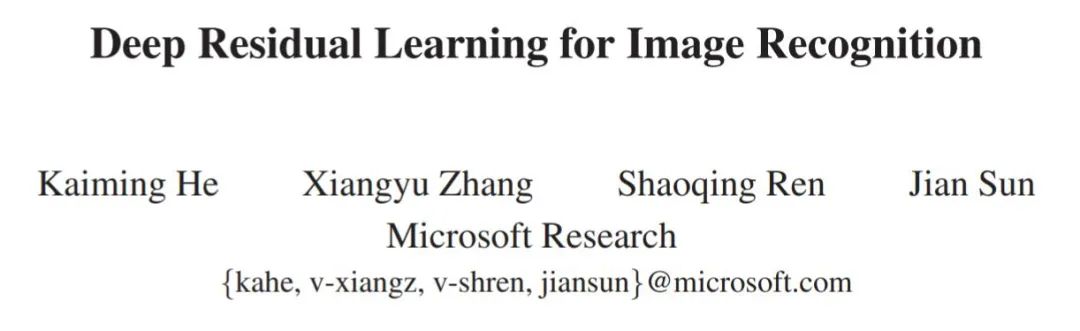

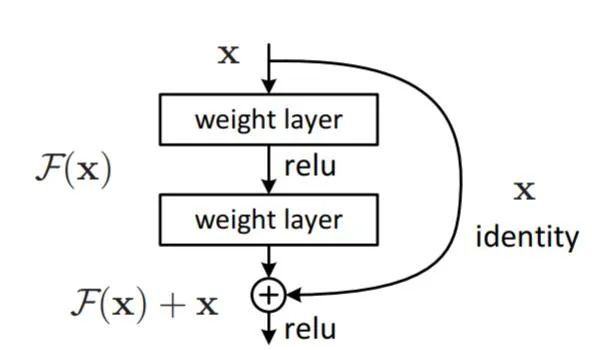

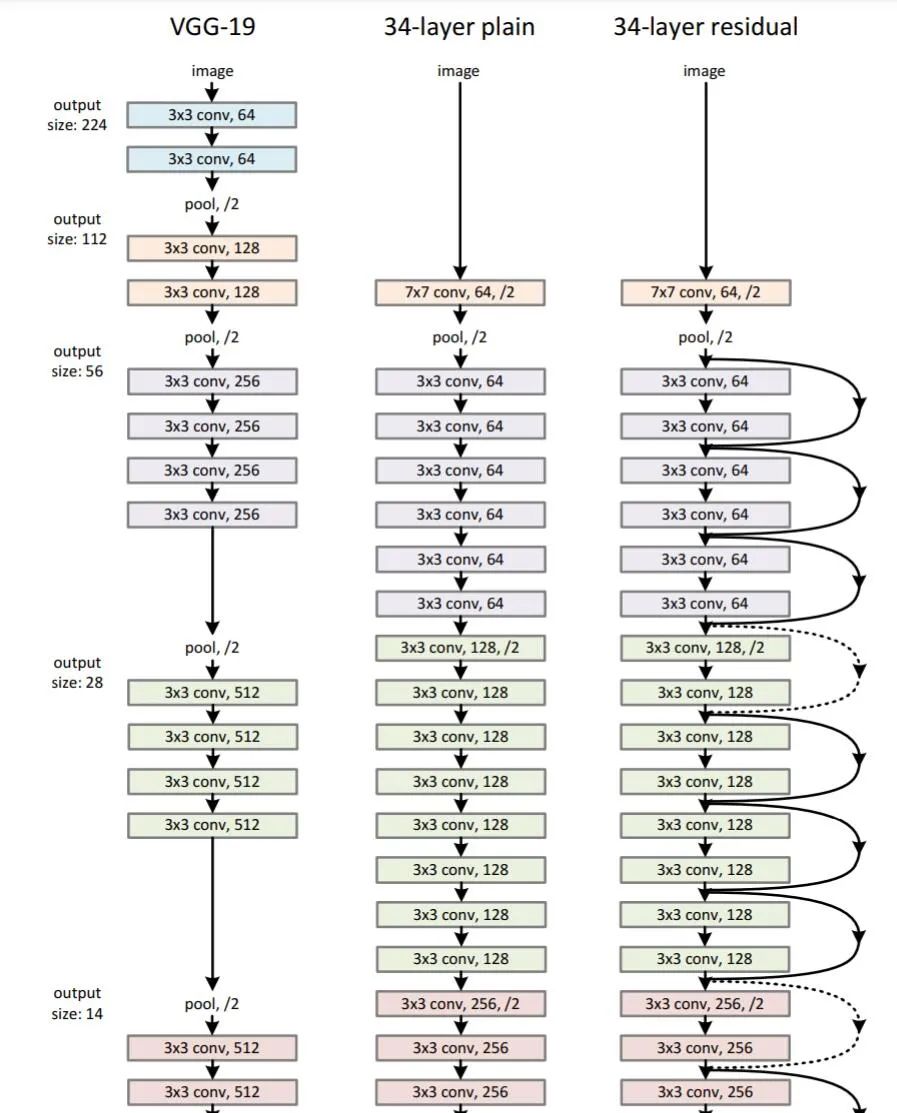

「深度神经网络非常难以训练,我们提出的残差网络框架使得神经网络的训练变得容易很多。」文章摘要的开头如今已被无数研究者们细细读过。

如果觉得有用,就请分享到朋友圈吧!

点个在看 paper不断!

评论

下载APP

下载APP点击上方“视学算法”,选择加"星标"或“置顶”

重磅干货,第一时间送达

导读

「深度神经网络非常难以训练,我们提出的残差网络框架使得神经网络的训练变得容易很多。」文章摘要的开头如今已被无数研究者们细细读过。

如果觉得有用,就请分享到朋友圈吧!

点个在看 paper不断!