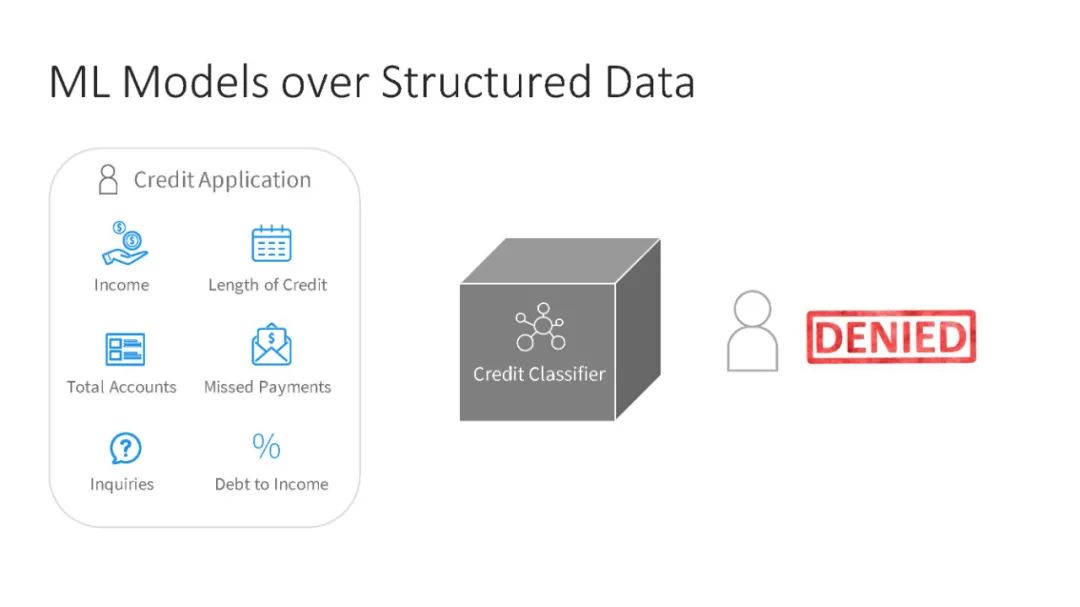

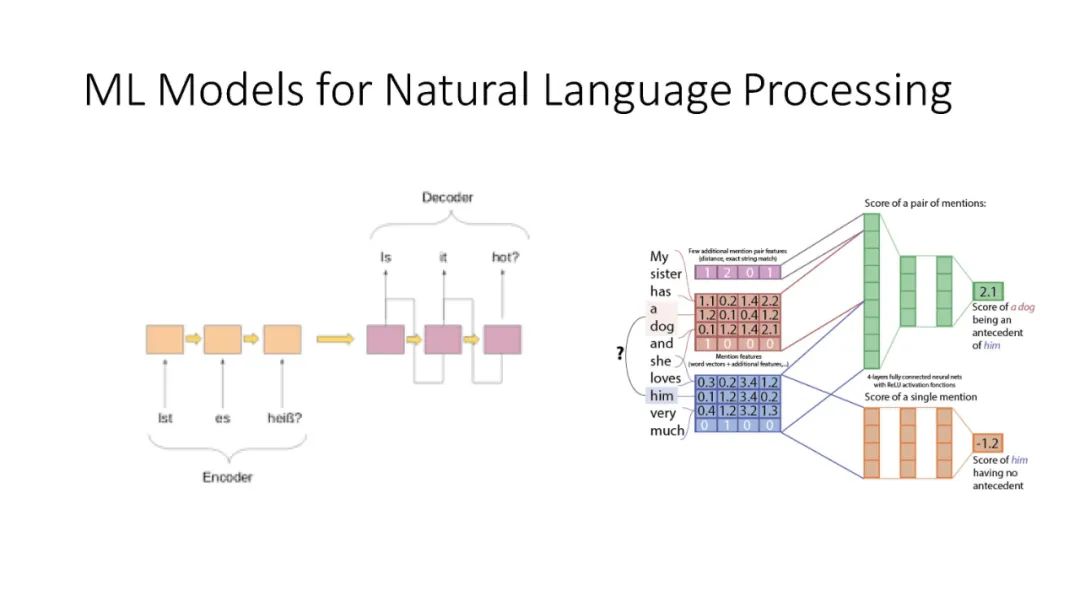

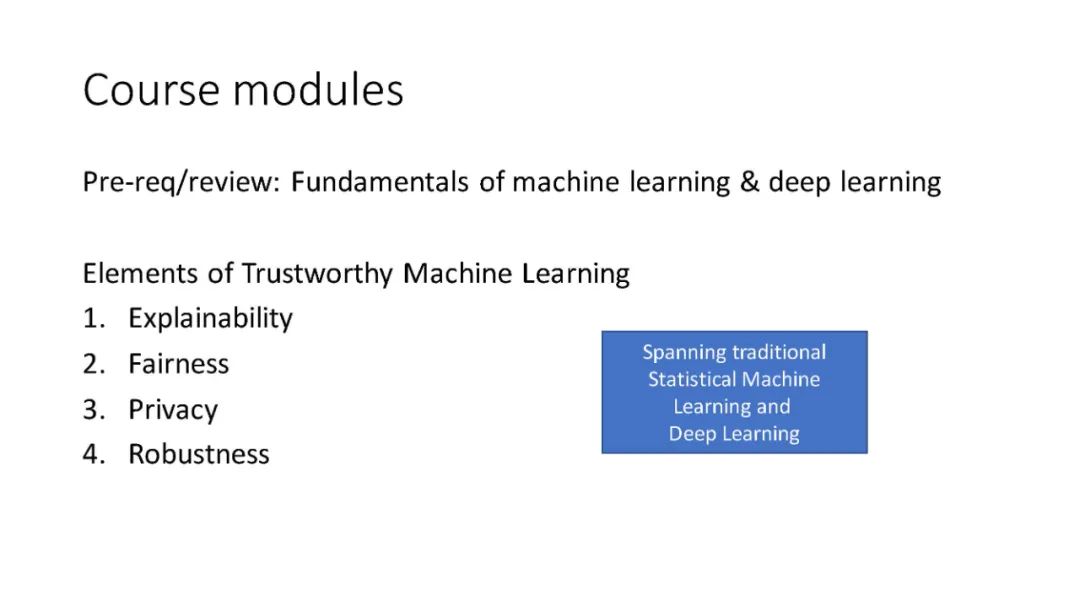

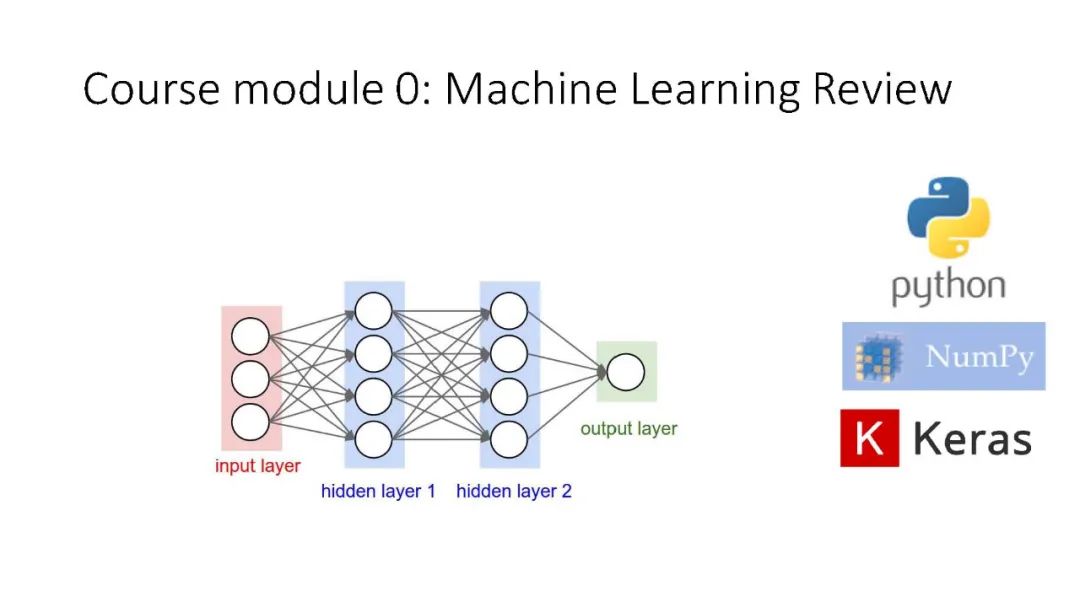

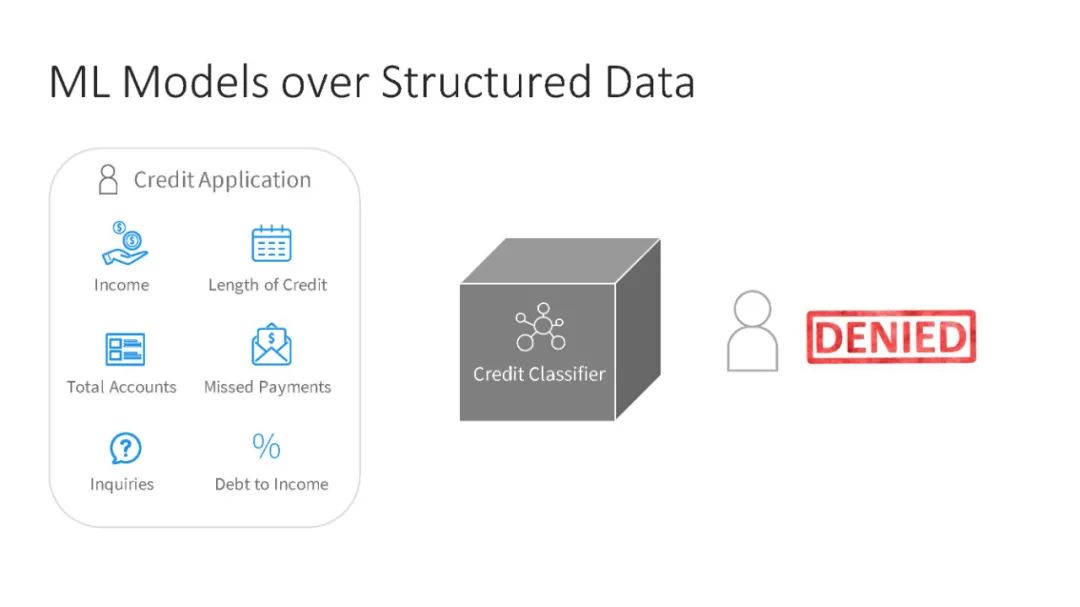

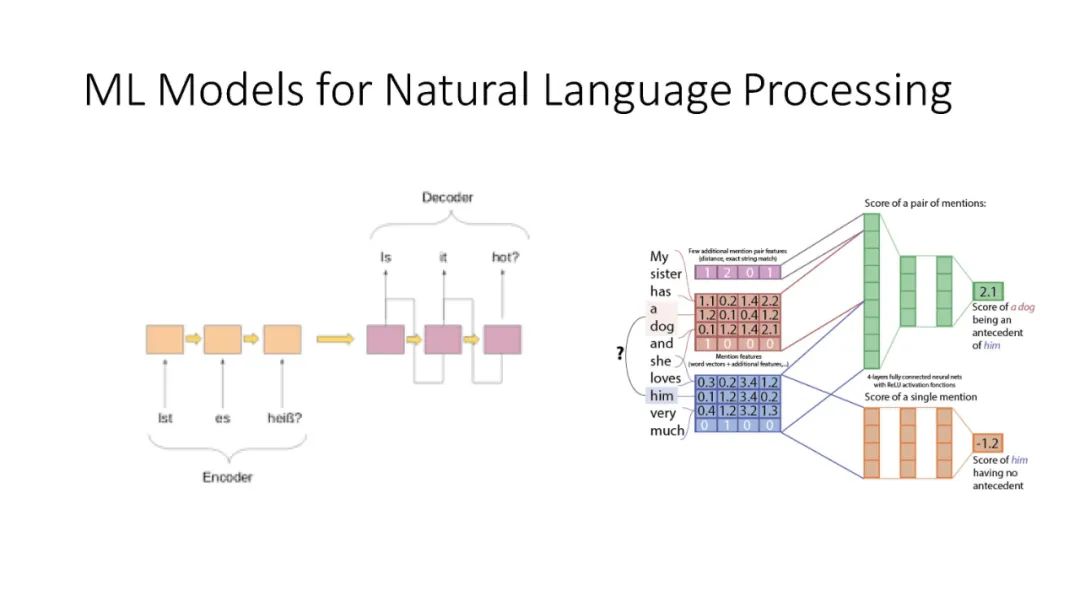

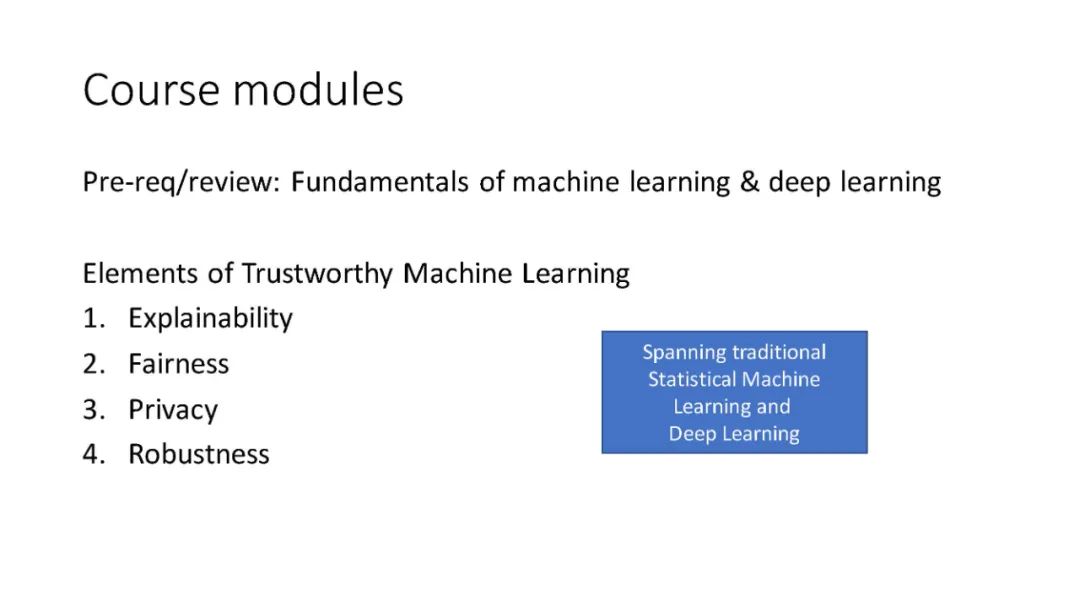

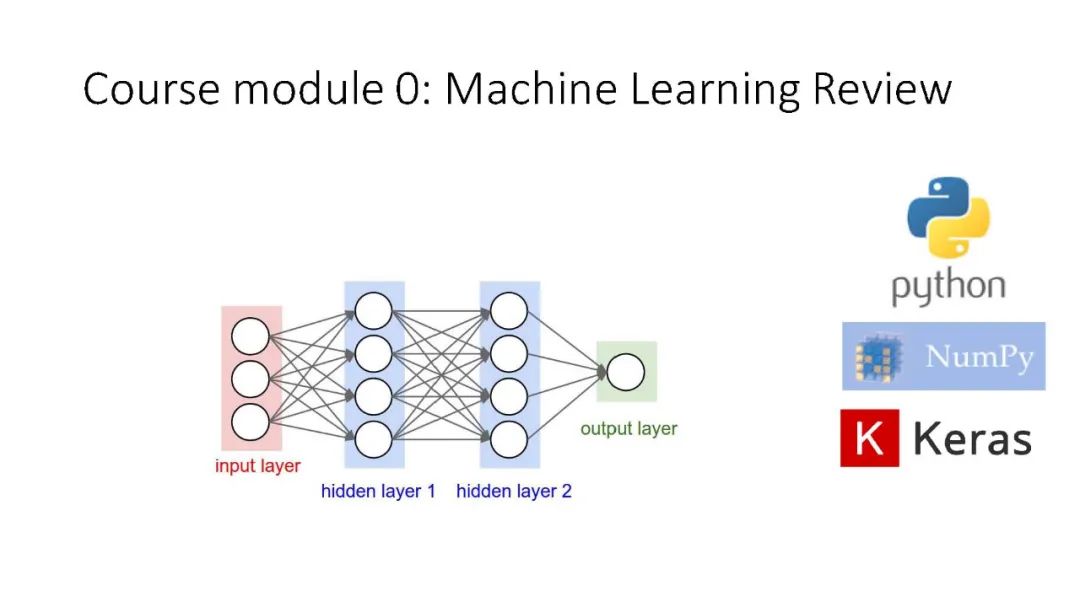

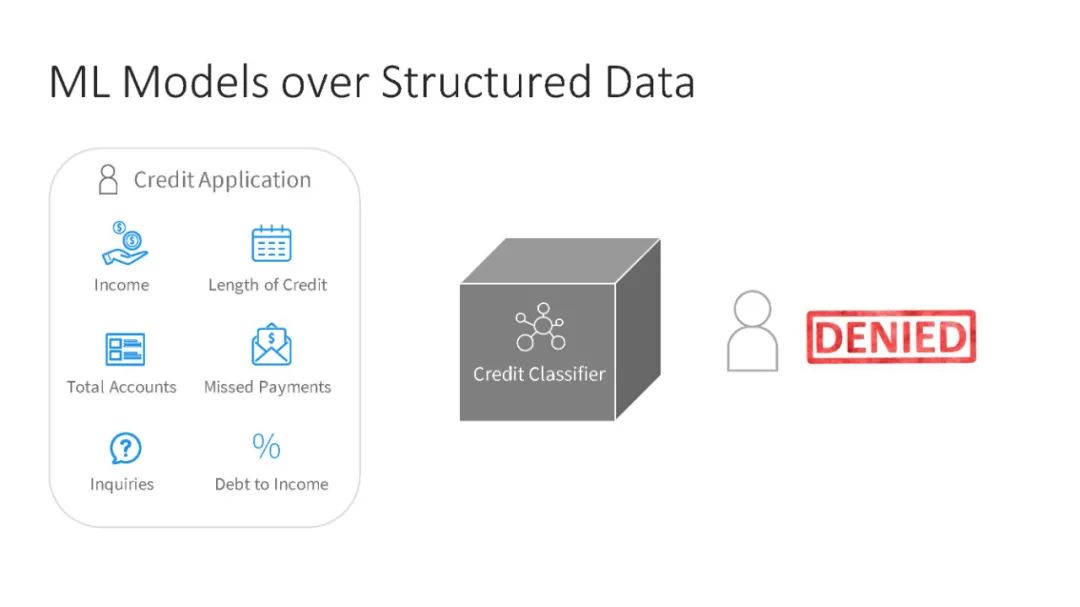

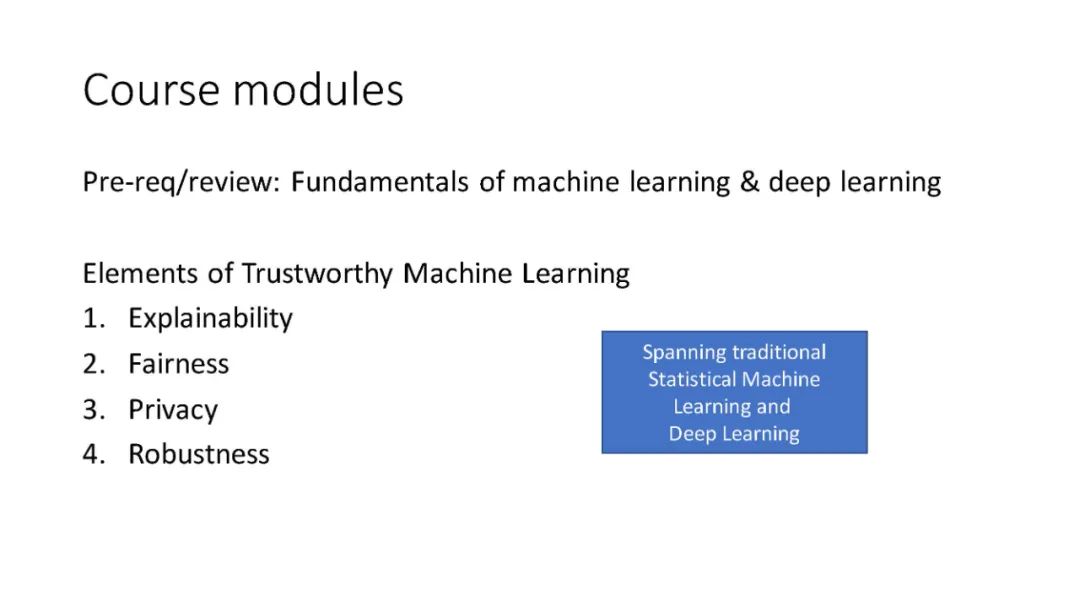

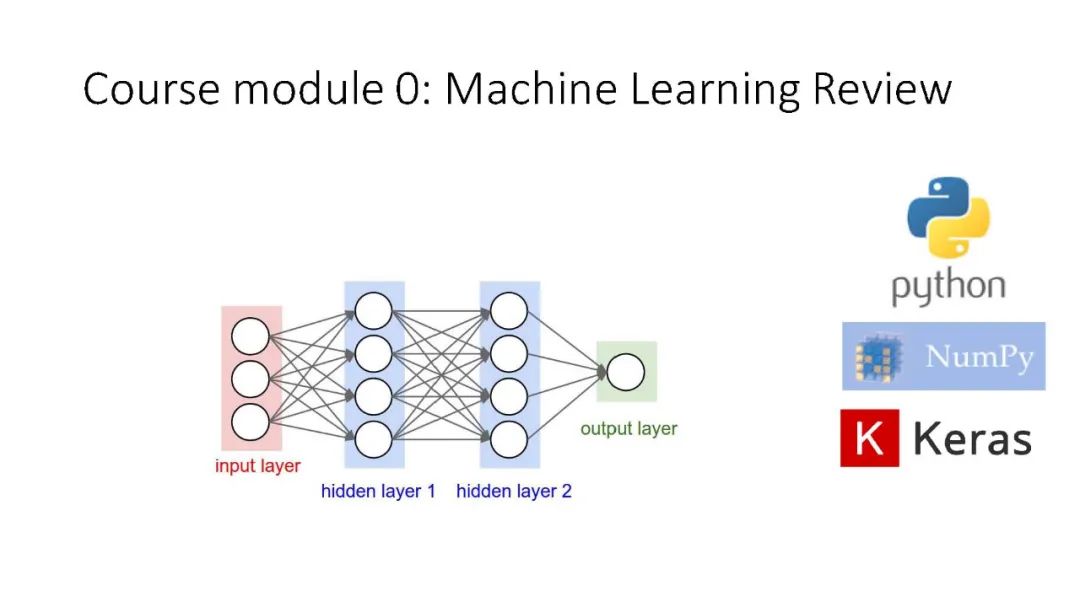

ML模型无处不在——从交通(自动驾驶汽车)到金融(信用卡或抵押贷款申请)和职业(公司招聘)。然而,ML并非没有风险。一些重要的风险涉及模型理解和问责:机器学习创建的模型很大程度上是我们难以窥视和理解的黑盒子;他们容易受到不可预见的错误、对抗性操纵以及在隐私和公平方面违反伦理规范的影响。本课程将提供最先进的ML方法的介绍,旨在使人工智能更值得信赖。本课程关注四个概念: 解释、公平、隐私和健壮性。我们首先讨论如何解释ML模型输出和内部工作。然后,我们研究了偏差和不公平是如何在ML模型中产生的,并学习了缓解这个问题的策略。接下来,我们将研究模型在不应该泄漏敏感信息的情况下泄漏敏感信息的上下文中的差异隐私和成员关系推断。最后,我们将讨论对抗性攻击和提供抗对抗性操作的健壮性的方法。学生将了解一套方法和工具,以部署透明、伦理和鲁棒的机器学习解决方案。学生将完成实验,家庭作业,并讨论每周阅读。

https://web.stanford.edu/class/cs329t/syllabus.html

编辑:文婧

下载APP

下载APP