程增木:激光雷达与摄像头信息融合之路

共

4178字,需浏览

9分钟

·

2021-06-09 14:31

在【首届焉知汽车年会】上,芯片之家联合创始人程增木以“现代汽车集团的多传感器融合之路”为主题,介绍了激光雷达与摄像头信息融合的技术,以及目标跟踪解决方案和卡尔曼滤波方法。他表示,目前比较火的两个主要方向一个是域控制器,另一个是以太网,在L4以上以太网是一个必备的技术。程增木首先结合某款车型介绍了多传感器融合技术。其搭载ADAS辅助驾驶系统,主要包括自适应巡航、还有自动识别行人、自行车、车辆及交叉路口的前方防碰撞辅助系统,以满足2021年最新的法规标准。此外还包括车道检测警告、感应死角的全景影像、驻车辅助,以及后方全景影像摄像头、雷达和超声波传感器。该车型使用的是5R1V12U的ADAS解决方案,安全方面车辆可自主判断驾驶环境,预测事故并积极介入。安全配置包括前防碰撞辅助、安全下车、后方交叉防碰撞。便利方面主要是自适应巡航、车辆跟随和高速公路驾驶辅助功能。他表示,多传感技术融合是利用计算机技术,将来自多个传感器的多元信息及数据以一定规则进行自动分析及综合,为后续决策及估计而进行的信息处理过程。其处理方式像人脑处理信息一样,将多个传感器进行多层次、多空间信息互补及信息优化组合,最后产生对感知环境一致性的解释。在融合过程中对信息需要进行多识别、多方面组合,以产生一些更有效的信息。它不仅需要多个传感器相互协同,而且需要提高数据源质量。基本原理包括五部分,一是需要采集有源、无源数据;二是输出数据,包括离散以及连续函数变量,以矢量直接对它打上标签,进行特征提取,进行一系列变化;三是需要对特殊矢量进行模式识别和处理,包括算法,完成传感器对各个目标标签的说明;四是进行分组关联;最后利用融合算法进行合成,达到目标的一致性。

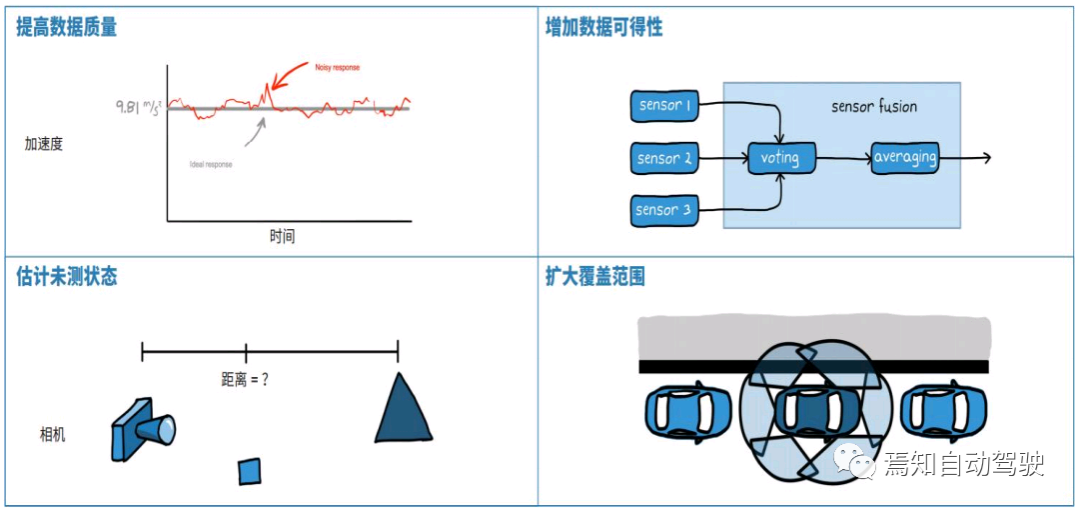

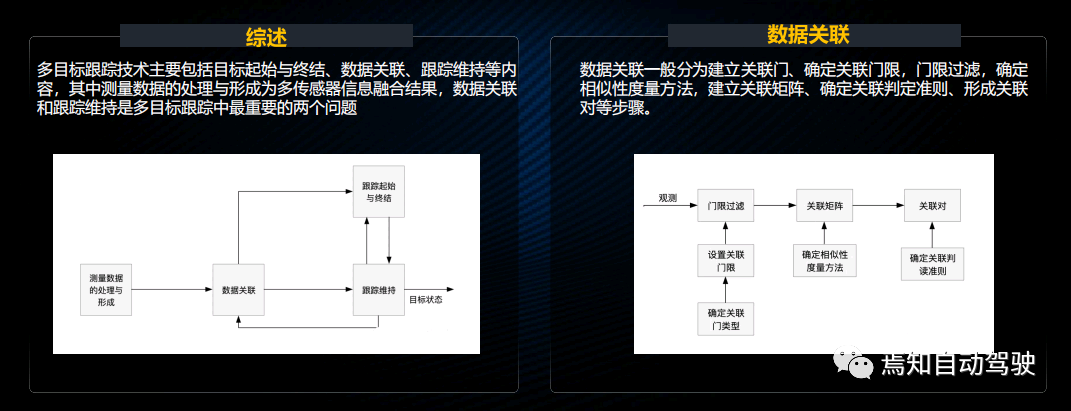

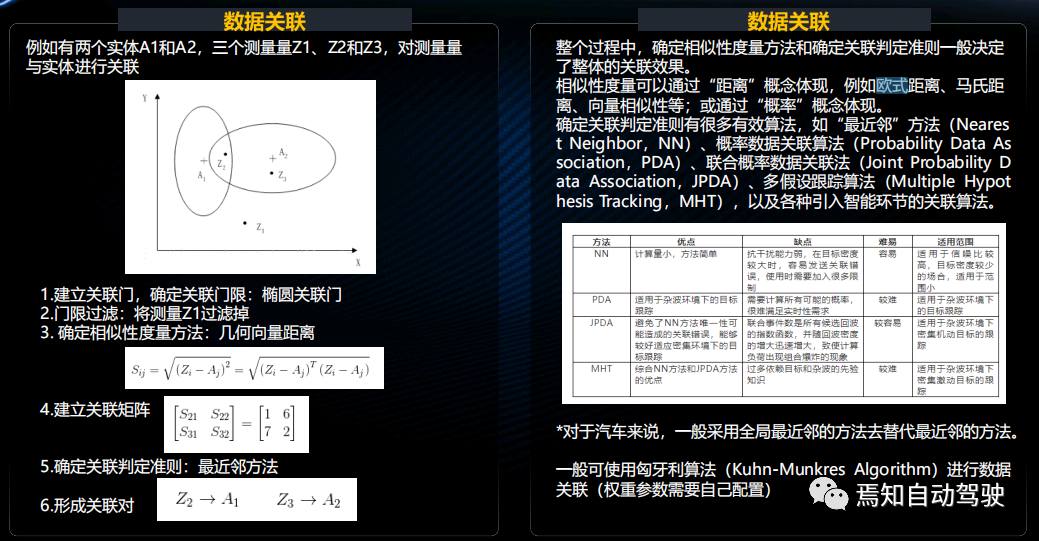

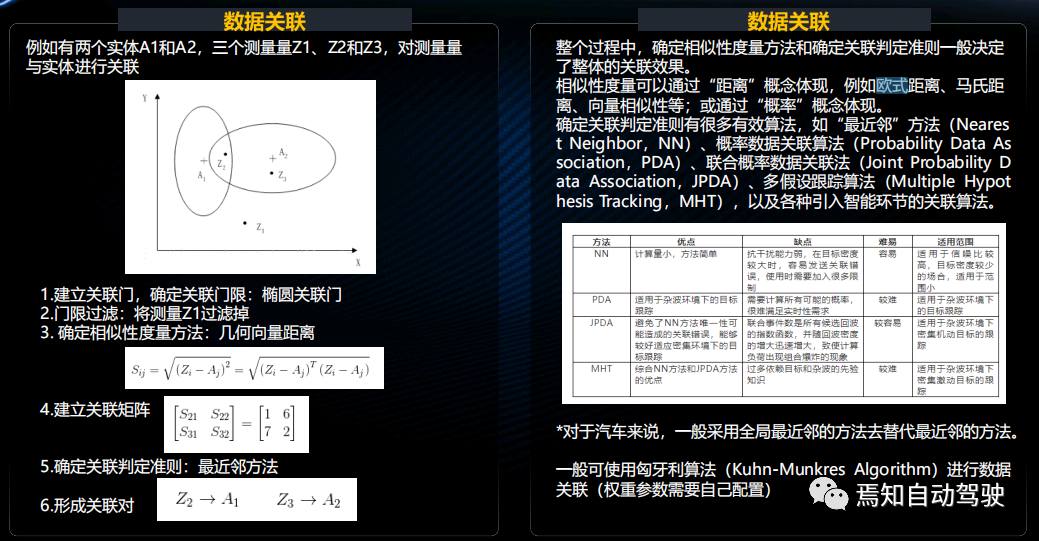

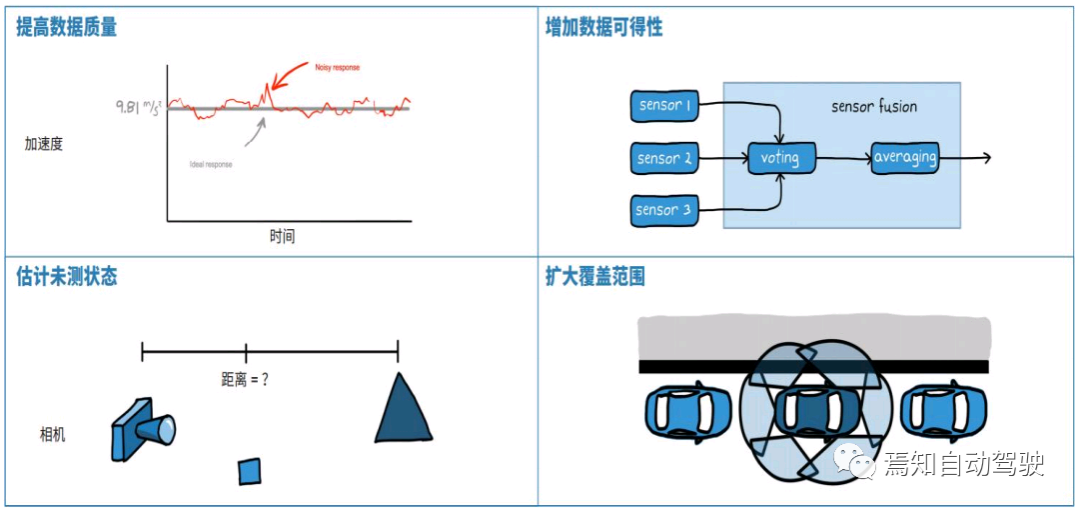

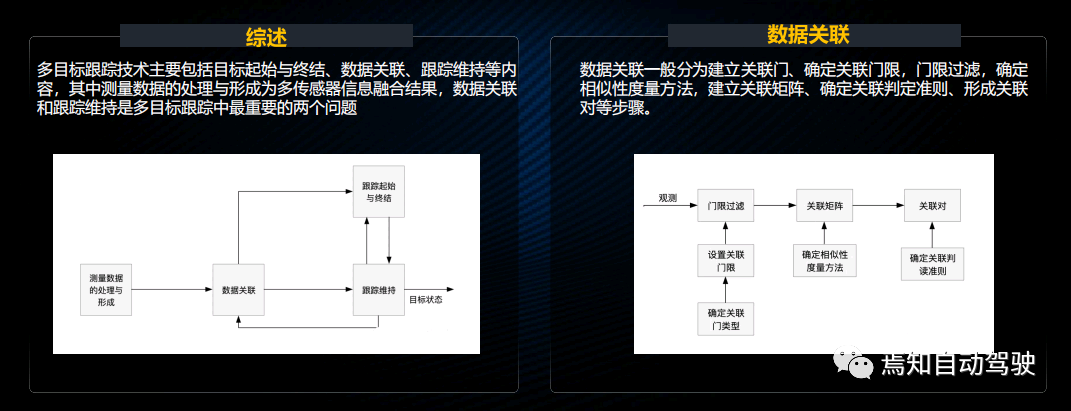

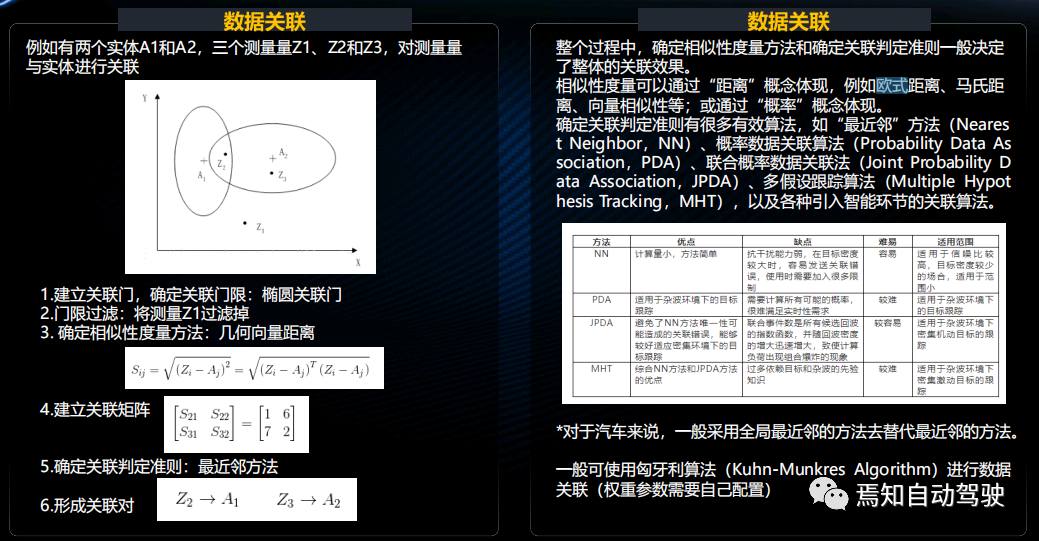

传感器融合是一个信息处理的综合过程,和单一传感器相比,主要优势包括:提高数据质量;增加数据可得性;通过多个传感器融合感测未测的状态;扩大覆盖的范围。传感器融合主要采用三种处理结构:一是集中式,二是分布式,三是混合式,各自有其优势。分布式是把每个独立传感器获得的原始信息进行局部处理,然后将它送进融合中心进行优化后得到最终结果。集中式是把各传感器获得的原始数据直接送到中央传感器做融合,不做处理,可以实现实时融合。这种方式数据量非常大,比较难实现。混合式具有较强的适应能力,兼顾了两者的优势。程增木接着介绍了激光雷达和摄像头信息融合的联合标的问题。做完信息融合之后,需要给它做一个标的,包括两部分内容:第一部分是时间同步,由于各个传感器采集数据发送频率不一样,需要把不同时间采集的数据进行时间坐标的同步;第二是在多传感器融合数据时需要进行空间对齐。目前,时间同步数是用ROS,在ROS中分别订阅不同的需要融合的传感器主题,通过时间同步模块实现统一接收多个传感器数据,然后产生同步结果的回量函数,再把这个回量函数里的变量采出来,之后完成时延同步。空间标定主要是三维点云数据转换为二维数据,然后把它转换成Birdseye,即空间视角图,再转换成二维视角,选择一个感兴趣区域(ROI),进行过滤后运输到像素位置,填充完成后创建图像阵列,然后进行对齐。目前,做的比较好的是百度Apollo开源标的方法,还有Autowire等。激光雷达与摄像头融合之后,会得到一个关于RGB-D图像,可以利用二维检测结果,并以具体信息实现环境检测。它包括分三个部分:第一是Frustum Proposal,主要功能是IPN,检测二级边框,以识别出物体边框,并且确定障碍物的类型,识别出人还是车辆,基于CV技术实现。第二是结合2D边框以及RDB-D信息获得激光雷达点云信息。第三是3D Instance Segmentation,就是Frustum Proposal模块,它输出边框,一般可以看到它检测的比人多出一块,怎么办呢?需要利用点云背景网络架构继续对点云进行提取,也可能别人会用别的点运架构来获得物体信息。最后通过T-Net来估计物体三维尺寸,就可以精准地对目标进行特征提取。采用的是某品牌激光雷达与摄像头联合检测,图像用的是深度学习,用的最多的是开源YoloV3或Foster-RCNN进行训练。点云内聚主要是对行人的检测,对于车辆来说,中央处理器可以对识别出来的物体进行分类,它的标签就是人。相对单纯使用激光雷达进行检测,融合具有以下优势:第二,因为有一些激光雷达点云在某些环境下比较稀疏,在20到30米的人行通道,通常只有2到3个点云数据,所以难以对它进行物体分类,如果利用图像来提取可能会形成更好的互补效果。特斯拉就是这种方案,非常自信地只使用摄像头对物体进行检测和分类。其检测会更加的精准,可以为后续的多目标跟踪及模块提供更优质的输入。程增木介绍说,多目标跟踪技术主要包括目标起始、终结、跟踪维持等内容,其中测量数据的处理与形成是多传感器信息融合结果,数据关联与跟踪维持是多目标跟踪中最重要的两个问题。数据关联一般分为几个步骤:建立关联门、确定关联门限、门限过滤、确定目标相似度,以及建立关联矩阵,并确立判断选择,最后形成关联。数据关联概念比较难理解,举个非常简单的例子,比如空间中有两个实体A1和A2,三个测量Z1、Z2和Z3,要进行关联,第一步是建立关联门,确定关联门限,关联门是两个椭圆。第二步对它进行过滤,可以看到Z1不是关联范围内的变量,首先把它给去掉。第三步需要确定相似度度量方法,可以利用几何向上的测量方法,主要是通过欧式距离计算公式。第四是建立关联矩阵,建立之后利用一个关联判断准则来形成关联对。可以看到,在关联中Z2和A1是在一个团队里,也就是说它们两个是密切关联的,而Z3和A2是在一个团队里,所以它们两个是最关键的变量。

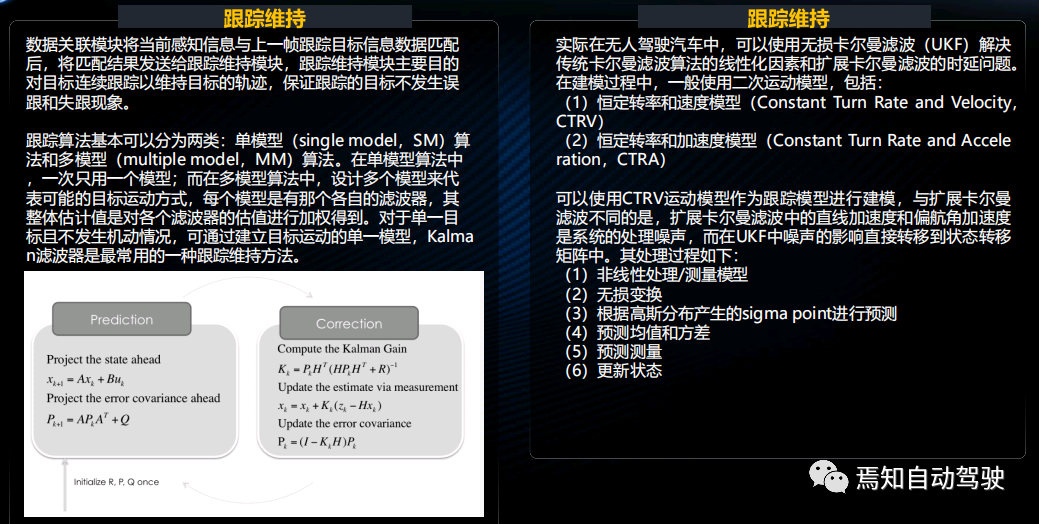

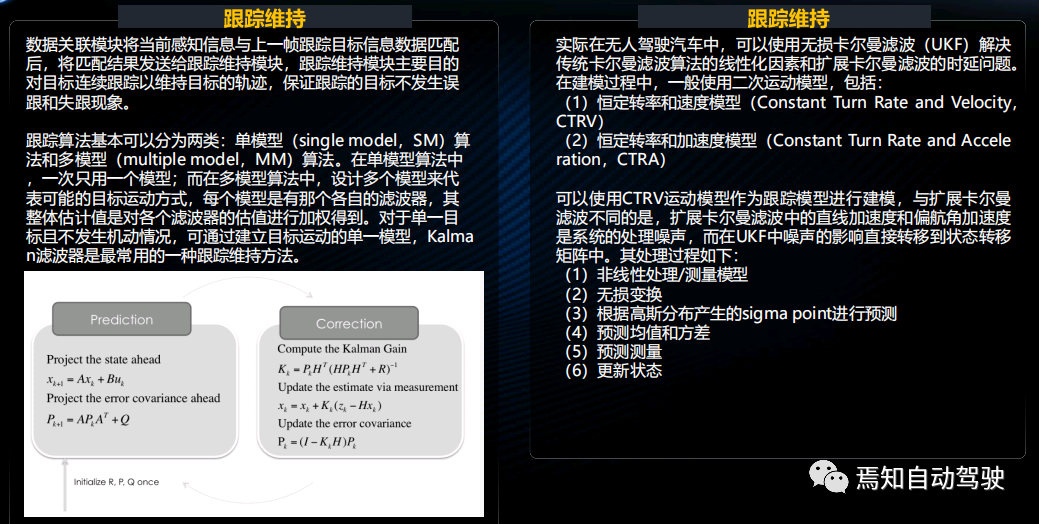

通常,用数据关联来确定相似度量方法和确定关联判定准则决定了整体关联效果。相似度度量可以通过距离来体现,比如欧式距离或者马氏距离,向量相似形是通过概率概念体现。有几种具体判断方法,各有优缺点和适用范围。对于汽车来讲,一般采用全局最近邻的方法去替代最近邻的方法,不管工业界还是学术派,目前最好的办法是匈牙利算法数据关联。在跟踪维持方面,数据关联模块的当前感知信息与上一帧跟踪目标信息数据匹配后,将匹配结果划分到跟踪、维持模块,即汽车感知层级。跟踪维持模块的主要目的是对目标进行连续跟踪,并需要对目标可能出现的轨迹进行预判,以保证跟踪目标不发生误跟或失跟现象。

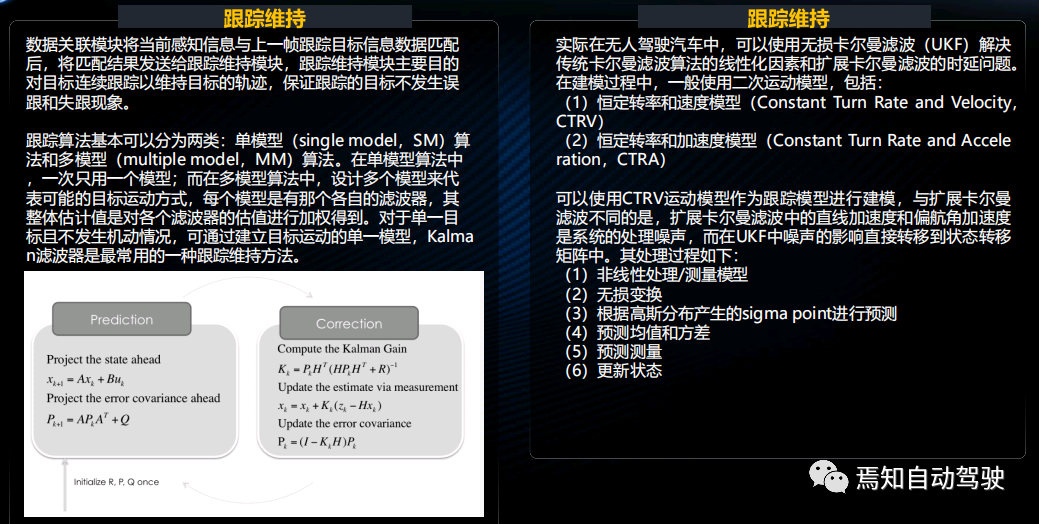

跟踪算法主要分两类:一类是单模型算法,另一类是多模型算法。前者一次使用一个模型,后者需要设计多个模型,判断其以后可能会出现的一些运动方式。每个模型都有各自的过滤器,整体估值是对每个滤波器的加权进行处理。用的最多的一种方法是卡尔曼滤波器。在在无人驾驶中,目前效果比较好的是无损卡尔曼滤波(UKF)办法。它可以解决传统卡尔曼滤波算法中一些限制化因素,并扩展卡尔曼滤波。扩展卡尔曼滤波主要是解决一些非线性化场景,但它有一个致命的问题,即时延。对于智能网联汽车、无人驾驶这种需要非常强时效性的应用来说,需要解决时延问题,而扩展卡尔曼滤波恰好完美解决了两个问题。在建模过程中,一般采用二次运动模型,主要是以下两种,其中一个是CTRA作为进行跟踪模型建模。不同的是,扩展卡尔曼滤波是直线加速度,而我们作为预判的是角加速度,是系统的处理噪声。在UKF中噪声可以用一个状态转移矩阵表示。用这个过程可以达到比较好的跟踪效果。程增木还展示了现代集团的轻燃料L4级车型Nexo。他介绍说,该车从首尔开到釜山,搭载了各种传感器。车设计中有一个按键,可以直接启动自动驾驶。它用摄像头识别物体,在隧道中,GPS不好用,这时用航向补偿,可以测前方车速。目前,立交桥和交叉路口是比较难做的,因为交叉路口上下堆叠的关系比较难处理。在非常高曲率过弯的极限状况下,行人识别、三岔口交通识别,目前都能做到,还有一些交通标志的识别,这也是L4级比较基础的功能,也包括转盘工况。

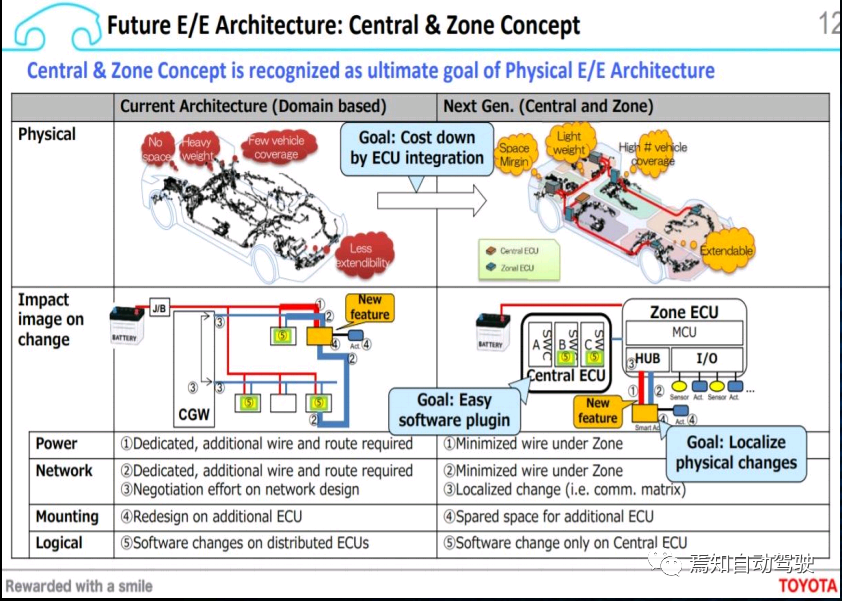

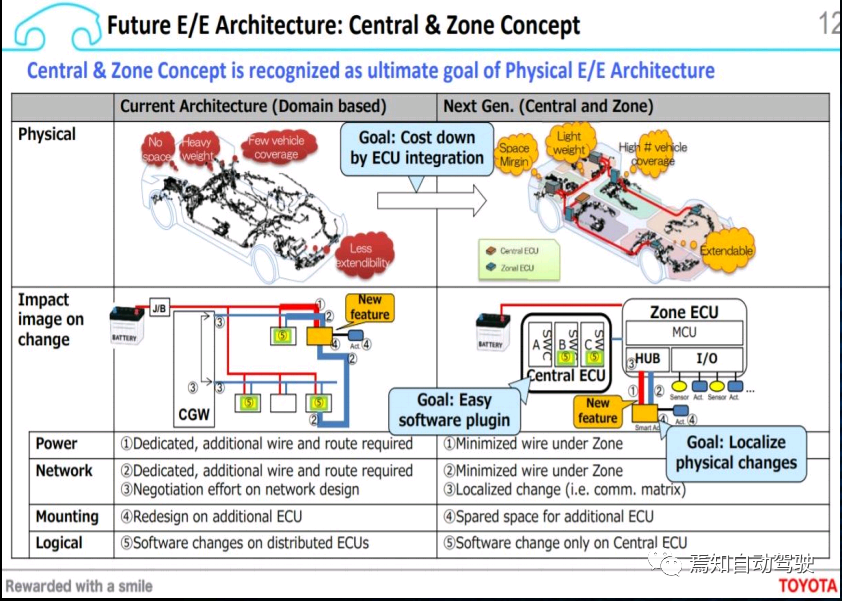

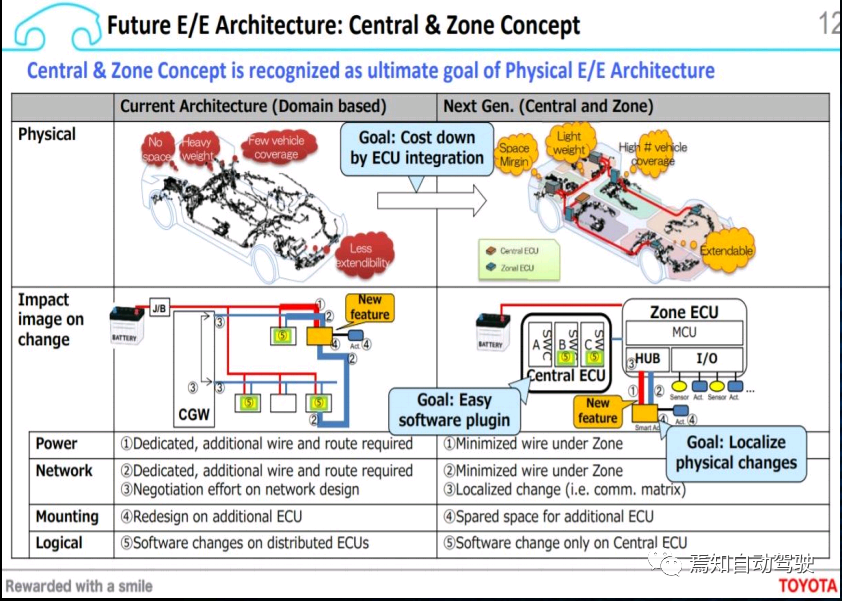

程增木最后展望了未来的技术发展。两个主方向一是域控制器,二是以太网,L4交互必须有以太网。他结合丰田的域控制器架构介绍说,域控制器最初的逻辑并不是为了减少车辆ECU数量,而是为了整合数据,增强计算能力。

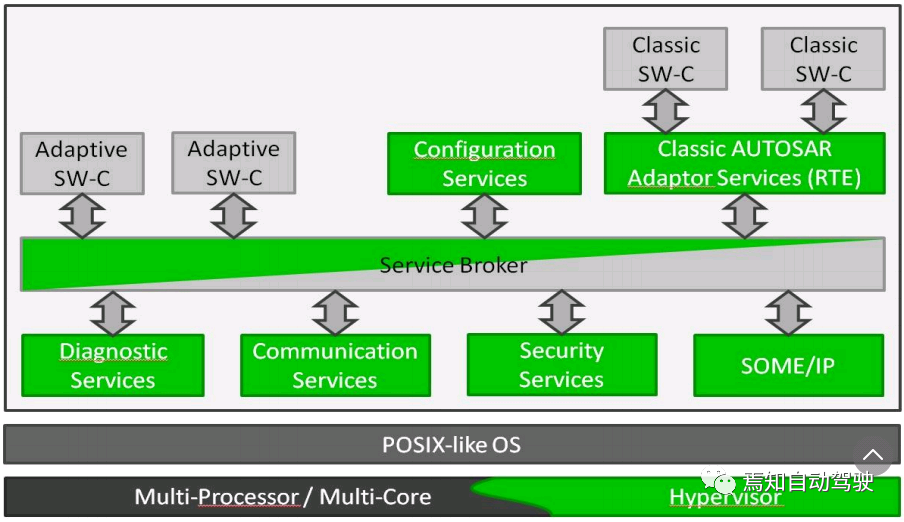

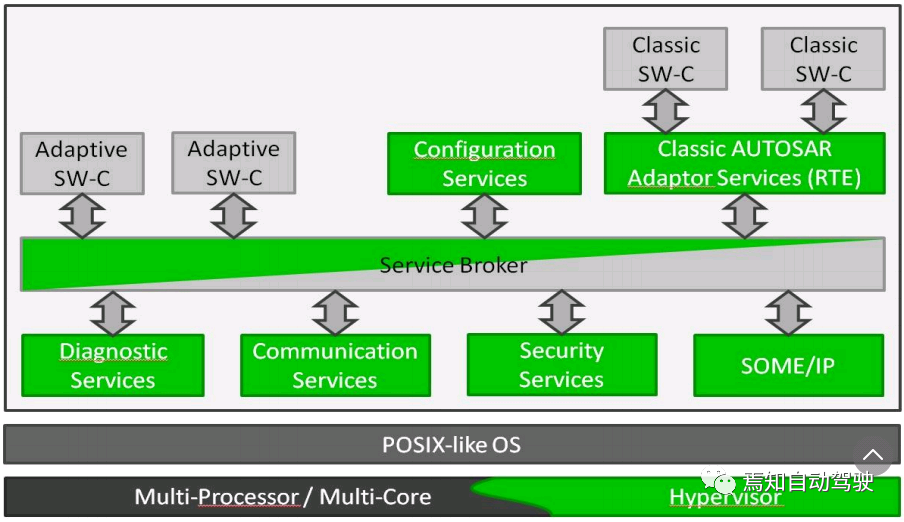

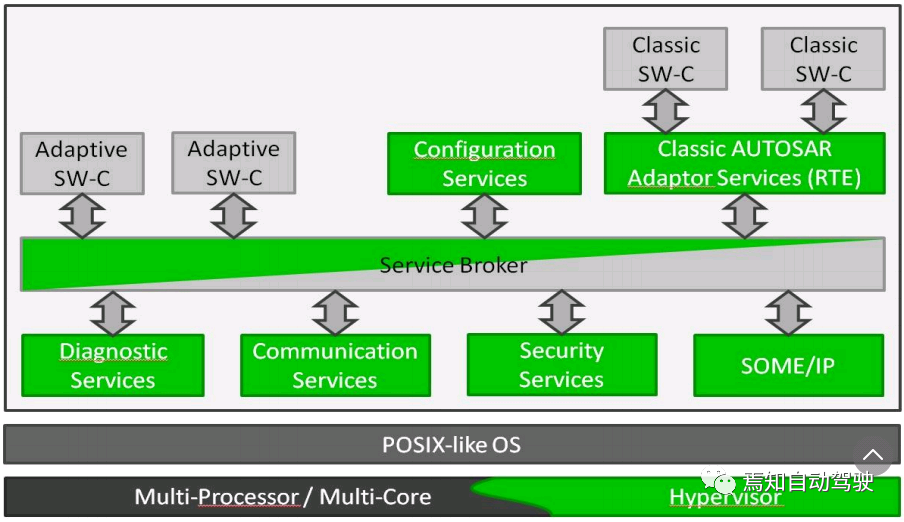

目前,OEM还是按照传统的域来进行划分,例如发动机域控制器,还有新能源OEM的“三电”,可以合成一个域控制器;另外底盘及L4级别线控转向,都需要利用一个域控制器器去处理;还有电子电器、智能网联域等。如果按照中心域(CZ)划分,新型域的开发更像是按照层任务来进行:应用层、感知层、网络驱动层、硬件层、整车层等。OEM的层级不便于开发。现在大部分域控制器制器内部架构是依据AUTOSAR或OSEK,OSEK用的人越来越少。开发一个静态驱动系统,在软件系统运行过程中更多是一些函数的调用,将事先安排好的排序文件依次调动,逐个进行,以满足对行车安全苛刻的运行需求。例如安全气囊,是否打开安全函数,是否每毫秒循环检测一次,在紧急情况下使气囊能够打开。然后利用多核处理器,对运行时间没有特别高要求的功能函数,动态驱动系统有更多的优势,比如以服务为导向,可以进行软件升级,针对这个系统AUTOSAR也提出了一套可变AUTOSAR的解决方案,既可以囊括动态驱动系统的优点,也为传统AUTOSAR提供了接口。

这样,整车厂和不同供应商的众多软件包分别构成了诊断服务、安全措施、通信服务等功能块,并集成在Adaptive-AUTOSAR工作组中。所有的软件通过Service-Broker互通信息,并为传统的AUTOSAR软件提供接口。关于智能网联汽车的更多知识,欢迎购买程增木出版的专业科普书籍《智能网联汽车技术入门一本通》进行学习。出版社/小程序/京东

长按对应图片二维码购买

点赞

评论

收藏

分享

手机扫一扫分享

举报

点赞

评论

收藏

分享

手机扫一扫分享

举报

下载APP

下载APP