资源|深度学习注意力机制TensorFlow 使用教程

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

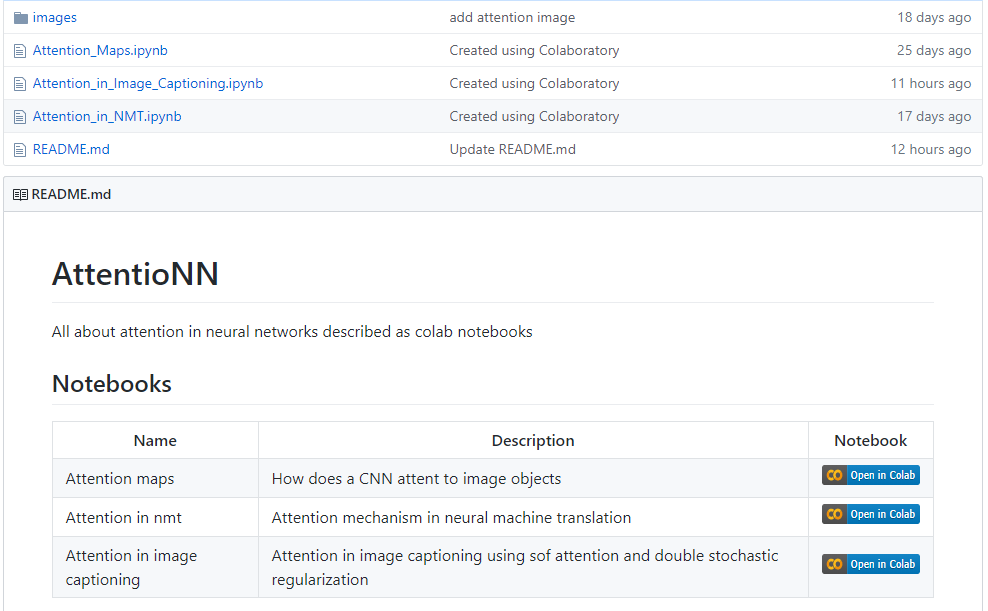

【导读】本资源介绍了以下3个方面:1)如何在图像上应用CNN attention。2)神经机器翻译中的注意机制。3)在图像配图中应用attention和双随机正则化。

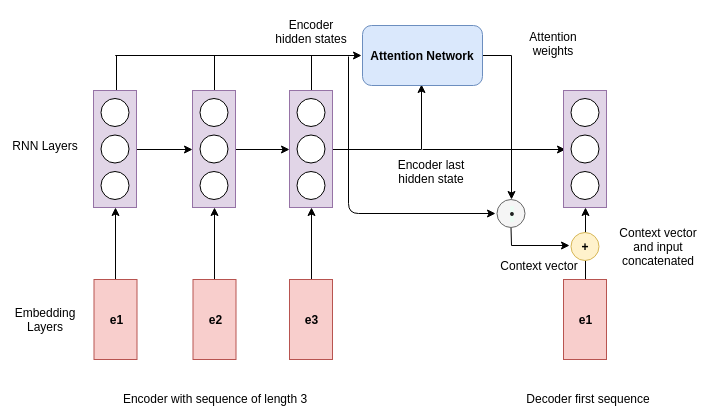

在这节课中,我们学习深度学习模型注意图像的哪些部分。根据我们在网络中的深度,我们可以学习不同层次的注意力图。

传统的图像字幕模型体系结构存在瓶颈问题。通常,我们使用一个预先训练的模型来提取固定的特征,这些特征被直接提供给一个RNN模型来生成标题。然而,随着时间的推移,这种表现会影响字幕的效果,因为我们把图像看作一个整体,而不是局部。注意力背后的基本思想是迫使模型为图像的不同部分分配权重,这使得字幕处理更加有效。

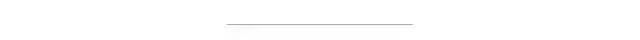

地址连接:

https://github.com/zaidalyafeai/AttentioNN

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~

评论