超100篇!CVPR 2020最全GAN论文梳理汇总!

转自 | 新智元 编辑 | 好困 LRS

【导读】AAAI 2022刚要落下帷幕就又被掀起来了!大连理工本科生一作论文中稿,本该是件值得庆祝的事,但有网友发现了论文中的致命漏洞:声称的无监督方法竟然引入了标签!这让无数被拒的论文情何以堪?导师及二作都出面澄清将会补充实验,但一作仍未公开发声。

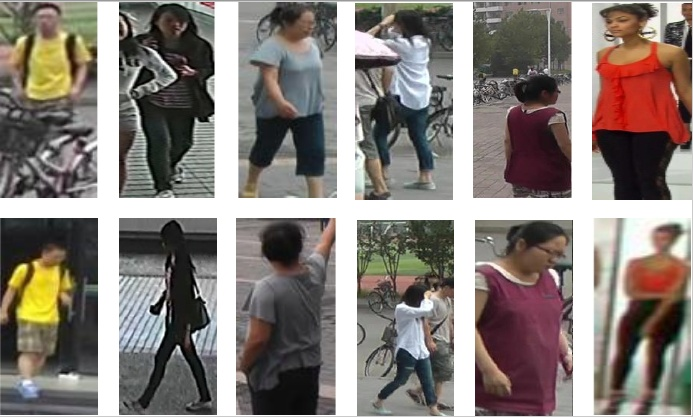

顶会AAAI 2022的惨烈程度,各位投稿人一定心有体会,近万篇投稿只有15%的录取率,无数全positive的优秀工作被录取率卡掉。「有的时候中了不一定是好事,不中也不一定是坏事。」最近知乎上的一个问题如平地惊雷,将本已缓缓落幕的AAAI 2022又拉回大众的视线。在这篇AAAI 2022中稿论文中介绍了一个无监督的行人重识别(Re-identification, Re-ID)技术,效果之好让相同领域的研究人员直呼绝望,性能直逼有监督,以一己之力把无监督的Re-ID技术抬到了天花板。原来如此强的论文才能入选顶会,那自己的论文被拒也是在情理之中。但抱着学习的态度继续深入看这篇论文的时候,越看越有点不对劲。作者将某些真实标签数据误认为是先验知识输入到模型中了,从原理上来说这已经不是无监督了,而是实实在在的有监督。首先科普一下这个行人重识别(Re-ID)是什么东西。在监控视频中,由于相机分辨率和拍摄角度有限,通常无法得到高质量的人脸图片。当人脸识别失效的情况下,Re-ID就成为了一个非常重要的替代品技术。行人重识别(Person/Pedestrian Re-Identification)是利用计算机视觉技术判断图像或者视频序列中是否存在特定行人的技术。行人重识别可以被认为是一个图像检索的子问题,给定一个监控行人图像,检索跨设备下的该行人图像,从而弥补固定的摄像头的视觉局限。行人重识别可与行人检测/行人跟踪技术相结合,并广泛应用于智能视频监控、智能安保等领域。其中,行人重识别一个非常重要的特性就是「跨摄像头」,所以评价一篇学术论文所取得的性能如何,是要检索出不同摄像头下的相同行人图片。Mind Your Clever Neighbours

目前,大多数的无监督行人重识别(Re-ID)技术都采用了迭代聚类机制。其pipeline大致可以分为三个部分:特征提取,在每一个epoch开始的时候,通过网络将训练数据集中图片的特征都提取出来。

聚类,通过传统的聚类方法如DBScan, KNN通过特征把图片聚成不同的类别,每个类别给一个标签,就是用来训练的伪标签。一开始的伪标签是很不准的,在训练的过程中,随着网络的精度越来越高,伪标签也会越来越接近真实标签。

图片特征的存储和更新,在网络训练的过程中,随着网络参数的变化,图片的特征也需要进行对应的更新。

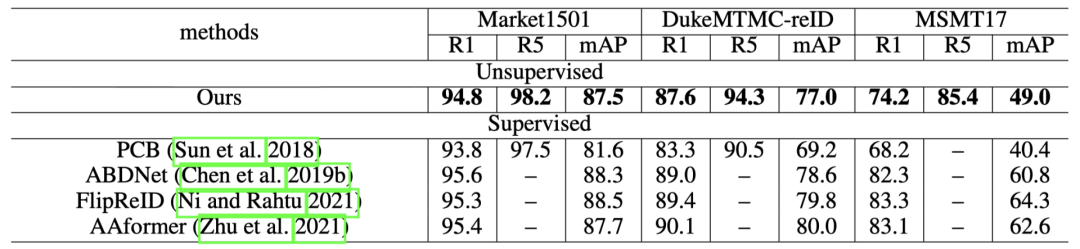

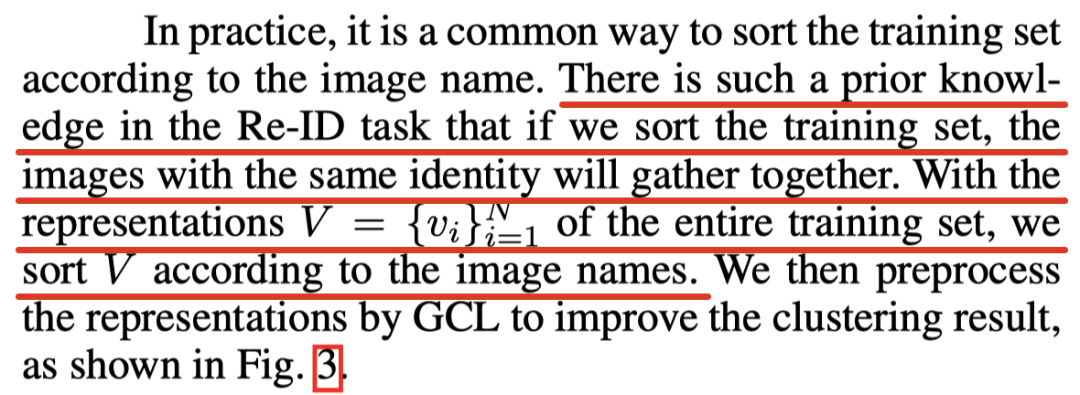

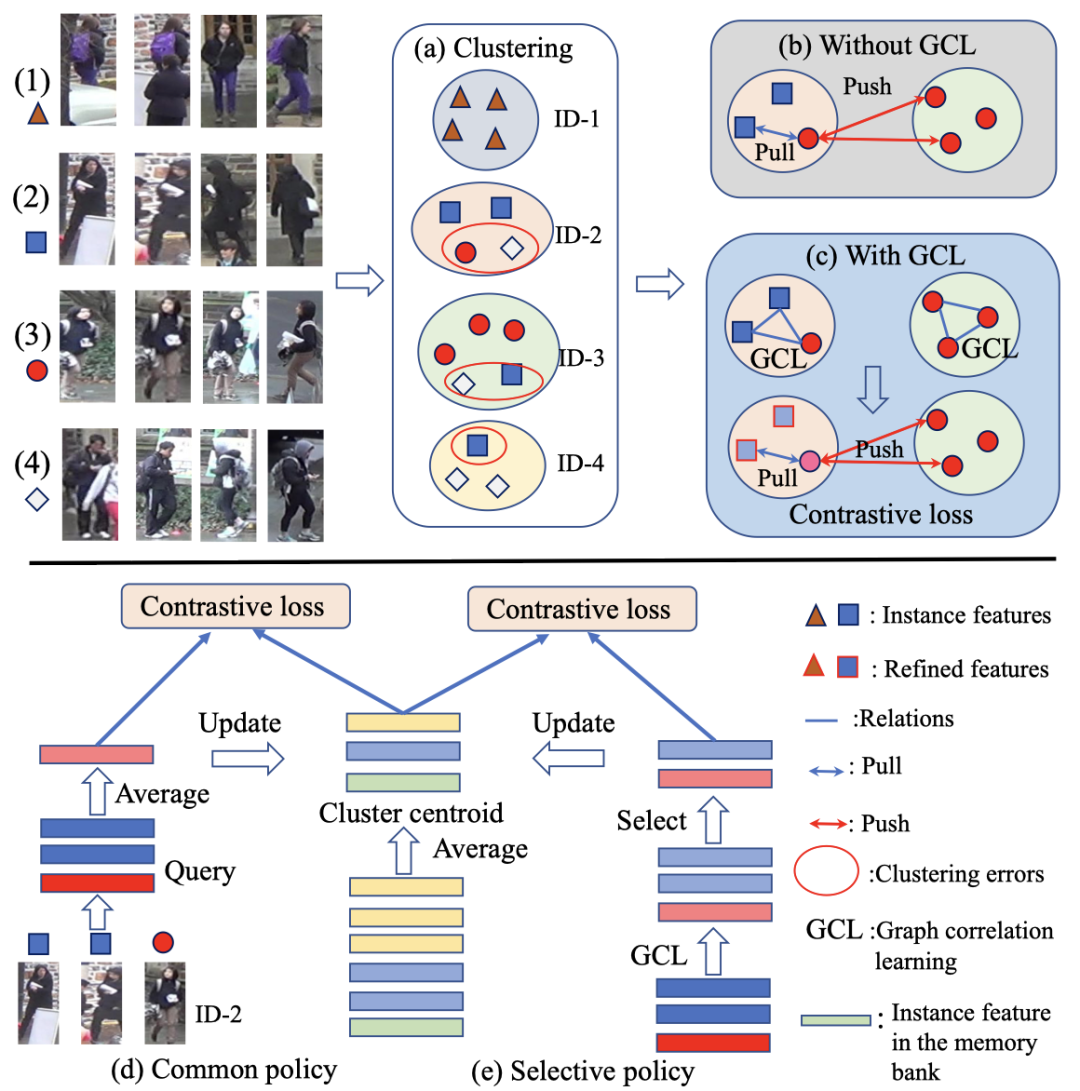

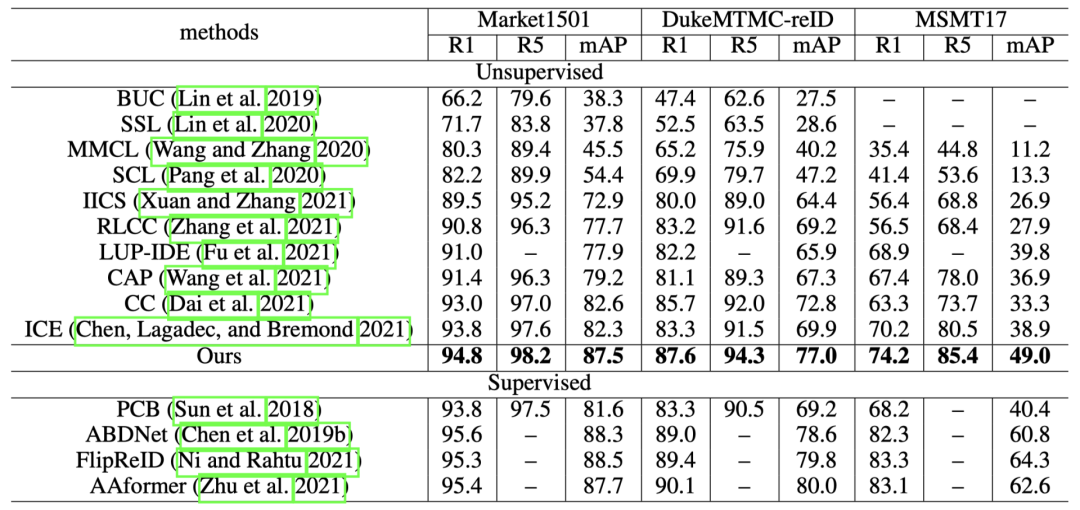

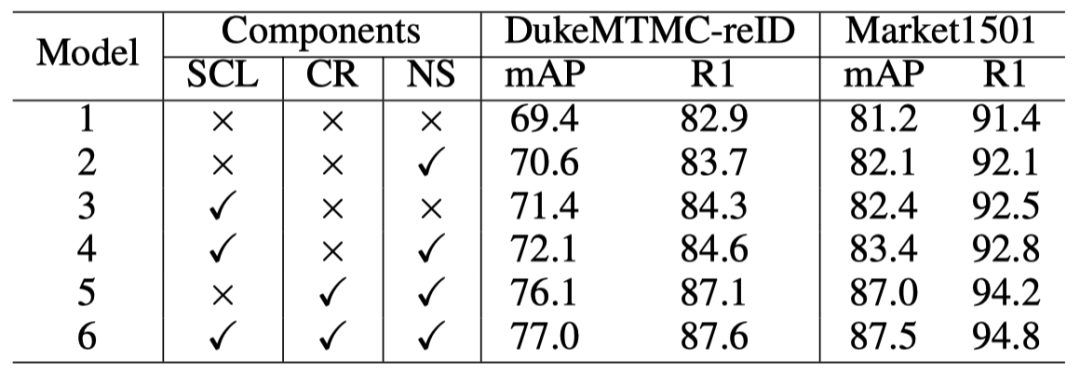

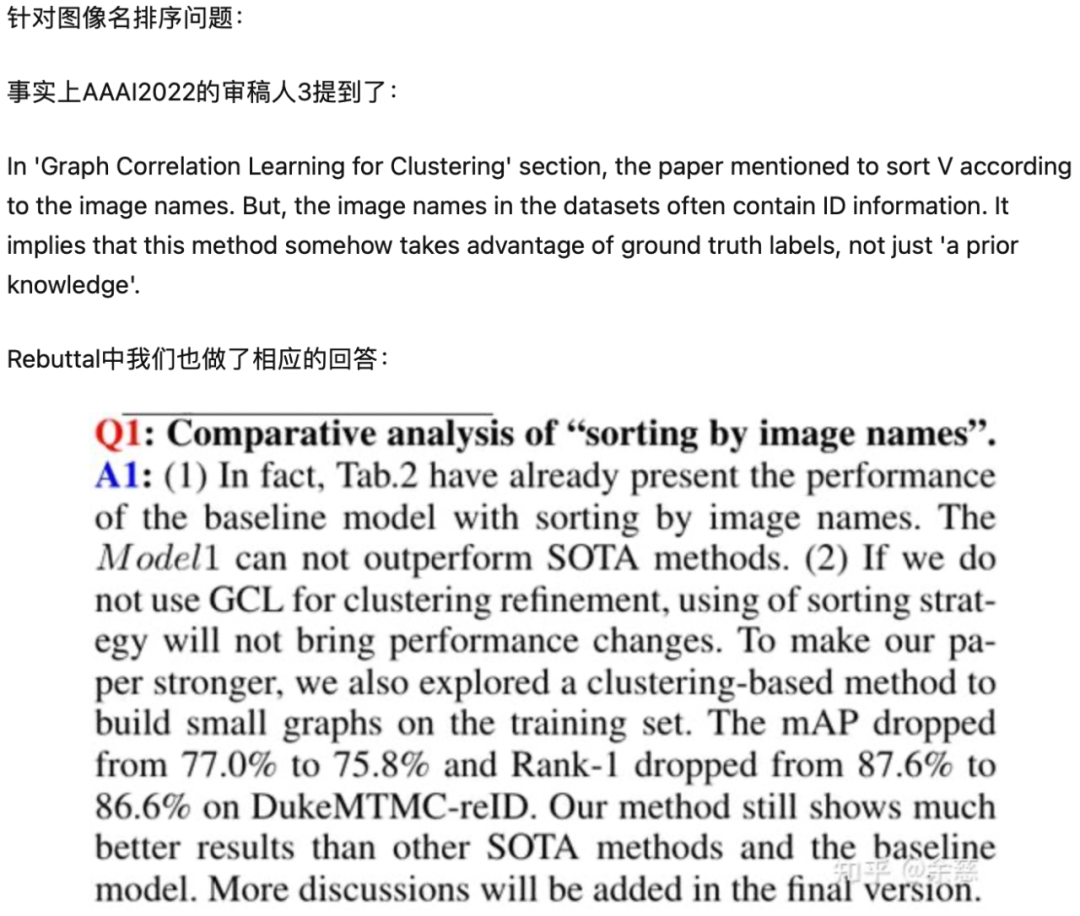

这篇备受争议的文章主要研究的就是第二步,作者提出了一个新型的聚类关系建模框架。也就是在聚类之前,使用基于图相关学习(graph correlation learning, GCL)模块来探索未标记图像之间的关系,然后将提炼出的特征用于聚类,从而生成高质量的伪标签。https://arxiv.org/abs/2112.01839v1具体来说就是GCL模块的输入是一个样例图像和它的相邻图像,因为相邻图像和样例比较相似,所以聚类的效果就会有所提升。关键来了,如何判断两个图像是否相似,并让他们相邻?作者表示他们采用了一个众所周知、常用的方法:把所有的图像按照「图像名」排序,然后把相邻图像输入GCL就好了。可能不懂Re-ID的人此刻已经被蒙混过去了,使用了一个「众所周知」的排序方法作为先验知识,加上文章提出的GCL模块,效果提升了。「图像名」在Re-ID任务上和标签和标签无异。论文中使用的dukemtmc和market1501数据集中,图片就是以ID进行命名的。每个图像名的写法都是「PersonID_CameraID_其他信息.jpg」,所以如果按照图像名排序的结果就是相同人物都已经按照顺序排列好了。图名=人名,顺序排列,相邻图像,GCL,聚类。。。等等,你是无监督?并且论文在行文的过程中似乎也刻意避开描述排序过程中利用的信息。在正文中作者只是表示他们没有直接使用特征提取器的输出进行聚类,而是首先对训练数据集中的样本之间的关系进行建模。由于为整个数据集建立一个graph是非常耗时耗力的,所以作者选择以批处理的方式构建一系列的small graph。如(a)和(b)所示,由于一个伪标签通常由多个实例组成,当不同身份的图像被认为是同一类别时,会降低Re-ID的性能。在这项工作中,GCL模块被用来重构mini-batch的样本表征,如(c)所示。通过这种方式,我们不仅提高了聚类的质量,也减轻了聚类错误的影响。可以看到,描述过程中作者完全没有提到GCL模块所依据的信息(训练数据的文件名,也就是训练数据的标签),转而描述了GCL模块中使用的两个trick,对于没有认真看method部分的审稿人来说,可能就会认为文章中的GCL贡献确实很大。作者在三个基于图像的人物识别基准上与SOTA的方法进行了比较,结果显示,论文提出的方法不仅刷新了无监督的SOTA,甚至超过了部分有监督学习。Market1501数据集,R1为94.8%,mAP为87.5%。与目前公布的最佳方法ICE相比,在R1精度和mAP上分别取得了1.0%和5.2%的提升。DukeMTMC-reID数据集,与考虑了训练期间相机变化的方法CAP相比,在R1和mAP方面提高了6.5%和12.7%。在具有挑战性的MSMT17数据集上,mAP也取得了49.0%的好成绩,R1则为74.2%,在mAP和R1上超过CC16.7%和10.9%。这种高性能表明论文提出的方法可以帮助生成高质量的伪标签,减少聚类错误的影响。与包括PCB、ABDNet、FlipReID和AAformer等有监督的方法相比,作者提出的无监督方法仍具有竞争力。虽然在具有挑战性的MSMT17上,有一定的性能差距。但是整体而言都取得了比有监督PCB更好的性能。但是,从消融实验的结果上来看,性能基本全依靠Cluster Refinement(CR),也就是论文提出的GCL。其中,「SCL 」指选择性对比学习;「CR」指通过GCL进行聚类重构;「NS」指噪声抑制。如果说,CR是论文中最重要的Component,而这里又存在标签泄漏的问题,那……二作Chenyang Yu就这些问题作出了公开回应。本文是基于DBSCAN的无监督聚类方法,第一步是根据ResNet-50提取整个训练集的特征,如DukeMTMC-reID上16522x2048 (样本个数x向量维数) ,然后计算Jaccard距离,得到16522x16522的相似度矩阵。根据这个相似度矩阵,DBSCAN算法会给每一张图片分配伪标签。在这个过程中,使用图像名的排序与不排序并不会影响16522x16522相似度矩阵的计算,因为每张图片都会与整个训练集的图片计算相似性,因此生成的伪标签是一样的。另外,我们在做实验的时候也有不需要排序的改进版本,即二次聚类方法:第一次聚类就按照基线方法,根据ResNet-50提取整个训练集的特征16522x2048 (DukeMTMC-reID上),得到相似度矩阵进行DBSCAN聚类,得到伪标签。因为DBSCAN聚类会有-1标签,我们根据最近邻的方法,给每个-1标签分配其最近邻对应的伪标签,从而完成整个训练集的伪标签分配。一旦完成,那么我们就可以对每个伪标签的所有图片,构建图,进行消息传递,得到优化后的特征。第二次聚类,与之前的描述一样,我们再将这个优化后的特征与原始特征级联,得到16522x4096的特征。接着与基线方法一样计算16522x16522的相似度矩阵,根据这个相似度矩阵,DBSCAN算法会给每一张图片分配伪标签。并且其中一个审稿人明确「质疑」了图像名字包含ID信息并不是一类先验知识。针对审稿人的提问,作者在rebuttal中表示如果只用聚类算法而不用GCL是不会带来性能提升的。并且为了让方法更可信,换了一种聚类方法,mAP指标立刻掉了1.2%。就职于大连理工大学人工智能学院、信息与通信工程学院的副教授张平平,也是这篇论文的通讯作者也做出了实名回应。- 论文投稿和rebuttal经过学生已在(https://www.zhihu.com/question/504163027/answer/2261562294)中回复,arXiv论文是投稿版本,并未包含rebuttal补充的修改与实验;

- 正在全面的做random shuffle setting的实验,将在第一时间(不晚于12月18日)做好实验说明和分析再来更新答复;

- 完成相关试验后,在camera-ready截止日期前根据新的结论和rebuttal阶段的讨论内容跟AAAI主席沟通是否撤稿。

有人认为这审稿人肯定是严重失职了,但凡专业一点,看见这么高的performance,不仔细看下方法实现?但从评审结果来看,5个审稿人员中有两个人都给了negative,所以大概率这个锅得meta reviewer来背。还有人表示「作者心真大,不怕举报,也不在乎学术前程」。也有网友的观点认为这就是变相造假!没有补充实验的话最好还是撤稿,让大家体面地结束。文章的第一作者贾某目前还未就此事公开回复,想必此刻他也是面临巨大的心理压力,也许最终的实验结果还能挽救一下这篇濒临撤稿的论文。这篇论文最大的遗憾与惊喜都来自于第一作者,他刚刚进入大三阶段的学习,没有经过多年的学术锻炼就中了一篇多少人梦寐以求、求而不得的顶会论文。年少有为,也意味着没有太多经验,一篇论文下隐藏着巨大的风险。随着越来越多的本科生进入科研领域,科学这个神圣的领域也进入寻常百姓家,写出的论文质量也是良莠不齐。这个知乎问题下可以看到无数优秀本科生的科研经历,但并不是所有本科生的成果都对科学这座大厦产生着正面影响。如何对论文严格把关,也是科学研究发展到下一阶段需要着重思考的问题。

参考资料:

https://www.zhihu.com/question/504163027https://baike.baidu.com/item/行人重识别/20815009本文部分引用「罗浩.ZJU」、「水母沙拉」和匿名回答https://zhuanlan.zhihu.com/p/31921944https://www.zhihu.com/question/504163027/answer/2261199211https://www.zhihu.com/question/504163027/answer/2261562294https://www.zhihu.com/question/504163027/answer/2261562294

猜您喜欢:

超110篇!CVPR 2021最全GAN论文汇总梳理!

超100篇!CVPR 2020最全GAN论文梳理汇总!

拆解组新的GAN:解耦表征MixNMatch

StarGAN第2版:多域多样性图像生成

附下载 | 《可解释的机器学习》中文版

附下载 |《TensorFlow 2.0 深度学习算法实战》

附下载 |《计算机视觉中的数学方法》分享

《基于深度学习的表面缺陷检测方法综述》

《零样本图像分类综述: 十年进展》

《基于深度神经网络的少样本学习综述》