可能是最好的ReLU改进,微软推出提点神器Dynamic ReLU丨ECCV 2020

极市导读

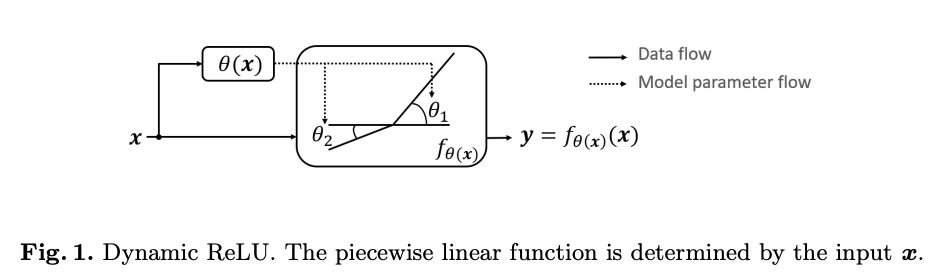

这篇论文提出了一种动态ReLU。根据输入,它能动态地调整对应的分段激活函数,以较少的额外计算量大幅提升性能。

Dynamic ReLU

论文地址:https://arxiv.org/abs/2003.10027

论文代码:https://github.com/Islanna/DynamicReLU

Introduction

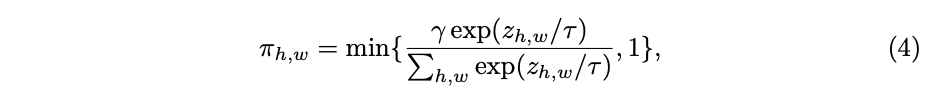

Definition and Implementation of Dynamic ReLU

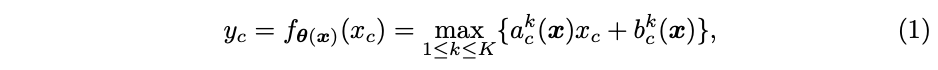

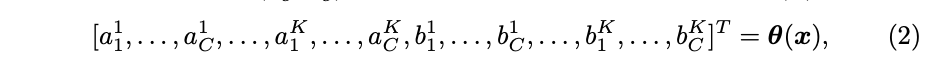

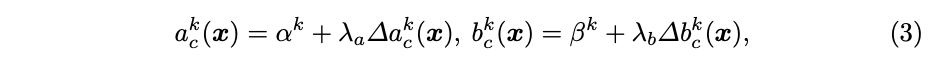

Definition

Implementation of hyper function

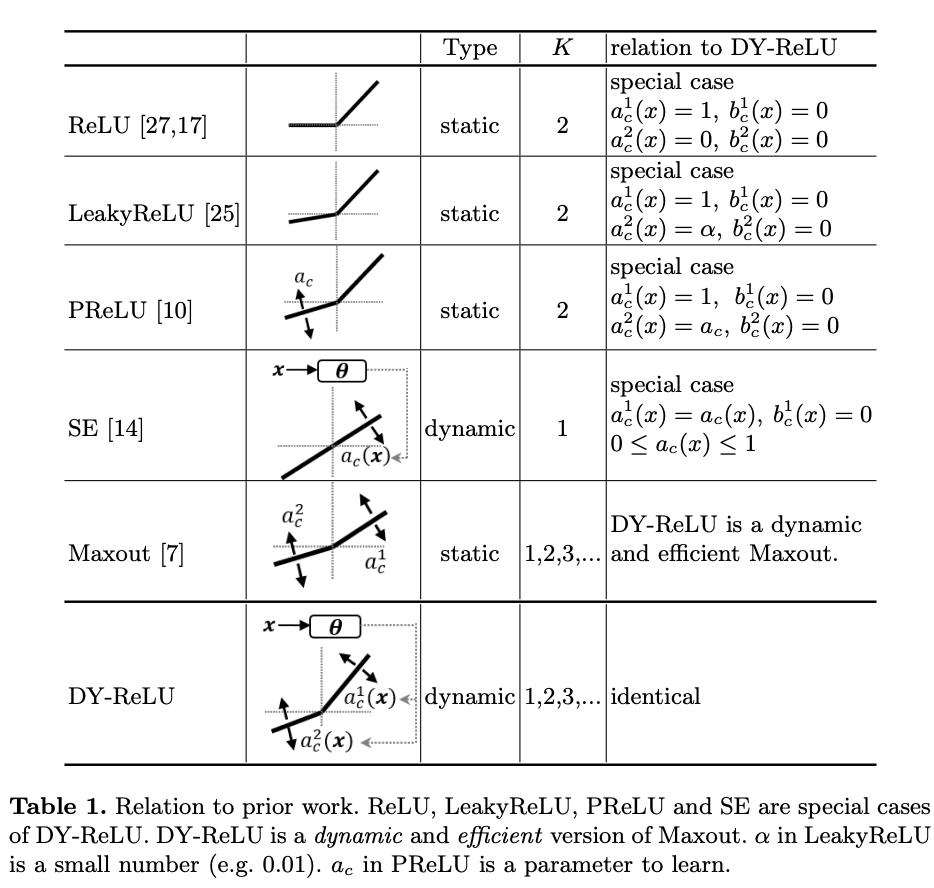

Relation to Prior Work

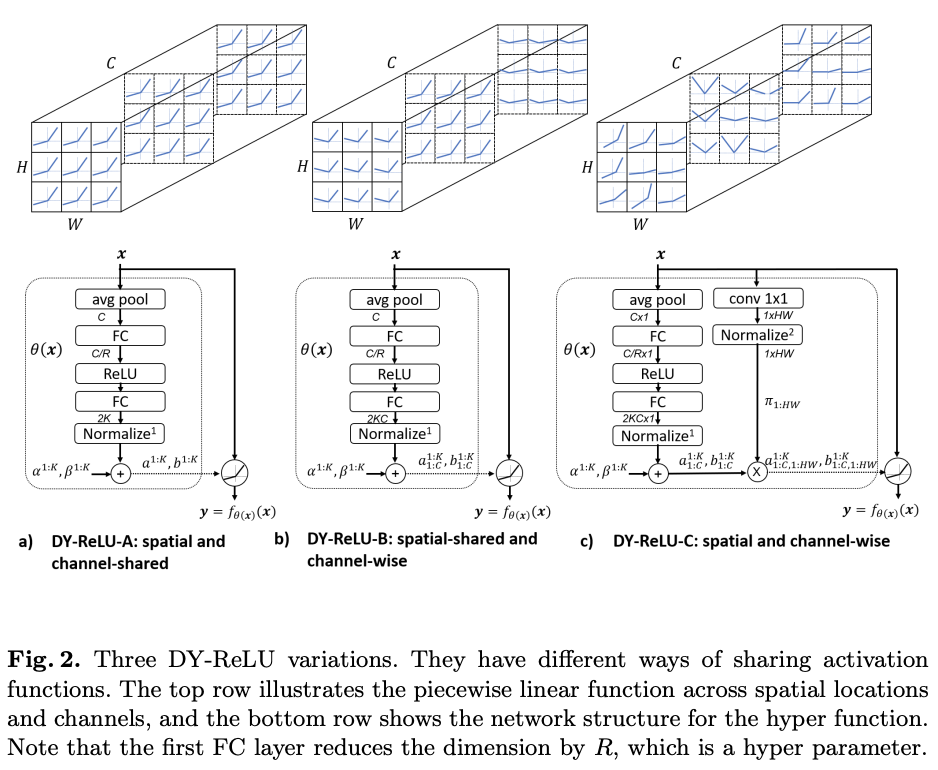

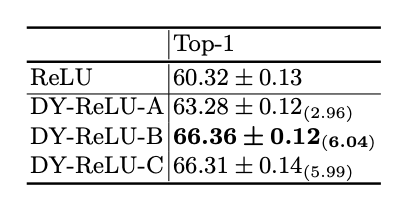

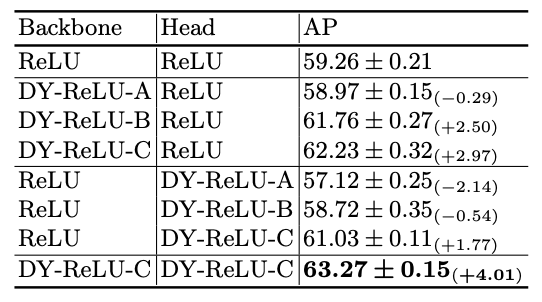

Variations of Dynamic ReLU

DY-ReLU-A

DY-ReLU-B

DY-ReLU-C

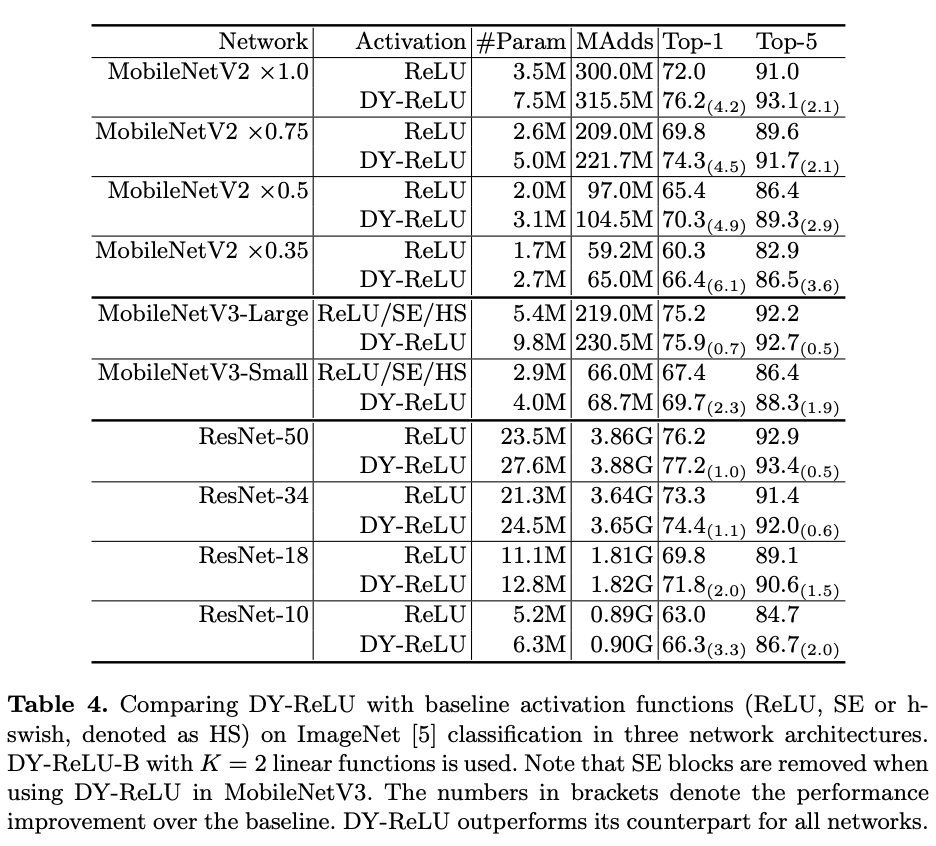

Experimental Results

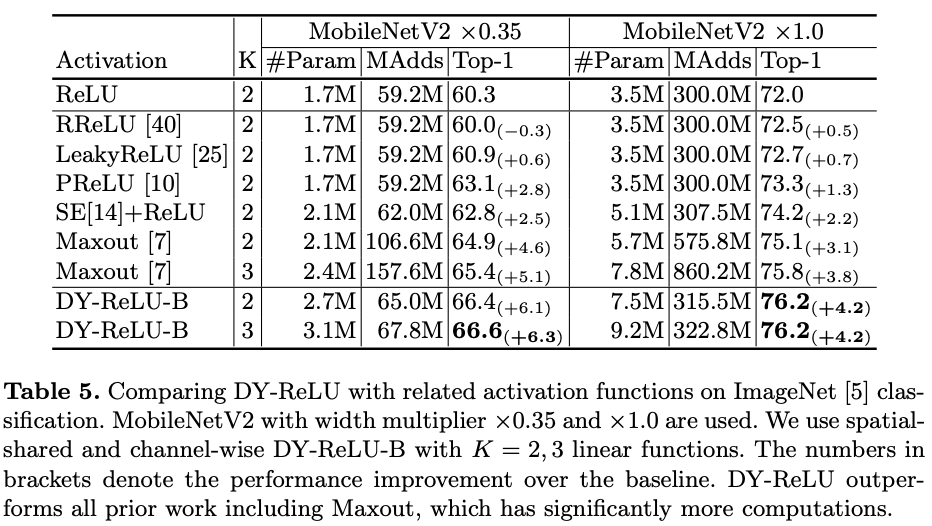

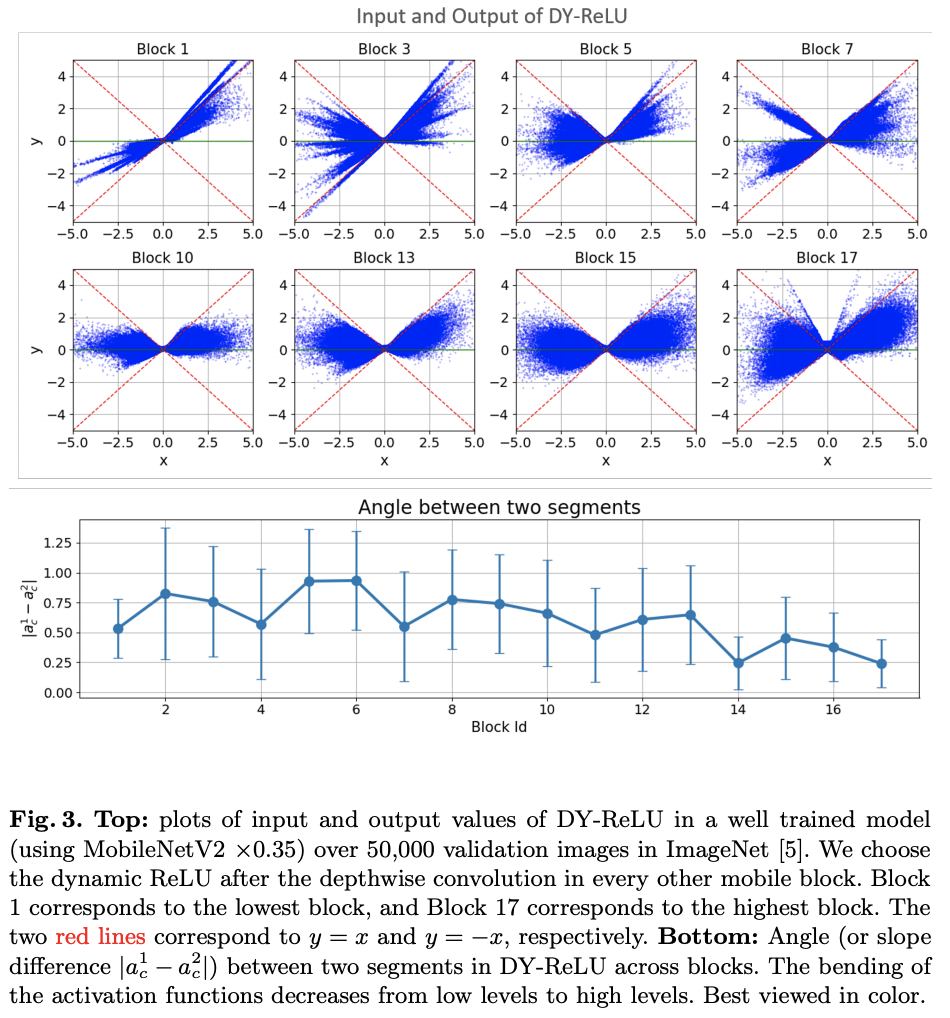

与其它激活函数进行实验对比

Conclusion

推荐阅读

评论