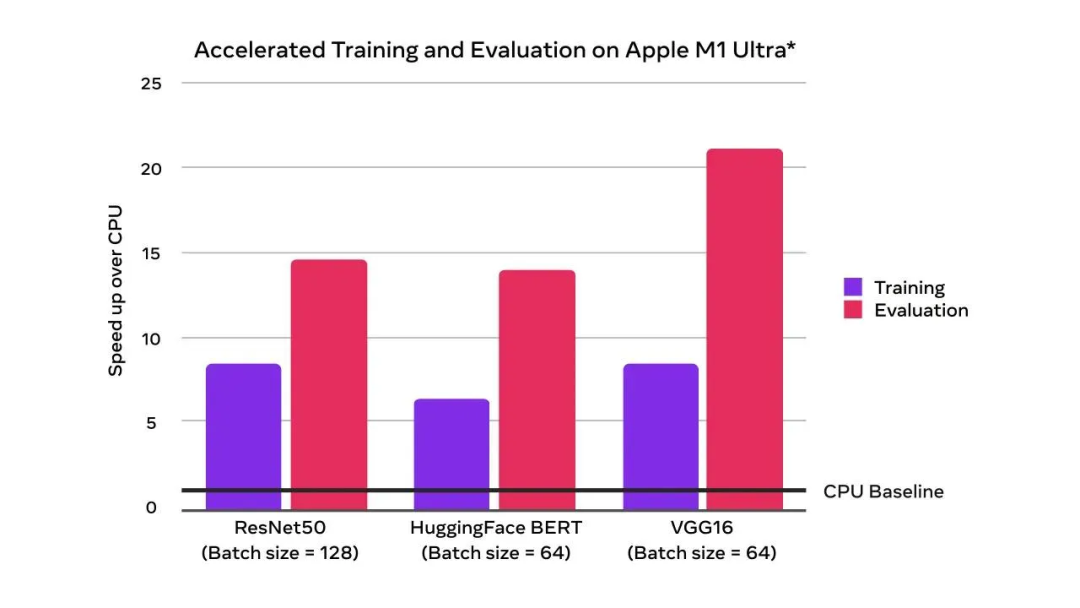

PyTorch 1.12发布,正式支持苹果M1芯片GPU加速,修复众多Bug

编辑:陈萍

PyTorch 1.12 正式发布,还没有更新的小伙伴可以更新了。

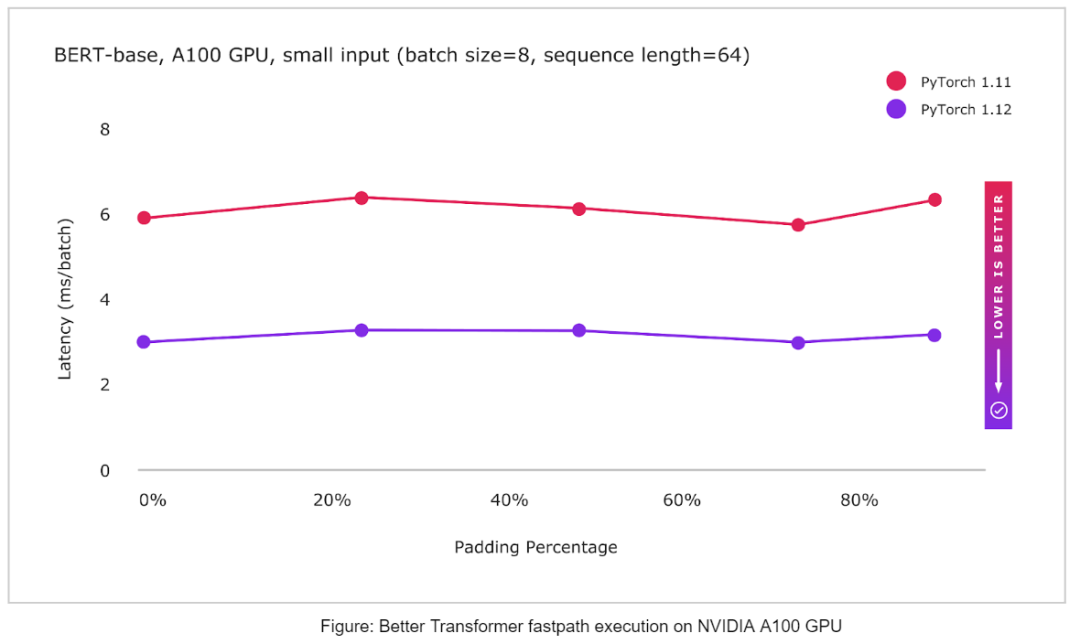

模块:模块计算的一个新 beta 特性是功能性 API。这个新的 functional_call() API 让用户可以完全控制模块计算中使用的参数; TorchData:DataPipe 改进了与 DataLoader 的兼容性。PyTorch 现在支持基于 AWSSDK 的 DataPipes。DataLoader2 已被引入作为管理 DataPipes 与其他 API 和后端之间交互的一种方式; nvFuser: nvFuser 是新的、更快的默认 fuser,用于编译到 CUDA 设备; 矩阵乘法精度:默认情况下,float32 数据类型上的矩阵乘法现在将在全精度模式下工作,这种模式速度较慢,但会产生更一致的结果; Bfloat16:为不太精确的数据类型提供了更快的计算时间,因此在 1.12 中对 Bfloat16 数据类型进行了新的改进; FSDP API:作为原型在 1.11 版中发布,FSDP API 在 1.12 版的发布中达到了测试版,并添加了一些改进。

——The End——

分享

收藏

点赞

在看

评论