TIOBE 更新了 2021 年 10 月份编程语言指数排行榜。

榜单中共对 100 种编程语言进行了评级排名,其中 Python 成为 “20 多年来的新语言霸主”,以 11.27% 的评级排名第 1 位;

C 和 Java 的“长期霸权已经结束”,分别以 11.16% 和 10.46% 的评级位列榜单第 2 和第 3 位。

Python稳坐前三的宝座,只因当下时代,大数据盛行。每一个成功的商业运营都会遇到它。

1、什么是爬虫?

网络爬虫也叫网络蜘蛛,如果把互联网比喻成一个蜘蛛网,那么爬虫就是在网上爬来爬去的蜘蛛,爬虫程序通过请求url地址,根据响应的内容进行解析采集数据。比如:如果响应内容是html,分析dom结构,进行dom解析、或者正则匹配,如果响应内容是xml/json数据,就可以转数据对象,然后对数据进行解析。

通过有效的爬虫手段批量采集数据,可以降低人工成本,提高有效数据量,给予运营/销售的数据支撑,加快产品发展。

目前互联网产品竞争激烈,业界大部分都会使用爬虫技术对竞品产品的数据进行挖掘、采集、大数据分析,这是必备手段,并且很多公司都设立了爬虫工程师的岗位。

用爬虫最大的好处是批量且自动化得获取和处理信息。用实际生活应用举例更加直观:

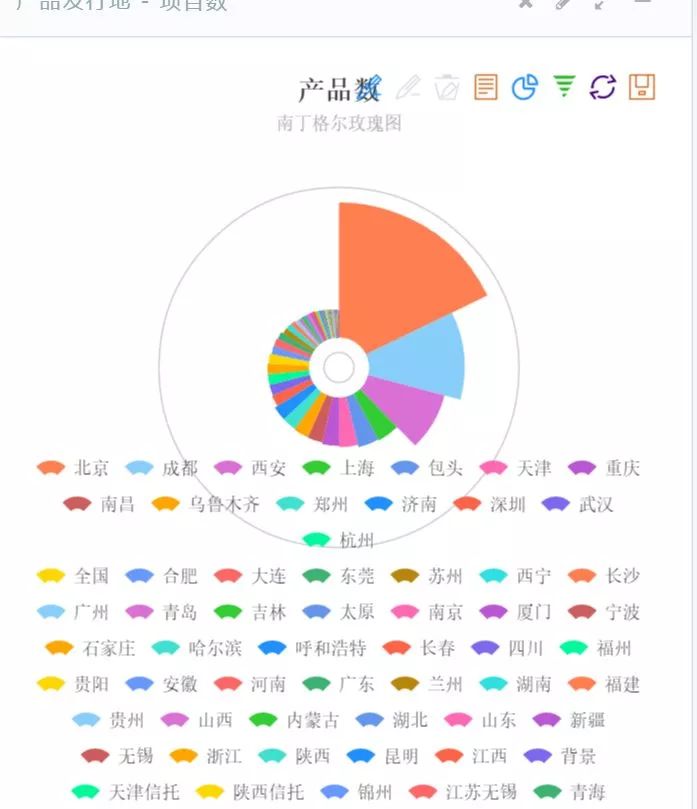

1、获得各个机场的实时流量

2、获得热点城市的火车票情况

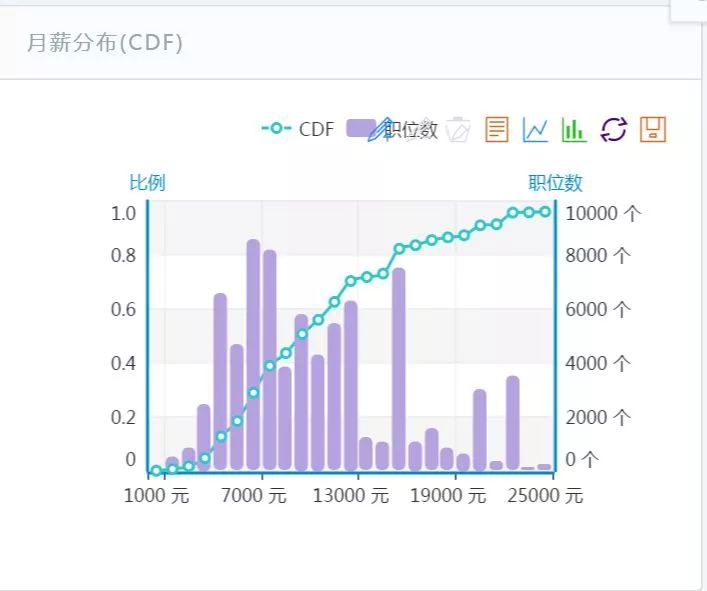

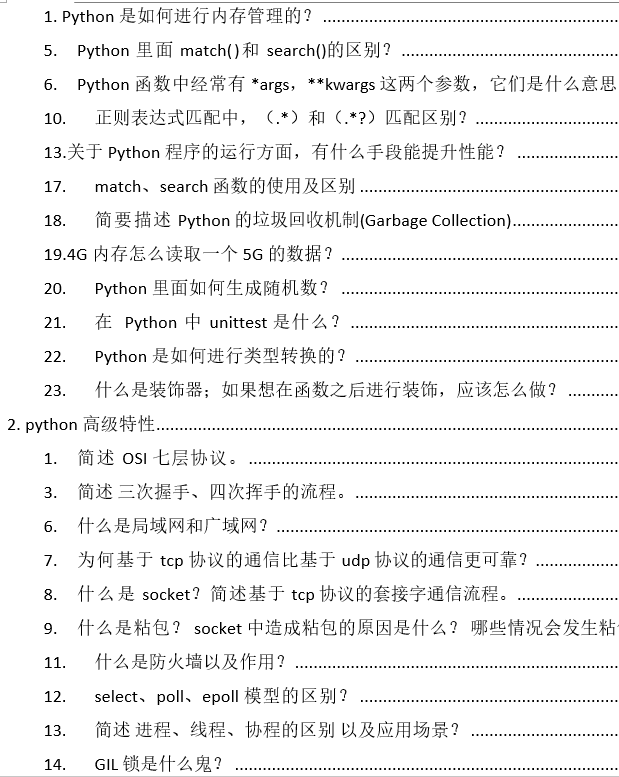

3、各种热门公司招聘中的职位数及月薪分布

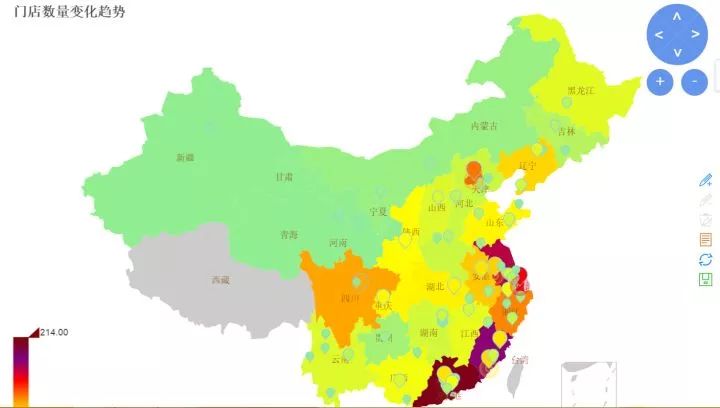

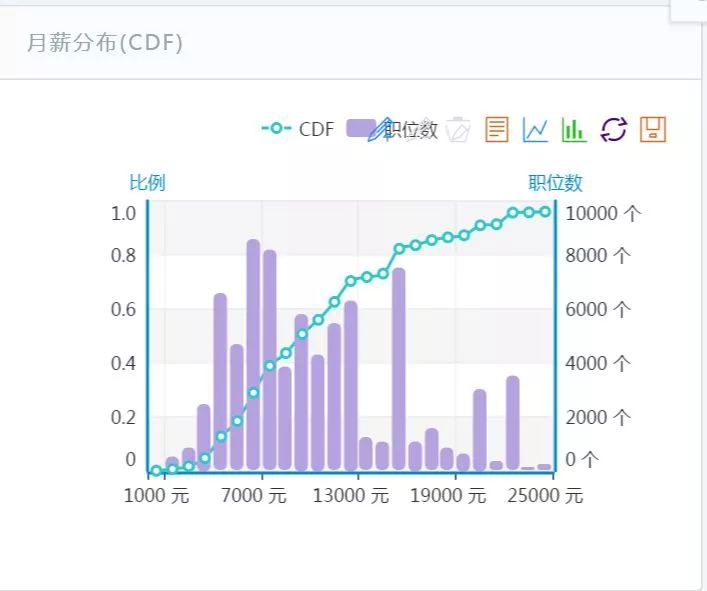

4、某公司的门店变化情况

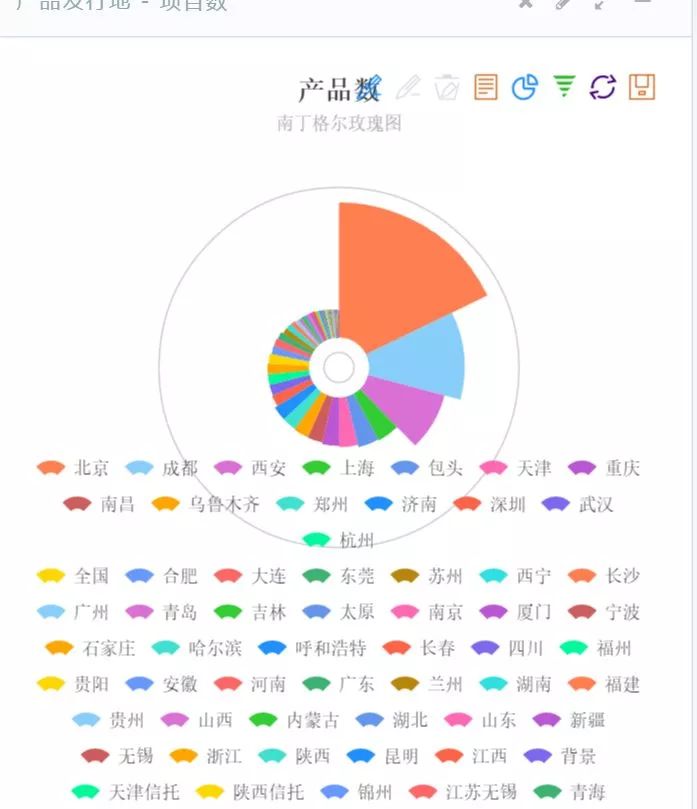

5、对某一类金融产品的检测和跟踪

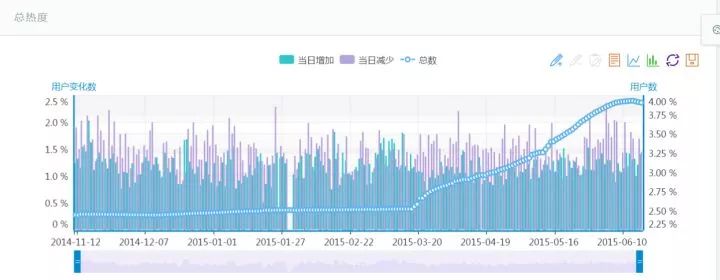

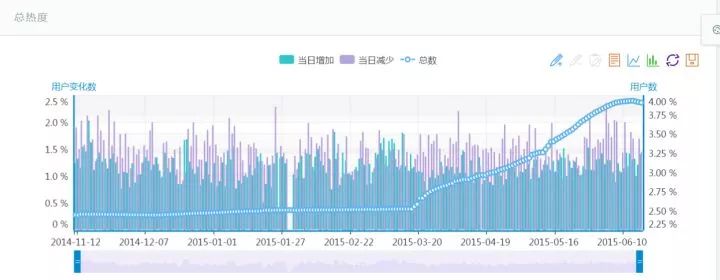

6、对某车型用户数变化情况的跟踪

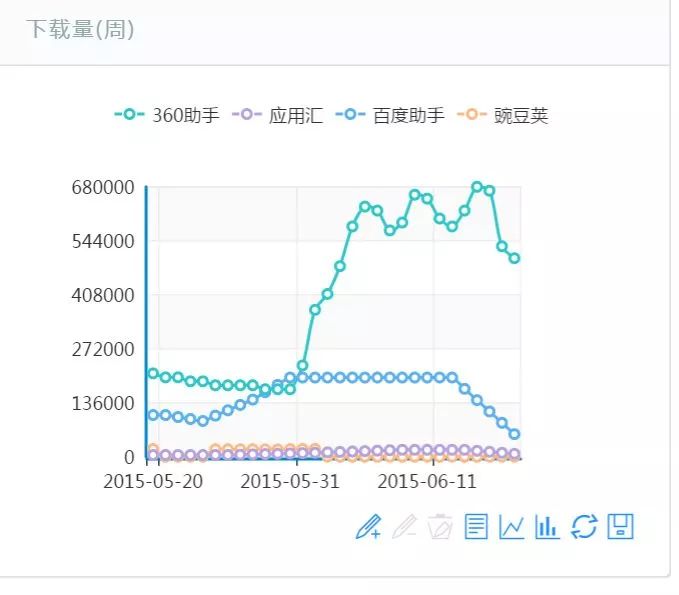

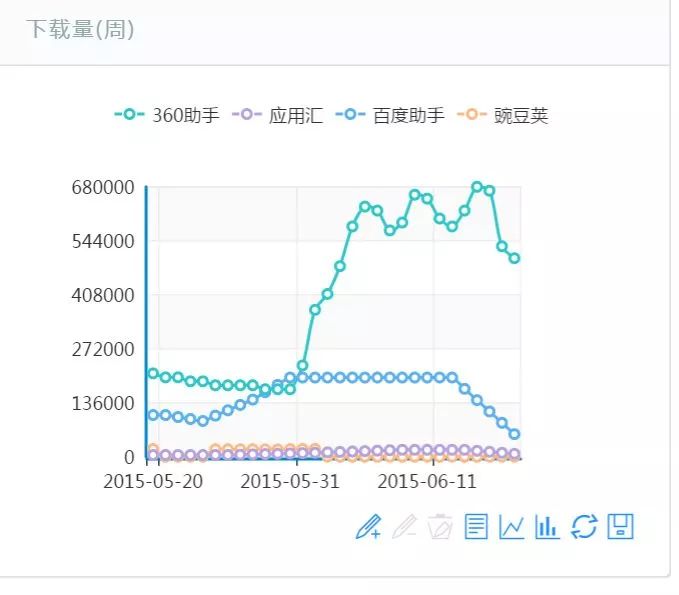

7、对某个App的下载量跟踪

爬虫技术好学吗?一个视频告诉你!

《13天搞定Python分布爬虫》视频教程,将爬虫技术学习分为13天,逐步带你入门,轻松上手,初学者也能学。

第一天

01-爬虫介绍

02-爬虫软件的安装

03-第一个爬虫

04-Request对象的使用

05-get请求的使用

06-贴吧案例

07-post请求的使用

第二天

08-ajax请求的抓取

09-https请求的使用

10-proxy的使用

11-cookie的使用1

12-cookie的使用2

13-URLError的使用

14-requests的使用

第三天

15-re的使用

16-糗事百科案例

17-BeautifulSoup的使用

18-xpath的使用

19-pyquery的使用

20-jsonpath的使用

第四天

21-多线程的使用

22-tesseract的使用

23-云打码平台的使用

24-云打码登录

25-爬取图文并茂文章方法

26-selenium的使用

第五天

27-阶段测试需求说明

28-猫眼测试xpath的写法

29-猫眼测试bs4的写法

30-猫眼测试re的写法

31-猫眼测试pyquery的写法

32-ChromeDriver开启无头模式

33-爬虫复习

第六天

34-虎牙直播练习

35-selenium滚动条的使用

36-图虫图片练习

37-双色球练习数据下载

38-双色球练习保存数据库

39-双色球练习数据更新

40-爬虫新写法1

41-爬虫新写法2

第七天

42-爬虫的基本介绍

43-爬虫的基本使用

44-爬虫的数据提取

45-scrapy中pipeline中的使用

46-scrapy中settings的设置

47-scrapy中细节问题

48-scrapy爬取小说

49-scrapy中crawlspider的使用

第八天

50-scrapy中ImagePipeline的使用

51-scrapy中动态UA的使用

52-scrapy中动态代理的使用

53-scrapy登录方式1

第九天

55-Mongo的使用

56-Mongo的数据库实例与集合的操作

57-Mongo的数据基本操作(CRUD)

58-Mongo的数据查询

60-Scrapy中保存到数据库

第十天

62-Splash的安装

61-Scrapy中调试的使用

63-Splash如何打开服务

64-阶段测试

65-scrapy内容补充

第十一天

66-splash与requests结合

67-splash与scrapy的结合

68-selenium与scrapy的结合

69-某家内容爬取-数据解析

70-某家内容爬取-数据保存

第十二天

71-scrapy-redis的介绍

72-linux的安装

73-linux软件安装与克隆

74-scrapy-redis的windows环境安装

75-scrapy_redis的写法1

76-scrapy_redis的写法

77-scrapy_redis的写法2

78-从redis中取出数据到Mongo数据库

第十三天

0.1-Flask介绍与安装

0.2-Flask的路由设置与参数接收

0.3-Flask的响应.mp4

0.4-Flask与Echarts的结合使用

番外1-51job需求与页面分析

番外2-51job页面解析1

番外3-51job页面解析2

番外4-51job保存到数据库

需要以上资料的朋友请添加助理的微信免费领取

加微信请备注【777】

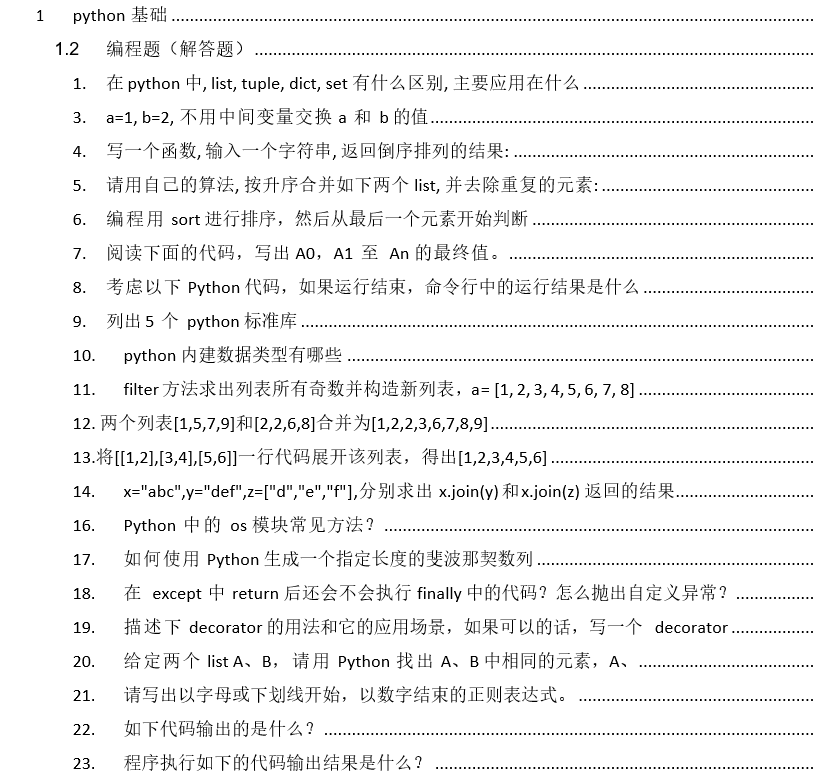

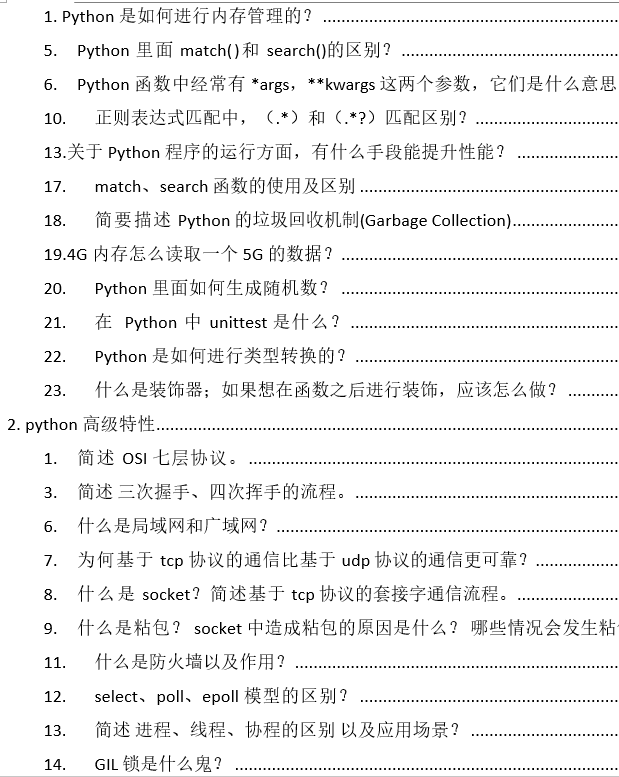

在这里,小编为大家准备了一份面试资料给大家!希望能祝各位一臂之力!文件列表小编放在下方了,请各位有需要的同学扫描下方二维码自行下载!

篇幅有限,展示部分。

需要以上资料的朋友请添加助理的微信免费领取

前100名免费领取

加微信请备注【777】