10倍提效,每天100篇,如何使用AI提取arXiv论文知识?

arXiv

arXiv是国际上最有影响力的论文预发平台,在arXiv发表论文,已经成为科研圈的“潜规则”。arXiv创建于1991年,论文主要是理工科论文,包括数学、物理、计算机、统计、金融等领域。

目前收录论文数量已达200万篇。研究人员每个月会向arXiv提交约8000篇论文,平均每天提交250余篇。

arXiv每天更新量级已经不是普通人可以追更的体量了。

提到大量的信息,肯定有读者会想到用LLM来处理论文。

假设每天我们需要处理100篇英文论文,那需要消耗多少Token呢?需要消耗5百万Token,费用大约在1.25 ~ 600美元(不同模型价格不一样)。

100篇论文需要消耗1.25 ~ 600美元。

有没有更为经济(省钱)的方式?

使用本地的LLM,进行批量化处理,可以节省Token开支。

MixCopilot 提供了本地化解决方案,下载lm studio和通义千问-7B(Qwen-7B)模型,启动本地LLM服务,在MixCopilot接入后使用。

参考教程:

论文解读

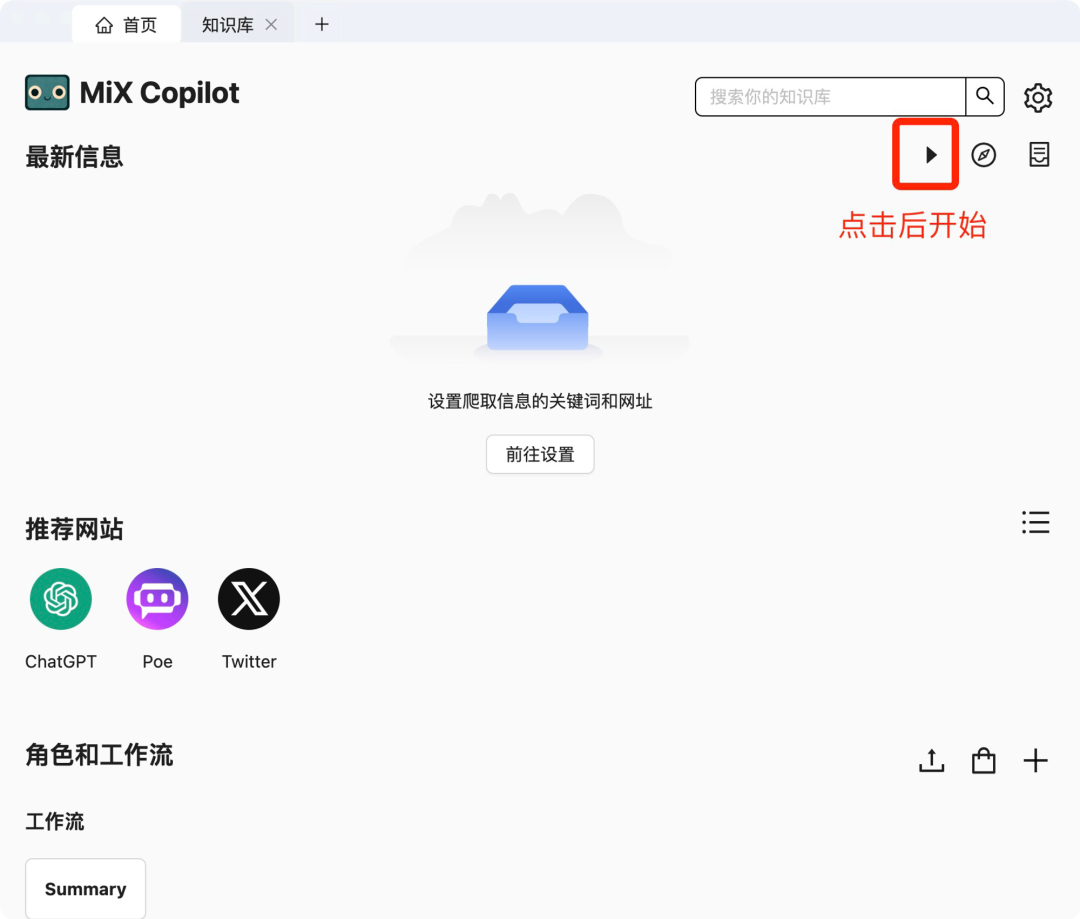

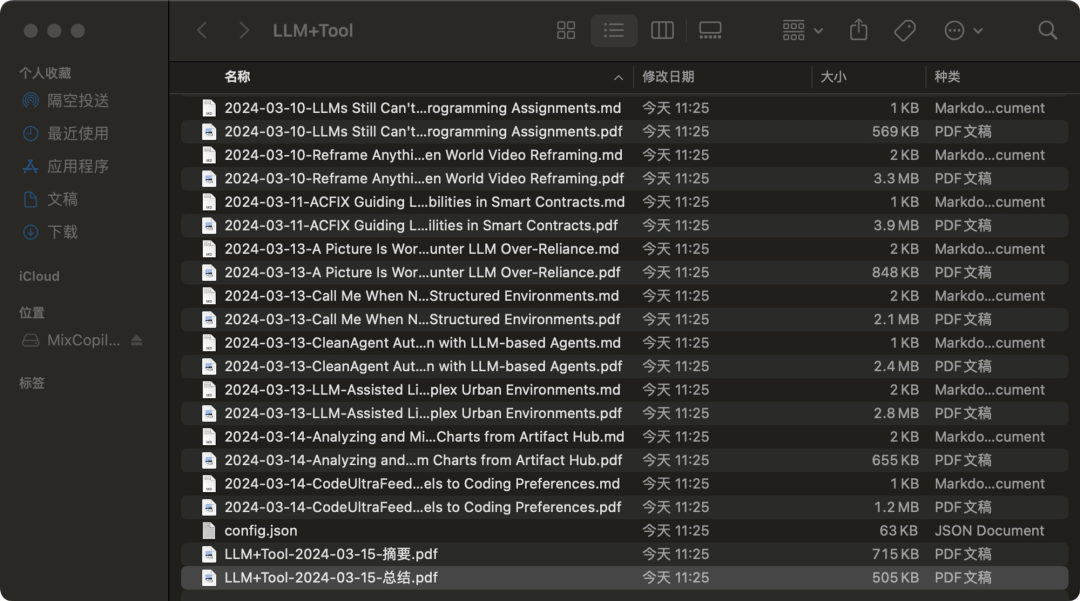

使用MixCopilot最新功能,配置Arxiv论文、一键启动、使用本地LLM加工处理。

处理效率:128篇16分钟完成。

论文的知识加工

除了使用本地LLM来加工处理论文,还可以把pdf论文转为html。

为什么要转为html?

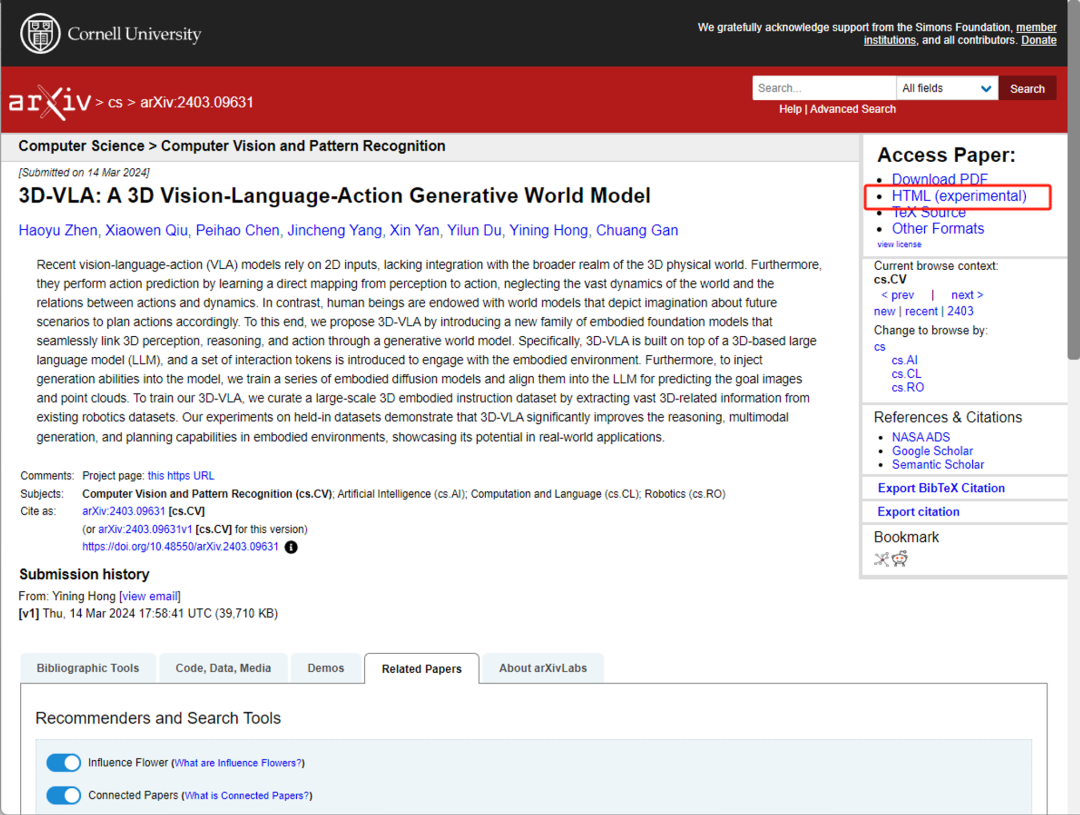

由于arXiv上的论文都是pdf格式,对视障人士的阅读产生不便。在去年12月,arXiv开始提供HTML格式的论文版本,HTML 格式的论文可以通过屏幕阅读器和其他技术更轻松、更准确地阅读,这可以帮助有阅读障碍(包括失明、视力低下等)的研究人员。

有了html版本,我们就可以轻松地使用LLM来进行信息处理。

把论文的url在MixCopilot打开,右键调用chatbot,支持2种格式,pdf和html 。

( html有个好处就是可以直接拷贝图片 )

加工论文,转为markdown格式,生产内容,编辑后导出为pdf。

论文的可信度

由于arXiv平台并没有纠正科学性错误的义务。这意味着,我们在阅读arXiv论文时,需要有足够的甄别能力,对一些存在明显科学性错误的论文应该能够鉴别。

我们可以从哪些方面得到论文的可信度?

作者、著名期刊收录、搜索引擎

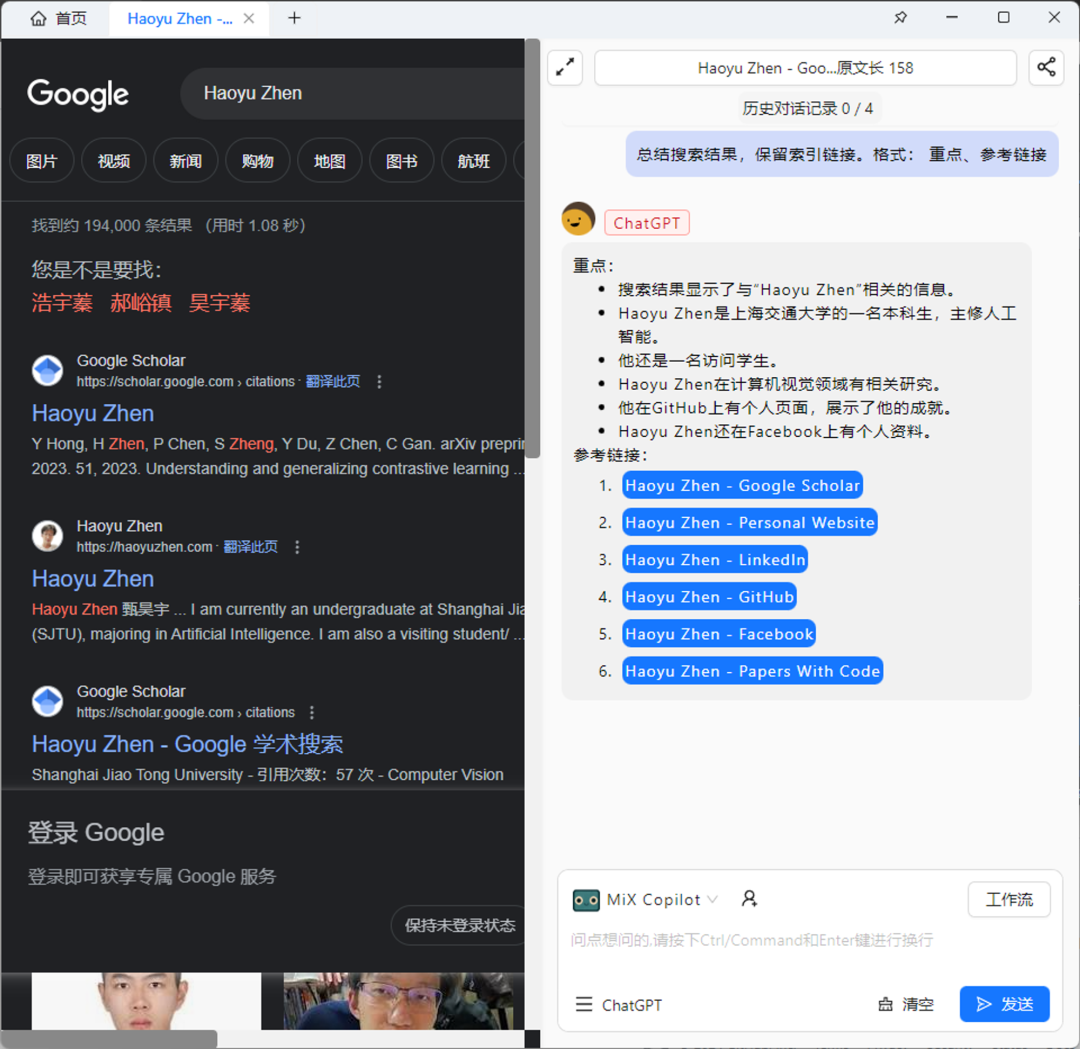

在知识库,可以点击作者直接调用搜索引擎,方便甄别信息。

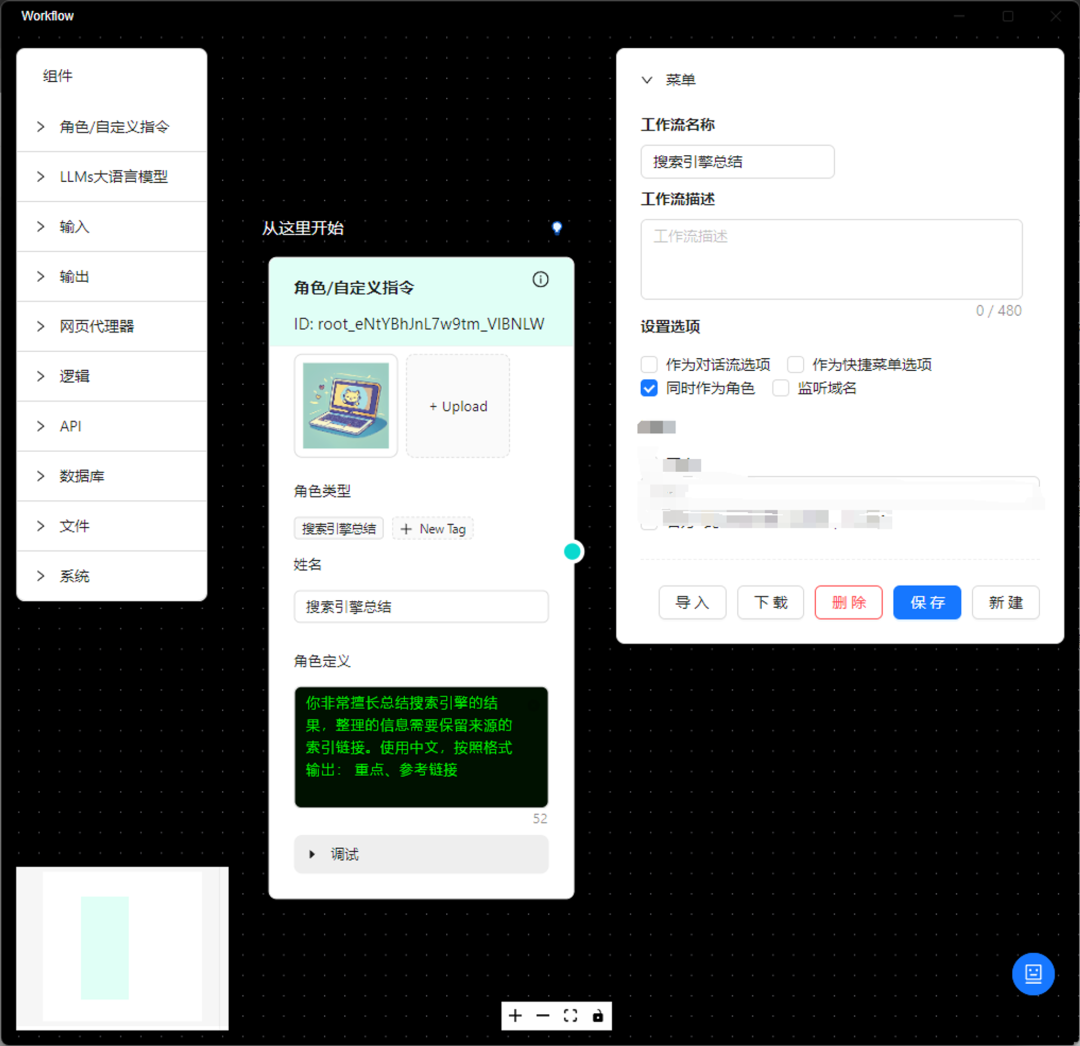

通过chatbot总结搜索引擎的结果。我们还可以把这个prompt,制作成一个角色。

通过编辑器制作角色-搜索引擎助手,完成信息汇总,保留索引的角色设定,直接在chatbot种通过角色即可一键调用。

最佳实践

作为研究人员,你可以使用此方法制作技术趋势报告。

如果你是知识博主,你可以提供更为系统的论文解读给你的读者们。

如果你正在学习,你可以通过MixCopilot的帮助,高效率地完成最新论文的追踪和阅读。

入群备注:MC