鄂维南院士:机器学习数学本质的理解

作者:鄂维南院士,来源:科学智能AISI

机器学习问题的数学本质

众所周知,机器学习的发展,已经彻底改变了人们对人工智能的认识。机器学习有很多令人叹为观止的成就,例如:

· 比人类更准确地识别图片:利用一组有标记的图片,机器学习算法可以准确地识别图片的类别:

Cifar-10 问题:把图片分成十个类别

来源:https://www.cs.toronto.edu/~kriz/cifar.html

· Alphago下围棋打败人类:完全由机器学习实现下围棋的算法:

参考:https://www.bbc.com/news/technology-35761246

· 产生人脸图片,达到以假乱真的效果:

参考:https://arxiv.org/pdf/1710.10196v3.pdf

机器学习还有很多其他的应用。在日常生活中,人们甚至常常使用了机器学习所提供的服务而不自知,例如:我们的邮件系统里的垃圾邮件过滤、我们的车和手机里的语音识别、我们手机里的指纹解锁……

所有这些了不起的成就,本质上,却是成功求解了一些经典的数学问题。

❖

对于图像分类问题,我们感兴趣的其实是函数![]() :

:

![]() : 图像→类别

: 图像→类别

函数![]() 把图像映射到该图像所属的类别。我们知道

把图像映射到该图像所属的类别。我们知道![]() 在训练集上的取值,想由此找到对函数

在训练集上的取值,想由此找到对函数![]() 的一个足够好的逼近。

的一个足够好的逼近。

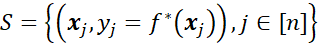

一般而言,监督学习(supervised learning)问题,本质都是想基于一个有限的训练集S,给出目标函数的一个高效逼近。

❖

对于人脸生成问题,其本质是逼近并采样一个未知的概率分布。在这一问题中,“人脸”是随机变量,而我们不知道它的概率分布。然而,我们有“人脸”的样本:数量巨大的人脸照片。我们便利用这些样本,近似得到“人脸”的概率分布,并由此产生新的样本(即生成人脸)。

一般而言,无监督学习本质就是利用有限样本,逼近并采样问题背后未知的概率分布。

❖

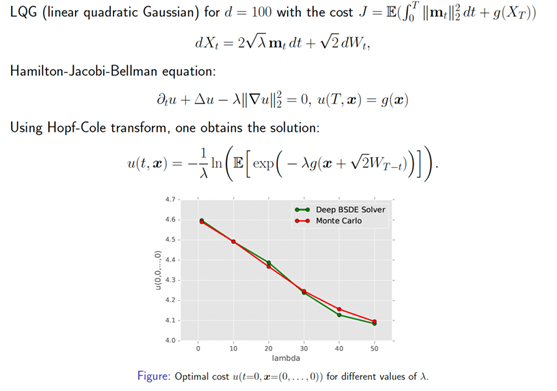

对于下围棋的Alphago来说,如果给定了对手的策略,围棋的动力学是一个动态规划问题的解。其最优策略满足Bellman方程。因而Alphago的本质便是求解Bellman方程。

一般而言,强化学习本质上就是求解马尔可夫过程的最优策略。

然而,这些问题都是计算数学领域的经典问题!!毕竟,函数逼近、概率分布的逼近与采样,以及微分方程和差分方程的数值求解,都是计算数学领域极其经典的问题。那么,这些问题在机器学习的语境下,到底和在经典的计算数学里有什么区别呢?答案便是:

例如,在图像识别问题中,输入的维度为![]() 。而对于经典的数值逼近方法,对于

。而对于经典的数值逼近方法,对于![]() 维问题,含

维问题,含![]() 个参数的模型的逼近误差

个参数的模型的逼近误差![]() . 换言之,如果想将误差缩小10倍,参数个数需要增加

. 换言之,如果想将误差缩小10倍,参数个数需要增加![]() . 当维数

. 当维数![]() 增加时,计算代价呈指数级增长。这种现象通常被称为:

增加时,计算代价呈指数级增长。这种现象通常被称为:

维度灾难(curse of dimensionality)

所有的经典算法,例如多项式逼近、小波逼近,都饱受维度灾难之害。很明显,机器学习的成功告诉我们,在高维问题中,深度神经网络的表现比经典算法好很多。然而,这种“成功”是怎么做到的呢?为什么在高维问题中,其他方法都不行,但深度神经网络取得了前所未有的成功呢?

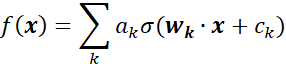

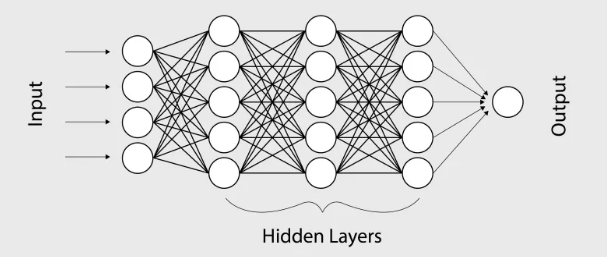

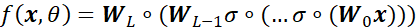

从数学出发,理解机器学习的“黑魔法”:监督学习的数学理论

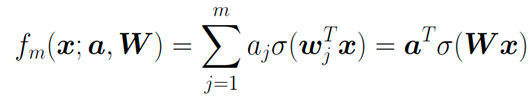

为了简便,我们在此省略掉所有的bias项![]() 。

。![]() 是权重矩阵,激活函数

是权重矩阵,激活函数![]() 作用在每一个分量上。

作用在每一个分量上。

我们将要在训练集S上逼近目标函数![]()

不妨假设![]() 的定义域为

的定义域为![]() 。令

。令![]() 为

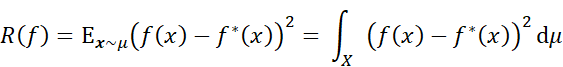

为![]() 的分布。那么我们的目标便是:最小化测试误差

的分布。那么我们的目标便是:最小化测试误差![]() (testing error,也称为population risk或generalization error):

(testing error,也称为population risk或generalization error):

2.2 监督学习的误差

监督学习一般有如下的步骤:

❖

第一步:选取一个假设空间(测试函数的一个集合)![]() (m正比于测试空间的维数);

(m正比于测试空间的维数);

❖

第二步:选取一个损失函数进行优化。通常,我们会选择经验误差(empirical risk)来拟合数据:

有时,我们还会加上其他的惩罚项。

❖

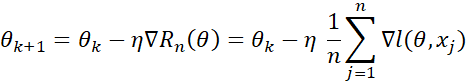

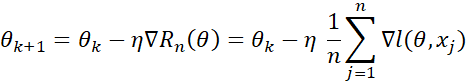

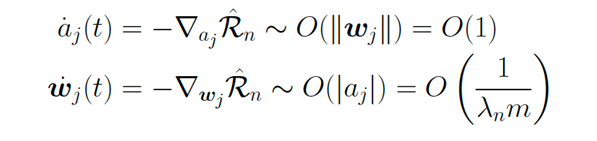

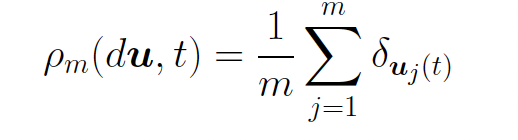

第三步:求解优化问题,如:

· 梯度下降:

· 随机梯度下降:

![]() 是从1,…n中随机选取的。

是从1,…n中随机选取的。

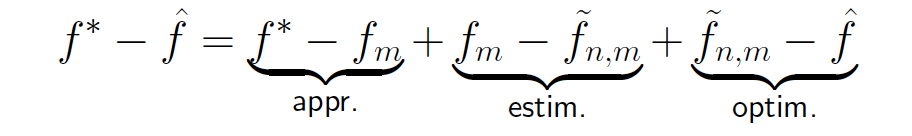

如果把机器学习输出的结果记![]() ,那么总误差便是

,那么总误差便是![]() 。我们再定义:

。我们再定义:

❖

![]() 是在假设空间里最好的逼近;

是在假设空间里最好的逼近;

❖

![]() 是在假设空间里,基于数据集S最好的逼近。

是在假设空间里,基于数据集S最好的逼近。

由此,我们便可以把误差分解成三部分:

❖

![]() 是逼近误差(approximation error):完全由假设空间的选取所决定;

是逼近误差(approximation error):完全由假设空间的选取所决定;

❖

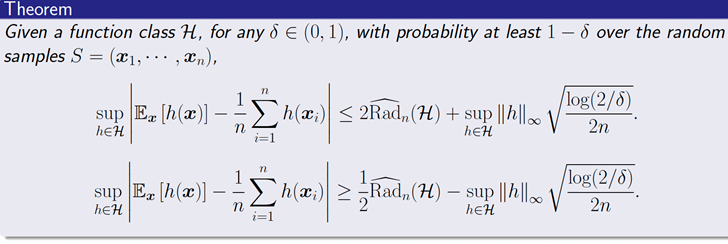

![]() 是估计误差(estimation error):由于数据集大小有限而带来的额外的误差;

是估计误差(estimation error):由于数据集大小有限而带来的额外的误差;

❖

![]() 是优化误差(optimization error):由训练(优化)带来的额外的误差。

是优化误差(optimization error):由训练(优化)带来的额外的误差。

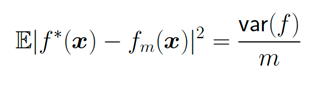

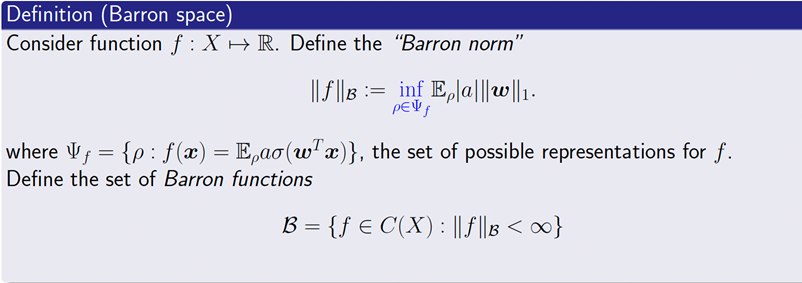

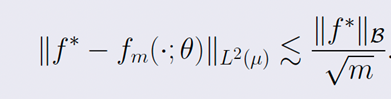

2.3 逼近误差

我们下面集中讨论逼近误差(approximation error)。

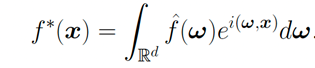

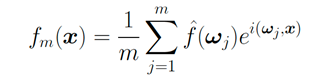

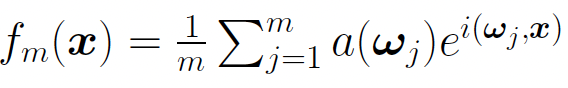

我们先用传统方法傅立叶变换做一个对比:

❖

梯度下降方法到底能不能快速收敛?

❖

训练得到的结果,是否有比较好的泛化性?

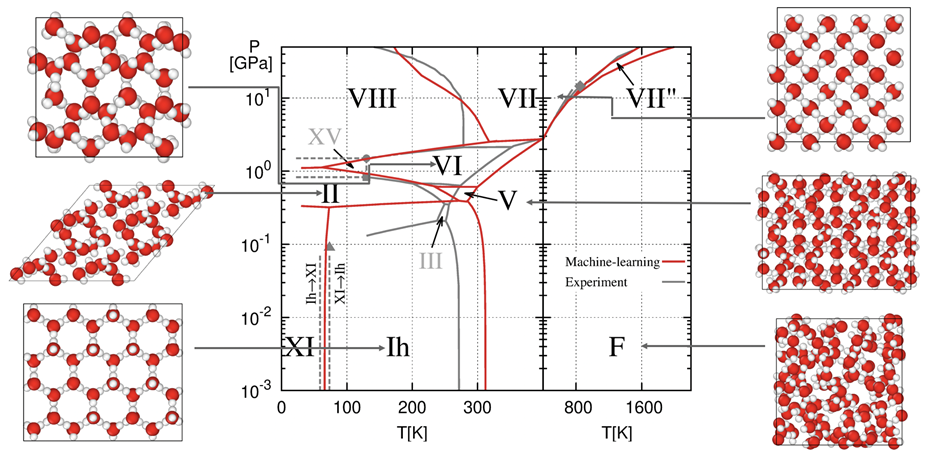

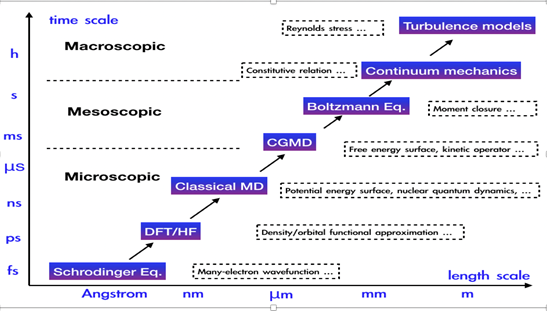

机器学习的应用

❖

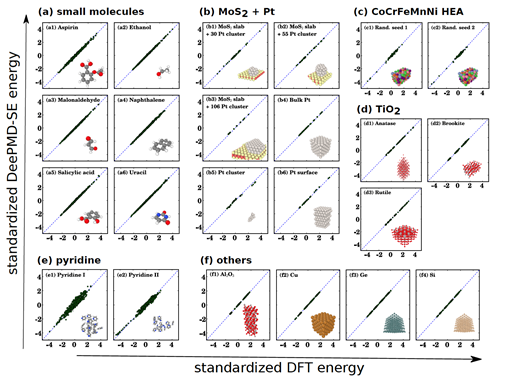

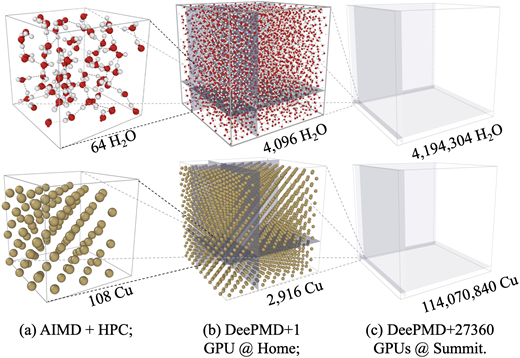

利用量子力学第一性原理计算提供数据;

❖

利用神经网络,给出势能面准确的拟合(参考:Behler and Parrinello (2007), Jiequn Han et al (2017), Linfeng Zhang et al (2018))。

❖

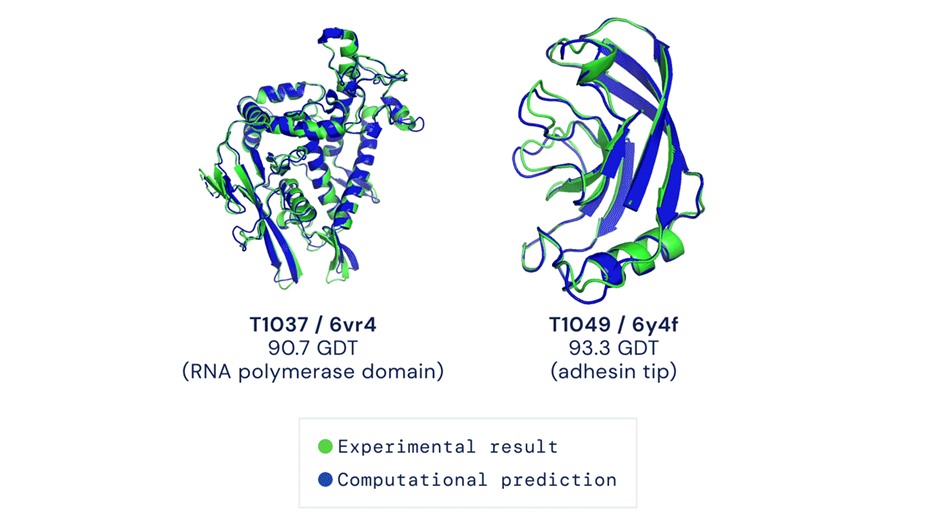

量子多体问题:RBM (2017), DeePWF (2018), FermiNet (2019),PauliNet (2019),…;

❖

密度泛函理论: DeePKS (2020), NeuralXC (2020), DM21 (2021), …;

❖

分子动力学: DeePMD (2018), DeePCG (2019), …;

❖

动理学方程: 机器学习矩封闭 (Han et al. 2019);

❖

连续介质动力学: ![]() (2020)

(2020)

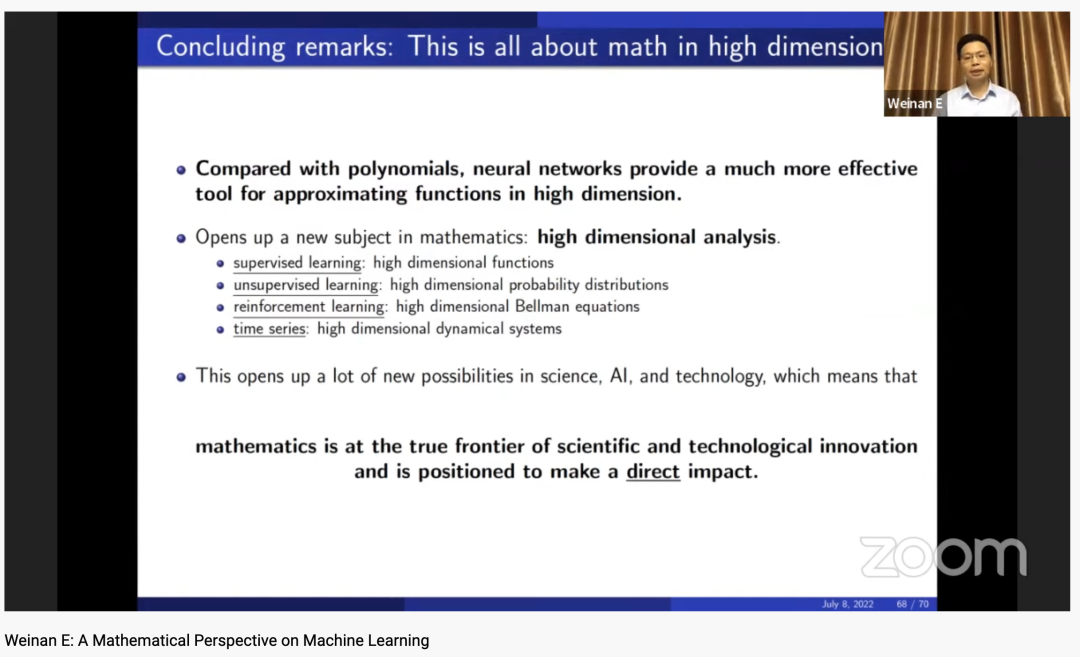

总结

❖

监督学习:高维函数理论;

❖

无监督学习:高维概率分布理论;

❖

强化学习:高维Bellman方程;

❖

时间序列学习:高维动力系统。

北京科学智能研究院(AI for Science Institute, 以下简称AISI)成立于2021年9月,由鄂维南院士领衔,致力于将人工智能技术与科学研究相结合,加速不同科学领域的发展和突破,推动科学研究范式的革新,建设引领世界的「AI for Science」基础设施体系。

AISI的研究人员来自国内外顶尖高校、科研机构和科技企业,共同聚焦物理建模、数值算法、人工智能、高性能计算等交叉领域的核心问题。

AISI致力于创造思想碰撞的学术环境,鼓励自由探索和跨界合作,共同探索人工智能与科学研究结合的新可能。

推荐阅读

整理不易,点赞三连↓