点蓝色字关注“机器学习算法工程师”

点蓝色字关注“机器学习算法工程师”

设为星标,干货直达!

据了解,这是首个关于 Transformers 的专题课程。

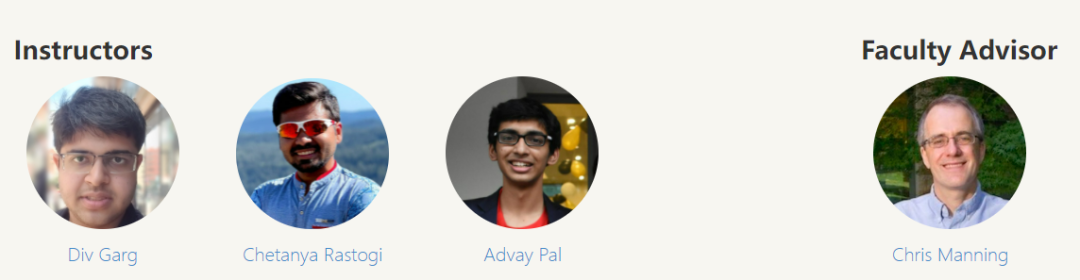

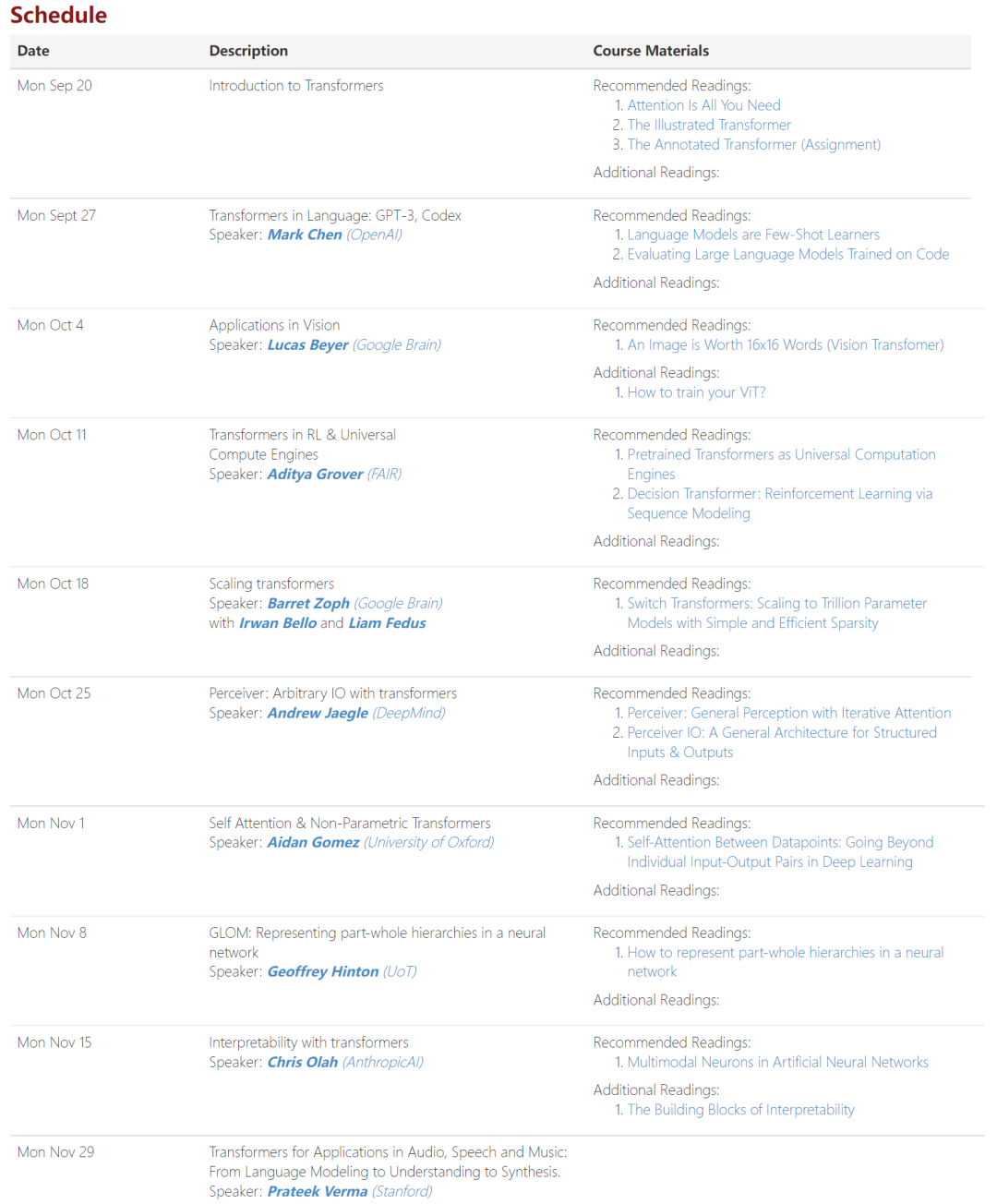

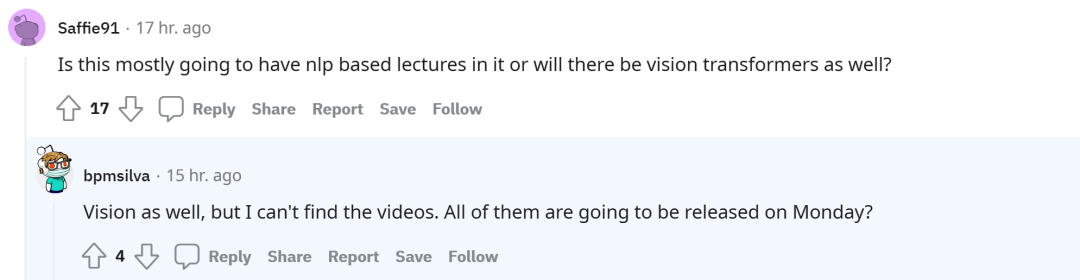

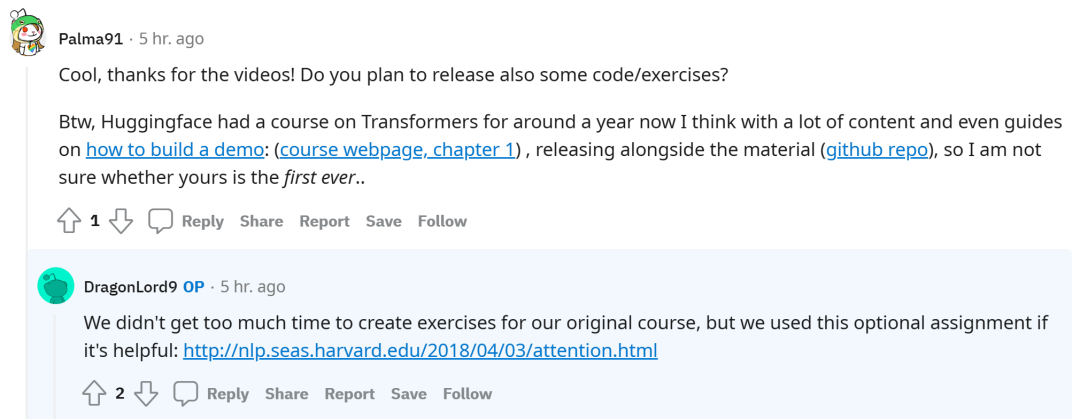

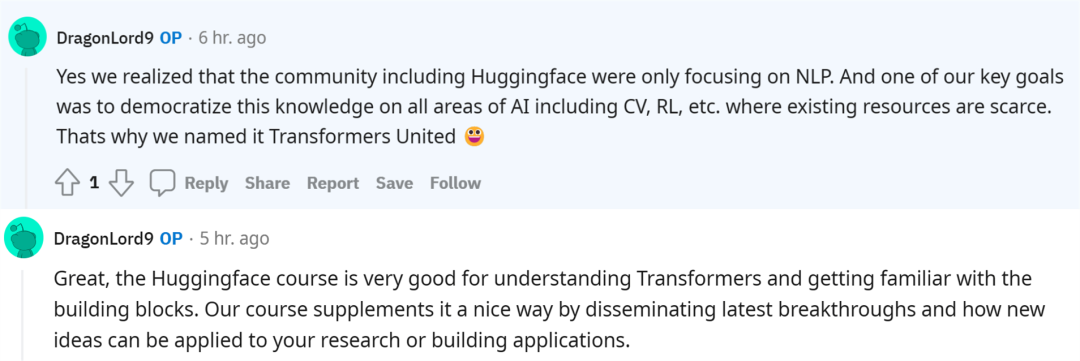

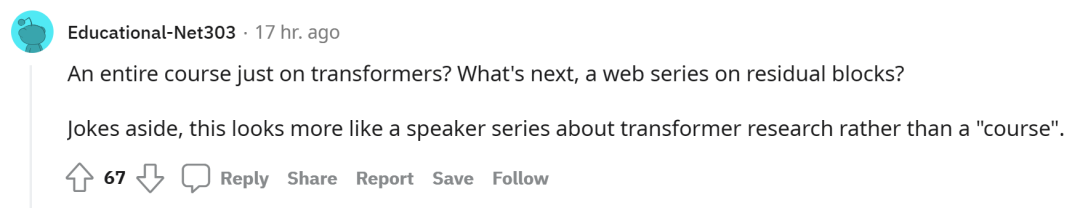

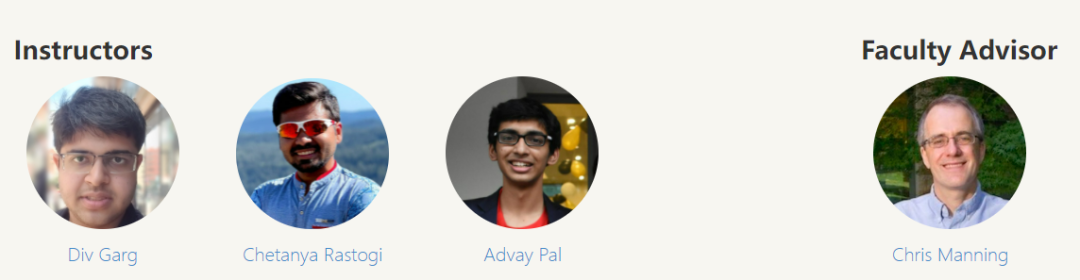

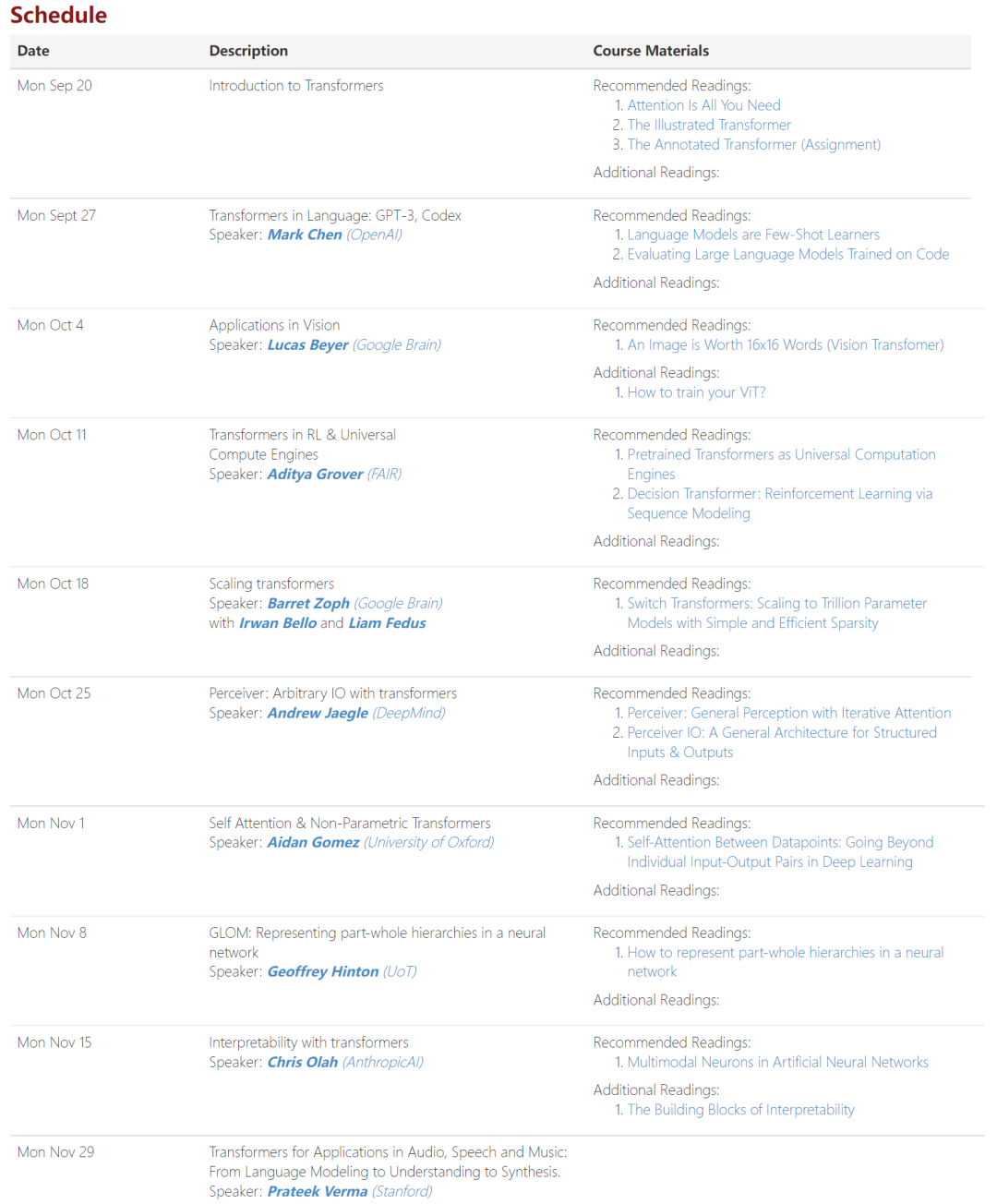

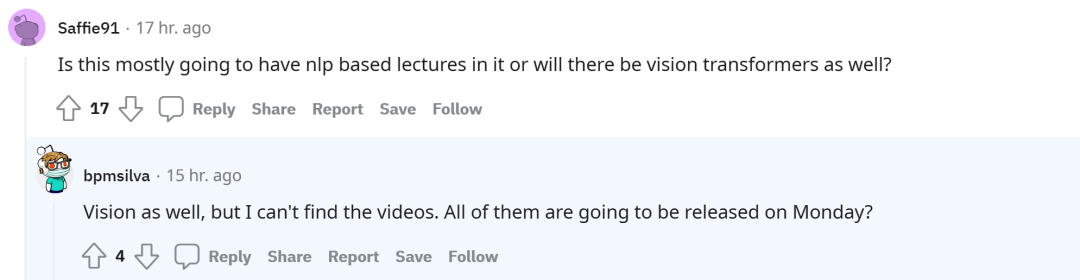

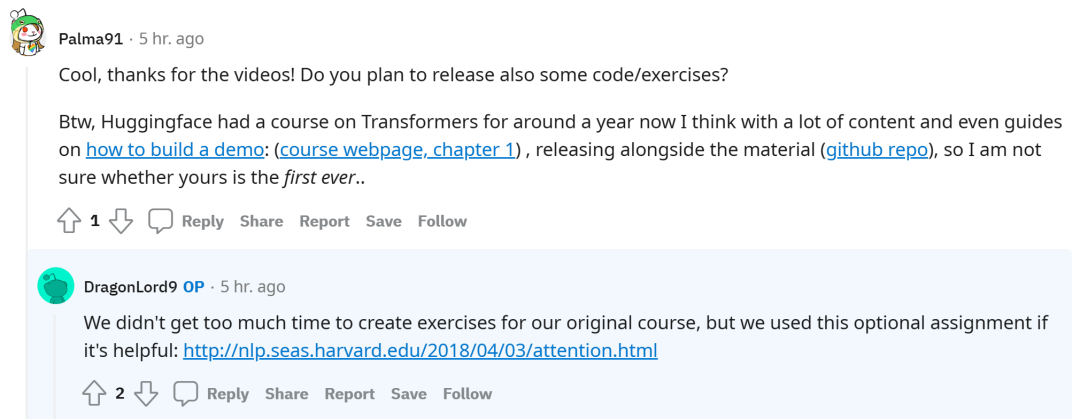

要说在世界大学公开课中哪些属于精品,斯坦福大学的 CS 课程可谓是榜上有名。这所世界名校先后免费公开了众多课程,有关于自然语言理解的、有关于机器学习的等等。斯坦福大学的 CS 课程可以说是覆盖范围广,今天他们又上线了一门经典课程:《CS 25: Transformers United》,据了解这是首个关于 Transformers 的课程。自 2017 年推出以来,Transformer 彻底改变了自然语言处理 (NLP)领域。现在,Transformer 在深度学习中被广泛使用,无论是计算机视觉 (CV)、强化学习 (RL)、生成对抗网络 (GAN)、语音甚至是生物学。除此之外,Transformer 还能够创建强大的语言模型(如 GPT-3),并在 AlphaFold2 中发挥了重要作用,该算法解决了蛋白质折叠问题。可能是意识到 Transformer 带来的一系列技术突破,又或者其他原因,总之斯坦福 CS 25 课程诞生了。这门课程的重点就是介绍 Transformers,并统一其在 ML、CV、NLP、生物学和其他社区的使用。此外,该课程还讨论关于 Transformer 的最新突破和想法,以激发交叉合作研究。不过,想要学习这门课程的小伙伴,必须先要掌握深度学习基础知识(必须理解注意力机制),或者已经通过 CS224N / CS231N / CS230 课程。从下周开始,CS 25 将每天公布课程内容,目前已放出第一个视频:介绍 Transformer。视频链接:https://www.youtube.com/playlist?list=PLoROMvodv4rNiJRchCzutFw5ItR_Z27CM在今天公布的第一节课中,讲师为斯坦福大学硕士生 Divyansh Garg、软件工程师 Chetanya Rastogi(毕业于斯坦福大学)、软件工程师 Advay Pal(毕业于斯坦福大学)。此外,第一节课的指导教授为 Christopher Manning,他是斯坦福大学计算机与语言学教授,也是将深度学习应用于自然语言处理领域的领军者。从之前的课程描述来看,CS 25 课程邀请了来自不同领域关于 Transformer 研究的前沿人士进行客座讲座。OpenAI 的研究科学家 Mark Chen,主要介绍基于 Transformers 的 GPT-3、Codex;Google Brain 的科学家 Lucas Beyer,主要介绍 Transformer 在视觉领域的应用;Meta FAIR 科学家 Aditya Grover,主要介绍 RL 中的 Transformer 以及计算引擎等。值得一提的是,AI 教父 Geoff Hinton 也带来了一次讲座。课程主页:https://web.stanford.edu/class/cs25/在 Reddit 帖子的评论区,网友关于该门课程的一些问题也得到了解答。在 CS25 课程中,除了基于自然语言处理(NLP)的演讲内容之外,还将覆盖到视觉 Transformers。关于是否有计划放出一些代码或练习?虽然 CS 25 授课者没有太多时间为原始课程创建练习,但会使用 Harvard NLP 提供的《The Annotated Transformer》中的内容。Harvard NLP 链接:http://nlp.seas.harvard.edu/2018/04/03/attention.html有网友表示,Huggingface 一年前也开设了一门关于 Transformers 的课程,两者的区别在哪里呢?Huggingface 的课程特别适合了解 Transformers 和熟悉构建块。CS25 课程在此基础上做了补充,传播领域最新突破,并讲授如何将新想法应用到自己的研究或构建应用程序中。可以这样说,包括 Huggingface 在内的社区仅仅关注 NLP 领域。CS25 的核心目标之一是在 CV 和 RL 等现有资源稀缺的 AI 领域普及 Transformers 的知识。这也是命名为 Transformers United 的原因。不过,也有网友疑问,整个课程都是关于 Transformers,那接下来会是关于残差块的 web 系列课程吗?不过,CS25 看起来更像是一个专题讲座而不是一门课程。参考链接:https://www.reddit.com/r/MachineLearning/comments/vuw77a/n_firstever_course_on_transformers_now_public/转自机器之心

推荐阅读

深入理解生成模型VAE

DropBlock的原理和实现

SOTA模型Swin Transformer是如何炼成的!

有码有颜!你要的生成模型VQ-VAE来了!

集成YYDS!让你的模型更快更准!

辅助模块加速收敛,精度大幅提升!移动端实时的NanoDet-Plus来了!

SimMIM:一种更简单的MIM方法

SSD的torchvision版本实现详解

机器学习算法工程师

一个用心的公众号

点蓝色字关注“机器学习算法工程师”

点蓝色字关注“机器学习算法工程师”

下载APP

下载APP 点蓝色字关注“机器学习算法工程师”

点蓝色字关注“机器学习算法工程师”