纯Python实现机器学习算法13:Lasso回归

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

第13讲和第14讲我们来关注一下回归模型的两个变种模型。本节我们要介绍的是基于L1正则化的Lasso模型,下一节介绍基于L2正则化的Ridge模型。在正式介绍这两种模型之前,笔者还是想带大家复习一下过拟合和正则化等机器学习关键问题。

正则化是防止模型过拟合的核心技术之一,关于欠拟合和过拟合的问题,这里笔者就不再展开来说,不了解的朋友可以看看笔者很早之前写的一篇文章:谈谈过拟合。

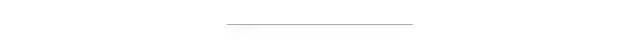

总的来说,监督机器学习的核心原理莫过于如下公式:

该公式可谓是机器学习中最核心最关键最能概述监督学习的核心思想的公式了:所有的有监督机器学习,无非就是正则化参数的同时最小化经验误差函数。最小化经验误差是为了极大程度的拟合训练数据,正则化参数是为了防止过分的拟合训练数据。你看,多么简约数学哲学。正如之前所说,监督机器学习是为了让我们建立的模型能够发现数据中普遍的一般的规律,这个普遍的一般的规律无论对于训练集还是未知的测试集,都具有较好的拟合性能。

继续回到公式。第一项经验误差函数在机器学习中无疑地位重要,但它不是笔者今天要讲的,今天要讲的是公式的第二项:正则化项。第二项中 λ 为正则化系数,通常是大于 0 的,是一种调整经验误差项和正则化项之间关系的系数。λ = 0 时相当于该公式没有正则化项,模型全力讨好第一项,将经验误差进行最小化,往往这也是最容易发生过拟合的时候。随着 λ 逐渐增大,正则化项在模型选择中的话语权越来越高,对模型的复杂性的惩罚也越来越厉害。所以,在实际的训练过程中,λ 作为一种超参数很大程度上决定了模型生死。

系数 λ 说完了,然后就是正则化项,正则化项形式有很多,但常见的也就是 L1 和 L2 正则化。本节我们先来看L1。

在说常见的 L1 和 L2 之前,先来看一下 L0 正则化。L0 正则化也就是 L0 范数,即矩阵中所有非 0 元素的个数。如何我们在正则化过程中选择了 L0 范数,那该如何理解这个 L0 呢?其实非常简单,L0 范数就是希望要正则化的参数矩阵 W 大多数元素都为 0。如此简单粗暴,让参数矩阵 W 大多数元素为 0 就是实现稀疏而已。说到这里,权且打住,想必同样在机器学习领域摸爬滚打的你一定想问,据我所知稀疏性不通常都是用 L1 来实现的吗?这里个中缘由笔者不去细讲了,简单说结论:在机器学习领域,L0 和 L1 都可以实现矩阵的稀疏性,但在实践中,L1 要比 L0 具备更好的泛化求解特性而广受青睐。先说了 L1,但还没解释 L1 范数是什么,L1 范数就是矩阵中各元素绝对值之和,正如前述所言,L1 范数通常用于实现参数矩阵的稀疏性。至于为啥要稀疏,稀疏有什么用,通常是为了特征选择和易于解释方面的考虑。

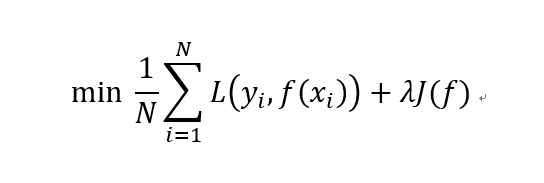

Lasso的全称叫做Least absolute shrinkage and selection operator,直译过来为最小收缩与选择算子。其本质就是在常规的线性回归的基础上对参数加了一个L1正则化约束。其形式如下所示:

规约到线性回归模型上,上式的第一项就是MSE损失,第二项则是L1正则化项。我们同样按照之前线性回归的打法来对其进行实现,只是需要注意一下L1正则化项的求导处理。我们来看具体的实现代码。

导入相关package并读入示例数据:

import numpy as npimport pandas as pddata = np.genfromtxt('mystery.dat', delimiter = ',')# 选择特征与标签x = data[:,0:100]y = data[:,100].reshape(-1,1)# 加一列X = np.column_stack((np.ones((x.shape[0],1)),x))# 划分训练集与测试集X_train, y_train = X[:70], y[:70]X_test, y_test = X[70:], y[70:]print(X_train.shape, y_train.shape, X_test.shape, y_test.shape)

定义参数初始化函数:

# 定义参数初始化函数def initialize(dims):w = np.zeros((dims, 1))b = 0return w, b

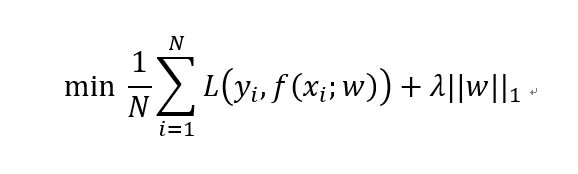

定义符号函数并进行向量化,用于对L1正则化项的梯度计算:

# 定义符号函数def sign(x):if x > 0:return 1elif x < 0:return -1else:return 0# 利用numpy对符号函数进行向量化vec_sign = np.vectorize(sign)vec_sign(np.zeros((3,1)))

在MSE损失函数的基础上定义Lasso损失:

# 定义lasso损失函数def l1_loss(X, y, w, b, alpha):num_train = X.shape[0]num_feature = X.shape[1]y_hat = np.dot(X, w) + bloss = np.sum((y_hat-y)**2)/num_train + np.sum(alpha*abs(w))dw = np.dot(X.T, (y_hat-y)) /num_train + alpha * vec_sign(w)db = np.sum((y_hat-y)) /num_trainreturn y_hat, loss, dw, db

定义Lasso训练过程函数:

def lasso_train(X, y, learning_rate=0.01, epochs=300):loss_list = []w, b = initialize(X.shape[1])for i in range(1, epochs):y_hat, loss, dw, db = l1_loss(X, y, w, b, 0.1)w += -learning_rate * dwb += -learning_rate * dbloss_list.append(loss)if i % 50 == 0:print('epoch %d loss %f' % (i, loss))params = {'w': w,'b': b}grads = {'dw': dw,'db': db}return loss, loss_list, params, grads

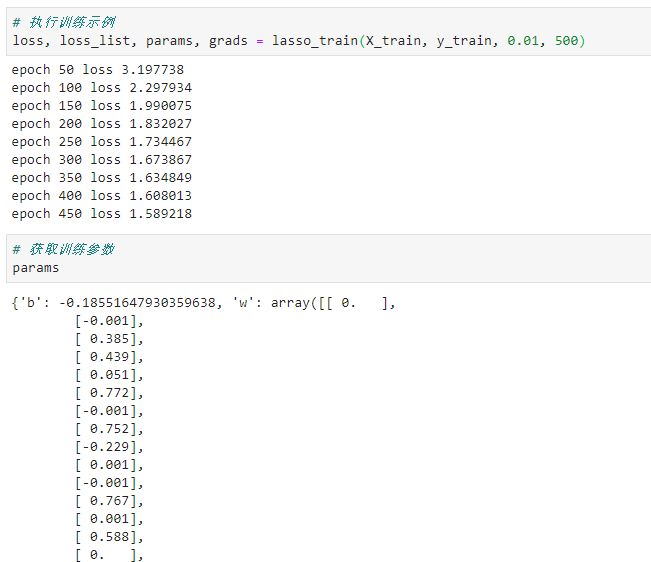

执行训练:

loss, loss_list, params, grads = lasso_train(X_train, y_train, 0.01, 500)

可以看到,在L1的约束下,在训练过程中有不少对标签贡献率低的特征的系数都变成了0。这就是L1的作用,一定程度上可以进行特征选择和实现稀疏化。

最后可以简单写一个Lasso回归的class来对上述过程进行封装:

import numpy as npfrom sklearn.metrics import r2_scoreclass Lasso():def __init__(self):passdef prepare_data(self):data = np.genfromtxt('./example.dat', delimiter = ',')x = data[:, 0:100]y = data[:, 100].reshape(-1, 1)X = np.column_stack((np.ones((x.shape[0], 1)), x))X_train, y_train = X[:70], y[:70]X_test, y_test = X[70:], y[70:]return X_train, y_train, X_test, y_testdef initialize_params(self, dims):w = np.zeros((dims, 1))b = 0return w, bdef sign(self, x):if x > 0:return 1elif x < 0:return -1else:return 0def l1_loss(self, X, y, w, b, alpha):num_train = X.shape[0]num_feature = X.shape[1]y_hat = np.dot(X, w) + bloss = np.sum((y_hat - y) ** 2) / num_train + np.sum(alpha*abs(w))dw = np.dot(X.T, (y_hat - y)) / num_train + alpha*np.vectorize(self.sign)(w)db = np.sum((y_hat - y)) / num_trainreturn y_hat, loss, dw, dbdef lasso_train(self, X, y, learning_rate, epochs):loss_list = []w, b = self.initialize_params(X.shape[1])for i in range(1, epochs):y_hat, loss, dw, db = self.l1_loss(X, y, w, b, 0.1)w += -learning_rate * dwb += -learning_rate * dbloss_list.append(loss)if i % 300 == 0:print('epoch %d loss %f' % (i, loss))params = {'w': w,'b': b}grads = {'dw': dw,'db': db}return loss, loss_list, params, gradsdef predict(self, X, params):w = params['w']b = params['b']y_pred = np.dot(X, w) + breturn y_predif __name__ == '__main__':lasso = Lasso()X_train, y_train, X_test, y_test = lasso.prepare_data()loss, loss_list, params, grads = lasso.lasso_train(X_train, y_train, 0.01, 3000)print(params)y_pred = lasso.predict(X_test, params)print(r2_score(y_test, y_pred))

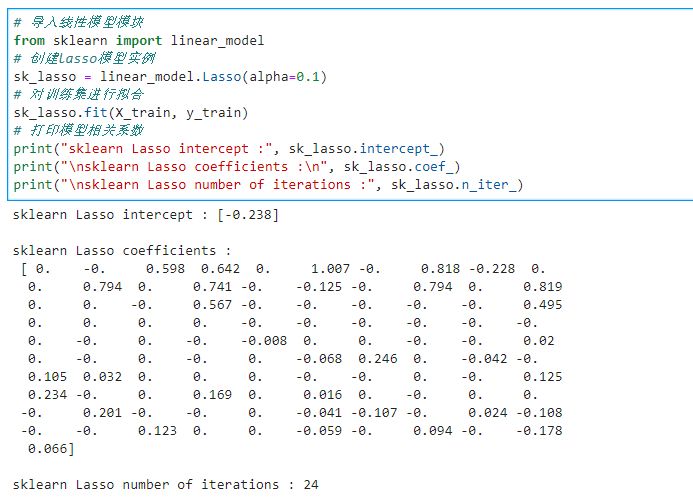

以上是基于numpy的手动实现Lasso的过程,下面再来看Lasso在sklearn中的实现。

# 导入线性模型模块from sklearn import linear_model# 创建lasso模型实例sk_lasso = linear_model.Lasso(alpha=0.1)# 对训练集进行拟合sk_lasso.fit(X_train, y_train)# 打印模型相关系数print("sklearn Lasso intercept :", sk_lasso.intercept_)print("\nsklearn Lasso coefficients :\n", sk_lasso.coef_)print("\nsklearn Lasso number of iterations :", sk_lasso.n_iter_)

下载1:OpenCV-Contrib扩展模块中文版教程 在「小白学视觉」公众号后台回复:扩展模块中文教程,即可下载全网第一份OpenCV扩展模块教程中文版,涵盖扩展模块安装、SFM算法、立体视觉、目标跟踪、生物视觉、超分辨率处理等二十多章内容。 下载2:Python视觉实战项目52讲 在「小白学视觉」公众号后台回复:Python视觉实战项目,即可下载包括图像分割、口罩检测、车道线检测、车辆计数、添加眼线、车牌识别、字符识别、情绪检测、文本内容提取、面部识别等31个视觉实战项目,助力快速学校计算机视觉。 下载3:OpenCV实战项目20讲 在「小白学视觉」公众号后台回复:OpenCV实战项目20讲,即可下载含有20个基于OpenCV实现20个实战项目,实现OpenCV学习进阶。 交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~