将大核卷积分三步,清华胡事民、南开程明明团队全新视觉骨干VAN,超越SOTA ViT和CNN

点击下方卡片,关注“新机器视觉”公众号

重磅干货,第一时间送达

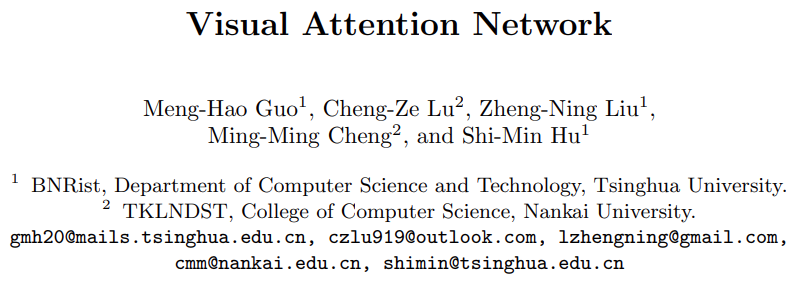

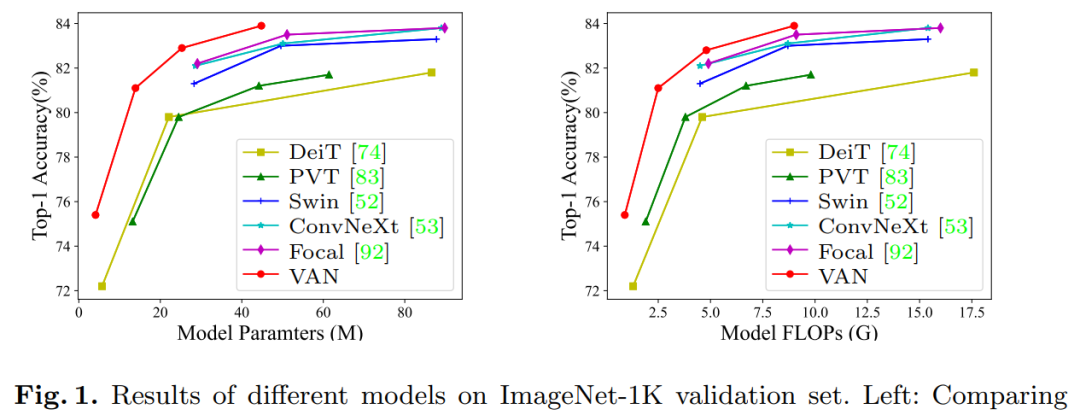

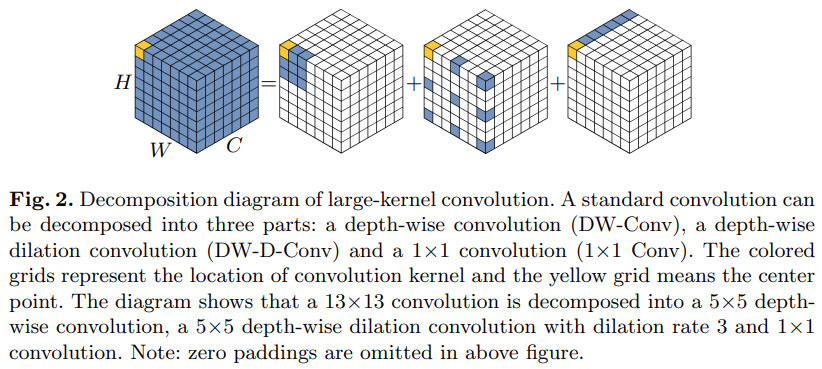

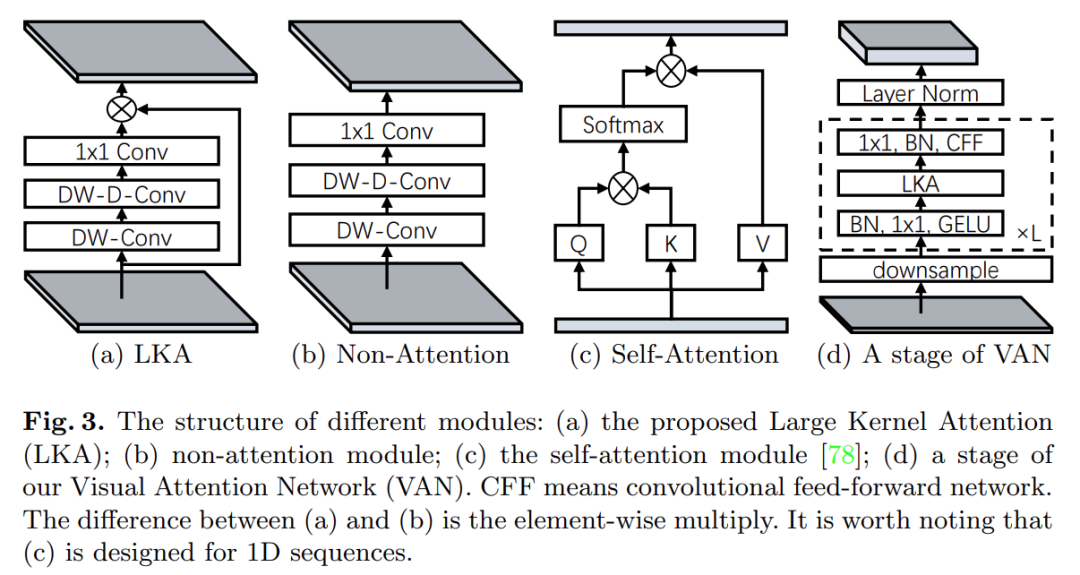

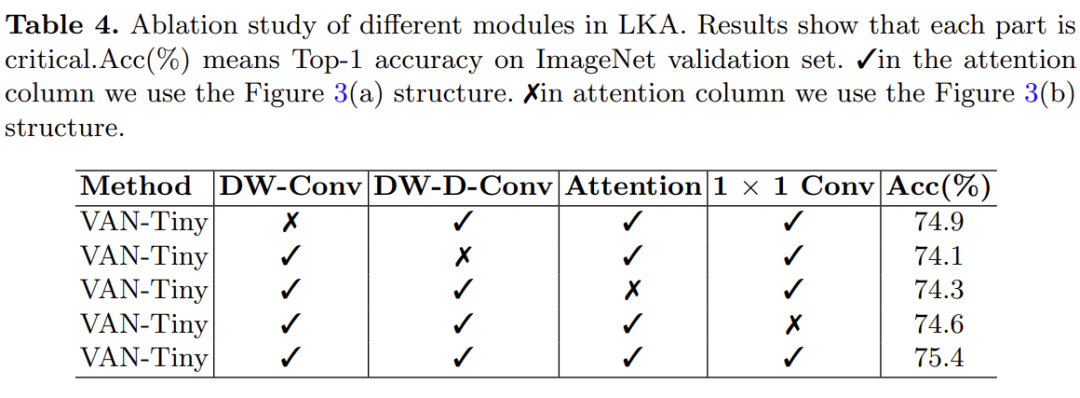

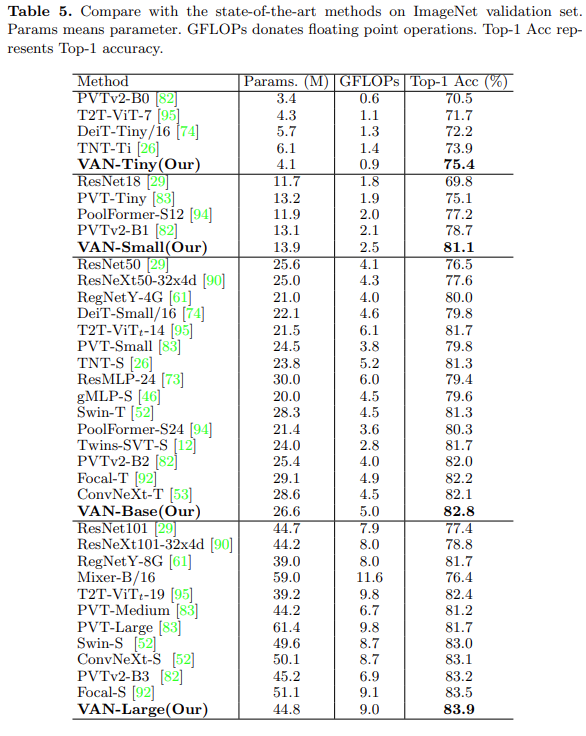

来自清华大学和南开大学的研究者提出了一种新型大核注意力(large kernel attention,LKA)模块,并在 LKA 的基础上构建了一种性能超越 SOTA 视觉 transformer 的新型神经网络 VAN。

将图像视为一维序列会忽略它们的二维结构;

二次复杂度对于高分辨率图像来说太昂贵了;

只捕捉空间适应性而忽略通道适应性。

论文地址:https://arxiv.org/abs/2202.09741

项目地址:https://github.com/Visual-Attention-Network

本文仅做学术分享,如有侵权,请联系删文。

评论