千呼万唤始出来——GPT-3终于开源!

GPT3终于开源!不过,不是官方开的(别打我

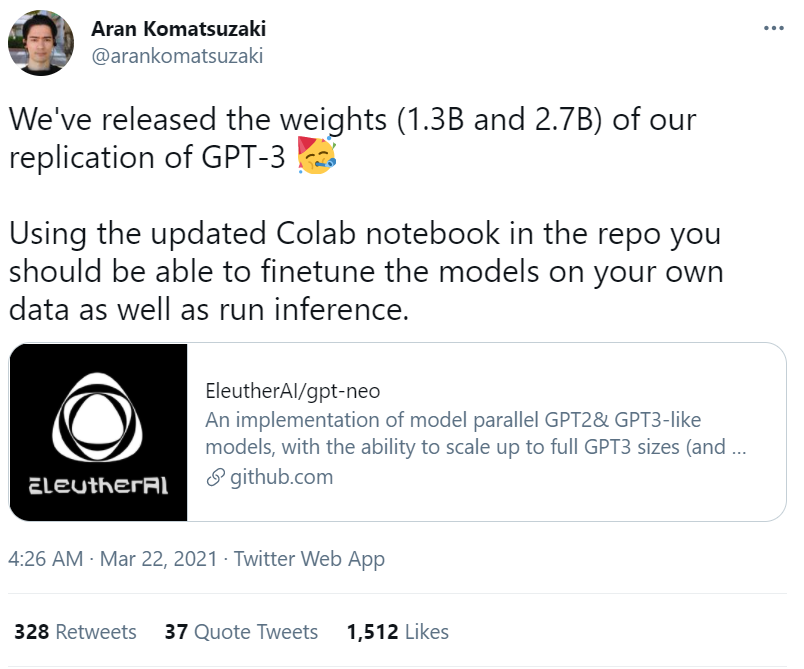

Eleuther AI推出的名为GPT-Neo的开源项目,于今晨4点于twitter正式宣布:已经开源了复现版GPT-3的模型参数(1.3B和2.7B级别),并将其更新在Colab notebook之上。需要指出的是这次开源的模型里较大的那个版本也只是到了GPT-3商用版里最小模型的参数量,不过Eleuther AI表示未来会进一步开源10B版本和原始大小版本的GPT3模型参数。

消息发布后,立刻被各个大v转发,10小时内就已迅速收获1.5K的点赞量,相应的github链接也已收获接近2k star。

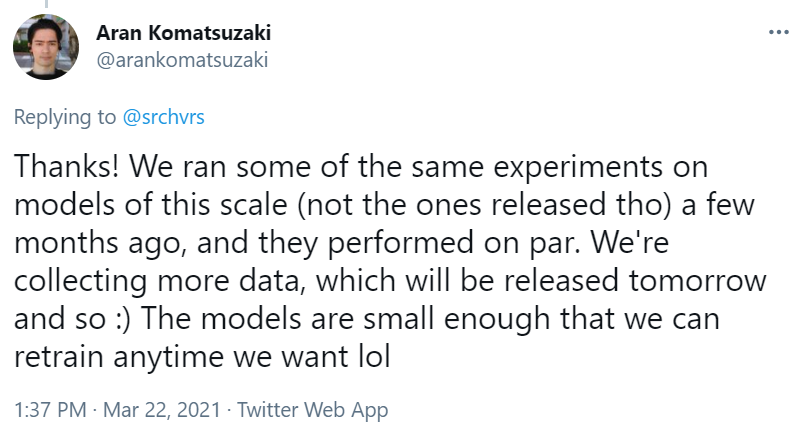

但关于复现模型的性能,目前只说“实验表现与原版GPT-3相当”(they performed on par)。具体实验结果将于明天公布。

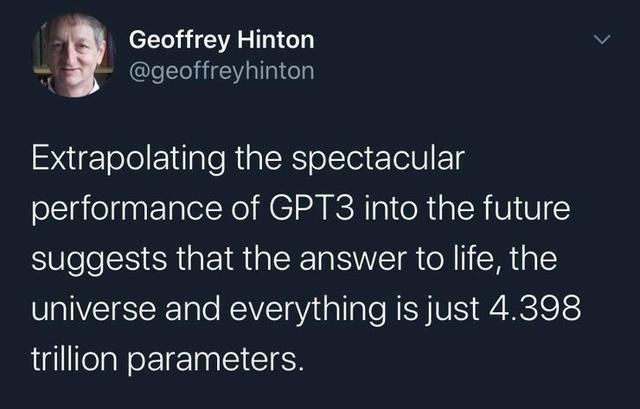

风靡一时的拥有1750亿超大参数量,一出道便被视作NLP领域最强AI模型的GPT-3,得益于其庞大的参数量,使得GPT-3拥有不用接受特定训练与微调,就能在不同NLP领域达到领先水平的强大能力。去年七月,GPT-3被Open-AI以商业API的形式向公众开放,并被人们探索出了形形色色的应用,从基于问题的搜索,到文本样式转换,从UI界面设计,再到自动生成SQL代码,GPT-3以其卓越的性能展现了其广阔的应用场景,深度学习之父Hinton甚至这样评价道:

如果以GPT-3的出色性能推算未来、生命、宇宙和万物的答案也不过是4.398万亿个参数

但是,由于目前GPT-3的使用模式仍然是付费的商业API,因此并不是所有NLP的研究者都能使用GPT-3完成自己领域的任务与工作。而由Connor Leahy,Leo Gao和Sid Black三人联合创立的Eleuther AI的团队,于去年11月宣布推出GPT-Neo的开源项目,该项目基于GPT系列的设计原理,旨在复现GPT系列的各种项目,在该项目发布之初,其团队成员已经预测可以完成GPT-3级别大小的语言模型。

毫无疑问,GPT-3的开源将会催生出一大批NLP技术的崭新应用,也会以更为低廉的成本释放人们对NLP未来的想象力。以下是项目的Github与推特原文地址。

Github:

https://github.com/EleutherAI/gpt-neo/

Twitter:

https://twitter.com/arankomatsuzaki/status/1373732645444579331?s=05