马里兰大学华人博士提出Transformer-LS霸榜ImageNet,输入长度提升三倍

新智元报道

新智元报道

来源:马里兰大学

编辑:LRS

【新智元导读】你是否受到Transformer无法输入篇章级词汇数量的困扰?马里兰大学华人博士提出能输入超长文本的Transformer-LS!无需更换硬件,输入长度即可提升三倍,参数压缩率超100%!

Transformer模型在语言nlp和视觉cv领域都取得了巨大的成功。

然而,由于自注意机制具有与输入序列长度N相关的二次方时间和记忆复杂度O(N^2),因此将它们扩展到长序列(如长文档或高分辨率图像)是非常费时费内存的。

以前的方法通常将它们分成等距的片段,并基于每个片段独立地预测文本向量,而不考虑其他片段的信息。

在模型改进上,人们也提出了许多方法来处理注意力机制过于复杂问题。一般来说,它们可以分为以下几类:

1)具有预定义模式的(例如滑动窗口)的模型,包括Sparse Transformer, Image Transformer, Axial Transformer等模型用来建模图像,Longformer, ETC, Big Bird等用来建模语言。

2)low-rank投射注意,包括Linformer, Nystromformer, Synthesizer。例如,Linformer使用线性层来投影从长度为n的原始高维度键(K)和值(V)到大小为r(r 远远小于 n)的低维度并允许所有查询标记(Q)参与这些压缩表示。

3)基于内存压缩机制的,像Compressive Transformer和SetTransfomer,它们使用额外的内存来缓存全局远程信息,用于计算距离较远的词之间的注意力。

4)基于核的注意力矩阵近似,包括Performer, Linear Transformer, Random Feature Attention。

5) 基于相似度和聚类的方法,包括Reformer, Routing Transformer和Sinkhorn Transformer。

针对这个问题,马里兰大学和英伟达共同提出一个新模型,基于low-rank映射和局部窗口注意力的长短Transformer(Long-Short Transformer, Transformer-LS)。

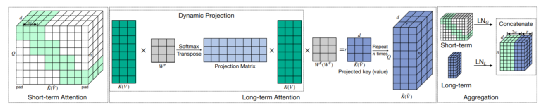

Transformer-LS采用一个高效的自注意机制,用于建模具有线性复杂度的长序列的语言和视觉任务。它通过动态投影聚合长距离注意力来模拟远距离相关性,并通过短期注意力来捕捉细粒度的局部相关性。

同时提出了一种双重归一化策略来解释这两种注意机制之间的规模不匹配。Transformer-LS可以应用于自回归和双向模型,并且没有引入额外的复杂度。这个方法在语言和视觉领域的多个任务上优于sota模型,包括Long Range Arena 基准测试、自回归语言建模和 ImageNet 分类。

例如,Transformer-LS 在 enwik8上实现了0.97测试 BPC,使用的参数数量是以前方法的一半,而且速度更快,想比完全注意力机制,在相同的硬件上新方法能够能够处理长3倍的序列。在ImageNet上,它也取得了sota 结果(只训练224*224 ImageNet-1K数据集,top1准确率达到了84.1%),同时这个方法在高分辨率图像上也具有通用性。

目前模型和源代码还没有公布,但文中称很快将会公开。

这篇论文的第一作者是Chen Zhu,马里兰大学巴尔的摩分校计算机科学的博士生,导师是 Tom Goldstein 教授。主要研究方向是机器学习,以及它在计算机视觉中的应用。于2018年获得了上海科技大学的硕士学位,并于2015年获得了北京航空航天大学的电子与信息工程学士学位。

文章的第二作者是 NVIDIA 的高级研究科学家,致力于机器学习、语音和自然语言处理。在此之前,我是百度研究的 TTS 团队领导。2016年在加州大学欧文分校获得了机器学习博士学位。热衷于为各个领域建立最先进的生成模型,包括音频、文本和视频。

Tom Goldstein教授的研究主要集中在机器学习和优化的交叉领域,目标应用于计算机视觉和信号处理。在理论和实践之间的边界工作,利用数学基础、复杂模型和高效硬件来构建实用的、高性能的系统。设计了多种平台的优化方法,从强大的集群/云计算环境到资源有限的集成电路和 fpga。在加入马里兰大学之前,他在加州大学洛杉矶分校完成了数学博士学位,并在莱斯大学和斯坦福大学担任研究科学家。曾经获得包括 SIAM 的 DiPrima 奖,DARPA 青年教师奖和 Sloan 基金奖励。

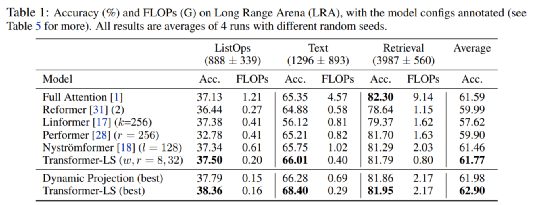

为了评估Transformer-LS作为长文本的双向编码器的效果,从最近提出的长期研究中选择了三个NLP任务Long Range Arena (LRA)基准:

1、ListOps,ListOps被设计用来通过层次结构数据来度量模型的解析能力。遵循中的设置,其中每个实例包含500-2000个词。

2、Text。这是一个二元情感分类任务,用于预测来自IMDb电影评论是否是正面的评论。做出正确的预测需要一个模型来推理组合的未分段字符级长序列,最大长度为4k。

3、召回。此任务基于ACL Anthology Network数据集。模型需要分类两篇论文之间是否存在共同引用,以评估模型的有效性为基于相似性的匹配编码长序列的能力。最大序列长度每个字节级的文档是4k,模型每次并行处理两个文档。

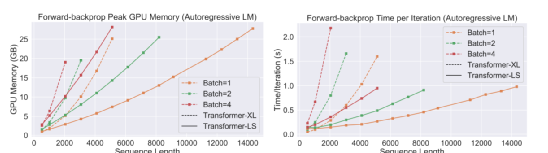

Transformer XL(完全注意力)和Transformer-LS在Char LM上的运行时间和内存消耗如下图。增加序列长度,直到用完V100GPU上的32GB内存。Transformer-LS与较小模型消耗相同,使用虚线表示完全注意力,实线代表我们的Transformer-LS。用不同的颜色来表示不同的批量大小。

结果显示了text8和enwik8的比较。文中提出的方法达到了sota水平。在text8上,用较小的模型实现了1.09的测试BPC。在enwik8上,我们的小该模型的测试BPC为0.99,性能优于具有可比性的最新模型参数。大模型获得的测试BPC为0.97,与压缩率相当于2倍参数Transformer。

在5个阶段和48 GPU内存更长的序列,结果总是比经过训练的Longformer更好。

参考资料:

https://arxiv.org/abs/2107.02192

-往期精彩-