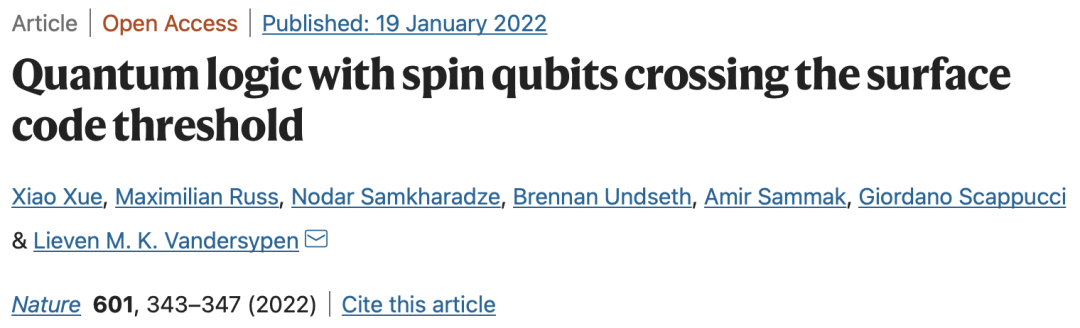

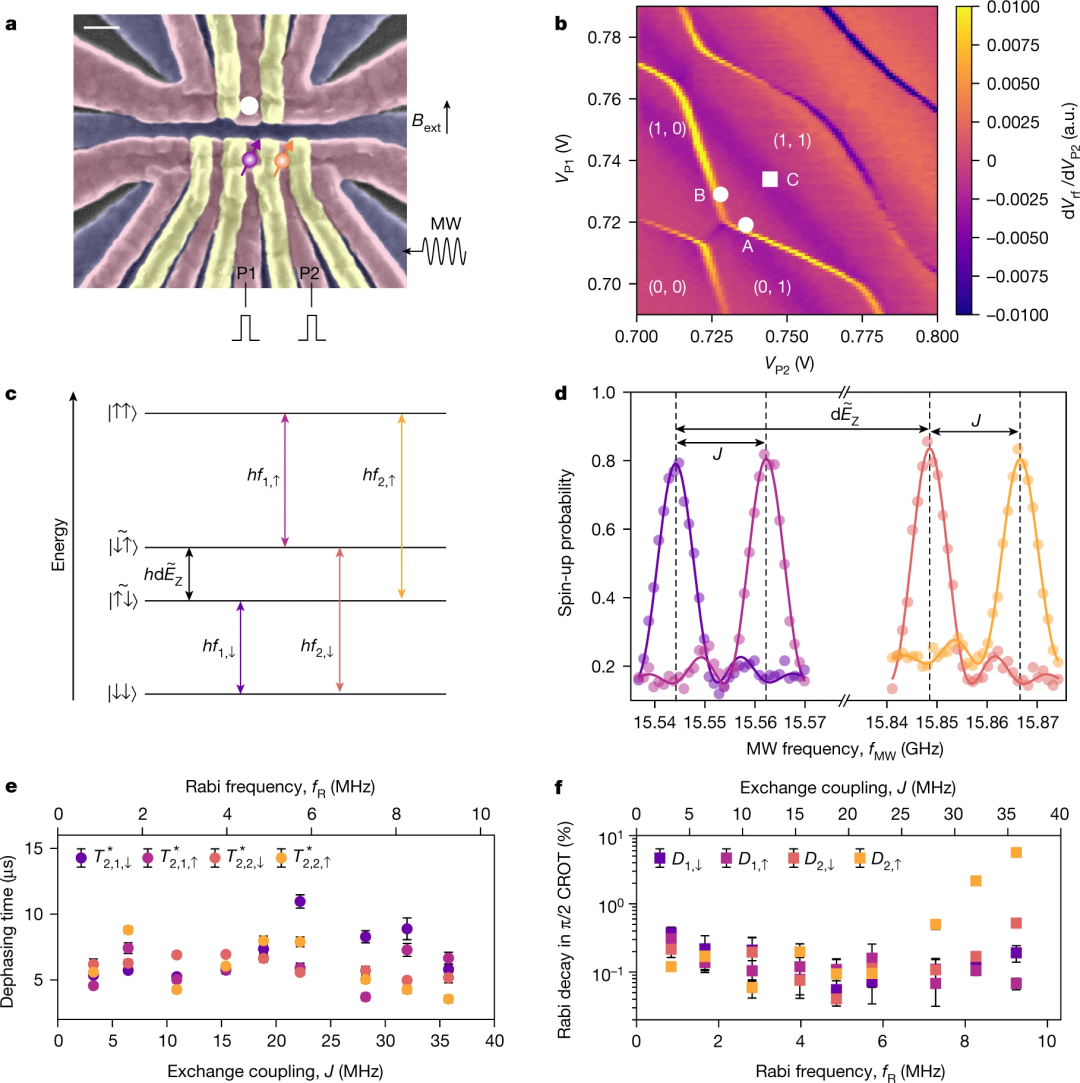

90后山东小伙一作登Nature封面!硅量子比特里程碑达成,保真度超99%

新智元报道

新智元报道

编辑:David 好困

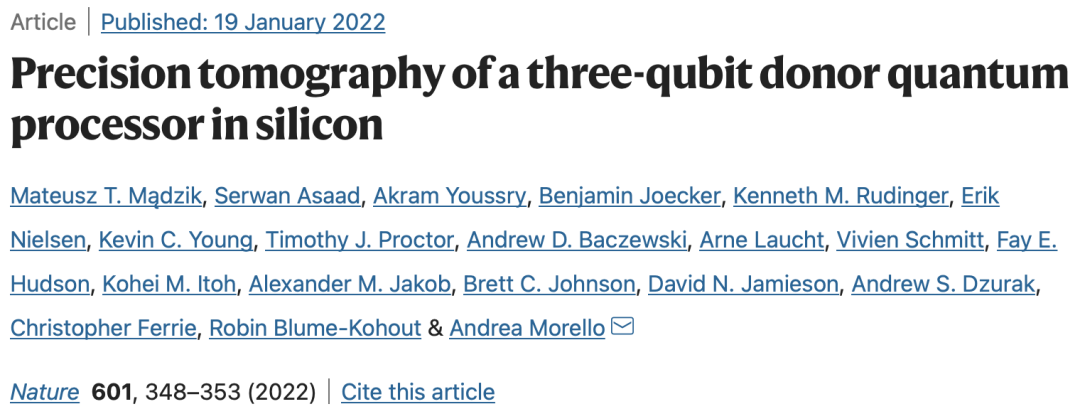

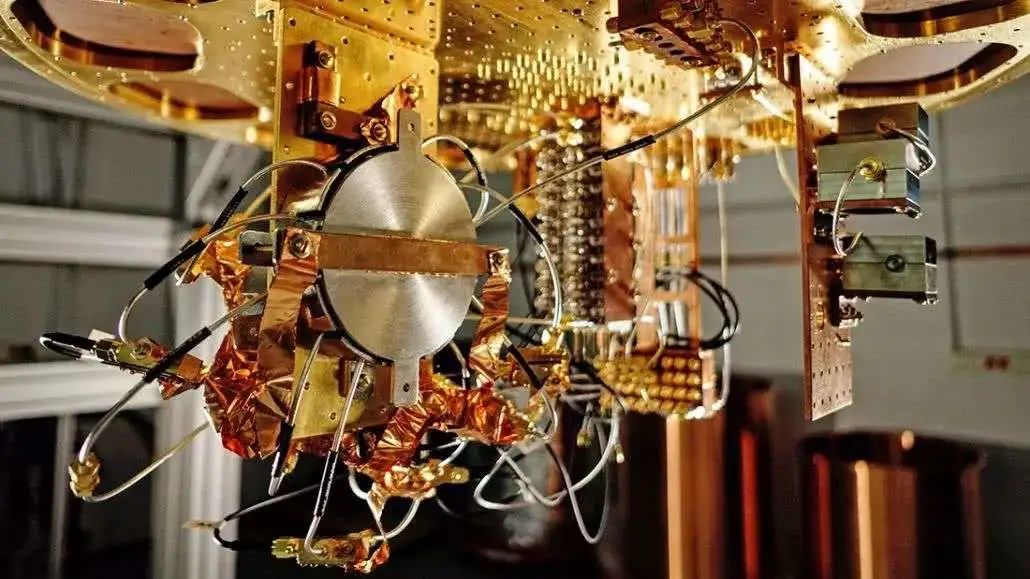

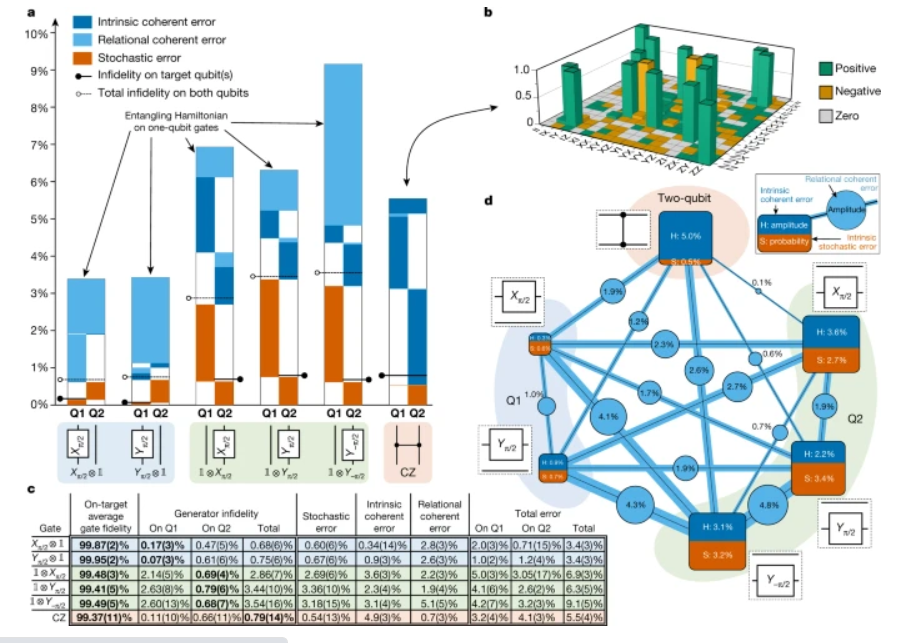

【新智元导读】近日,量子计算再获重大突破,硅基量子门的保真度突破99%,超过容错阈值!Nature为此在封面上连刊三文。

量子纠错

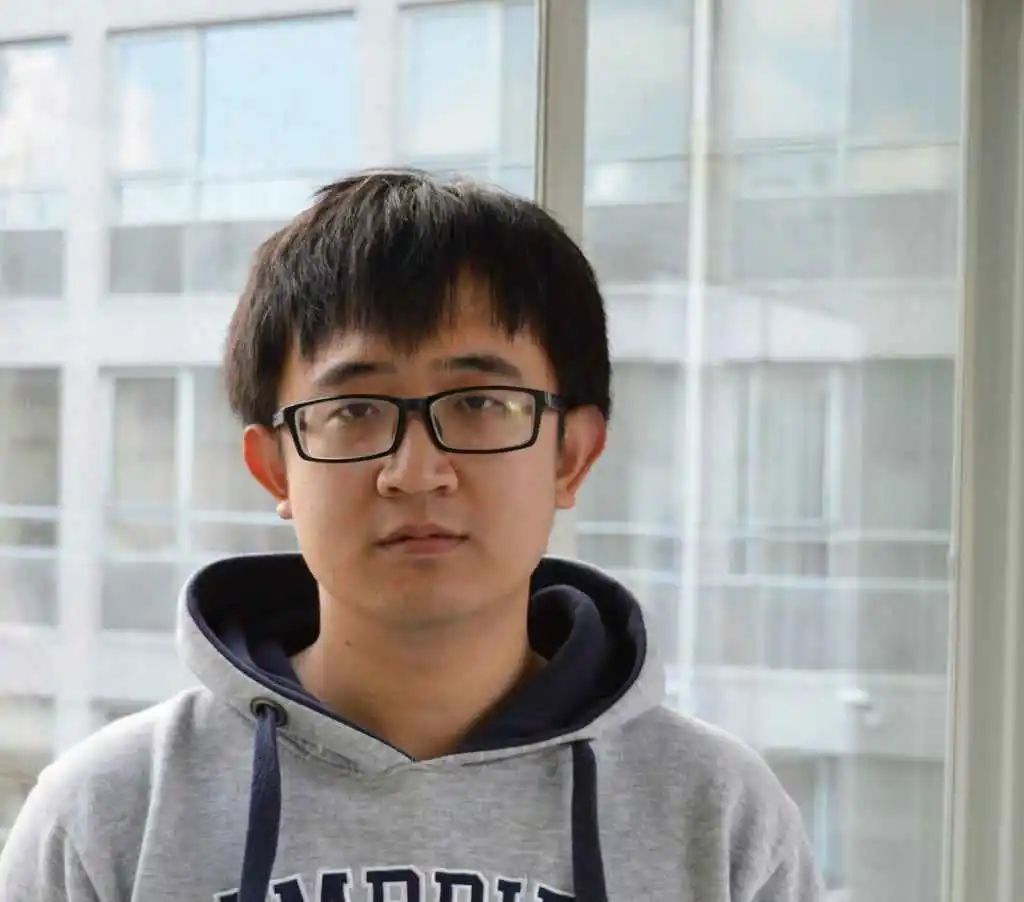

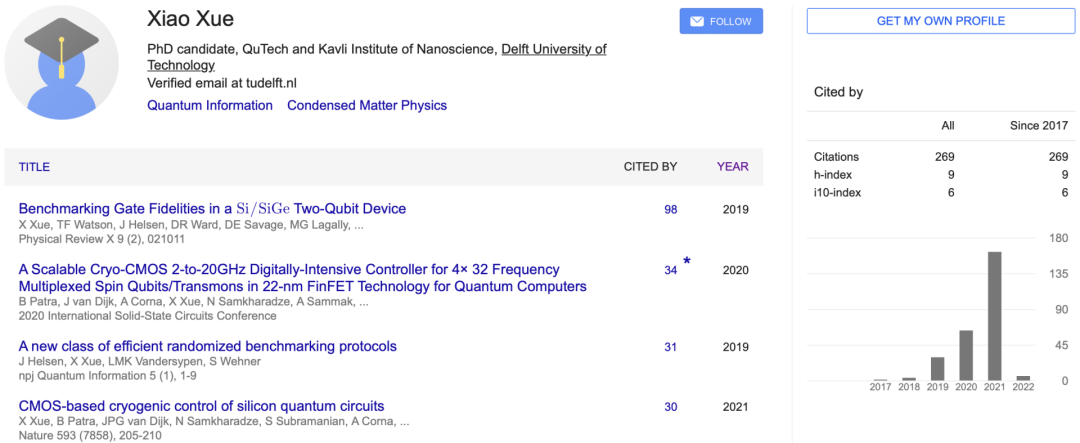

作者介绍

参考资料:

https://www.nature.com/articles/s41586-021-04273-w

https://www.nature.com/articles/s41586-021-04292-7

https://www.nature.com/articles/s41586-021-04182-y

https://www.nature.com/articles/d41586-022-00047-0

本文部分引用以下文章的技术介绍:

http://tech.china.com.cn/hydt/20220120/384411.shtml

AEB测试「霸榜」!理想如何靠全栈自研逆袭成功?

元宇宙要革了AI的命!奇点爆发第二年,新智元寻找「星舰」领航者

评论