机器人的「三体问题」

导读:物理学中有一个概念叫作三体问题,与重力如何影响大型物体(如行星和太阳)有关:当有两个以上的物体时,若试图计算重力对三个物体的影响,数学公式将变得比只有两个物体时复杂得多。

在机器人技术中,我们可以用该术语来指代人机交互中出现的三个参与者的问题。我们不仅需要考虑机器人、用户/监管者,还需要考虑机器人、用户/监管者和旁观者。此时,问题也变得更加复杂。

例如,越来越多的安全机器人被部署在公寓大楼、体育赛事现场和社区。它们融合了自动驾驶技术、激光扫描仪、热成像、360度视频和许多其他传感功能,它们在需要加强安全保障的区域行驶,具备强大的功能,以阻止盗窃、故意破坏或其他安全威胁,并捕获各种数据以增加识别犯罪活动的可能性。

监管者可以与远方的一个或多个机器人合作,实时监视收集的数据,并根据观察结果重新部署安全人员。这些用户(或监管者)通过阅读手册和接受培训来建立关于机器人的心理模型。

但是,当看到这个不明身份的机器人在人行道上巡逻时,周围的社区居民、商店和企业的顾客一开始会感到惊讶,他们必须依靠短暂的观察来弄清楚它为什么会在那里,并怀疑它是否会碾过他们的脚趾,伤害他们的孩子或宠物,甚至误认为他们是罪犯。

2016年7月,一个安全机器人在加利福尼亚帕洛阿尔托的斯坦福购物中心巡逻,撞倒了一个16个月大的小孩,然后继续前进。根据制造商的说法,这个小男孩可能对这台看上去很奇怪的机器很感兴趣,于是离开了父母的身边,开始朝机器人跑去,机器人为了避免撞到小男孩而转向了左侧,但小男孩也改变了方向,导致两人相撞。

在这种情况下,机器人并没有造成严重的伤害,但有时候情况可能会更糟,例如机器人可能重300磅(约136千克),高5英尺(约1.5米)——这对于机器人的成功管理来说是极具挑战性的。孩子被激起兴趣并走向麻烦的过程中,父母甚至可能没有注意到机器人,而机器人对孩子不可预测的动作也没有准备。

在这种情况下,机器人最好停下来,而不是改变方向。人类安保人员可能不得不停下来与孩子互动,或者至少知道如何在孩子周围进行操作。难道安全机器人不应该像人类那样,向孩子表现出同样的关注并具备足够的适应能力吗?

与受过培训的用户相比,旁观者没有多少直接接触机器人的经验,所以他们只能以非常有限甚至不准确的心理模型来操作系统。另外,由于他们的目标与机器人的目标不同,因此机器人可能只会分散他们的注意力,并且可能会对他们造成干扰。

一般来说,机器人应尽可能减少对旁观者的干扰。当确实发生干扰时,机器人与旁观者之间的协商过程应尽可能快速简便,就像我们在人群中用简单的短语(如“打扰了”)完成沟通一样。我们不需要详细了解人群中的其他人在做什么,或者他们将在哪里绕过其他人。

但是我们确实考虑了其他高级信息,例如他们是老人还是孩子,或者正在专注地进行交谈,可能注意不到我们,或者他们手中有沉重或不方便挪动的东西,例如一两杯热咖啡。

当我们注意到有关周围其他人的高级信息时,我们会在潜意识中将其纳入行动和决策中。如果有一位老人在我们前面走过,我们会为他让出更多的空间。当我们走进一家商店时,如果有一位推着婴儿车的家长跟在后面,我们会让门开的时间比平时长一点,以帮助他们便捷地通过。我们一直在与其他人交流,而不会彼此交换任何详细信息。

同样,旁观者不需要对机器人的全局计划、意图或推理有详细的了解。我们可以通过人脑中的主动和被动感知系统来对比监管者和旁观者的需求,其中一种是由目标自上而下驱动的,另一种是由刺激自下而上驱动的。

作为机器人的队友,监管者需要机器人行为的主动模型,该模型是通过搜索监管者和机器人的共同目标所需的相关信息来构建的。

旁观者只需要足够的信息即可发挥自己的作用,以最大限度地减少干扰并协调可能发生的短暂交互。他们没有直接监视机器人的责任,也没有监视穿越道路的行人的责任,也就是说,他们只需要自治系统行为的被动模型,该模型是通过观察和处理系统在实现目标时所需的信息而构建的(图11)。

▲图11 扩展设计者的概念模型以包含旁观者。旁观者需要机器人行为的被动心理模型,以实现两者的共同目标而互不干扰

例如,你可以快速地瞥一眼街上向你走来的人,然后评估那个人的肢体语言,以确定这个人在与你擦肩而过时是否有可能改变方向。你做这件事时没有意识到这一点,评估就在一瞬间发生。

但是如果你注意到那是一个孩子,或者有人拿着一个大包裹,你会自动多让出一点空间让他们安全通过,而并不需要知道该人是谁、要去哪里或为什么要去那里。同样,你无须知道机器人在做什么——为旁观者提供丰富的机器人模型也是不必要的,此外,就认知负担而言,这将付出很高的代价。

机器人也不需要确切地知道你在做什么以及为什么。如果有一个爱管闲事的邻居经常在公寓楼的走廊上拦住你,问你要去哪里、走哪条路、出门多长时间以及晚餐打算吃什么,该怎么办?更糟糕的是,如果小区的保安开始问你所有这些问题呢?

这些是他们不应该关注的细节。你可能会感到烦恼,甚至惊慌失措,并尽可能少说话,一直默不作声地走着。将来你可能会尽量避免与他们互动。

因此,只需要极少量的线索,就可以让机器人和人在街上安全通行。但是,我们怎样才能为旁观者提供正确的线索来预测机器人的行为,使他们能够利用观察到的有限信息来适当地调整自己的行为呢?我们如何设计机器人来准确地接受人们的暗示,并调整它们的行为以避免冲突呢?这些问题要求我们重新思考机器人的设计。我们必须设计一个人机系统,而不是简单地设计一个自动化系统。

我们总是考虑着身边的人,即生活中的旁观者,他们贯穿于我们决策过程的始终。我们可以帮拎着沉重购物袋的人关上门,保护孩子们冲到街上捡回滚落的球,把座位让给公共汽车上的一位老人。

机器人可能永远不会有同情心,尽管在科幻小说中可能有相反的观点。除非我们将同情心编入程序,否则机器人不会表现出人类通过长时间学习才表现出的社会道德和礼貌。不过,机器人可能无须如此完美,看起来这些新的社会实体只要尽最大努力不被人讨厌,就足够了。

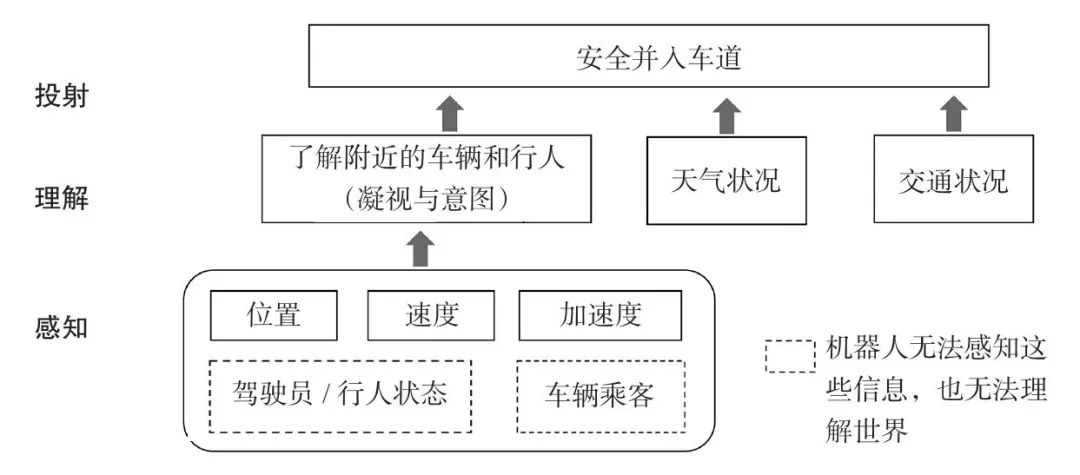

举一个简单的例子,在开车时将车并入另一个车道上,我们将这一过程分解为三种情境感知:感知、理解和投射(图12)。首先,感知有关自己汽车的信息(例如速度、位置和加速度)以及周围其他车辆的信息(再次感知速度、位置和加速度,以及车辆的接近度和类型)。

▲图12 人类如何感知环境的各个方面,例如另一辆车的位置和司机在车内的状态,然后在理解阶段使用这些信息来了解情况,并最终预测在特定时刻并入另一条车道是否安全

然后进行理解。如果离你最近的汽车的驾驶员正在发短信,则说明他可能没有注意到你,并且你会预测他在你并入车道时不会减速。或者你感觉到一辆城市巴士正在逼近,但它后面的空间是开放的,在这种情况下,即使公共汽车前面有足够的空间,你也可以选择延迟并入。

当然,与此同时,你也在感知其他细节——关于天气、道路状况,以及除了周围汽车以外的其他交通变化,比如前面亮起的汽车刹车灯。这种隐含的有前后联系的信息通常不包含在设计者为自动驾驶汽车开发的概念模型中,但是对于与道路上的其他实体进行安全交互至关重要。

如果工作机器人在设计时不考虑旁观者,那么当机器人填满我们的道路、人行道和天空时,它们将不仅仅是烦恼,其错误可能导致真正的灾难。因此,它们的核心设计必须能容纳旁观者。事实上,正确处理这个问题可能是我们今天面临的最新、最重大的设计挑战。

当然,在某些情况下,我们对人类的期望远不止是置身事外。例如,如果你在离开商店时不小心把一些商品弄掉在地上,其他顾客可能会停下来帮你把物品从地上捡起来。停下来帮助你并不能帮助他们更快地到达目的地,事实上,恰恰相反。

即使如此,他们也会帮你这个忙,因为他们认为他们可能会再次见到你,而你可能会以某种方式帮到他们。问题是,我们是否也应该尝试开发机器人的这种行为,而不仅仅是让它们远离我们?

我们首先关注的是如何最小化人与机器人之间的干扰这一问题,正确地做到这一点将为更好地实现机器人的社交互动提供坚实的基础。更紧急的是,这可能涉及身体或心理安全问题。

三体问题的灾难性代价

讨论三体问题不仅仅是为了减少麻烦,我们现在才初步看到对这个问题视而不见可能带来的灾难性代价。

2017年8月,一个多雨的下午,在密歇根州的塔斯科拉县,一名男子在高速公路上向西行驶时,他的车滑出了车道。他失去了对车辆的控制,越过中心线,撞上了一辆迎面而来的皮卡车。

紧急救援人员到达现场后,将他从车中解救出来,他被困多时并受了重伤。同时,请求了一架医疗直升机进行支援,与地面配合,帮助急救人员小心翼翼地将他救出。

当飞行员靠近地面时,他迅速判别出车祸现场的位置,并开始着陆。飞机开始下降,飞行员在扫视过程中,突然余光发现了突发情况——他的心跳加速,中止下降!他差点没发现那个正在靠近的威胁——一架休闲无人机正在车祸现场上空盘旋并录制视频。飞行员紧急调整救援计划并推迟着陆,这导致司机当天晚些时候因伤过世。

飞行员不能继续下降,因为他不能确定无人机要做什么,他也没有办法与它沟通。他只是一个旁观者,无法指挥或预测无人机的行为。

显然,直升机飞行员的目标和无人机操作员的目标并不一致。救援直升机的飞行员想让直升机尽可能安全地降落在离事故地点最近的地方,并且要尽可能快。飞行员并没有考虑将避开无人机作为这个目标的一部分。

但机器人的监管者并不知道旁观者的意图,他很难通过遥控界面里的狭窄视野迅速收集到相应的信息。这架无人机的操控者正在查看视频,并操纵无人机以获得更好的拍摄角度,可能还没有注意到无人机上方的救援直升机。

救援直升机飞行员与空中交通管制人员交谈并收听广播,以避免与该地区的载人飞机发生任何冲突。地面上,应急人员为直升机准备了一个降落区域,并将其他人员挡在一边,尽量减少该区域的旁观者。但飞行员并不知道这架休闲无人机的意图,同时也很难对其施加影响。

不幸的是,这不是特例。从2014年到2016年,联邦航空管理局接到了大约650起无人机和其他飞机(包括商用飞机、直升机和消防飞机)之间的未遂事件报告。无辜的操作员使用这些飞行机器人捕捉视频、与朋友比赛或尝试新功能,但却无意中干扰了重要的活动。

这些无人机如今都是遥控的,自主性很小甚至没有,但它们是矿井里的“金丝雀”。它们预示着一个更大的威胁即将到来,随着空中越来越多的机器人出现,很快,在我们的街道和人行道上也会相继出现机器人。

干货直达👇