大促密集,CDN如何保障电商体验如丝般顺滑?

讲师:曾福华,高级技术专家,阿里云边缘云智能调度系统负责人,主要研究技术方向为边缘云网一体化调度。

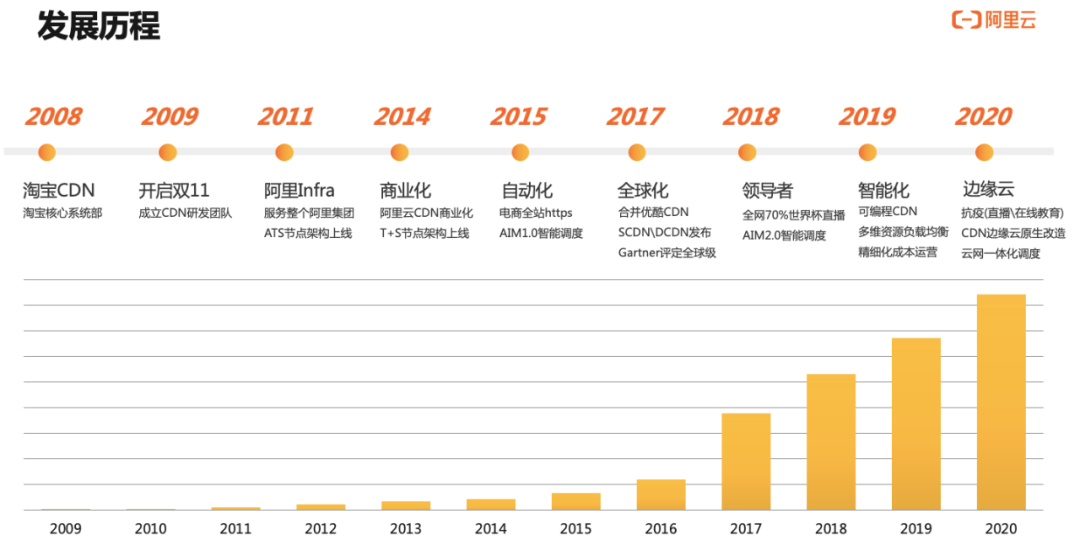

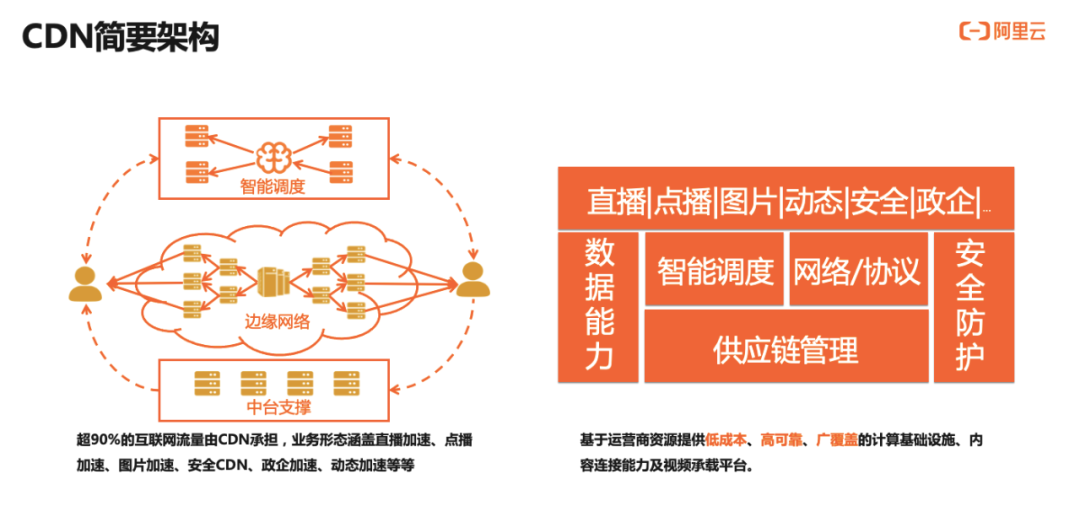

CDN的发展历程及架构简介

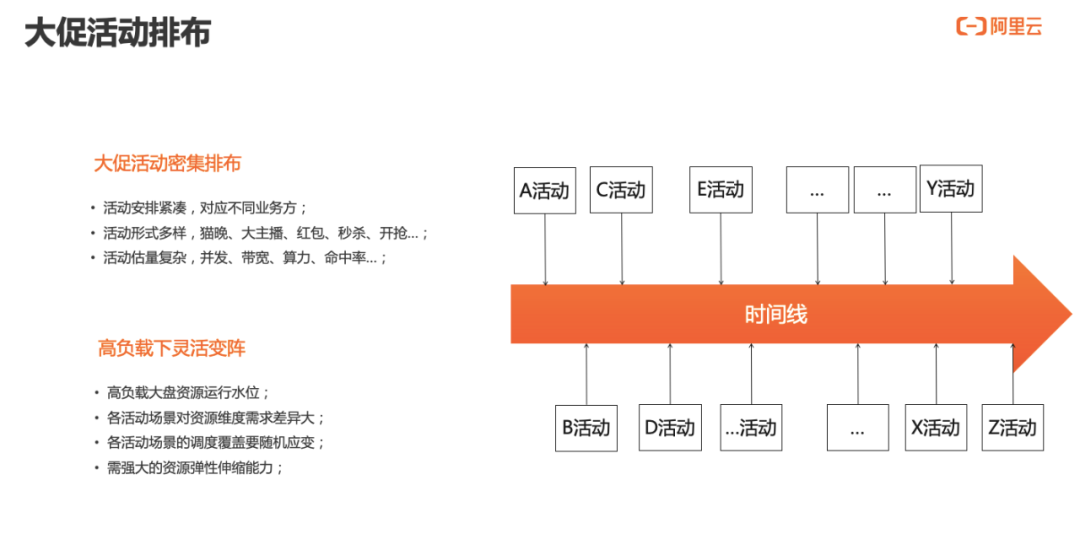

大促场景下,有关CDN的体量、保障以及排布那些事

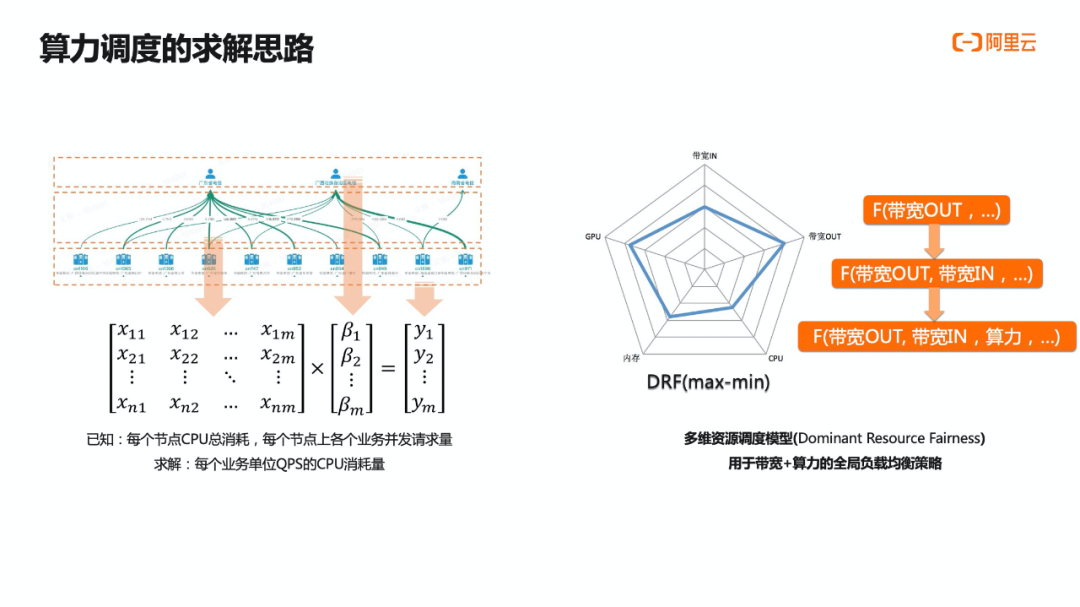

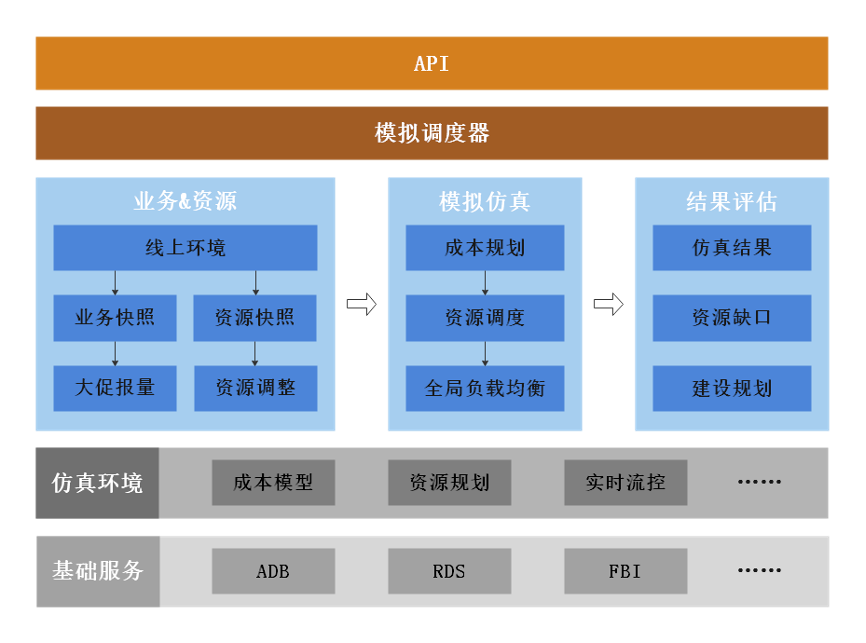

弹性、算力及模拟仿真等关键技术解读

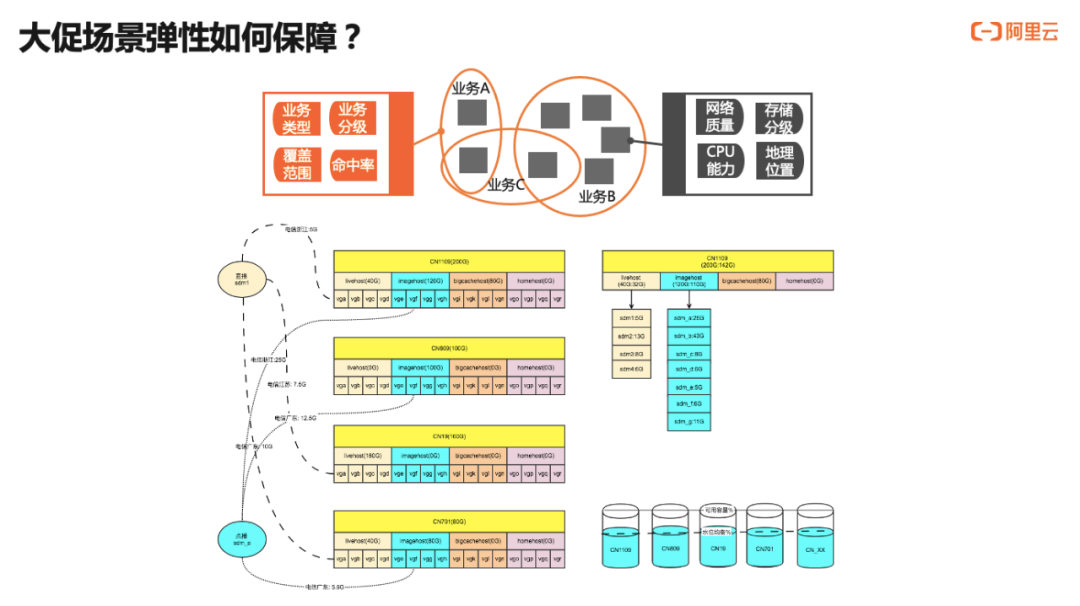

资源共池融合是业务弹性保障的最关键因素; 不做业务级别的节点硬件隔离,流量实时按需流动到全网所有节点上; 弹性、质量是可权衡的双目标,可根据实际情况进行自主灵活可控(业务资源匹配程度); 按整体大盘需求进行资源规划、资源建设、资源调度;

节点角色交调度系统决策,剪除硬约束; 业务资源池交调度系统实时决策,灵活变阵; 节点上业务混布交调度系统决策,充分复用; 资源池规划、全局负载均衡中台的双剑合璧,弹性伸缩;

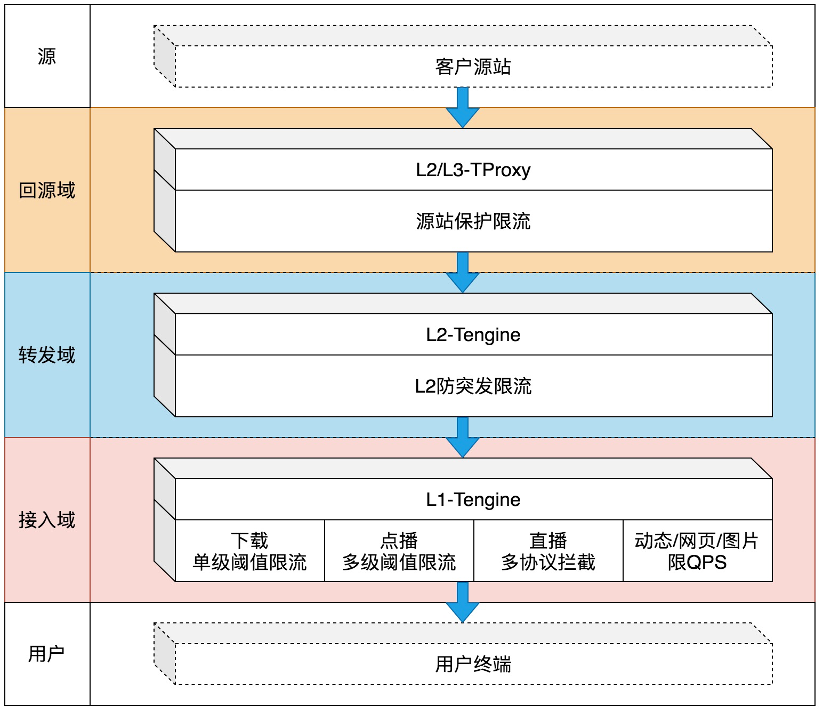

业务类型: 直播、点播、下载、动态加速等场景限流; 限流类型: 带宽、QPS、连接数等; 限流形态: 单阈值区间限流,多阈值区间限流; 限流范围: 全网、区域、节点等; 限流层级: L1限流、L2限流、回源限流;

今日福利-留言赢好礼

你的程序生活中,有用到CDN吗?它的作用是什么?

如果你的问题获得最多点赞,边缘酱也会送出阿里云CDN纪念T恤一件,限量定制款哦!

评论