仅用三张图,合成高质量的3D场景,NTU提出SparseNeRF

来源:机器之心 本文约2000字,建议阅读5分钟

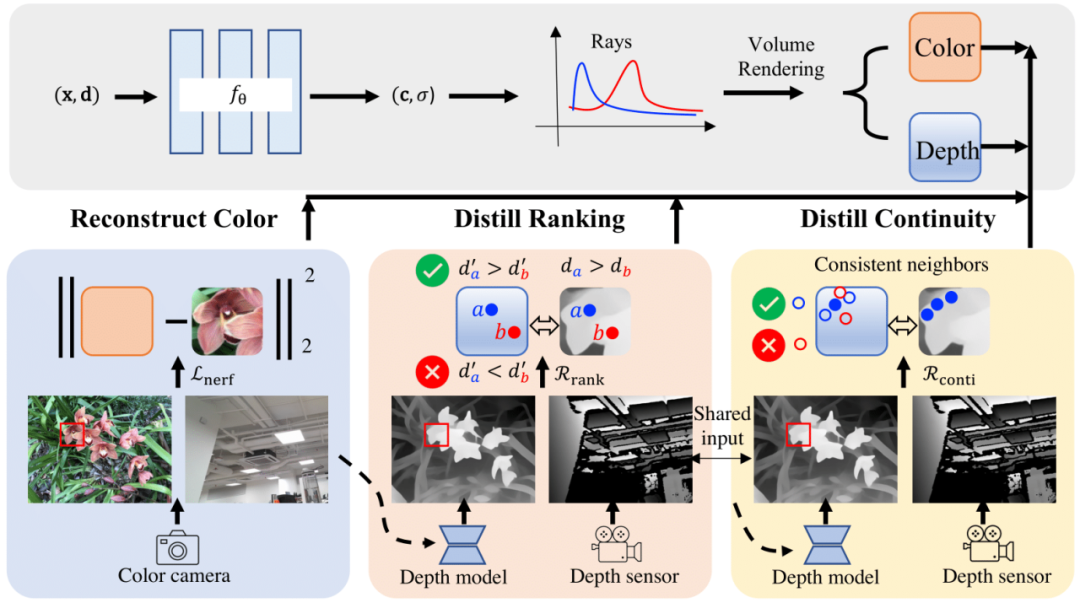

最近,一些方法极大地改进了基于神经辐射场 NeRF 稀疏 3D 重建的性能。

随着深度学习与 3D 技术的发展,神经辐射场(NeRF)在 3D 场景重建与逼真新视图合成方面取得了巨大的进展。给定一组 2D 视图作为输入,神经辐射场便可通过优化隐式函数表示 3D。

然而,合成高质量的新视角通常需要密集的视角作为训练。在许多真实世界的场景中,收集稠密的场景视图通常是昂贵且耗时的。因此,有必要研究能够从稀疏视图中学习合成新视角图像且性能不显著下降的神经辐射场方法。

比如说,当输入只有三张视角图片时,我们希望可以训练出真实的 3D 场景,如下动图所示:

-

项目主页: https://sparsenerf.github.io/ -

代码: https://github.com/Wanggcong/SparseNeRF -

论文: https://arxiv.org/abs/2303.16196

编辑:文婧

评论