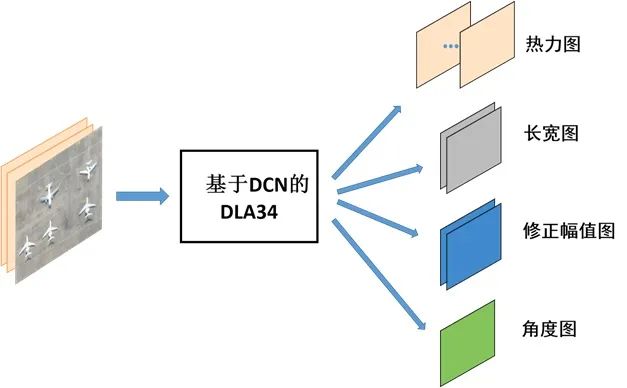

用CenterNet对旋转目标进行检测

极市导读

作者对CenterNet进行了部分修改,以此进行旋转目标检测。本文介绍了这种工作的代码、数据处理和样例,供读者参考。>>加入极市CV技术交流群,走在计算机视觉的最前沿

前言

代码

train.py:模型的训练

predict.py:模型的前向推理

backbone:模型的主干网,给了DLA和ResNet的DCN与普通版本,层数可以自定义

loss.py:模型的损失函数

dataset.py:模型的数据处理

数据处理

如何对旋转目标打标签? 如何将角度信息添加到VOC格式标签? 如何计算旋转IOU指标? 其它

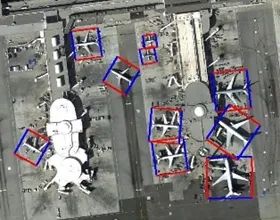

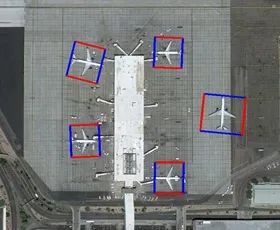

Demo

推荐阅读

评论