2018年BERT横空出世,带着碾压级的成绩刷榜各种NLP任务。

2019年,biobert,roberta,albert等各种BERT变体开始层出不穷,给传统的NLP任务带来了革命性的进展。

而谷歌作为BERT的本家,更是将它的优势发挥的淋漓尽致。

加入谷歌搜索刚一年,BERT「占领」几乎所有英语查询

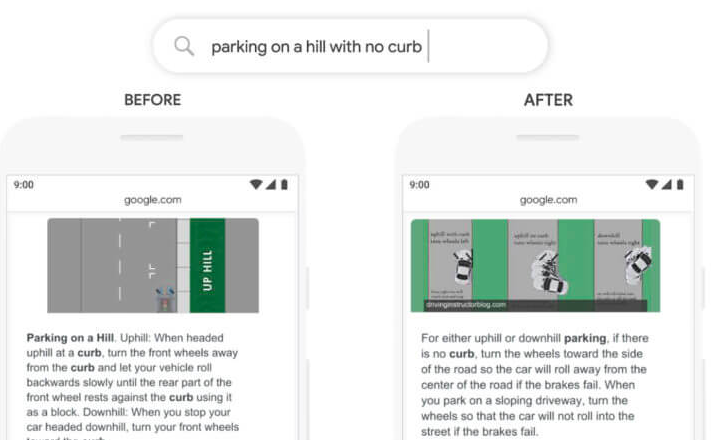

2019年10月,BERT首次亮相谷歌搜索时,这一比例仅为10%。2019年12月,谷歌将 BERT 的使用扩展到70多种语言。在最近的2020 Search On虚拟搜索大会上,谷歌表示,BERT几乎成了每一个英语查询的后端引擎。BERT不会影响网站的排名,BERT 的目的是更好地理解网页上的内容来提高搜索结果的相关性。下面是谷歌展示的集成BERT之后的一个demo,当查询「在没有路缘的山上停车」时,过去这样的查询会让谷歌的系统感到困惑。谷歌表示,之前的算法过于重视「curb」这个词,而忽略了「no」这个词,没有抓住这个词对于问题的重要性,所以搜索引擎会返回在有路缘的小山上停车的结果。工程师们已经将「特定搜索」的准确率提高了7% ,同时也在改善「更广泛搜索」的结果和答案。BERT替代RankBrain,晋升谷歌搜索算法「蜂鸟」头牌

BERT只是谷歌搜索算法的冰山一角,这个世界最强大的搜索工具,真可谓是一个Search Brain。谷歌把这个Search Brain称为「蜂鸟」,是一个搜索算法集装箱,就像一辆汽车有一个整体的引擎一样。各个算法就好比,发动机本身的机油滤清器、燃油泵、散热器等。蜂鸟还包含了其他部分,比如用于搜索引擎优化的,Panda、 Penguin 、 Payday ,打击垃圾邮件的Pigeon,以及大名鼎鼎的网页排名算法PageRank。而在BERT加入蜂鸟这个大家庭之前,最重磅的成员要属RankBrain了。2015年,RankBrain部署到了蜂鸟中,短短几个月时间,RankBrain 就迅速成长为搜索查询结果的第三重要的信号。RankBrain 利用人工智能将大量的语言嵌入到计算机可以理解的向量中,如果 RankBrain 看到一个它不熟悉的单词或短语,机器就可以猜测哪些单词或短语可能具有类似的含义,并对结果进行相应的过滤,使其更有效地处理从未见过的搜索查询,类似于我们今天熟知的词向量。参与了 RankBrain 项目的谷歌高级研究科学家 Greg Corrado 表示,RankBrain 是谷歌搜索算法系统中「数百个」信号之一,这些算法最终决定了谷歌搜索页面上出现什么结果。现在有了BERT的加持,「蜂鸟」能够更好地理解查询意图和内容相关性,成为了谷歌搜索理解语言的最重要信号。如果你拼错了什么,谷歌的拼写系统可以帮助你修改为正确的单词。据谷歌统计,在每十个日常搜索中,就有一个拼写错误,应用了BERT之后,这种手误就可以更好地纠正,比如下面这个dinner误输入为dibber,BERT能更好地理解搜索意图,直接返回了地图上的位置。BERT的突破来自谷歌transformer相关的研究成果,transformer可以更好地处理句子中所有单词的相关性,而不是按顺序逐个来。因此,BERT 模型可以查看单词前后的词语来考虑单词的整个上下文,这对于理解搜索查询背后的意图特别有用。但是,将BERT应用于搜索,不仅仅需要软件,也需要新的硬件,比如TPU。BERT 建立的一些模型非常庞大,突破了传统硬件的极限,所以要想应用,还得加上谷歌的云端TPU们。BERT将用户查询的问题拆解后转换为向量,通过将 BERT 模型找到更有用的信息。特别是对于更长的、更具对话性的查询,或者搜索介词如「for」和「to」对于查询的意义非常重要的情况,基于BERT的查询能够更全面地理解查询问题中各个单词的上下文,搜索的方式可以更加口语化,而不必刻意打「官腔」。BERT的核心组件transformer真是百变金刚,除了在各种NLP任务中刷榜,也应用到了计算机视觉当中,并且基于transformer的模型大有取代CNN的趋势。CV和NLP融合的多模态人工智能,也将登上AI的舞台。https://searchengineland.com/google-bert-used-on-almost-every-english-query-342193