终于有人把数据仓库讲明白了

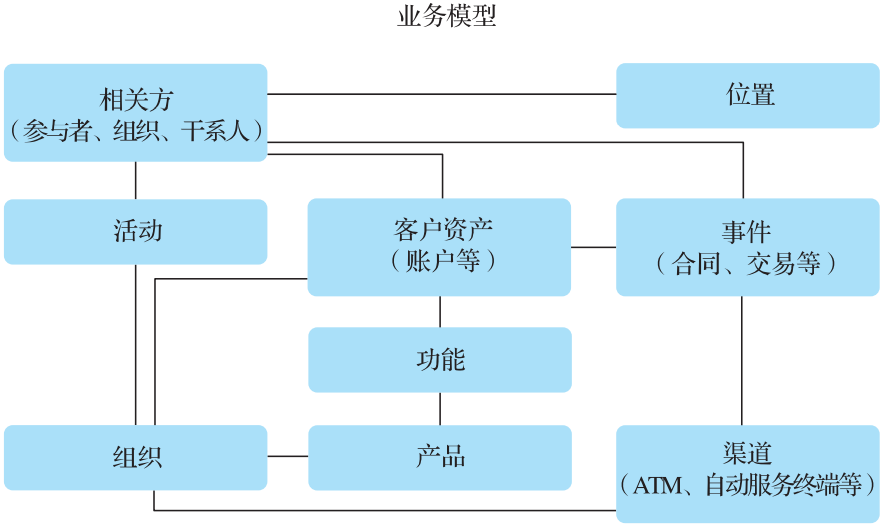

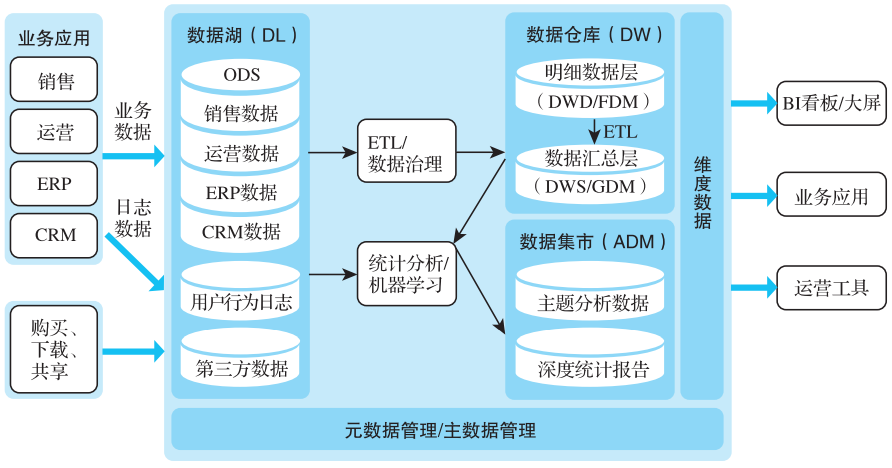

建立公司业务数据模型; 整合公司数据源,让清洗和治理之后的数据成为业务数据的唯一事实; 支持进行细粒度的、多维的分析,帮助高层管理者或者业务分析人员做出商业战略决策; 为更高一层的数据服务、机器学习应用提供主要的历史数据来源。

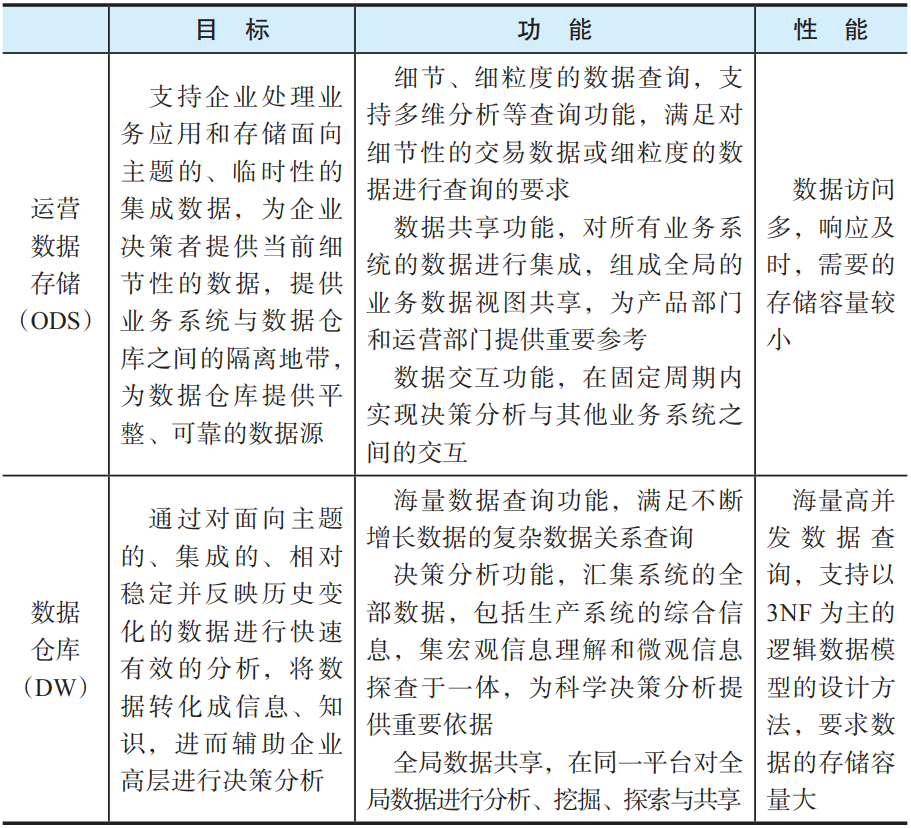

概念模型将业务抽象出来,实现对实际业务的数字化描述。 逻辑模型将概念模型进行结构化的设计,使其能够用于后续的分析和管理。 物理模型将逻辑模型映射到实际的物理存储上,例如数据库、表的设计。

比较直观和便于理解,一条事实表中的记录就可以还原一个业务流程的大部分信息; 处理复杂的查询效率较高,无须做大量会占用很多计算资源的join操作; 能够快速支持业务的变化和扩展,可以方便地添加新的业务模型及维度,而无须考虑复杂的依赖关系; 可以快速实施和见效,可以有针对性地选择业务场景落地然后再逐渐扩展。

其一,根据业务需求人工确定最常用的组合,例如,上面的表可以分为sales_by_channel_gender_age_income_referer_region和sales_by_channel_category_referer_region,如果业务部门有其他组合,可以使用即席计算来算一下,但无法做到实时交互了。 其二,使用Kylin这样的预计算和动态规划的Cube Planner。

第一,数据分散、杂乱,无法理解。很多企业业务线众多,数据源分散,且各系统间无法打通,成为信息孤岛;数据收集标准不相同,数据零散地存储在各个业务系统中,难以形成全局数据联动。 第二,数据收集渠道单一,模式落后,效率低,成本高。业务增长带来数据增长,传统数据管理模式难以应对大数据增长。从渠道上来说,传统数据收集渠道单一、落后、偏线下化;从方式上来说,很多企业收集信息的手段仍停留在手工收集阶段,效率低、成本高且造成数据不匹配。 第三,数据标准不统一,缺乏分析工具,数据难运用。一方面,数据标准不统一导致整合困难,难以进行全局联动;另一方面,缺乏数据分析工具,仅靠数据专业人才难以满足企业需求,且难以看到数据的实时变化及价值。这两方面的因素导致难以真正实现数据驱动业务发展,提升运营管理水平。 第四,系统落后,难以满足数据管理需求,存在数据风险隐患。在数据井喷式增长的当下,众多企业未能跟上随数据增长而变化的需求,难以满足监管要求,同时存在数据隐患及风险问题。

元数据管理:通过统一的元数据管理满足各类用户的数据资源使用需求,实现数据资产的可视化管理。 数据质量管理:通过数据质量控制方法,使得数据的采集、存储和使用符合相关的质量要求。 数据安全管理:保证数据不因偶然或恶意的原因而遭到破坏、更改或泄露,还包括数据访问权限控制、数据安全服务、数据访问审计等。 数据标准管理:为数据标准提供系统工具支撑,包括标准管理、标准展示、标准监控等功能。 元数据管理接口:提供元数据查询、数据加解密、数据资产注册接口和SSO接口。 数据管理门户:包括数据资产查询以及数据质量、数据安全、元数据和数据标准集成门户等。

基础类数据标准一般包括数据维度标准、主数据标准、逻辑数据模型标准、物理数据模型标准、元数据标准、公共代码标准等。 指标类数据标准一般分为基础指标标准和计算指标(又称组合指标)标准。基础指标一般不含维度信息,且具有特定业务和经济含义,计算指标通常由两个以上基础指标计算得出。

理解数据标准化需求; 构建数据标准体系和规范; 规划制定数据标准化的实施路线和方案; 制定数据标准管理办法和实施流程要求; 建设数据标准管理工具,推动数据标准的执行落地; 评估数据标准化工作的开展情况。

数据不完整,例如患者的属性中缺少性别、籍贯、年龄等。 数据不唯一,例如不同来源的数据出现重复的现象。 数据不权威,例如同一个指标出现多个来源的数据,且数值不一样。 数据不合法,例如获取的数据与常识不符,如年龄大于150岁。 数据不一致,例如不同来源的不同指标实际内涵是一样的。

数据完整性:直接补齐数据。没有办法直接补齐的,通过其他信息补全,例如使用身份证件号码推算性别、籍贯、出生日期、年龄等。还可以通过前后数据补全,例如时间序列缺数据,可以使用前后的均值;如果缺的数据较多,可以使用平滑等处理。 数据唯一性:去除重复记录,只保留一条。可以按数据库主键去重,也可以按规则去重。编写一系列规则,对重复情况复杂的数据进行去重,例如对于不同渠道来的客户数据,可以通过相同的关键信息进行匹配,合并去重。 数据的权威性:对不同渠道设定权威级别,用最权威的那个渠道的数据。 数据的合法性:设定强制合法规则,凡是不在此规则范围内的,强制设为最大值,或者判为无效并剔除。例如,字段类型合法规则中,日期字段格式为year-month-day;字段内容合法规则中,性别属于男、女或未知。 数据的一致性:建立数据体系,包含但不限于指标体系(度量)、维度(分组、统计口径)、单位、频度、数据。

降低高维度数据的维度:一般采用主成分分析法和随机森林法。 处理低维度数据:通过汇总、平均、加总、取最大值、取最小值、离散化、聚类、自定义分组等方法来抽象。 处理无关和冗余信息:剔除无关的和冗余的字段。 处理多指标数值:对多指标数值进行归一化,例如取最大/最小值、取均值等。

关于作者:彭锋,智领云科技联合创始人兼CEO。武汉大学计算机系本科及硕士,美国马里兰大学计算机专业博士,主要研究方向是流式半结构化数据的高性能查询引擎,在数据库顶级会议和期刊SIGMOD、ICDE、TODS上发表多篇开创性论文。2011年加入Twitter,任大数据平台主任工程师、公司架构师委员会大数据负责人,负责公司大数据平台及流水线的建设和管理。

宋文欣,智领云科技联合创始人兼CTO。武汉大学计算机系本科及硕士,美国纽约州立大学石溪分校计算机专业博士。曾先后就职于Ask.com和EA(电子艺界)。2016年回国联合创立智领云科技有限公司,组建智领云技术团队,开发了BDOS大数据平台操作系统。

孙浩峰,智领云科技市场总监。前CSDN内容运营副总编,关注云计算、大数据、人工智能、区块链等技术领域,对云计算、网络技术、网络存储有深刻认识。拥有丰富的媒体从业经验和专业的网络安全技术功底,具有超过15年的企业级IT市场传播、推广、宣传和写作经验,撰写过多篇在业界具有一定影响力的文章。

本文摘编自《云原生数据中台:架构、方法论与实践》,经出版方授权发布。

评论