你了解如何评估模型吗?

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

本文转自:机器学习算法工程师

在不同的任务进行评估时,都需要不同的指标进行评估,本文主要给大家简单介绍评估方法。

准确率是指分类正确的样本占总样本数的比例,即

准确率是分类问题中直观的评价指标。但是当负样本占比比较高时,这时候分类器要是把所有样本都预测为负样本,他就更容易获得更高的分数,这也说明了当样本占比不均匀时,此时准确率作为评估指标会对结果有影响。那么怎么解决呢,可以通过平均准确率,即计算每个类别下的样本的准确率的算术平均。

精确率是指分类正确的正样本个数占分类器判定为正样本的样本个数的比例。

排序问题中,通常采用TopN的结果作为模型预测的正样本, 然后在计算其Precision和Recall。而Precision和Recall是矛盾又统一的指标,为了提高Precision,这时候,分类器要更有把握时才把样本预测为正样本,就会导致会过滤掉一些分数低一点的正样本,从而导致Recall值降低。

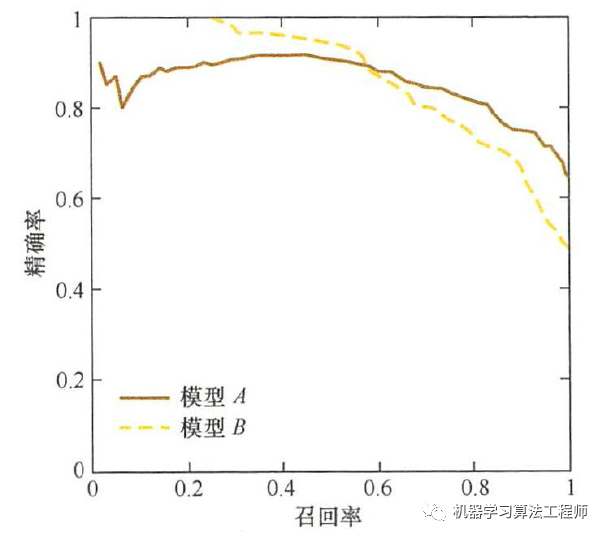

所以为了更好的评估一个模型的好坏,可以通过P-R曲线。

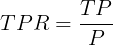

P-R曲线横轴是召回率(Recall),纵轴是精确率(Precision),对一个排序模型来说,曲线上的一个点代表某阈值下将大于阈值的结果判定为正样本,小于阈值的判定为负样本,此时返回结果对应的召回率和精确率,整个曲线通过将阈值从高到低移动生成,如下图:

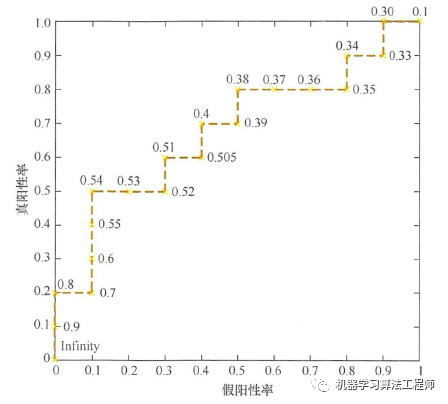

由图可见,随着召回率的升高,模型A精确率下降并没有B那么快,只用曲线某个点不能全面衡量模型的性能,需要通过曲线的整体表现。

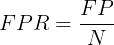

ROC曲线经常被用作为二值分类器最重要的指标之一。其横坐标为假阳性率(FPR),纵坐标为真阳性率(TPR),他们的计算公式如下

其中,P是真实的正样本的数量,N是真实的负样本的数量,TP是P个正样本中被分类器预测为正样本的个数,FP是N个负样本中被分类器预测为正样本的个数。

通过动态调整阈值(区分正负预测结果的阈值),每个阈值都对应一个FPR和TPR,在ROC曲线上对应一个点,连接所有点就得到ROC曲线,如下图:

那么ROC曲线和P-R曲线有什么区别呢?

当正负样本分布发生变化时,ROC曲线的形状基本保持不变,而P-R曲线的形状一般发生较剧烈的变化,如下图,c和d是将测试集中负样本数量增加10倍后的曲线图,可以看出ROC曲线形状基本不变,这让ROC曲线能够降低不同测试集带来的干扰,客观衡量模型本身性能,不受正负样本不均匀的影响。

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~