如何看Meta发布的全新大模型 LLaMa 2?免费商用又如何快速用起来?

01

引言

Facebook母公司Meta上周(7.19)发布了新一代可商用大语言模型LLaMa 2,可以说是迄今为止ChatGPT最强大的开源竞争对手。LLaMa 2因为性能强劲,关键是完全免费商用,其对大模型行业的格局也势必产生较大影响。

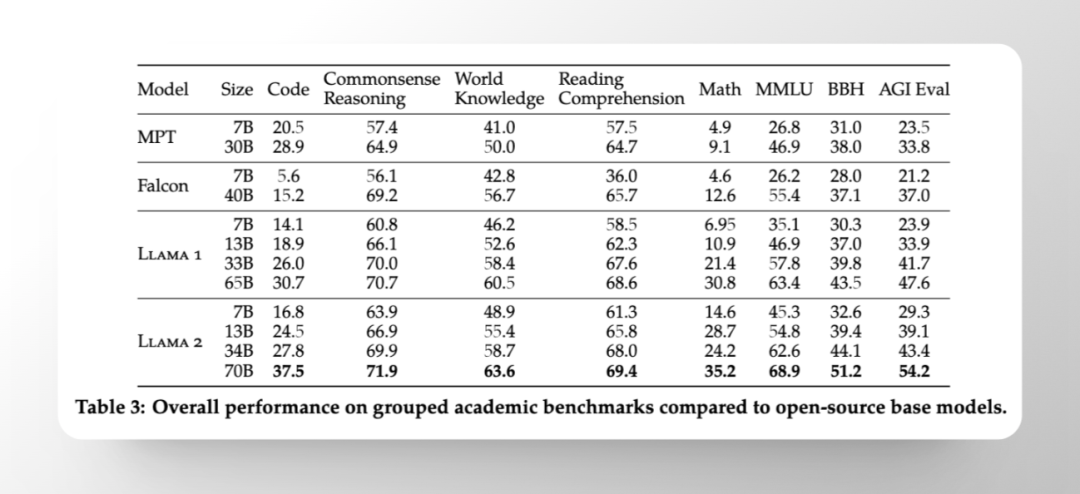

LLaMa 2对比其他开源模型均有明显胜出

LLaMa 2对比其他开源模型均有明显胜出不光开源了模型,Meta还写了一篇76的paper,把各种细节都讲的清清楚楚,相比 OpenAI,这是真的开放!建议大家去阅读(下一篇会分享一个翻译插件帮助大家阅读),复制下面地址下载即可:https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

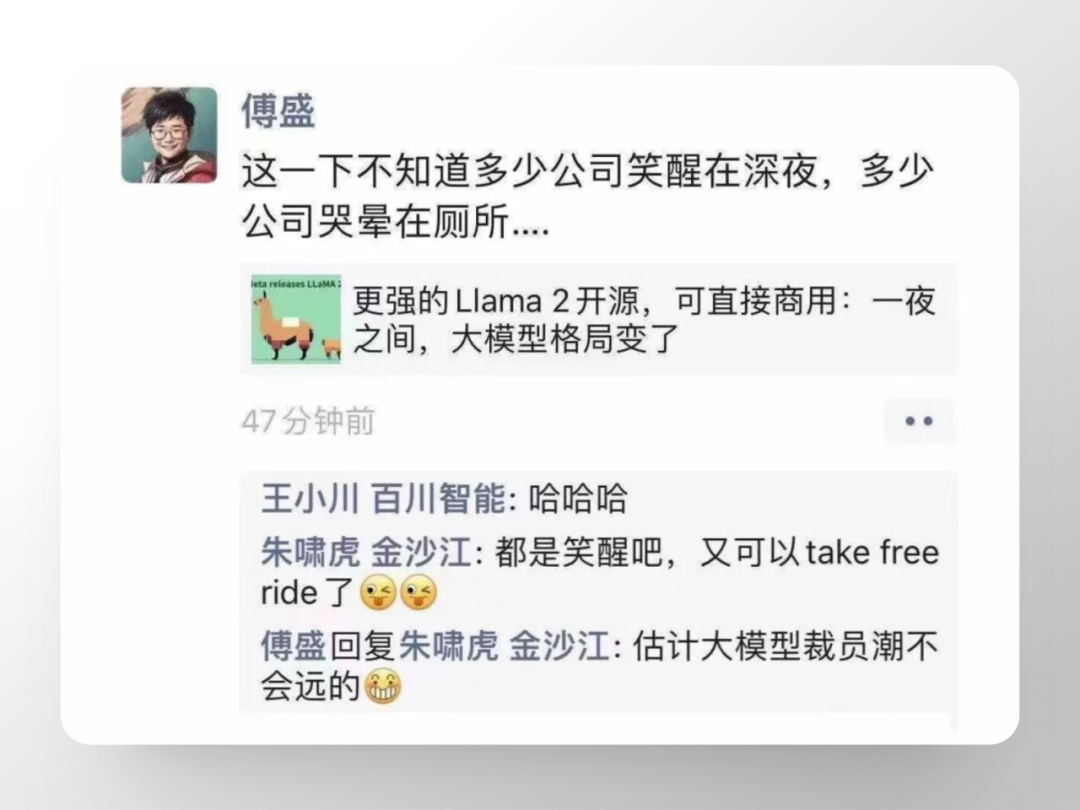

LLaMa 2推出当天,傅盛和朱啸虎就又在朋友圈开始了据6月份后的第二次斗嘴。大模型行业到底是该笑呢,还是哭呢?很有意思。

反正作为应用层和消费者,我们肯定是乐得一笑的。并且,据LLaMa 2文档明确表示,直到你的产品月活跃用户达到7亿,商业使用LLaMa 2都是免费的。这将是多么令人兴奋的一件事,可以相信未来就是人手一个专属的LLM。

要知道现在单纯国内就是千模大赛,LLaMa 2出来以后,想想大多数的处境都会比较尴尬,甚至被排死在沙滩上。除非Top几家因中文语料比较丰富的,中文模型效果更为突出,或者是垂直模型另说。因为一个行业不仅应用层不需要重复造轮子,大模型行业也同样如此。

02

LLAMA 2的参数和训练

1、LLaMa2 的性能和参数

对于LLaMa2 的性能和参数,官网上(ai.meta.com/llama)介绍得很详细也很清楚:

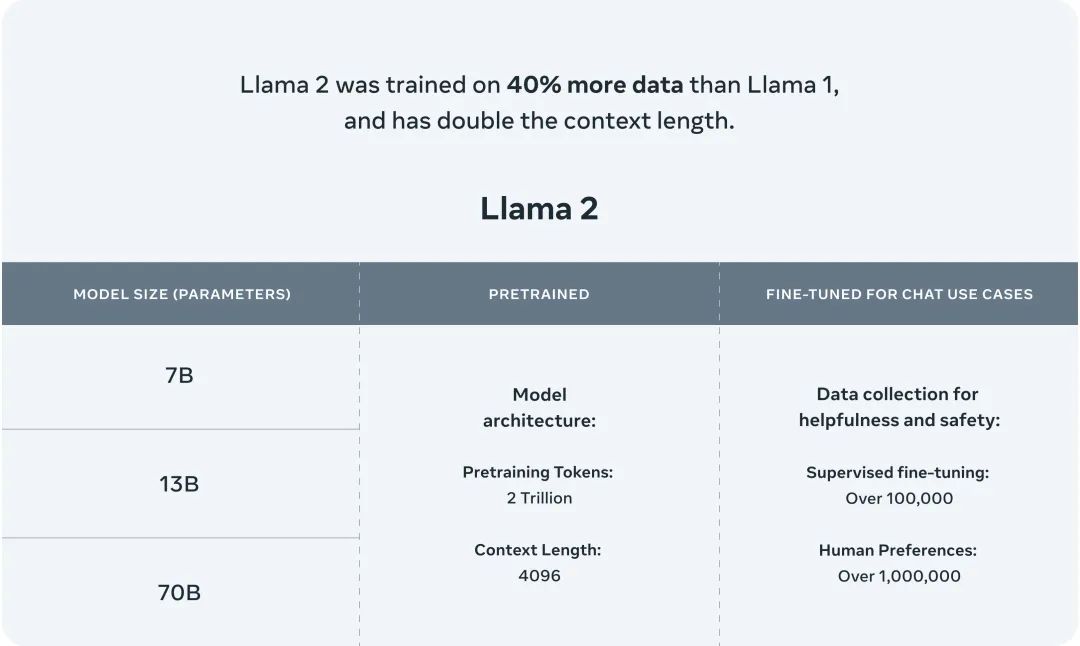

- LLaMa2 的训练数据比LLaMa 1 多 40%,上下文长度是LLaMa 1 的两倍。

- LLaMa2有大小三个版本分别是7B 13B和70B。

- 预训练的Token为2 万亿,上下文长度为4096。

- 据Meta所说,LLaMa2在许多外部基准测试中都优于其他开源语言模型,包括推理、编码、熟练程度和知识测试。

2、LLaMa2 的模型架构

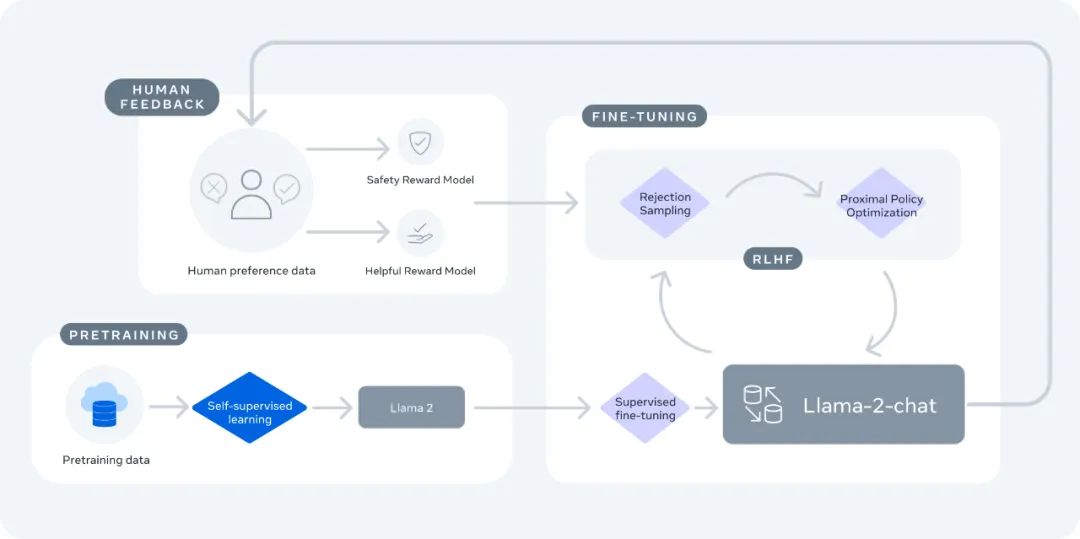

- LLaMa2-Chat 的基础是 LLaMa2 系列预训练语言模型。LLaMa2使用标准的Transformer架构。

- LLaMa2-Chat 通过监督微调和强化学习人类反馈进行了优化。先进行监督微调,然后应用包括拒绝采样和PPO在内的强化学习算法进行迭代改进。

- 采用了一些优化,比如预规范化、SwiGLU激活函数和旋转位置嵌入(RoPE)。

- LLaMa2-Chat有70亿、34亿、13亿和7亿参数的版本。训练使用公开可获得的数据,没有使用任何Meta用户数据。

3、LLaMa2 的训练方法论

1)预训练

- 使用公开可获得的在线数据进行预训练,总计2万亿个标记。

- 对数据进行了清洗,移除了一些包含大量个人信息的网站。

- 采用标准的Transformer架构,以及一些优化如RoPE等。

2)监督微调

- 使用高质量的人工标注数据(约3万示例)进行监督微调。

- 优化回答标记,而不是提示标记。

3)基于人类反馈的强化学习

- 收集人类偏好数据: letting人类比较并选择更好的回复。

- 训练奖励模型,给回复打分。

- 使用拒绝抽样和PPO算法进行迭代调优。

4)安全性

- 收集安全/有帮助的数据进行监督微调。

- 训练独立的安全性奖励模型。

- 使用内容蒸馏等方法增强安全性。

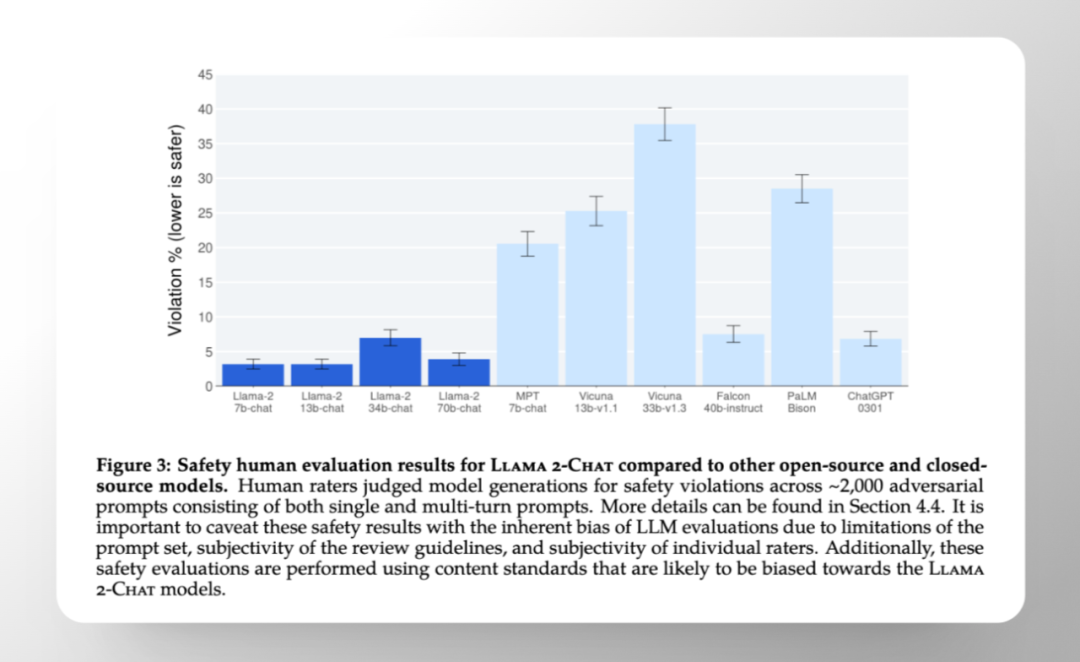

在模型安全性方面,LLaMa2 可以说是一骑绝尘,一举超越了 ChatGPT。事实上,开源模型的安全大多都很糟糕,通过下图量化对比你能知道它们会有多差。

4、关于代码能力

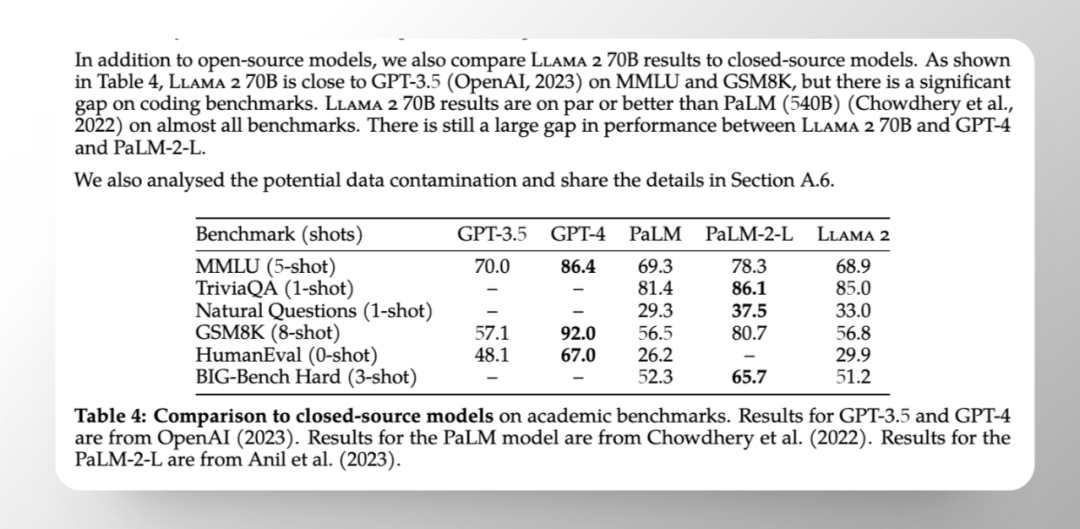

官方使用了 human evel 作为测试。官方说得很明白,LLaMa2和 GPT3.5 还是有「显著的差距」。具体得分 LLaMa2 29.9,GPT3.5 48.1,GPT4 67 。同时也能看到 PaLM-2 的各项指标也都不错,是比 LLaMa2要强的。

5、评估

- 在4K提示上进行有用性人类评估,与ChatGPT等旗鼓相当。

- 在2K提示上进行安全性人类评估,优于多个基准模型。

6、如何申请模型使用

- 与 LLaMa1 版本不同,这次Meta开放了商业使用的权限。

- 现在可以直接在这个页面申请下载模型使用:https://ai.meta.com/resources/models-and-libraries/llama-downloads

- 日活大于7亿的产品需要单独申请商用权限

- 不得使用 LLaMa 材料或 LLaMa 材料的任何输出或结果来改进任何其他大型语言模型。

03

如何使用LLAMA 2?

LLaMa 2作为全新的开源大模型,不用购买 IP,就能免费使用。除了在官网申请模型使用外,以下是几种能够快捷体验到用 LLaMa 2 进行 Chat 聊天的方法:

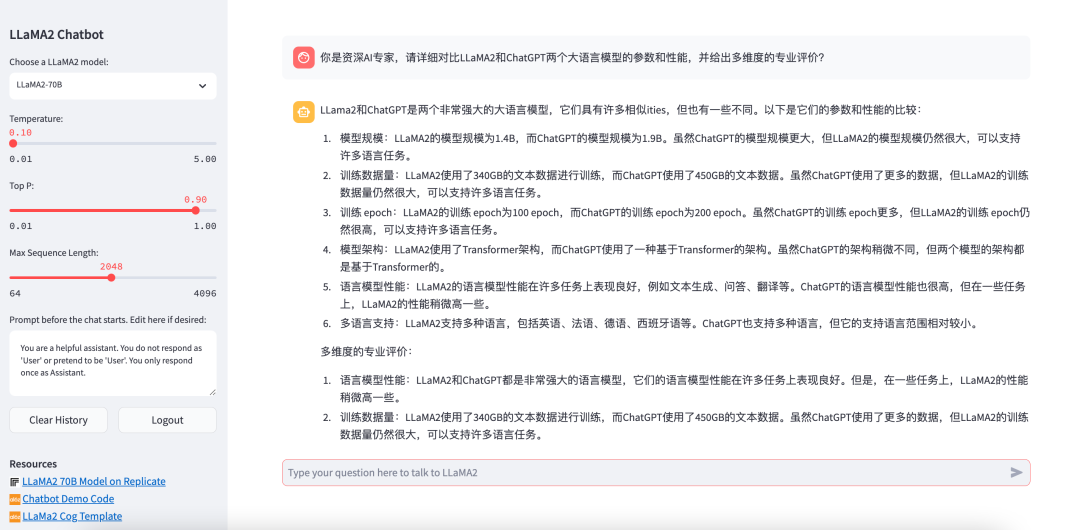

1、llama2.ai

国内用户就可以直接访问,轻松注册后就可以正常使用。左侧列表支持选择具体模型(70B/13B/7B),设定Temperature、Top P以及Max Sequence Length,这些参数主要是调优prompt对话效果的,后面讲prompt工程训练时我们再介绍。当然对于一些问题还是能看出来它在一本正经瞎说,大家要留心辨认。

国内用户就可以直接访问,轻松注册后就可以正常使用。左侧列表支持选择具体模型(70B/13B/7B),设定Temperature、Top P以及Max Sequence Length,这些参数主要是调优prompt对话效果的,后面讲prompt工程训练时我们再介绍。当然对于一些问题还是能看出来它在一本正经瞎说,大家要留心辨认。2、在Hugging Chat 上使用LLaMa 2

在 huggingchat 上最大的亮点是支持连网功能-search web。这点比较强大能够获得很多实时性语料内容。该站使用的模型是LLaMa/LLaMa2 70B,使用 LLaMa2 的地址:https://huggingface.co/chat/

3、perplexity AI chat

使用地址:llama.perplexity.ai,目前还是13B的模型,70B还要等等。

4、 当然还有我一直推荐的poe.com 或者 poe 客户端

LLaMa 2Chat 整体的体验都还不错,从用户体验来看和 ChatGPT (GPT3.5) 确实差别不明显。不过有时候他的回答默认是英文,还需要你再让他翻一下。

总之,Meta 发布的 LLaMa 2 大模型整体还是非常强大的。参数量级和性能效果足以吊打很多大模型,关键还可以免费商用,直到你的产品月活 7 亿。可以说,LLaMa 2 势必会对大模型行业产生较大影响,尤其是大模型创业。即便是安全性略逊,LLaMa 2 也是很多小微企业开始 AI 应用层训练的起点和支撑。具体影响还让我们拭目以待!

关于 LLaMa 2,你有什么想聊的也欢迎留言讨论~

...................END...................

hello,我是阿外,10 年+PM&Designer,AGI领域研究者。欢迎关注「波悟馆」(bo_club),也可以加我微信,申请加入读者群,和更多小伙伴一起学习,共同成长。

推荐阅读

如果你觉得文章对你有帮助,请记得一定要点下面👇的「分享」、「赞」和「在看」。