Calibration: 一个工业价值极大,学术界却鲜有研究的问题!

点击上方“AI算法与图像处理”,选择加"星标"或“置顶”

重磅干货,第一时间送达

导读

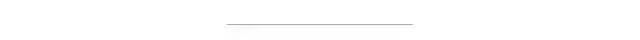

在实际的工业应用中,当模型的准确性无法达到预期的标准时,通常思考采用提高模型决策的阈值。而这种方法在神经网络上不一定适用。本文介绍了一篇来自2017年的ICML顶会论文,关于让模型的softmax输出能真实的反映决策的置信度,也就是Calibration问题。

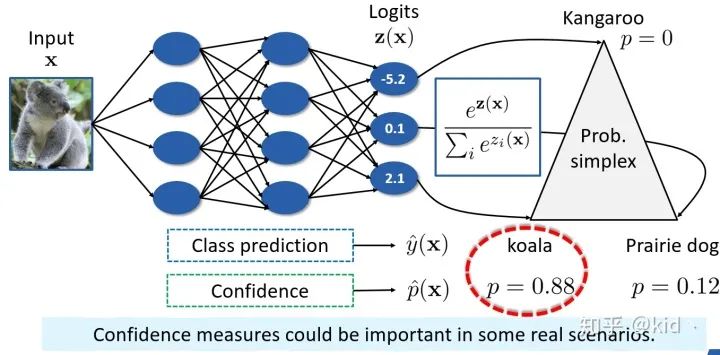

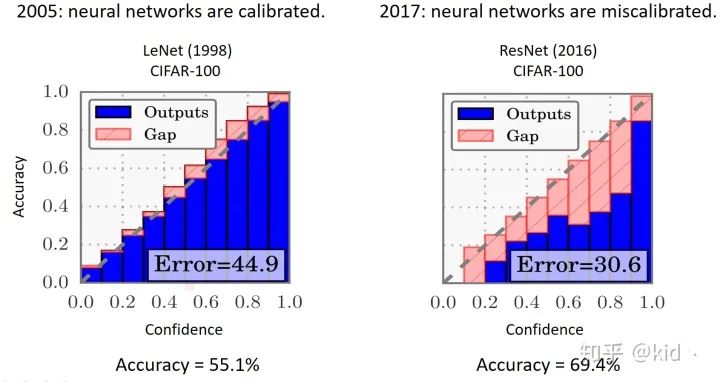

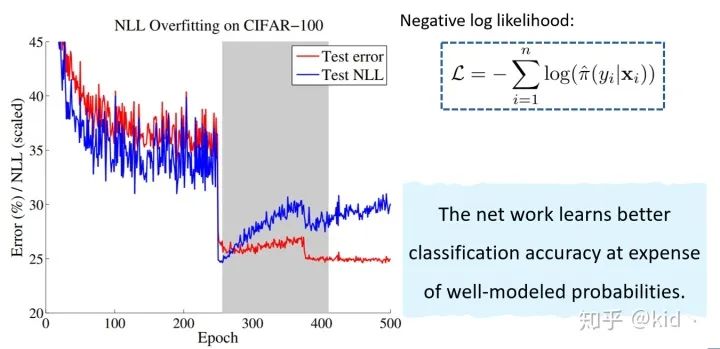

神经网络的 overconfidence

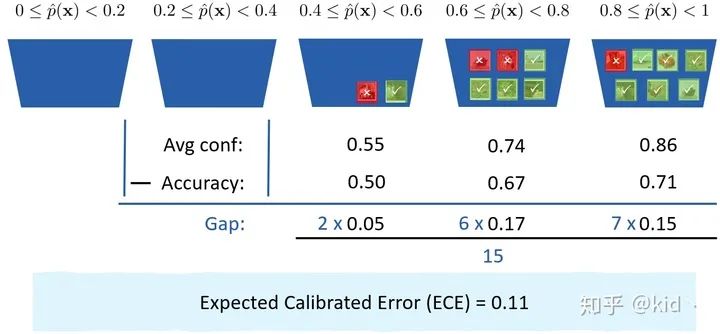

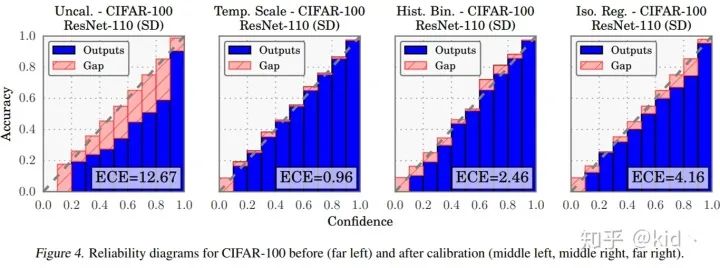

预期校准误差(ECE)

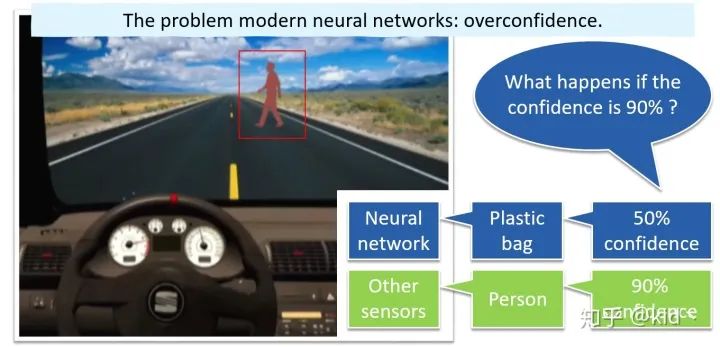

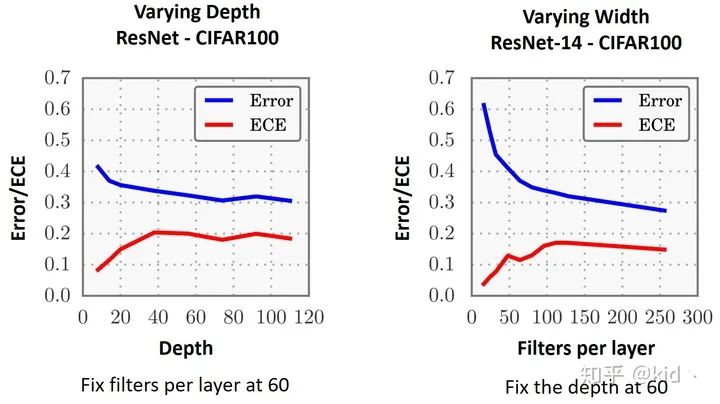

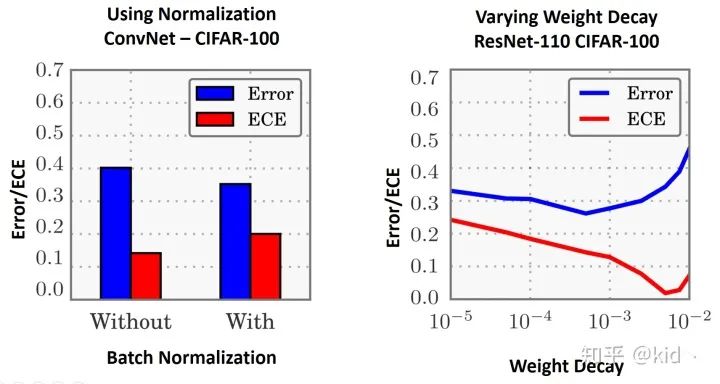

什么原因导致神经网络出现准确率与置信度不匹配?

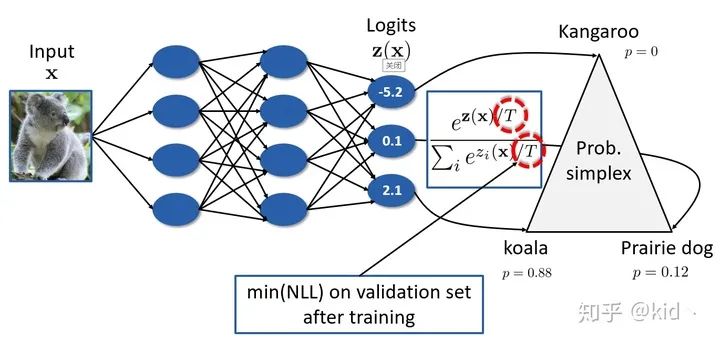

我们该如何对模型进行校准呢?

讨论

模型的置信度应当是和准确率匹配的,这样的模型我觉得才是有意义的,否则以很高置信度进行很离谱的预测错误的模型会让人感觉这个模型好像什么都会、又好像什么都不会。 ECE 的指标是否能反应样本的一些性质,例如难易程度、是否为噪声等。 该文章是间接的去优化ECE的,能否有直接优化的形式,或者主动学习里面能否考虑这一点来挑选样本?

下载1:何恺明顶会分享

在「AI算法与图像处理」公众号后台回复:何恺明,即可下载。总共有6份PDF,涉及 ResNet、Mask RCNN等经典工作的总结分析

下载2:终身受益的编程指南:Google编程风格指南

在「AI算法与图像处理」公众号后台回复:c++,即可下载。历经十年考验,最权威的编程规范!

下载3 CVPR2020 在「AI算法与图像处理」公众号后台回复:CVPR2020,即可下载1467篇CVPR 2020论文 个人微信(如果没有备注不拉群!) 请注明:地区+学校/企业+研究方向+昵称

觉得不错就点亮在看吧

评论