深度图像修复的一个突破

来源:AI公园 本文约4000字,干货满满,建议阅读6分钟

本文介绍了如何使用上下文注意力来进行深度图像修复。

回顾

动机

介绍

方案

贡献

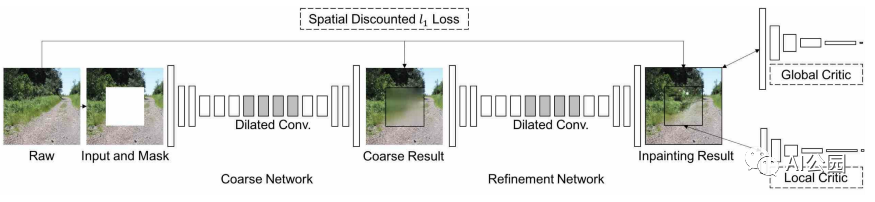

方法

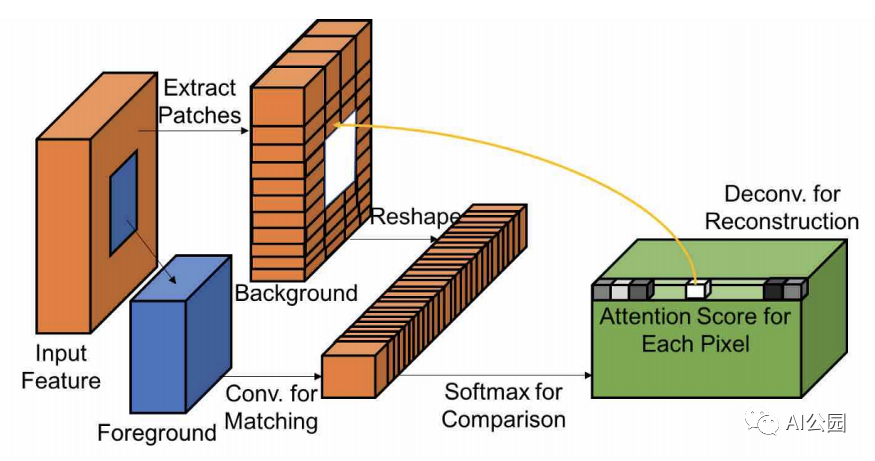

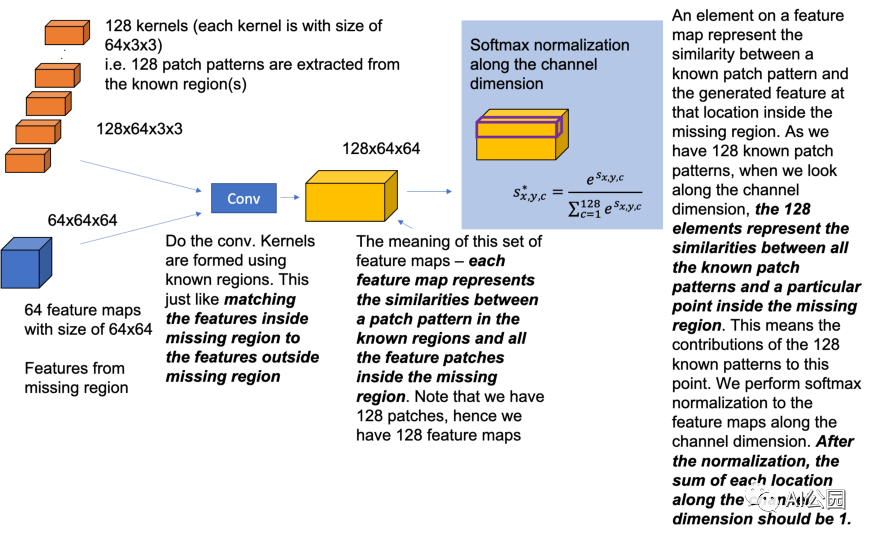

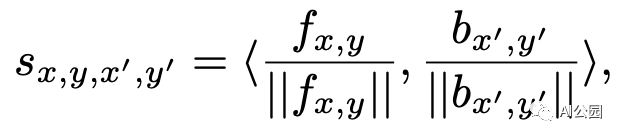

上下文注意力

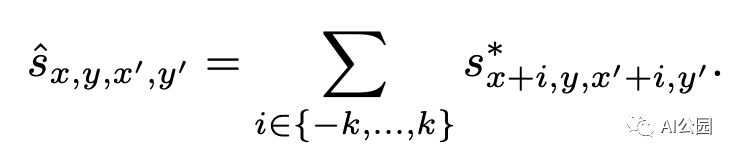

与上一篇文章中提到的Shift-Net相比,你可以看到,这一次我们给每个已知特征的patch分配了权重,来表示重建的时候每个特征位置对于缺失区域的重要性(软分配),而不是对于缺失区域的每个位置找一个最相似的(硬分配)。这也是为什么提出的上下文注意力是可微的。

注意力传播

以较大的步长提取已知的特征patch,以减少kernel数量。

操作前先对特征图大小进行向下采样,获取注意力图后再进行上采样。

网络中的注意力

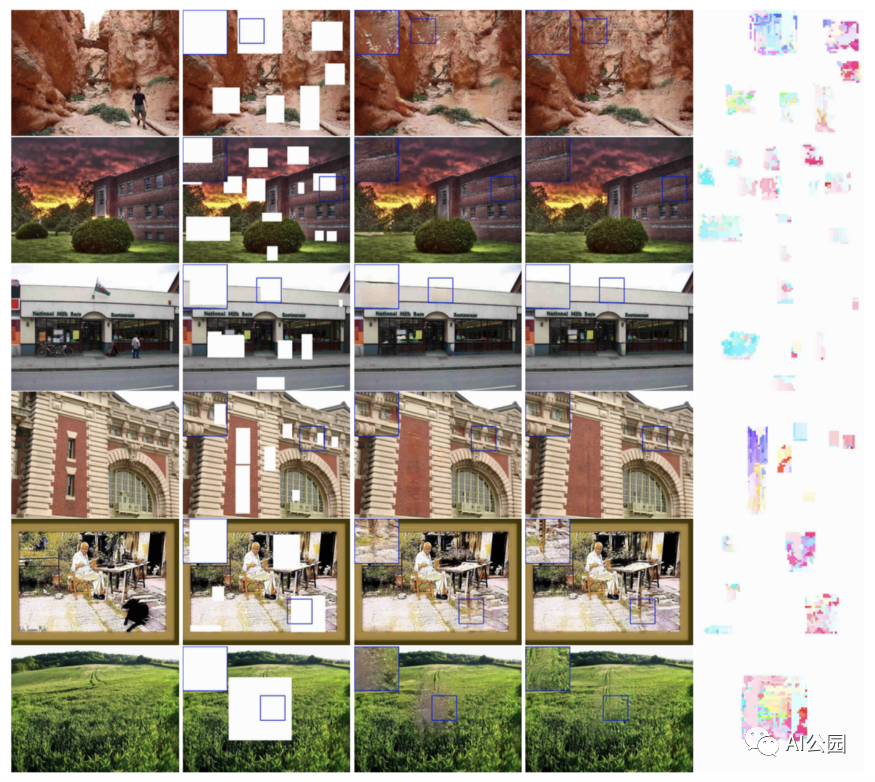

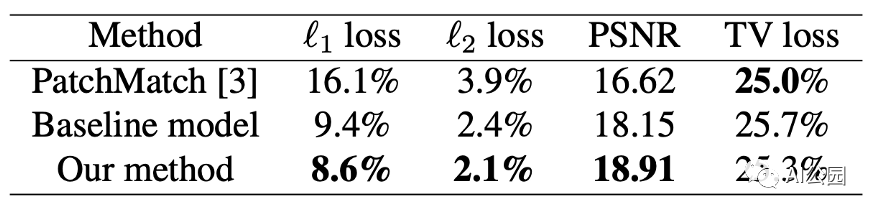

实验

消融研究

总结

要点

英文原文:

https://towardsdatascience.com/a-breakthrough-in-deep-image-inpainting-review-generative-image-inpainting-with-contextual-1099c195f3f0

编辑:王菁

校对:汪雨晴

评论