ICLR 2021杰出论文奖公布,8篇论文入选!获奖华人一作14岁保送清华

本文授权转载自AI科技评论

就在昨日,ICLR 在推特上官宣了 ICLR 2021 杰出论文奖获奖名单。本次获奖从860篇卓越论文中选拔,其中获得杰出论文奖的工作高达 8 篇!

8篇获奖论文中,华人一作论文有3篇(如下,获奖论文1、7、8)。

其中,获奖工作1的一作 Aston Zhang 是《动手学深度学习》的作者之一,其余作者有李沐、Alex Smola、Zack Chase Lipton等人。Aston Zhang 博士毕业于UIUC,目前在亚马逊担任高级科学家。

图注:Aston Zhang

图注:《动手学深度学习》封面

获奖论文8的一作宋飏14岁保送清华大学,本科就读于数学物理专业,曾跟随朱军等人做研究,后在2016年赴斯坦福大学攻读计算机科学博士,导师为Stefano Ermon。

图注:宋飏

获奖论文7的一作 Ruochen Wang,本科期间从上海财经大学转到密歇根大学计算机科学与统计学专业,目前在UCLA攻读CS硕士。

图注:Ruochen Wang

值得一提的是,在这8篇获奖论文中,并不是所有的论文都是Oral评级,还有两篇论文是Spotlight评级。论文主题涉及参数化、复杂查询、PCA的博弈论形式、物理模拟、双耳声音合成、SGD收敛性、神经架构搜索、基于得分的模型等。

另外,需要说明的是,去年ICLR 2020并没有评选杰出论文奖,而今年高达8篇杰出论文并不是对去年未评选的补偿,它更有可能是大会评委的进步,照顾到了机器学习社区中一直以来大家对每年最佳论文/杰出论文太少或论文选拔领域不公平的一个呼声。

获奖名单(按字母顺序)

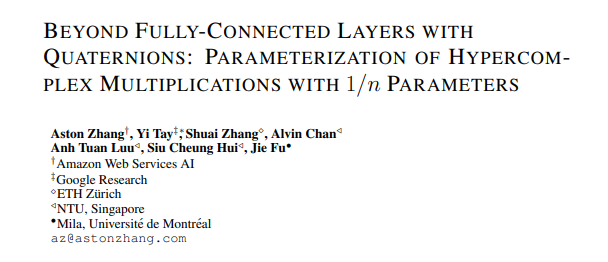

获奖论文一(spotlight):

论文链接:https://openreview.net/forum?id=rcQdycl0zyk

一句话总结:

与全连接层相比,本文提出使用任意1 / n个可学习参数对超复杂乘法进行参数化。

程序主席评价:

作者等人提出了一种新的参数化方法,能够跨多个体系结构泛化超复杂的乘法运算,并在节省大量参数的情况下提供较小的低维强大性能。所有审稿人都对这项工作的理论贡献感到满意,但也希望能获得更多的经验证据。

论文摘要:

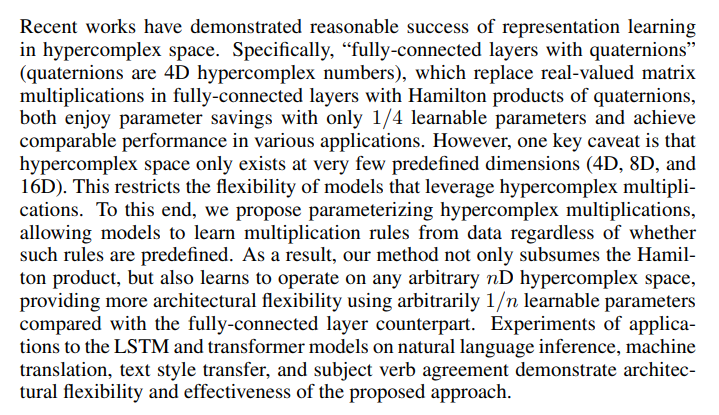

获奖论文二(oral):

论文链接:https://openreview.net/forum?id=Mos9F9kDwkz

一句话总结:

本文展示了如何通过神经连接预测变量回答其子查询,通过t范数和t-conorm汇总结果,以及通过求解优化问题来确定最佳变量替代(optimal variable substitutions)的方式,来回答复杂查询。

程序主席评价:

审稿人一致认为这篇论文非常值得被接收。它在提升查询关系嵌入模型的能力上取得了重要进展。

论文摘要:

获奖论文三(oral):

论文链接:https://openreview.net/forum?id=NzTU59SYbNq

程序主席评价:

本文介绍了一种关于PCA的新颖的博弈论观点,该观点产生一种能够以分散的方式评估奇异矢量的算法(EigenGame; 算法2)。根据其在大规模数据集(ResNet-200激活)上的实验显示,该算法的可伸缩性表现突出。论文条理清晰,特别是第2节,提供了关于PCA博弈论重构的易于理解的推理。

在他们的博弈论重构中,我发现了一个有趣的点:在(6)所示的效用函数中,正交约束 被移除,取而代之的是表示为正则化项的软约束,以此鼓励正交性。尽管正则化项的其他几种替代形式也许是可行的,但正是文中所提出的这种特殊形式能够带来有效的梯度上升算法,无需显式正交归一化,或者矩阵求逆可直接并行化。

被移除,取而代之的是表示为正则化项的软约束,以此鼓励正交性。尽管正则化项的其他几种替代形式也许是可行的,但正是文中所提出的这种特殊形式能够带来有效的梯度上升算法,无需显式正交归一化,或者矩阵求逆可直接并行化。

优点:

提供PCA的一种新颖博弈论形式。 基于博弈论重构,提出了PCA的顺序算法和分散算法。 为顺序算法的全局收敛提供理论保证。 证明所提出的分散算法可扩展到大规模问题。

缺点:

定理4.1的后半部分陈述需要关于初始化的条件,这些条件在高维设置中很难满足。 在博弈论背景下,文中提到的博弈论公式意义没有被充分探索。

论文摘要:

获奖论文四(spotlight):

论文链接:https://openreview.net/forum?id=roNqYL0_XP

一句话总结:

本文介绍了一种在网格上准确高效地学习复杂物理系统动力学的通用方法。

程序主席评价:

本文提出了一种利用图神经网络进行网格物理模拟的方法。这将专注于网格或粒子的最新工作扩展到基于网格的域,这项工作由于不规则且可能会改变的连接性而具有挑战性。审稿人有一些担忧,但知晓这是一项重要的工作,将引起广泛关注,并可能产生重大影响。

论文摘要:

获奖论文五(oral):

论文链接:https://openreview.net/forum?id=uAX8q61EVRu

一句话总结:

我们提出了一个端到端的方法神经双耳声音合成,第一次优于基于 DSP 的方法在定性评估和感知研究。

程序主席评价:

从移动单音频进行双耳合成的有趣方法。 很好地解释了为什么L_2不是双耳重建的最佳损失。 有趣的架构选择,效果不错。 很好的动机和清晰的想法——特别是在回复了审稿人的评论之后。

我同意关于标题的修改意见。虽然我认为它暗示了声源可能是单个的,但明确的表述会让那些不太紧密相关的主题中工作的人更清楚。因此,“从单声道音频的双耳语音的神经合成”的建议听起来相当合理。

论文摘要:

获奖论文六(oral):

论文链接:https://openreview.net/forum?id=PULSD5qI2N1

论文介绍:

本文分析了用于回归问题的超参数化两层神经网络的平均随机梯度下降(SGD)的收敛性。最近研究发现,神经正切核(NTK)在显示NTK体制下基于梯度方法的全局收敛中起着重要作用,其中过参数化神经网络的学习动力学(learning dynamics)几乎可以通过相关的再生核希尔伯特空间(RKHS)的学习动力学来表征。

但是,在NTK体制中,仍有进行收敛速度分析的空间。在这项研究中,我们表明,通过利用目标函数和与NTK相关的RKHS的复杂性,平均SGD下降可以达到最小最大最优(minimax optimal )收敛速度,并且具有全局收敛性保证。此外,我们表明,在一定条件下,通过ReLU网络的平滑逼近,可以以最佳收敛速率学习ReLU网络的NTK指定的目标函数。

一句话总结:

这是第一篇以克服技术挑战、实现最佳收敛速度下的NTK制度的论文。

程序主席评价:

本文给出了超参数化两层神经网络平均SGD收敛性的一些令人激动人心的结果。AC和评审们都同意这些贡献是非常重要的。同时要感谢作者对评审的反馈:对假设和参考文献作了相应的修改,并在论文介绍中增加了简化的命题论点,使原稿有了很好的改进。

论文摘要:

获奖论文七(oral):

论文链接:https://openreview.net/forum?id=PKubaeJkw3

程序主席评价:

本文提出了一种新的选择范式,用于在神经架构搜索(NAS)中选择最佳架构,特别是针对涉及单样本模型并部署基于梯度的搜索方法的方法。基本上,本文着重于非常仔细地检查最大选择(max selection),并发现架构权重的大小具有误导性。取而代之的是,本文提出了更为直观的最终确定步骤,选择当边被去除的时候验证性能下降幅度最大的算子。所有审稿人都认为这个想法很有趣,论文写得也很好,而且论文中的结果也很有趣。此外,作者的回答令人满意地解决了审稿人提出的大多数问题,并且大多数rebuttal都增加了他们的原始评分。因此,我建议接受。

论文摘要:

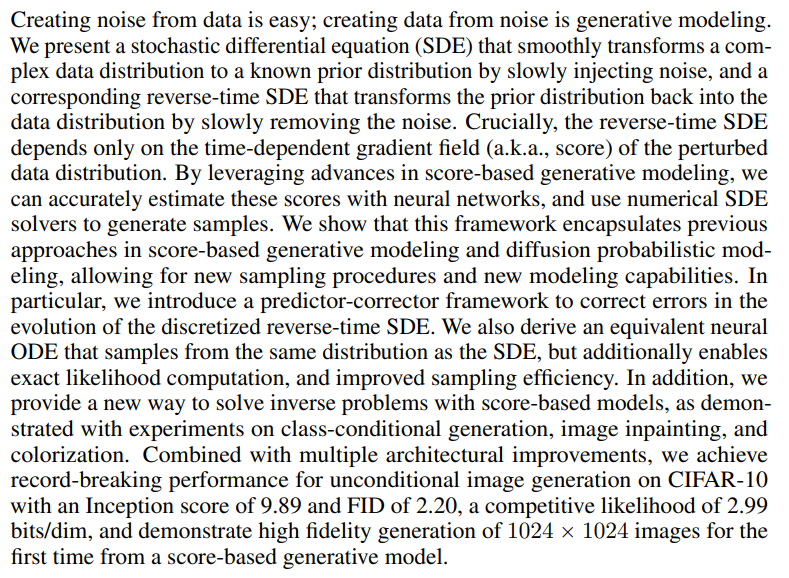

获奖论文八(oral):

论文链接:https://openreview.net/forum?id=PxTIG12RRHS

一句话总结:

用于从基于得分的模型进行训练和采样的通用框架,该框架统一并泛化了先前的方法,允许进行似然计算,并实现可控的生成。

程序主席评价:

所有审稿人都同意,这是一篇写得很好且有趣的论文,ICLR和更广泛的ML社区都会感兴趣。

论文摘要:

杰出论文评选标准

1、在论文评审的基础上构建候选论文的候选名单;

2、入围的论文送交杰出论文委员会作进一步评审;

3、评审专家们不仅要评估技术质量,还要评估论文潜在的影响力,包括提出新的观点、开辟令人激动兴奋的新方向、为解决一个重要问题作出了重大贡献;

4、排名最高的8篇论文被选为获奖论文。

杰出论文奖评选委员

参考链接: