一篇文章浅析Python自带的线程池和进程池

回复“书籍”即可获赠Python从入门到进阶共10本电子书

前言

大家好,我是星期八。

我们都知道,不管是Java,还是C++,还是Go,还是Python,都是有线程这个概念的。

但是我们知道,线程是不能随便创建的,就像每招一个员工一样,是有代价的,无限制招人肯定最后各种崩溃。

所以通常情况下,我们会引出线程池这个概念。

本质就是我就招了几个固定的员工,给他们派活,某一个人的活干完了再去任务中心领取新的活。

防止任务太多,一次性招太多工人,最后系统崩溃。

开心一刻

理想的多线程

实际的多线程

from concurrent.futures import ...

可能也是因为线程池这个东西用的越来越多了吧,从Python3.2+之后,就成了内置模块。

对的,直接就能使用,不需要pip进行安装什么的。

concurrent.futures下面主要有俩接口。

ThreadPoolExecutor线程池。ProcessPoolExecutor进程池。

这里可没有什么所谓的异步池。

个人看法:虽然异步的性能很高,但是目前除了Go以外,其他实现的都不是太好,用法上面有些怪异,当然,你们可以说我菜,我承认。

线程池

示例代码

import timefrom concurrent.futures import ThreadPoolExecutorimport random# max_workers表示工人数量,也就是线程池里面的线程数量pool = ThreadPoolExecutor(max_workers=10)# 任务列表task_list = ["任务1", "任务2", "任务3", "任务4", ]def handler(task_name):# 随机睡眠,模仿任务执行时间不确定性n = random.randrange(5)time.sleep(n)print(f"任务内容:{task_name}")if __name__ == '__main__':# 遍历任务,for task in task_list:"""交给函数处理,submit会将所有任务都提交到一个地方,不会阻塞然后线程池里面的每个线程会来取任务,比如:线程池有3个线程,但是有5个任务会先取走三个任务,每个线程去处理其中一个线程处理完自己的任务之后,会再来提交过的任务区再拿走一个任务"""pool.submit(handler, task)print("main执行完毕")

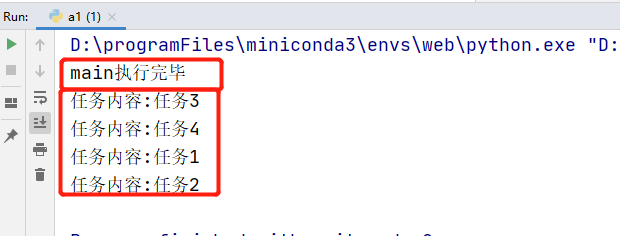

执行结果

发现的问题

其实这个就是并发的,不要怀疑,但是你有没有发现个问题,main先执行,这说明啥?

这说明,我main跑完之后,是不管子线程的死活的。

那能不能设置一下,所有的子线程都执行完之后,main函数在执行完?

当然可以,需要一个参数即可。

pool.shutdown() 要完成上述的问题,我们需要一个参数,加上这个参数之后。

就可以让主线程等待所有子线程执行完之后,主线程再执行完。

示例代码

...if __name__ == '__main__':# 遍历任务,for task in task_list:"""交给函数处理,submit会将所有任务都提交到一个地方然后线程池里面的每个线程会来取任务,比如:线程池有3个线程,但是有5个任务会先取走三个任务,每个线程去处理其中一个线程处理完自己的任务之后,会再来提交过的任务区再拿走一个任务"""pool.submit(handler, task)pool.shutdown()print("main执行完毕")

主要就是13行的pool.shutdown()。

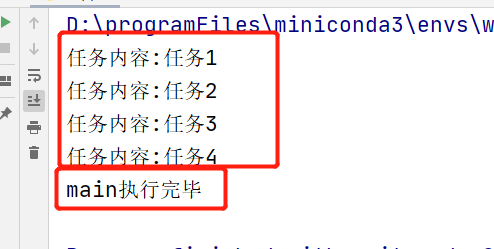

执行结果

这次结果就是我们想要的了,hhh!!!

add_done_callbackadd_done_callback可以理解为是回调函数,线程执行完之后,会自动调用指定的回调函数。

并且能拿到线程执行函数的返回值。

有什么用,我也没用过,怪我才疏学浅叭。

示例代码

import timefrom concurrent.futures import ThreadPoolExecutorimport randomfrom concurrent.futures._base import Future# max_workers表示工人数量,也就是线程池里面的线程数量pool = ThreadPoolExecutor(max_workers=10)# 任务列表task_list = ["任务1", "任务2", "任务3", "任务4", ]def handler(task_name):# 随机睡眠,模仿任务执行时间不确定性n = random.randrange(5)time.sleep(n)print(f"任务内容:{task_name}")return f"任务内容:{task_name}"def done(res: Future):print("done拿到的返回值:", res.result())if __name__ == '__main__':# 遍历任务,for task in task_list:futrue = pool.submit(handler, task) # type:Futurefutrue.add_done_callback(done)pool.shutdown()print("main执行完毕")

注意:第17,27,28行代码!

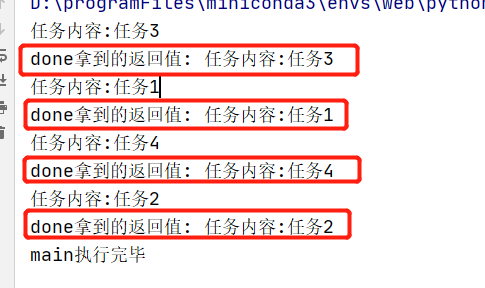

执行效果

我想,可能通常用在一些善后工作叭。

多进程方式

其实通过上述几个例子,我们基本是知道怎么使用上面这个线程池了。

但是都知道Python的线程,因为GIL(全局解释器锁)的原因,是不能并发到多个物理核心上的。

所以是IO密集型的,像爬虫,读写文件,使用线程池是ok的。

但是如果说我就是野,就是头铁,非要用Python做计算型应用,像图片压缩、视频流推送,那没办法,需要使用多进程池方式。

其实通过concurrent这个接口,可以很方便的创建进程池,只需要修改两个地方。

...# 改成导入进程池方式from concurrent.futures import ProcessPoolExecutor...if __name__ == '__main__':...# 进程池方式pool = ProcessPoolExecutor(max_workers=10)...

只需要修改这俩地方即可,其他和上述用法一摸一样。

总结

本篇主要讲的是Python自带的线程池和进程池。

比较有特色的是,ThreadPoolExecutor,ProcessPoolExecutor的接口是一样的。

只需要修改导入的包就行。

concurrent的接口主要有pool.submit(),pool.shutdown(),futrue.add_done_callback()。

基本这几个都够自己用了。

如果在操作过程中有任何问题,记得下面留言,我们看到会第一时间解决问题。

想学习更多关于Python的知识,可以参考学习网址:http://pdcfighting.com/,点击阅读原文,可以直达噢~

------------------- End -------------------

往期精彩文章推荐:

欢迎大家点赞,留言,转发,转载,感谢大家的相伴与支持

想加入Python学习群请在后台回复【入群】

万水千山总是情,点个【在看】行不行

/今日留言主题/

随便说一两句吧~~