腾讯警告:你的声音正在被AI「偷走」

腾讯朱雀实验室

腾讯安全平台部下属的腾讯朱雀实验室,致力于实战级 APT 攻击和 AI 安全研究,不断发现现实网络安全风险,为 AI 业务提供安全保障。

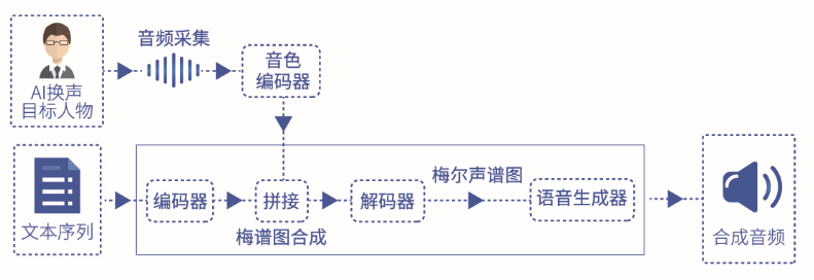

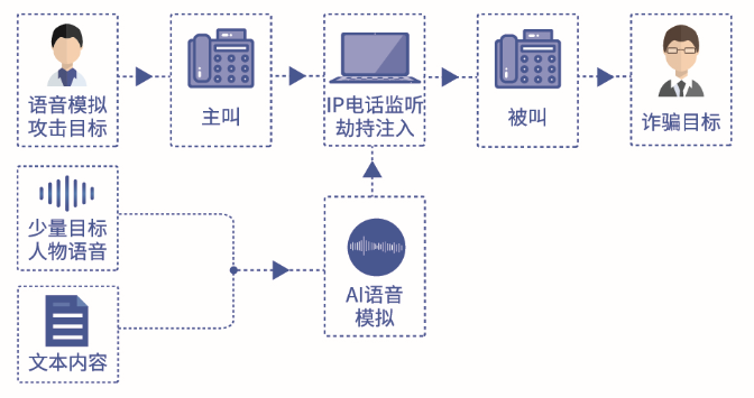

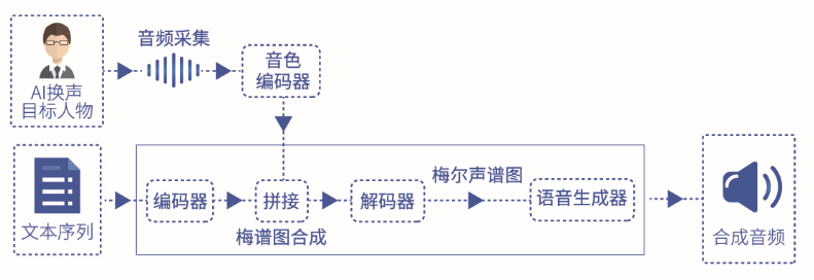

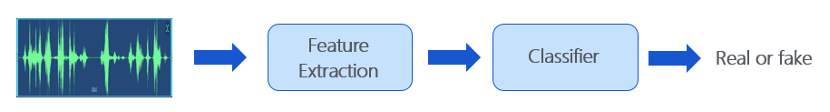

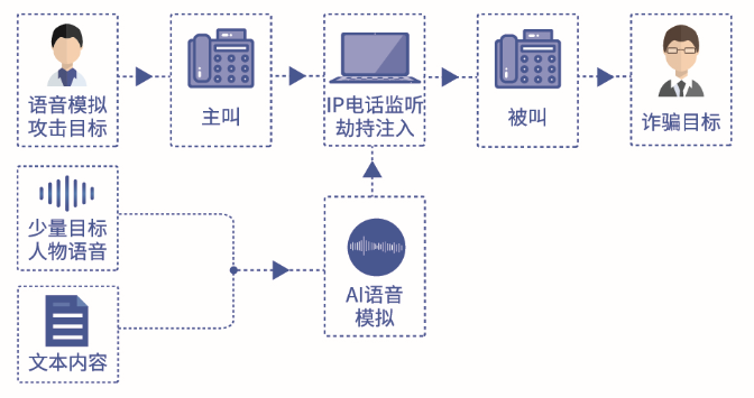

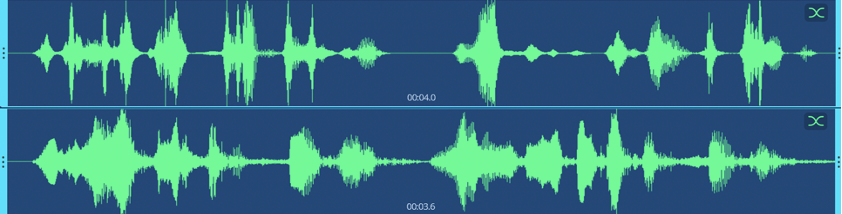

音色编码器 :音色编码器从音频中提取不同说话人的语音特征。

文本编码器 :文本编码器将输入文本转换为特征。

解码器 :解码器将说话人特征和文本特征拼接后的结果转化为梅尔声谱图。

语音生成器 :最后语音生成器根据梅尔声谱图合成语音。

评论

下载APP

下载APP

腾讯朱雀实验室

腾讯安全平台部下属的腾讯朱雀实验室,致力于实战级 APT 攻击和 AI 安全研究,不断发现现实网络安全风险,为 AI 业务提供安全保障。

音色编码器 :音色编码器从音频中提取不同说话人的语音特征。

文本编码器 :文本编码器将输入文本转换为特征。

解码器 :解码器将说话人特征和文本特征拼接后的结果转化为梅尔声谱图。

语音生成器 :最后语音生成器根据梅尔声谱图合成语音。