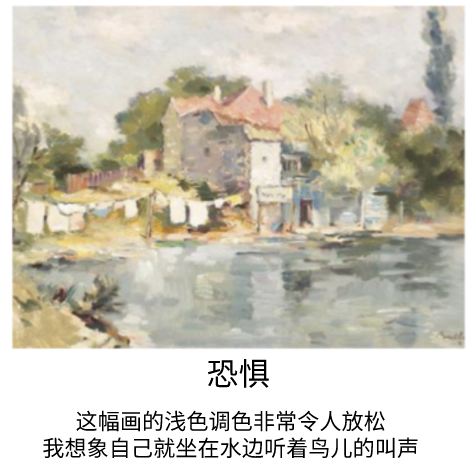

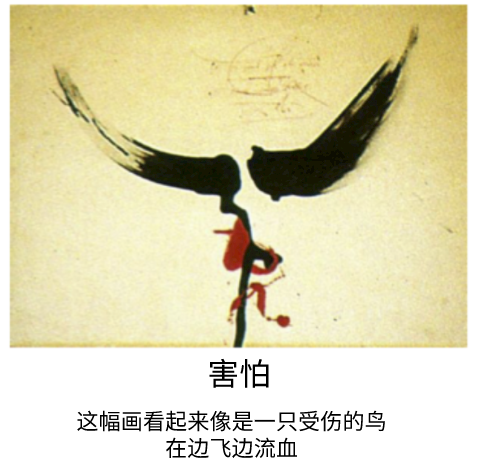

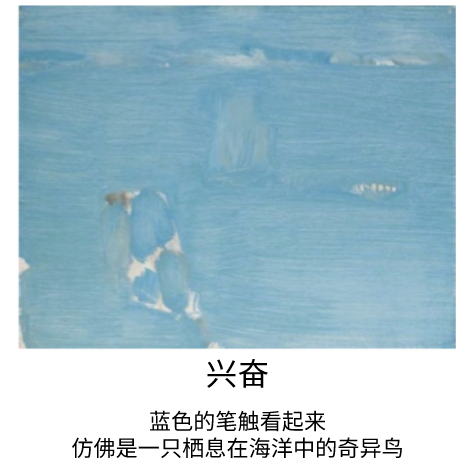

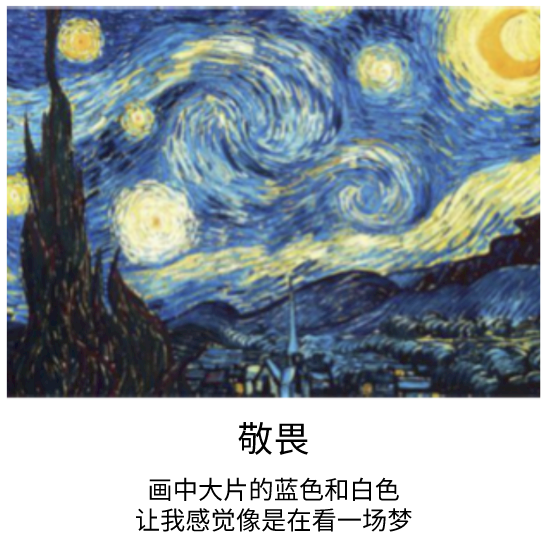

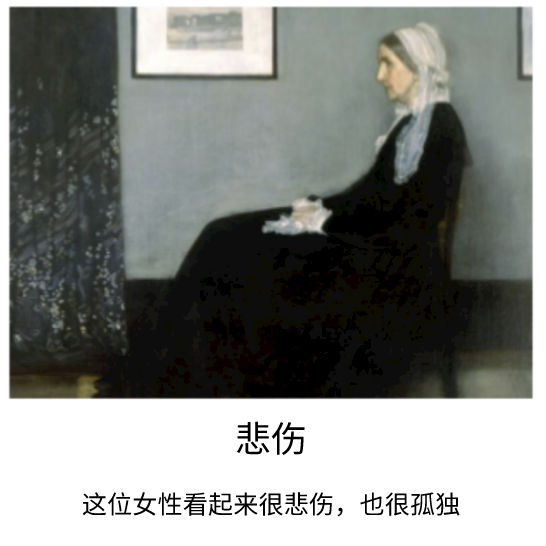

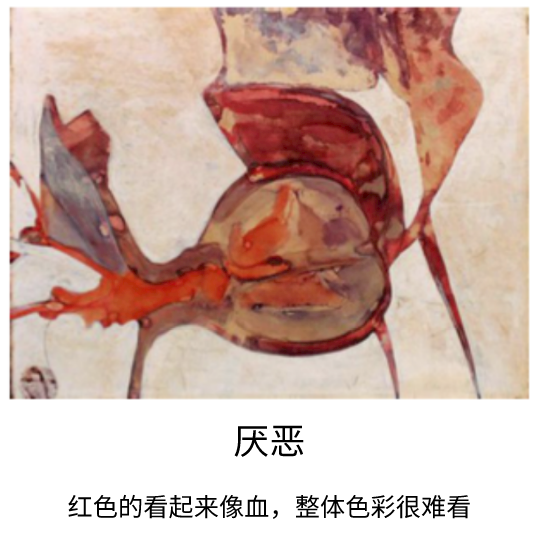

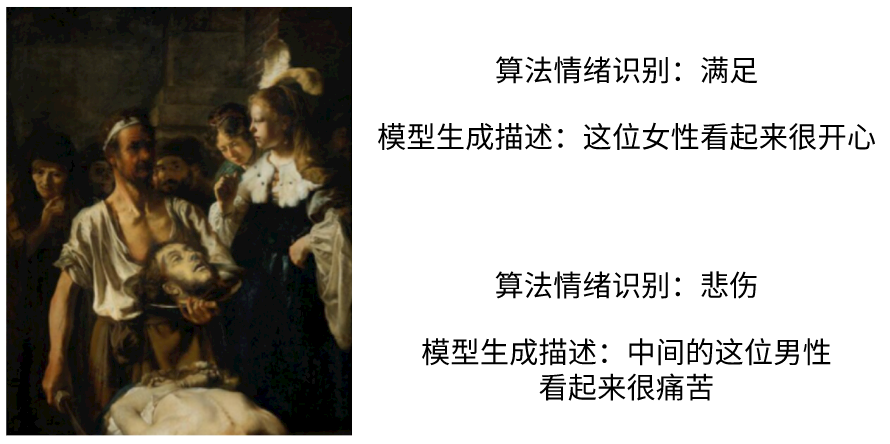

为了让计算机也能够像人类一样,对视觉艺术产生情感反应,并用语言证明产生这些情感的原因,团队基于这一大规模数据集,训练了一个 Neural Speaker(神经表达者)。斯坦福大学 HAI 学院的教授 Guibas 表示,这是计算机视觉领域中一项新的探索。此前经典的计算机视觉方法,往往是指出图像中有哪些内容,比如:有三只狗;有人正在喝咖啡……而他们的这项工作,则是定义视觉艺术中的情感。经过 ArtEmis 数据集训练之后,算法识别出不同的画作中蕴含的情感,并自动生成了这样判断的依据,示例结果如下:论文中介绍了具体训练思路。首先,用 ArtEmis 来训练模型,实现艺术画作的情感解释问题。这属于经典的 9 路文本分类问题,团队使用基于交叉熵的优化,应用于从头开始训练的 LSTM 文本分类器,同时也考虑对为这个任务预训练的 BERT 模型进行微调。另外,让计算机对人类通常会对作品产生的情绪反应进行预测。为了解决这个问题,团队将输出和 ArtEmis 用户标注之间的 KL-分歧最小化,以此对基于 ImageNet 的预训练 ResNet32 编码器进行微调。对于给定的一幅画作,分类器先判断其传达的情感是积极还是消极,再进一步判断具体是哪种情感。团队介绍,对于一幅画作,算法不仅能够感知整体的情感色彩,还能区分画中不同人物的感情。以这幅伦勃朗的《被斩首的圣施洗者约翰》为例,AI 算法不仅捕捉到了被斩首的约翰的痛苦,还感知到了画中被献首的女性莎乐美的「满足」。人类的情感非常丰富且复杂微妙,即使是我们人类自己,也并不能百分之百理解某些艺术家想要表达的心情,所以,要让 AI 精准地理解艺术家的意图,目前必然还存在一定挑战。不过,此次 ArtEmis 数据集的发布,已经让 AI 在处理图像情感属性方面,迈出了第一步。团队表示,待进一步研究与改进之后,算法或许能够感知人类的悲欢,艺术家便可借助算法,评估自己的作品是否能达到预期的情感表达效果。另外,一旦算法能通人性,人机交互的过程也将更加自然、和谐。新闻来源:

https://techxplore.com/news/2021-03-artist-intent-ai-emotions-visual.html

数据集论文:

https://arxiv.org/pdf/2101.07396.pdf

项目主页:

https://www.artemisdataset.org/#videos