隐私和便利我全都要:一位科学家的隐私计算史

1.一个电表引发的隐私矛盾

2009年,美国总统奥巴马站在演讲台上说:“我们要建立一个更坚强、更智能的电网……”

随即,美国能源部门宣布投资34亿美元资助智能电网技术的开发,“投资智能电网”自此成为美国的一项国策。

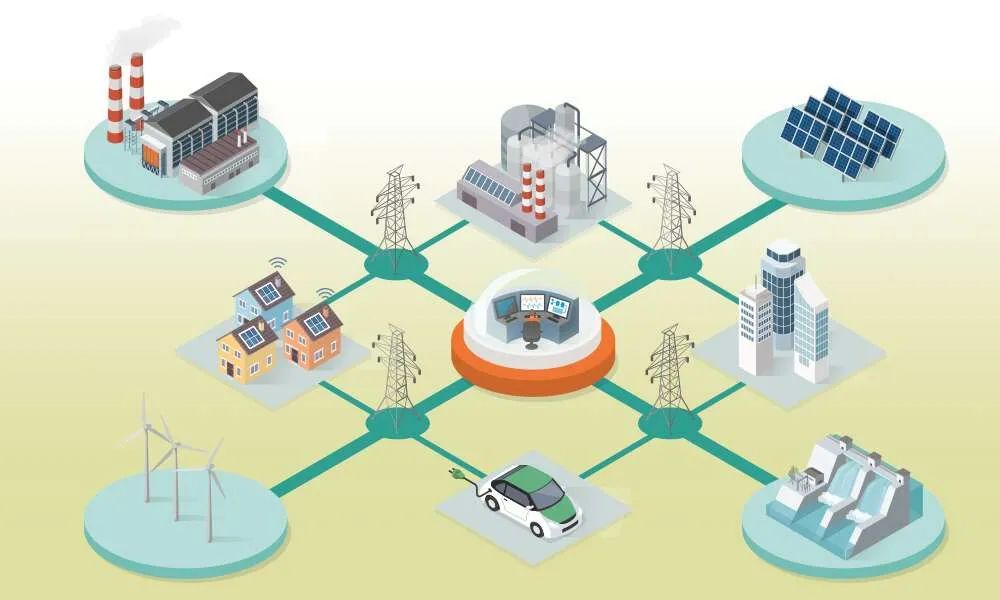

在这个庞大的智能电网计划里,电表是重要的一环。

电厂送出来的电,没用完的,要么转送到别处,要么就直接浪费掉了,所以能源部门就设想:只要成千上万的智能电表分布到每一个角落,每隔15分钟上传一次数据,电网就能根据实际用电量来实时调度电力,用多少就送多少,减少浪费。

这个设想当然很好,可智能电表的推广进展很快受阻。

“我感到自己正在被监视。”

“电厂有什么权力这么做?!”

类似的声音此起彼伏,人们害怕频繁上传用电量会暴露自己的隐私。

乍一看,有点杞人忧天,就像之前国内有人担心辐射,宁愿手机没有信号,也不准运营商在自家附近建基站。

但电表隐私问题还真不是杞人忧天,研究人员发现:每15分钟上传一次的电量数据,真的可以用来搞监视!

王爽当时在美国读计算机博士,他发现,利用一些特定的算法,很容易就能通过用电数据推算整个屋子里的活动情况:“你什么时间做饭、用电脑、看电视、洗衣服等等,全都能计算出来。”

这些用电数据一旦被滥用,坏人可以拿来监视别人,商家可以做所谓的“大数据营销”。例如,商家先得知你家是否用了某种医疗器械、你的私人时间是如何度过的,再给你不同的商品定价和广告策略。

事情到这,就陷入一个死循环:国家要节能,电网就得高效,电网要高效,数据必不可少,可人们又不愿意给数据。

当时有人想到一个妥协方案:降低上传数据的频率——原本15分钟上传一次,现在改成每天上传,或每周上传。

但这样一来,电网调度的实时性和效率也会大大降低,频率降得太低,跟抄表员十天半个月上门来抄电表也没多大区别。

“有没有可能,既能让电厂用到这些数据,又不暴露个体的隐私数据?”

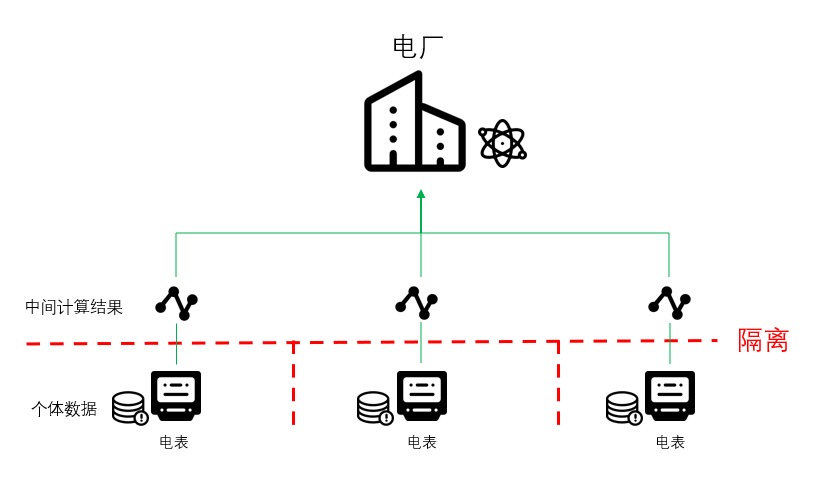

王爽发现,电厂想要的其实只是统计信息,比如一片区域在特定时间内的总用电量、平均用电量、高峰用电量等等,并不需要个体数据。

而这类问题在数学上是有解的。

举个例子:

爷爷想知道家里的仨葫芦娃这个月一共挣多少钱,但是哥仨谁都不想暴露自己的收入,怎么办?(你可以思考5秒再往下读)

有一个办法是这样的:

第一个葫芦娃在脑子里想一个很大的随机数,加上自己的收入,把求和结果告诉第二个葫芦娃。

第二个葫芦娃再加上自己的收入,给求和结果第三个葫芦娃,第三个葫芦娃加上自己的收入,把结果交给第一个葫芦娃。

第一个葫芦娃再减去自己一开始的那个随机数,就得到三个人的总收入,交给爷爷。

整个过程中,大家谁也没暴露自己的收入,却一起计算出了总数。

王爽很快研究出一套方案,可以做到既让电厂拿到各项统计数据(中间计算结果),又不暴露单个用户的用电量。

他把方案写成论文,发在学术期刊上。(当然比上面葫芦娃的例子复杂得多的多,葫芦娃只是为了帮大家理解为什么“既使用数据,又不暴露数据”是可以做到的)。

由于这篇论文,王爽和“隐私计算”结下不解之缘。不过严格来说,当时还没有“隐私计算”这个领域,充其量是“混沌初开”。

那时王爽也没意识到,若干年后,隐私将成为各行各业的难题,对整个世界产生深远影响,电表引发的矛盾,只是科技发展与隐私保护之间矛盾的一个小小缩影。

要科技发展,还是要保护隐私?这个矛盾是深刻而本质的,它深埋在各个领域,就像一颗定时炸弹,即将被“云计算、大数据、人工智能”等新兴技术引爆。

在一次学术活动上,王爽遇到一位师哥,师哥来自加州大学圣地亚哥分校(美国全国性一级大学)医学院,听说王爽在研究隐私保护技术,又临近博士毕业,正在找实习,便盛情邀约。

师哥告诉他,医疗行业的隐私问题由来已久,当年,就连麻萨诸塞州(就是大名鼎鼎的麻省理工学院所在的“麻省”)的州长都是医疗隐私问题的受害者。

2.连州长都遭殃的医疗数据之困

1997年,美国麻省政府的一个部门为了帮助医疗科研人员,公布了一份政府雇员的医疗记录。

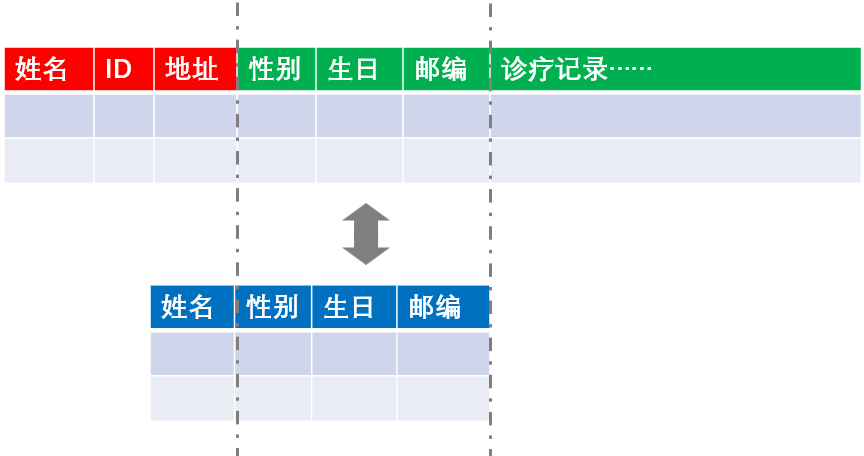

为了防止暴露个体隐私,他们专门给数据“打了个码”——删掉了姓名、地址和社会安全号码(相当于身份证号码),但保留了出生日期、性别和邮政编码这些看似无关痛痒的信息。

麻省理工学院当时有一位学者叫拉坦娅·斯维妮( Latanya Sweeney),她拿到医疗记录一看,眉头一皱:这马赛克简直是打了个寂寞啊!

她打听到麻省州长住在剑桥市,就花20美元从剑桥市政府买了一份选民名册,从里头找到州长的资料,有姓名、地址、邮编、生日、性别等等(美国很多州选民的这些基础信息都是公开的),再跟那份“打了码”的医疗记录进行对比,发现跟州长同一天生日的人有6个,性别是男的有3个,最终,她又用“邮编”把目标锁定到其中一个人。

她把“这个人”的医疗记录摘出来,一封邮件发到州长办公室,也不知道州长看到自己得过什么病,吃过什么药,被人扒得一清二楚,该作何感想。

之后,拉坦娅又公布出一个惊人结论:只需要三个信息(邮政编码、出生日期和性别)就有63%~87%的可能性唯一确定某个州中的一个美国人。

这件事直接让麻省政府部门“炸开了锅”,没过多久,麻省乃至整个美国的医疗信息隐私政策都发生重大调整,开始“严打”,所有医疗记录披露都需要严格遵守《健康保险隐私及责任法案》(简称“HIPAA法案”)所规定的相关隐私保护条例。

人们从此意识到,隐私数据处理并不是随便删一删数据,打一打码就行,它是一门技术活,搞不好的话,分分钟就会被人破译出来。

这也是为什么师哥会邀请王爽这样的计算机专家来医学院实习——名曰“实习”,实则“救火”和“把关”。

它山之石,可以攻玉。在加州大学圣地亚哥分校(以下简称UCSD)医学院实习的三个月,王爽处理起数据是得心应手,一边工作还一边顺手发了几篇硬核学术论文,这一顿猛如虎的操作,把一帮学医的教授都看懵了,实习期刚结束,就让王爽留下来继续工作。

虽然成绩还不错,但王爽发现一个问题:有一些“特殊的数据”很难用“老方法”来处理。

所谓“老方法”概括起来就两点:匿名和泛化。

匿名,就是把敏感的信息(比如名字)用***替代,原来是张三,改成张*或**。

泛化,就是把一个确定的内容变成一个范围,原来是28岁,现在是20~30岁,这样别人就很难通过数据比对来定位到某个人。

对于“结构化”数据(简单理解就是平时能用表格来表示的数据),这两种方法比较奏效,但是对“非结构化”数据就不太好办,比如医生在病历里写了一段口语化的备注:“这个病人从15岁到50岁期间抽烟,平时睡觉不太好,得过阿尔兹海默症……”

像这种数据,每个病人的格式都不一样,这时,你就不知道应该给什么地方打码,什么地方不打码。

而且匿名和泛化,肯定造成信息量丢失(严谨一点叫“增加信息熵”)。正如一部电影,马赛克打得越多越厚,观赏性就越低(你懂的)。一份数据,从头到尾全部码上,就彻底失去了数据的使用价值。

但这还不是最难的。

如果说处理非结构化数据是棘手,那处理人类基因序列数据,简直就是“无从下手”!

3.美好而脆弱的基因密码

基因序列是个神奇的东西。

正如一个计算机程序可以用无数个1和0构成的代码序列来表示,一个人的基因也可以用无数个ATCG(四种碱基)构成的代码序列来表示。换言之,你的基因序列就是你的“底层代码”。

一个程序出了问题,程序员会在代码里定位到具体原因,基因也是一样,你也许听过,一些基因检测技术只需要取一些唾液、血液或毛发,就能诊断出你是否患某种病,或是提示风险,给出建议。

之所以这么神奇,背后是无数科研人员做了大量数据统计和分析的结果。

一个人大约共有30亿个基因位点,我们身体的性状:单双眼皮、直卷发、皮肤颜色以及身体疾病,大多都能找到对应的基因位点。

科研人员通过大量的数据统计分析,才把各种疾病、身体性状和特定的基因位点一一对应上。

分析过程中会大量用到机器学习之类的AI(人工智能)技术,把大量基因位点和疾病、症状的对应数据“喂给AI模型吃”,AI模型就会自动学会判断疾病和基因位点之间的联系,就像要教会AI识别狗,得用很多张狗的照片去训练它一样,喂的数据越多,效果就越好。

如果样本数据的量不够,训练出的AI模型就像一个学艺不精的医生,经常出错。

2011年底,王爽所在的项目要研究如何用基因数据来诊断心脏病,遇到一个难题:

加州大学体系下有5家医院,每一家都有一些心脏病人,单独做分析,样本数量都不够,可医院之间又不敢贸然交换数据,因为基因序列数据太特殊了。

常规的医疗数据,可以用匿名和泛化来处理,基因序列数据不行。

“一个人有30亿多个基因位点,只要挑出具有代表性的十几个位点,就能唯一确定一个人,准确率比指纹高得多。”王爽说。

这就好比,你全身每一寸肌肤都写着你的名字,要怎么打码?不可能给30亿个基因位点全部打上码吧?而且万一码掉的基因位点恰好跟这种病有关怎么办?

可是如果保护做不到位,导致基因序列医疗数据泄露,后果更严重。

王爽团队的一位同事做过一项试验,一个人喝完一杯水,杯子留在桌上,他只需要提取杯子上残留的唾液,做个基因检测,就能有一定概率知道这个人姓什么。

方法说起来特简单,美国是一个移民国家,人们喜欢溯源自己的家族,市面上有很多公开的基因族谱数据,像什么“史密斯家族”、“唐纳德家族”,只要拿着你的基因和族谱数据一比对,就能知道你在不在这个数据库里。

如果只是知道姓什么,并不可怕,可怕的还在后头。

王爽当时手头有许多大型的医疗科研项目,见到过各种各样的数据,其中一个项目包含4万多志愿者的全基因组序列,以及他们的录音、360度的全息拍照。

假如这批数据被泄露,只需要被泄露者的一滴唾液,就能精准恢复出他的各项身体信息:肤色、眼睛颜色、体重、身高、声音等等。

这意味着,我拿到你的一滴唾液,只要放到各种数据库里比对,就能知道你的各种信息,比如放到一个艾滋病或自闭症的研究数据库里比对,就能知道你是不是参与过这个项目。

最最极端的情况是:某一家特别有钱和权势的组织,从各个渠道收集到所有流落在市面上的基因数据库,聚合到一起,它就能分析出所有人的基因信息:你的(以及你父母、孩子的)相貌,你的病,你家族的遗传病,你的先天特征……一切和你的基因有关的一切,都可以被掌握。

届时,很可能会出现比“大数据杀熟”更可怕的情况:“基因杀熟”。

保险公司可以根据你的基因来评估你的投保风险,甚至拒保,诈骗团伙根据你的基因来设计精巧的骗局。

……

……

……

更可怕的就不说了,反正挺赛博朋克的。

总之,医院每交换一次数据,风险就多一分,因为数据可以无限复制,对方会怎么处理你的数据,能不能保护好,这些都不可控。

隐私问题一度让项目进展非常缓慢,项目组左右为难。

但是基因医疗肯定不能放弃,因为它确实有很多传统医疗不可比拟的优势。

比如做羊水检查,需要用一根针管从孕妇肚皮上扎到子宫抽出羊水,对胎儿有一定危险,而基因检测就不需要。

还有一些疾病,传统方法束手无策,基因医疗却能另辟蹊径。

王爽开始琢磨:有没有办法在不给出原始数据的情况下,又让对方利用到数据的价值?

他想起自己写过的电表隐私论文,在那个方案里,电厂在不需要直接碰触居民电表里的原始数据,却能得到中间计算结果……

有了!一道灵光闪过,王爽欣喜若狂,“真相只有一个!”他冲进实验室和同事们分享自己的思路。

王爽教授(和柯南)

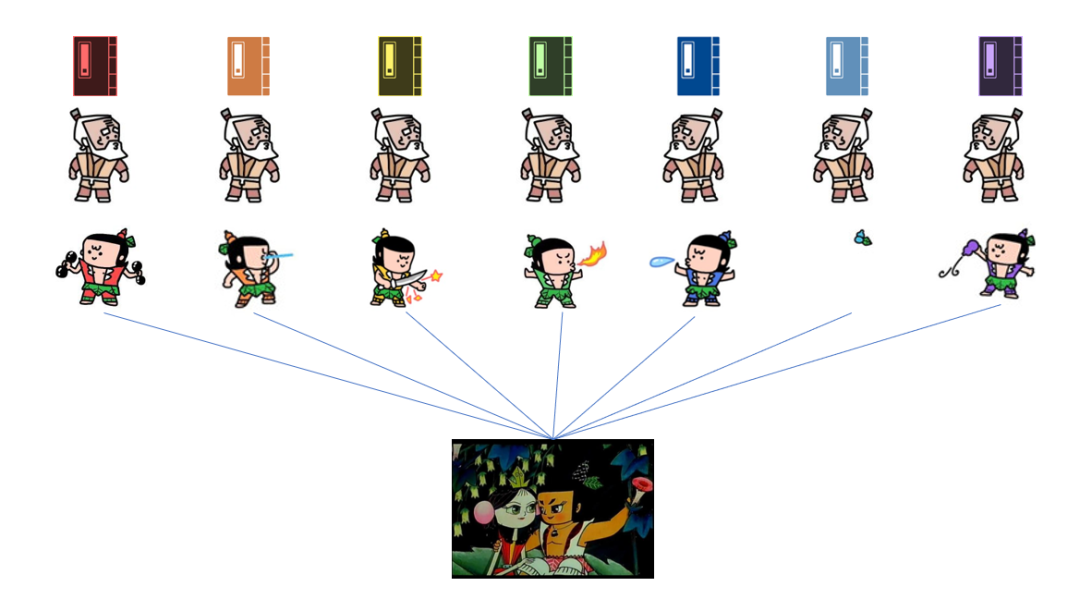

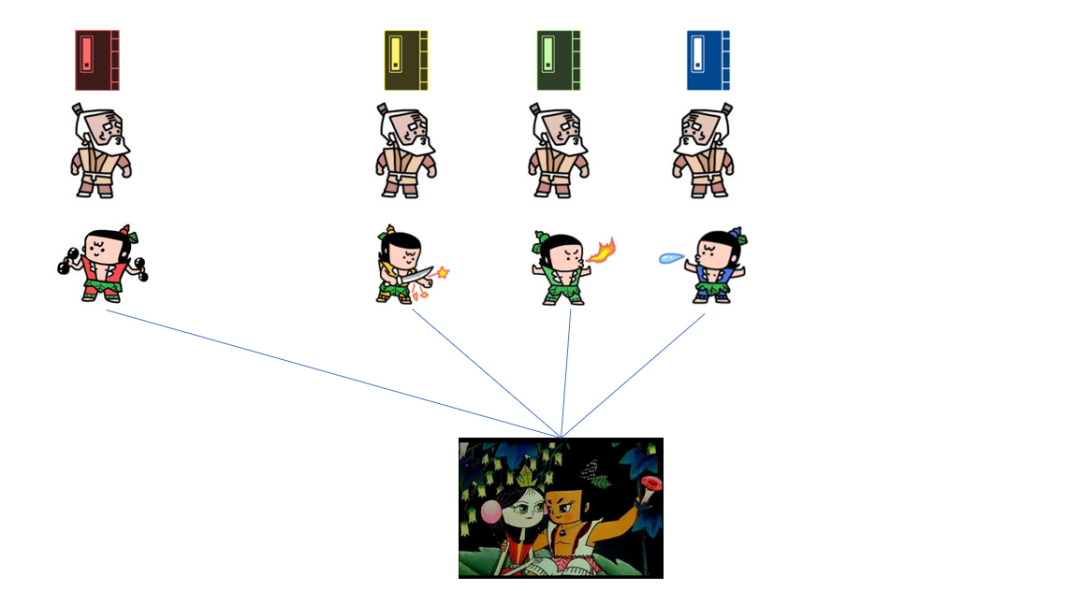

很快,一套名叫“隐私保护下的分布式机器学习”的方案摆在众人面前,在这套方案里,医院不需要把数据拿出来,喂给模型吃,而是反过来,把模型放到医院的服务器,训练出一个小的AI模型。

再把几家医院分别训练出的“小模型”放到一起,训练出一个更厉害更准确的大AI模型,整个过程中谁也不会暴露自己的原始数据,却又用到所有数据,做到数据的“可用而不可见”。

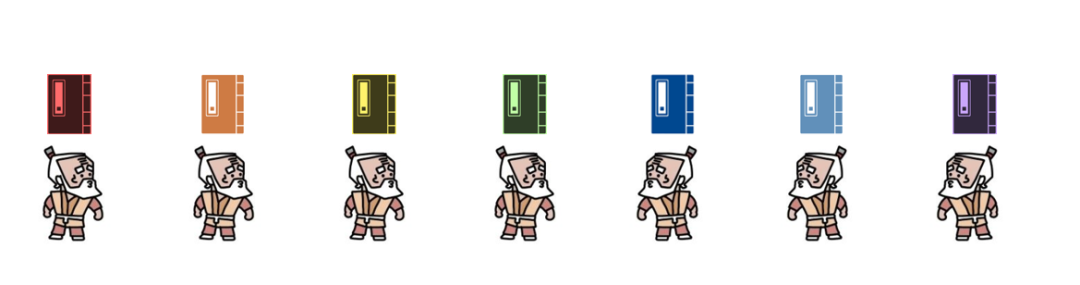

打个不严谨的比方,每一个爷爷都有一本“葫芦娃”训练秘籍,都只能训练出单色葫芦娃,但是爷爷们又都需要一个全能的葫芦小金刚来保护自己。

所以爷爷们先各自训练出一批单色葫芦娃,再让七个葫芦娃合体成七彩葫芦小金刚,每个爷爷都可以领走一个,至于葫芦娃秘籍,依然保留在各自手中,不需要告诉任何人。

至此,每一家医院既能得到一个优质的AI模型,又保住了患者的隐私。应了那句:小孩子才做选择,成年人当然是隐私和便利……

尽管说起来很简单,实际做起来还是会碰到各种无法预料的情况。

“比如,其中一个计算中心网络不稳定,或是中途想退出这个项目,掉线了怎么办?”

还记的文章开头那个“计算三个葫芦娃的总工资”吗?这就相当于第三个人加完自己的工资,交给第一个人,准备让他减去最初那个随机数,结果第一个人忽然说:“我溜了,你们自己算吧。”于是其他人又得从头来一遍。

为了避免类似情况,王爽不断改进了方案,做到让每一个中心都可以动态地加入或离开,整个研究不会受影响。

原本非要7个葫芦娃才能合体,现在随便来几个都能合体。

安全领域有一个说法:未知攻,焉知防。

为了保护好数据,王爽还要带着团队自己扮演攻击者的角色,想尽各种办法来破解自己的方案,“黑”掉自己的数据,提出各种安全假设,左右手互博。

至此,基因序列研究的隐私困境终于被解开,一个包含加州大学5所附属医院的多中心联合分析网络建立起来。

之后,越来越多的医院闻讯加入,到2013年,一个横跨美国西海岸将近20个医共体(全称“医疗服务共同体”,是一种医疗合作组织形式)的网络建成,串联起上百家医院,超过3000万个病患数据像孤星汇成银河。

这“银河”对一些病人来说,也许是活着的希望。

之后,王爽又参与了其他研究项目,把这套思路延伸在其他罕见病的基因研究,以及医疗影像和其他非结构化数据上。

然而这个世界上不可能有一劳永逸的解决方案,故事到这里,隐私计算的大厦还远远没有建成。

4.隐私计算界的奥林匹克

“隐私计算光靠一两个团队的话,进展肯定太慢。”2013年底,王爽意识到这个问题。

次年,他开始频繁接触各路密码学和安全专家,却发现整个密码学界、安全界跟医学界完全处于“脱钩”状态。

“懂医学的人不懂安全,懂安全的不懂医学。”

王爽举了个例子,一位密码学专家设计了一套非常精巧的方案,在密码学上是完全正确的,可是他假设的场景在实际当中根本不存在,医院根本就没有这个需求。

比如:医院接到一个病人,想在数据库里寻找是否有相似的病人,以前用过什么诊疗方法,效果如何。此时,如果技术方案的设计者不理解“什么是相似的病人”,就很可能出错。

什么是相似的病人?是病人的身份证编号相似?哈希值相同?年龄、性别相同?还是生理指标?多大程度上的相同才能叫“相似”?

隔行如隔山,但王爽知道,这座山必须打通,工业界和学术界要充分交流,隐私计算才能长足发展。

2014年,他主持创办了一个讨论社区“iDASH 隐私安全研习大会(iDASH Privacy & Security Workshop)”,每年把大家拉到一块交流学习。

之所以叫iDASH,是因为王爽当时作为核心人员参与了总额超过四千万美元的美国国家生命医疗计算中心(iDASH)项目,这个社区的建设经费是项出的,所以就冠名了。

王爽一边攒局,一边带着团队十几个做数据隐私安全的博士、研究生们,当起了“翻译”,把医学领域实际碰到的各种问题,抽象成一个个的“信息学应用题”,摆到密码学和安全研究者们面前。

“你直接跟他说两个相似的病人,他不知道怎么做,但是当我们把相似性严格定义成一个可以度量的概念,比如求一个特定的“最短路径” ,公式规则我都全都给定义好,他们就秒懂,直接解题就行,慢慢地,他们也会理解这个可以临床上能解决哪些问题。

他们从同事、朋友、合作伙伴那里四处收集到各种临床上的难题,后来一琢磨:不如把这些难题变成考题,搞一场隐私计算的“华山论剑”,让各路高手来切磋切磋如何?

iDASH隐私保护竞赛就这么办了起来。

2014年,第一届iDASH比赛还没有任何名气,王爽只能“刷脸”,靠着自己的学术魅力,发邮件、朋友圈“人传人”,拽着身边的朋友跟合作伙伴来参加,有的朋友一开始只是卖个面子来参加,结果发现:诶?这比赛可真有意思!反响很好。

等到2015年第二届,美国基因研究领域的权威媒体GenomeWeb和自然(《Nature》)杂志也跑来报道。很快,整个学术圈子里研究隐私计算或基因的人基本都知道这个比赛。

2016年第三届,微软、英特尔、IBM等商业公司也开始派队伍参赛,原因说来也巧,王爽有一个经常一起约饭吃烧烤的邻居,正好在微软负责系统安全,一听他搞了个比赛,也帮忙吆喝,所以iDASH比赛很快在互联网科技圈传开。

又过了一年,iDASH比赛出现中国公司的身影。最早是百度,2017年,百度美国研究中心出资赞助iDASH竞赛。那一届还发生过一个有趣的事:当时有个赛题是在可信计算环境下完成人类基因组分析,百度安全实验室当时研发了一个工具包叫Rust SGX,结果法国队基于这个工具包做的方案夺了冠,也不知道百度团队当时被自己研究的武功招式击败,是该开心还是忧伤……

那一年,和百度一起赞助iDASH的另一家公司叫人类长寿公司(Human longevity),创始人叫Craig Venter,是人类基因组研究计划的先驱和代表人物之一,曾被时代杂志评为世界最有影响力的人之一,2010年他和同事一起创造出历史上第一个人造细胞。

前文提到的王爽参与的那个包含4万个志愿者的基因和全息影像数据的项目,就是跟这家公司合作的。

现年75岁的Craig Venter

王爽并没有料到,这场切磋交流将一年比一年声势壮大,队伍一年比一年多,几年下来,俨然成了隐私计算领域的奥林匹克。

也正是那几年,隐私计算领域的各个技术流派逐渐清晰。

同态加密、可信计算、差分隐私、多方安全计算、联邦学习等等……就像是一场武林大会,吸引来少林、武当、峨眉、昆仑,各路门派豪杰齐聚。尽管大家都是要保护隐私,但具体的场景和方法区别非常大,很多时候要结合多种技术。

王爽记得,第一届的iDASH有一条赛道是基于“差分隐私”的隐私保护——看看谁能在数据里加最少的噪音,又能尽可能保持数据在分析中的可用性,还能充分保证第三方不能从结果里窃取到相关信息。

而说到隐私计算的技术流派,还有一个跟王爽有关的小插曲。

2016年,谷歌在官方博客发了一篇文章,讲他们如何在不碰触用户手机数据的情况下,依然能利用这些数据做机器学习。

大致原理是,不把用户手机里的数据拿出来,而是把一个小的AI模型放到用户手机里,训练完之后,只上传中间计算结果,不上传原始数据,成千上万个用户的模型再聚到一起,训练出一个大的模型。

谷歌当时为这种思路造了一个新词:Federated Learning(联邦学习)

截取自谷歌博客

王爽在网上刷新闻,看到许多媒体都在报道说:谷歌开创了一种新的机器学习范式叫“联邦学习”,他捏着下巴微微点头:“嗯……Federated ,联邦,这个词用的真巧妙,就用了一个单词,我以前咋就妹想到捏~?(注:王教授是东北银)”

以前,王爽在论文里用的是Privacy preserving distributed learning(隐私保护下的分布式学习),那之后也改用Federated learning(联邦学习)以便于交流。

他当时还不知道,两年后,自己就从学术界踏入工业界,开始由一个纯粹的科学家变成一个创业者,跟一些客户提起联邦学习时,人们都以为是谷歌在2016年开创的,却不知道有一位华人科学家早谷歌五年就在实践同样的思路,而这位科学家正站在自己面前。

后来我有一次问王教授:“你当时看到谷歌那篇博客文章,有觉得谷歌抢走了本该属于你的荣誉吗?”他说没有。

“当时我还在学术界,对这些词汇上的东西不是很在意,而且解决的问题也不一样,谷歌解决的问题其中在2C(面向消费者)领域,我解决的问题主要在2B(面向商业)领域,虽然理念上确实差不多。”

5.回中国,还是在美国?

iDASH隐私竞赛之所以很快“出圈”,一个重要的原因是2015年底,号称史上最严的隐私数据保护法案GDPR(《通用数据保护条例》)的最终稿公布,并计划2018年开始正式实施。

法案规定,企业如果没做好隐私保护,导致用户隐私泄露,最高可以罚年营收的4%,科技巨头们掐指一算,当场吓尿:我们一年营收几百甚至上千亿美元,4%得是多少啊?!

他们开始四处寻找技术方案。

也因为人们隐私保护意识的觉醒,王爽参与的隐私保护项目越来越多,几年时间,他掌握的技术方案不论是在安全性,还是计算效率和复杂度上都在飞速提升,能应对的问题范围也越来越广。

2018年,他萌生了创业的念头。

他回顾自己在学术圈的日子:想得到的荣誉都已经得到,已经打了通关。一边带学生做项目,一边发论文,三年时间就“不小心”解锁了“教授”成就,几年时间下来,发了上百篇学术论文,各种奖项拿到手软。

主持和参与的科研项目也都是大型项目,比如总额超过四千万美元的美国国家生命医疗计算中心项目(iDASH)、美国卫生保健研究与质量局(AHRQ)项目,以及多项美国国立卫生研究院(NIH)项目,还有NIH联合英伟达(NVIDIA)、亚马逊(Amazon)的云计算项目等等。

他想起自己刚来美国读博士时,2007年,英伟达公司推出GPU计算平台CUDA,他是第一批研究这个框架的人,当时他想到可以基于CUDA做一套商业化方案,用GPU去加速高性能计算应用,但当时为了优先完成学业就放弃了创业计划,直到后来有一家公司做了这件事,并大获成功,他才意识到自己错过了几个亿。

如今,又一个机会摆在他面前。

2018年,王爽三十多岁,这位外表看着沉稳,不善言谈的教授,心中依然有一团小火苗。

这团火苗很快就被几位朋友彻底点燃。

2018年3月,王爽受邀到麻省理工学院做学术报告,台下可谓是高朋满座,包括多位图灵奖得主、院士、密码学专家。当时,著名物理学家张首晟教授也坐在台下,这是王爽第二次见张教授,两年前,张教授曾经邀请王爽到斯坦福大学做过一次关于数据隐私的报告,当时张教授就认定,隐私计算是未来解决数据流通的一项核心技术,但当时相关法律法规还不完善,所以那次他们主要在学术层面做交流。

报告结束后,张首晟又邀请王爽到斯坦福做一次报告,张教授在斯坦福大学组织了一个论坛,用于交流最前沿的技术,参加者不光有教授,还有一些投资人。

那次论坛上,张教授向王爽引荐了启明创投的创始人邝子平,以及在生物医药行业做了十多年硅谷资深科学家的郑灏博士,几人一拍即合,相谈甚欢,一致认定隐私计算的风口即将到来。邝子平当场表示,只要他们愿意出来创业,启明创投一定投资。

没犹豫太久,王爽向学校递了辞职信,郑灏也从硅谷的公司辞职出来,一起创办公司。

王爽是董事长兼CTO,郑灏既有世界500强公司的工作经历,又经历过一家公司从几个人一路做到上市的过程,担任CEO,两人性格互补。

此时摆在他们面前最大的抉择是:留在美国创业,还是回中国?

隐私保护风口在欧美国家出现得更早,隐私保护法律法规方面,国外的进度明显比国内更快,这意味着创业成功率更高。

而且他们在美国工作生活多年,熟识的朋友、团队(比如王爽的学生们)、人脉圈子也是美国这边更多。

国内的学术环境、氛围和一些流程也跟国外也不太一样。

工资待遇、房价什么的就更不消说。

没等他们犹豫,美国宣布对进口太阳能电池板和洗衣机征收全球保障关税——“中美对抗”自此开始。

王爽和郑灏深知数据是一件非常敏感的事,也察觉到问题的严重性,他们必须立刻做决定:要么回祖国工作,要么服务于美国公司。

在国内上大学期间,王爽曾获得首届“中国青少年科技创新奖”,这是在邓小平诞辰100周年之际,按照邓小平的遗愿,用他生前的全部稿费140多万元捐赠设立的奖项,鼓励中国青少年的科技创新。

在人民大会堂,王爽见到国家领导人、中科院院士和许多科技界前辈,与邓小平的子女面对面,接受颁奖并合影留念,和其他来自全国各地的54名获奖学生一同念颂誓词《青春的心声》,整个活动隆重,庄严,在王爽心里留下难以磨灭的记忆。

第一次踏上飞往美国的飞机时,他就知道自己有一天会回来。

2018年,恰逢“海外青年高层次人才引进计划”开始,王爽在递交了申请,很快通过选拔,成为当年医疗隐私计算领域唯一的上榜者,国家对于王爽过去学术成就的认可,更加坚定了王爽回国发展的决心。

“中国人的隐私,会被重视起来吗?”

这个问题的答案将决定他的隐私计算技术能否在中国的商业土地上生根发芽,枝繁叶茂。

“我相信,一定会的。”

6.隐私计算的东风

“我们是2019年回来的,到2020年,隐私计算忽然之间就变成一个风口了。”王爽说。

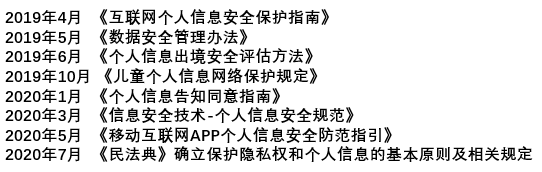

每一个“忽然之间”,放大之后都是一系列惊天动地的大动作。我简单整理了一个2019~2020年期间相关法律法规的时间轴,你可以从这个时间密度上感受一下国家这块的重视程度。

更不用提2021年9月1日生效的《数据安全法》和11月1日生效的《个人信息保护法》了……

隐私保护和网络安全类似,是一个“合规”驱动力很强的市场,法律不禁止,大家就疯狂试探。

如今,中国终于迎来一个隐私数据的强监管时代。

王爽是幸运的,但这份幸运源于坚信和坚持,很多年前,人们还不把隐私当回事的时候,他就在埋头研究。

“我2011年开始做隐私计算,一直到2017年,期间每次回国交流,都感觉大家对隐私保护还没形成一个刚需。”王爽回忆,那时回国作报告,表示感兴趣、想合作的大多是科研层面的,大家想发高分论文,管理层基本没有合作动力,大家只是嘴上说隐私很重要,身体很诚实。

“2018年,国内某大型酒店集团泄露了1亿多人的数据,结果只是治安处罚50万元,那可是1亿人的数据啊,放在欧盟可能要罚几个亿美金,犯错的成本太低了,以至于大家都没有意识去做好数据的保护。”

与其说是赶上,不如说是等来了东风。

中国的个人信息保护法比欧盟的GDPR和美国的CCPA(美国加州的消费者隐私保护法)的惩罚力度更“狠”,GDPR只罚营收的4%,中国最高罚5%,而且除了罚钱,还要承担刑事责任,直接抓去坐牢。

“2020年4月,中央出台了一个文件,把数据纳入生产要素,跟人一样的生产要素,和劳动力、土地一样重要,但是数据这个生产要素很奇特,它的好处是只要有人用就可以创造价值,坏处是一旦给出去以后,生产要素就不是你的了,就变成了别人的生产要素,它的复制成本很低,可以被转卖。”

王爽说,他相信隐私计算会成为这个时代数据价值的底座,帮助解决“一个数据反复创造价值”的问题,“我给出去的是数据的价值,而不是数据本身,这就是数据可用不可见。”

“2019年跟运营商讲隐私计算,大家还不知道隐私计算是什么,联邦学习是什么,我需要从头给他讲一遍这个东西的原理,能解决什么问题。到2020年下半年,我再跟需求方一说隐私计算,大家都已经知道个大概。”王爽说。

医学领域的,金融领域的,安防领域的,云计算领域……越来越多行业主动提出对数据隐私保护的需求。

为了解决这些需求,锘崴科技梳理出三条产品线:隐私查询、隐私建模和隐私推理。

正在读这篇文章的你,很有可能不经意之间已经用到过这三类产品,只是你并不知道。

隐私查询,就是可以做到我去一个数据库里查了一个数据(比如一种病的资料),但是我又不想让别人知道我查了这个数据。

税务部门要限制高消费,让机场要判断每一个乘客能不能上飞机,但是又不能直接把黑名单给每个机场,机场也不能把所有乘客名单给税务部门,这时就可以用“隐私查询”来完成数据的比对,不会泄露额外数据。

隐私建模,就是前文提到的“葫芦娃合体”的例子,多中心联合训练一个算法模型,但是谁也不暴露自己的数据。

很多医院做联合分析研究,金融机构做大数据风控都可以用到。

2020年海军军医大学第二附属医院拿下两个上海市科技进步一等奖,其中一是关于强直性脊柱炎和类风湿关节炎的研究,成果的背后是研究团队联合全国多个中心的数据一起分析,才筛选出24个易感基因,让这种疾病取得突破性进展,而联合研究用到的隐私计算方案,就是锘崴科技提供的。

隐私推理,就是在使用别人已经训练好的模型时,需要向模型输入一些信息源,但是你又不想把数据给对方,这时,隐私推理就能在不给对方数据的情况下,又能用对方的模型来处理数据。

银行可以用“隐私推理”实现各方不通信的情况下完成征信操作。

王爽告诉我,这三个应用基本可以覆盖目前隐私计算在数据领域的绝大多数需求。

只是在实践过程中,依然有许多细节调整工作,因为每个领域都有一些特殊的要求,需要去适配不同的解决方案,不同场景对数据处理的精度、执行的效率、保护安全性都不一样,所以需要用不同算法方案去灵活组合,才能更好地解决用户的痛点。

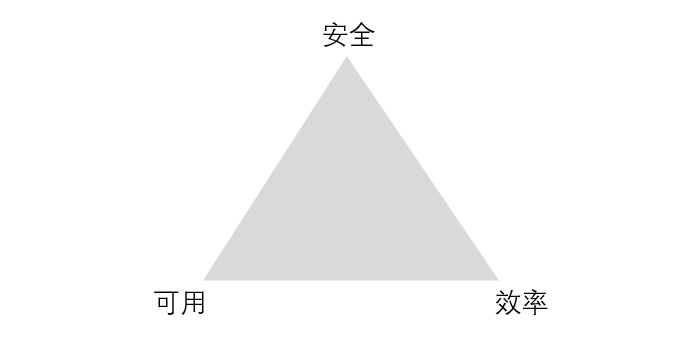

“隐私保护永远都是在安全性、可用性、性能构成的三角形里找到一个平衡点,最安全的就是不用这个数据,只要使用,就有隐私泄露的风险。”王爽说,“隐私计算就是为大家在可控的风险下,合规地使用数据提供了一个工具。”

7.结语:一个补丁

为了解决贫穷、落后、困窘,人类创造出“科技”这把武器,以更好的适应环境乃至改造环境。

但人性之恶,让一些人把科技的枪口瞄向自己人,攫取他人创造的价值,牟取不义之财。

隐私问题,是科技发展到一定阶段的产物。

人们对隐私泄露的恐惧,本质上是恐惧科技,人们害怕隐私落入坏人之手,成为对付自己的武器。

“只有魔法才能打败魔法”,发展的问题,永远只能靠发展来解决。人类的科技车轮一旦开始,便碾过一切无法停止,所以我们只能用“隐私计算”这个新技术来解决旧技术带来的问题。

从这个角度来看,“隐私计算”是科技世界的一个“补丁”,锘崴科技以及它的同行们正在“Debug the world”。

这件事和我们每个人息息相关,他们能不能成功,能做到何种程度,也取决于我们每个人对这件事的态度。

最后再介绍一下我自己吧,我是谢幺,科技科普作者一枚,日常是把各路技术讲得通俗有趣。想跟我做朋友,可以加我的个人微信:xieyaopro。不想走丢的话,请关注【浅黑科技】!(别忘了加星标哦)