这个厉害了,springboot整合ELK实现日志收集

点击上方蓝色字体,选择“标星公众号”

优质文章,第一时间送达

作者 | 易心i

来源 | urlify.cn/fQRJFj

1.什么是ELK?

ELK 就是Elasticsearch,logstash,kibana的缩写哈哈。

Elasticsearch 是一个搜索和分析引擎。

Logstash 是服务器端数据处理管道,能够同时从多个来源采集数据,转换数据,然后将数据发送到诸如 Elasticsearch 等“存储库”中。

Kibana 则可以让用户在 Elasticsearch 中使用图形和图表对数据进行可视化。

ELK该怎么实现日志收集呢?

logstash就相当于一个管道,日志通过这个管道传输给Elasticsearch来保存,最后在kibana上通过图表的形式就可以看见日志信息啦!

2.需要准备的环境

这里是使用的Docker来创建elasticsearch,logstash,kibana;Docker compose来启动的(也可以用Docker运行,看个人选择),所以需要安装Docker和Docker-Compose环境

2.1Docker环境安装

1. 安装yum-utils:

yum install -y yum-utils device-mapper-persistent-data lvm2

2. 为yum源添加docker仓库位置:

yum-config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo

3. 安装docker:

yum install docker-ce

4. 启动docker:

systemctl start docker

2.2Docker Compose环境安装

Docker Compose是一个用于定义和运行多个docker容器应用的工具。使用Compose你可以用YAML文件来配置你的应用服务,然后使用一个命令,你就可以部署你配置的所有服务了。

使用Docker Compose的步骤:

使用Dockerfile定义应用程序环境,一般需要修改初始镜像行为时才需要使用;

使用docker-compose.yml定义需要部署的应用程序服务,以便执行脚本一次性部署;

使用docker-compose up命令将所有应用服务一次性部署起来。

1. 安装下载Docker Compose

curl -L https://get.daocloud.io/docker/compose/releases/download/1.24.0/docker-compose-`uname -s`-`uname -m` > /usr/local/bin/docker-compose

2. 修改该文件的权限为可执行

chmod +x /usr/local/bin/docker-compose

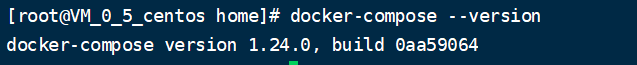

3. 查看是否已经安装成功

docker-compose --version

2.3获取Elasticsearch,logstash,kibana的镜像

docker pull elasticsearch:6.4.0

docker pull logstash:6.4.0

docker pull kibana:6.4.0

2.4部署前准备

Elasticsearch配置

需要设置系统内核参数,否则会因为内存不足无法启动;

改变设置

sysctl -w vm.max_map_count=262144

使之立即生效

sysctl -p

需要创建/mydata/elasticsearch/data目录并设置权限,否则会因为无权限访问而启动失败。

创建目录

mkdir /mydata/elasticsearch/data/

创建并改变该目录权限

chmod 777 /mydata/elasticsearch/data

Logstash配置

创建配置文件存放目录logstash

mkdir /mydata/logstash

创建一个存放logstash配置的文件logstash-springboot.conf

文件内容:

input {

tcp {

mode => "server"

host => "0.0.0.0"

port => 4560

codec => json_lines

}

}

output {

elasticsearch {

hosts => "es:9200"

index => "springboot-logstash-%{+YYYY.MM.dd}"

}

}

2.5使用docker-compose.yml脚本启动ELK服务

创建docker-compose.yml,内容如下

version: '3'

services:

elasticsearch:

image: elasticsearch:6.4.0

container_name: elasticsearch

environment:

- "cluster.name=elasticsearch" #设置集群名称为elasticsearch

- "discovery.type=single-node" #以单一节点模式启动

- "ES_JAVA_OPTS=-Xms512m -Xmx512m" #设置使用jvm内存大小

volumes:

- /mydata/elasticsearch/plugins:/usr/share/elasticsearch/plugins #插件文件挂载

- /mydata/elasticsearch/data:/usr/share/elasticsearch/data #数据文件挂载

ports:

- 9200:9200

- 9300:9300

kibana:

image: kibana:6.4.0

container_name: kibana

links:

- elasticsearch:es #可以用es这个域名访问elasticsearch服务

depends_on:

- elasticsearch #kibana在elasticsearch启动之后再启动

environment:

- "elasticsearch.hosts=http://es:9200" #设置访问elasticsearch的地址

ports:

- 5601:5601

logstash:

image: logstash:6.4.0

container_name: logstash

volumes:

- /mydata/logstash/logstash-springboot.conf:/usr/share/logstash/pipeline/logstash.conf #挂载logstash的配置文件

depends_on:

- elasticsearch #kibana在elasticsearch启动之后再启动

links:

- elasticsearch:es #可以用es这个域名访问elasticsearch服务

ports:

- 4560:4560

3.部署Elasticsearch,Logstash,Kibana

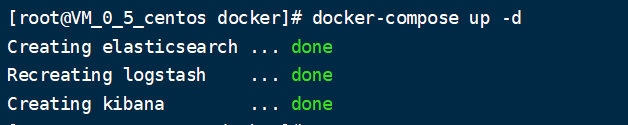

在docker-compose.yml目录下,使用命令docker-compose up -d启动

启动成功!!!

3.1elasticsearch需要安装中文分词器IKAnalyzer

进入容器

docker exec -it elasticsearch /bin/bash

此命令需要在容器中运行

elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v6.4.0/elasticsearch-analysis-ik-6.4.0.zip

退出

exit重启

docker restart elasticsearch

3.2在logstash中安装json_lines插件

进入logstash容器

docker exec -it logstash /bin/bash

安装插件

logstash-plugin install logstash-codec-json_lines

退出容器

exit

重启logstash服务

docker restart logstash

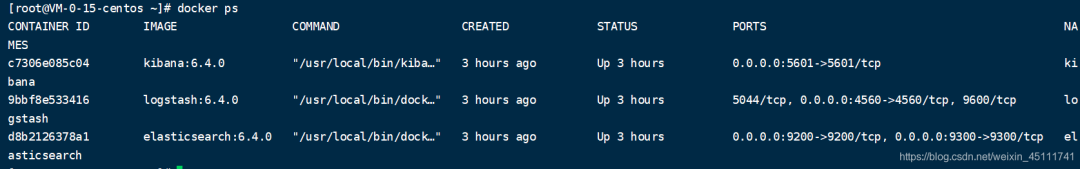

都重新启动好之后,这三个容器都是运行好的

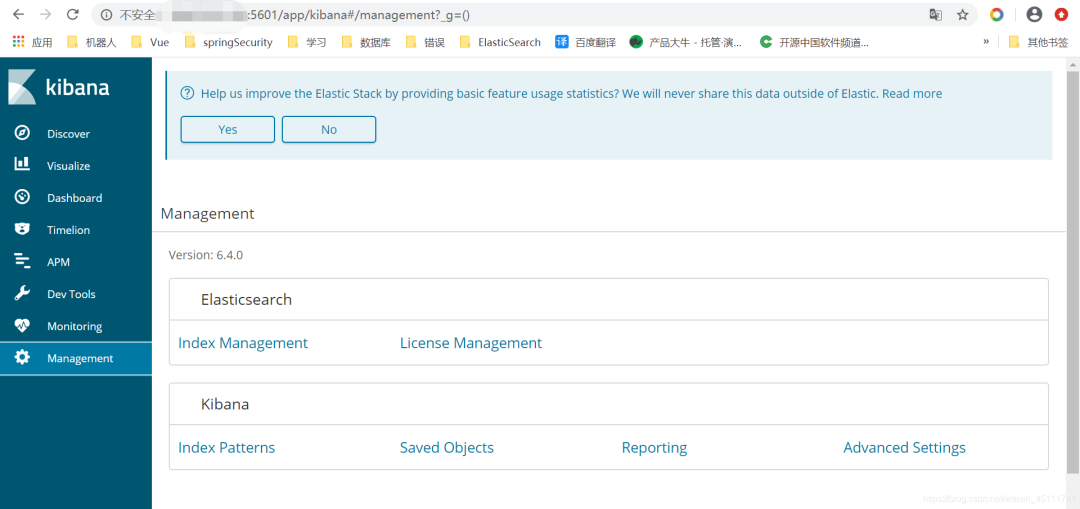

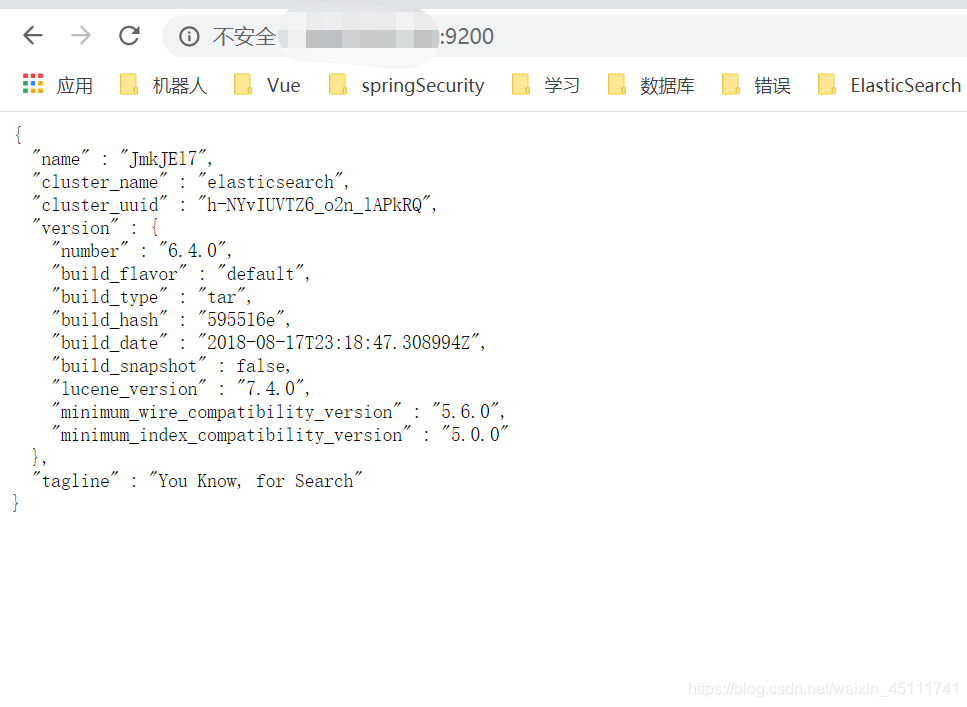

查看kibana

ip:5601

查看elasticsearch是否成功启动

ip:9200

4.springboot应用集成logstash

4.1.导入pom依赖

net.logstash.logback

logstash-logback-encoder

5.3

4.2添加配置文件logback-spring.xml让logback的日志输出到logstash

将下面的ip地址改成自己的

"1.0" encoding="UTF-8"?>

"org/springframework/boot/logging/logback/defaults.xml"/>

"org/springframework/boot/logging/logback/console-appender.xml"/>

"APP_NAME" value="mall-admin"/>

"LOG_FILE_PATH" value="${LOG_FILE:-${LOG_PATH:-${LOG_TEMP:-${java.io.tmpdir:-/tmp}}}/logs}"/>

${APP_NAME}

"FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

"ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

${LOG_FILE_PATH}/${APP_NAME}-%d{yyyy-MM-dd}.log

30

${FILE_LOG_PATTERN}

"LOGSTASH" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

ip:4560

"UTF-8" class="net.logstash.logback.encoder.LogstashEncoder"/>

"INFO">

"CONSOLE"/>

"FILE"/>

"LOGSTASH"/>

4.3配置yml文件

添加logstash配置文件路径

logging:

config: classpath:logstash-spring.xml

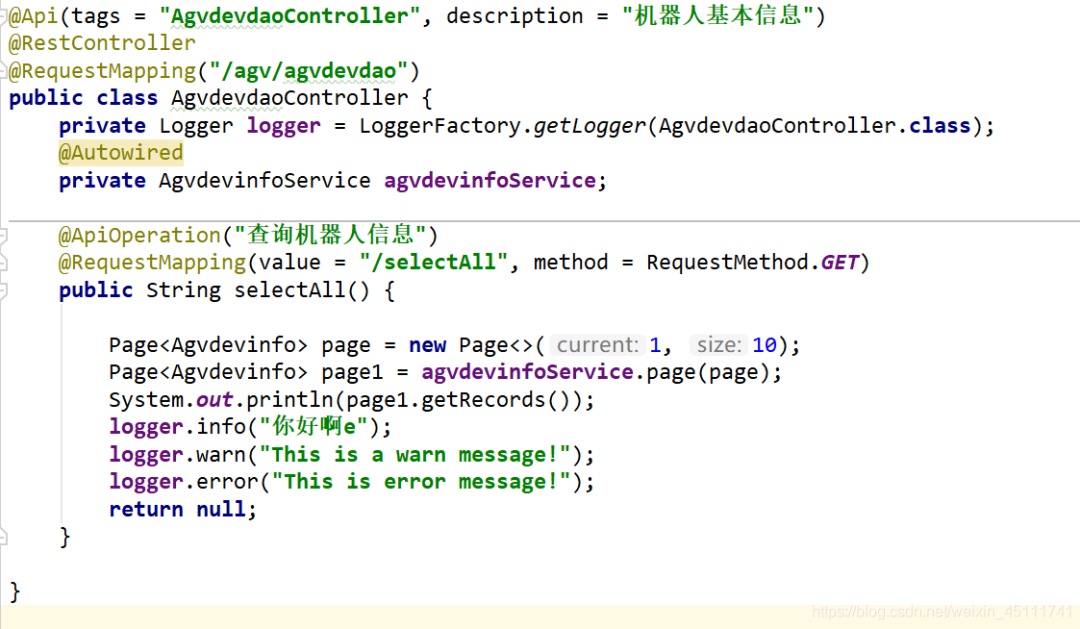

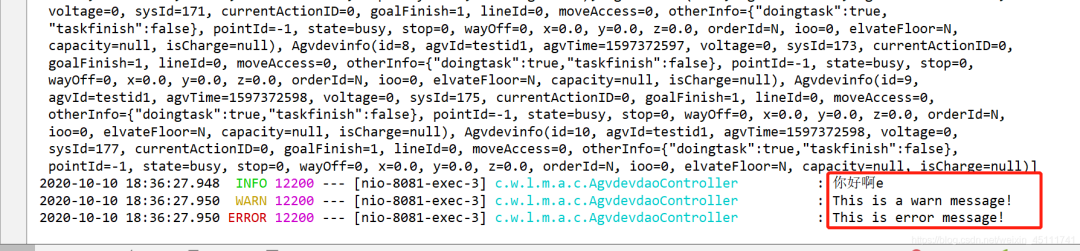

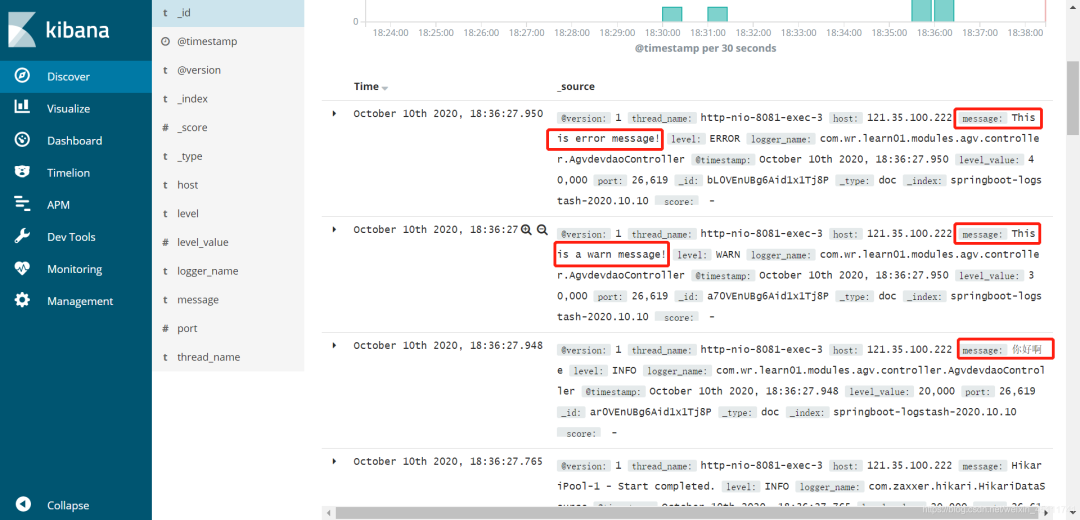

4.4测试

写了一个方法测试了一下

访问路径:http://localhost:8081/agv/agvdevdao/selectAll

控制台输出

在kibana中的日志信息

成功!!!

最后总结:

1.安装docker环境

2.获取elasticsearch,logstash,kibana的镜像

3.运行这三个容器

4.springboot集成logstash,将日志传输到elasticsearch

粉丝福利:108本java从入门到大神精选电子书领取

???

?长按上方锋哥微信二维码 2 秒 备注「1234」即可获取资料以及 可以进入java1234官方微信群

感谢点赞支持下哈