顶会“收割机”!周明“力压”Bengio总榜第一,清华第六,北大第八,张岳年度黑马

极市导读

近期,Marek Rei 再次发布2020年度机器学习和自然语言处理(ML&NLP)领域的年度统计。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

ML&NLP领域到底哪家单位实力最雄厚?哪位学者“冉冉升起”?中美之间实力差距到底如何?

2020年已经远去,围绕着AI研究实力的讨论仍在继续。

伦敦帝国理工学院机器学习和自然语言处理著名学者Marek Rei 教授从2016年起,每年都会对ML&NLP相关的会议论文进行统计和分析,并一年一度发表分析结果,目前已成为该领域权威性的报告内容。

近期,Marek Rei 再次发布2020年度机器学习和自然语言处理(ML&NLP)领域的年度统计。

从其分析中,我们可以看出:

在论文的发表数量中,来自西湖大学的张岳学者,在2019年统计的时候排名12,2020直接跳到了第2位,2020年一共发表了30篇文章;在2012~2020年区间统计中排名第三,排在榜首周明和亚军Yoshua Bengio的后面。

各个机构的比较中,谷歌高居榜首,而清华大学、北京大学、中国科学院,则是中国进入各大会议论文数总量前十的三所研究机构,分别排在第六、第八、第十。

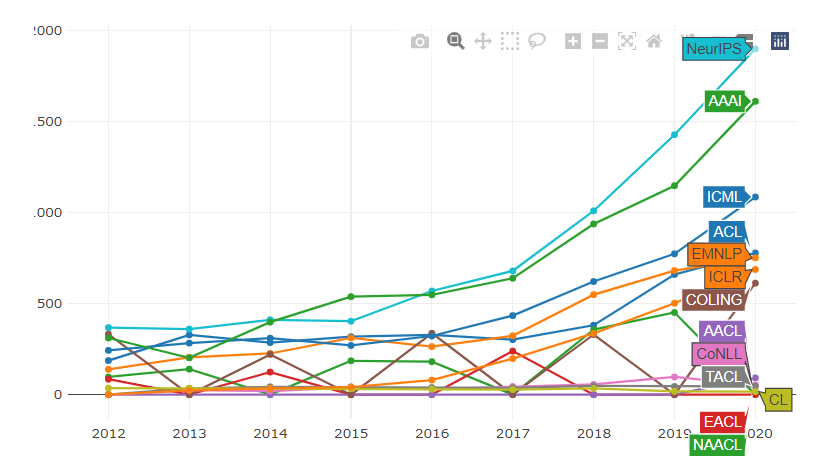

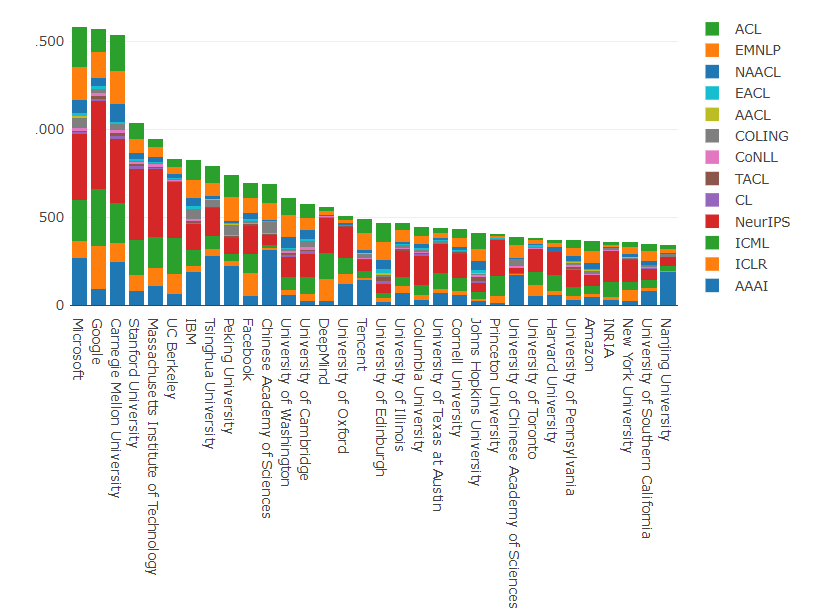

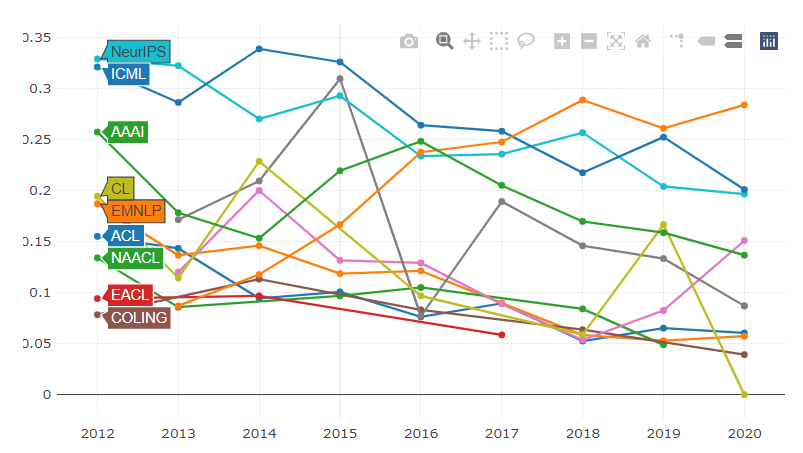

注:报告统计数据来源于2020年机器学习和NLP相关的会议和期刊,其中统计范围包括ACL,EMNLP,NAACL,EACL,COLING,TACL,CL,CoNLL,NeurIPS,ICML,ICLR,AAAI。由于作者是从Pdf文件以及相关程序中抓取的数据,因此数据可能存在偏差。所以作者提示,更应该关注总体趋势。

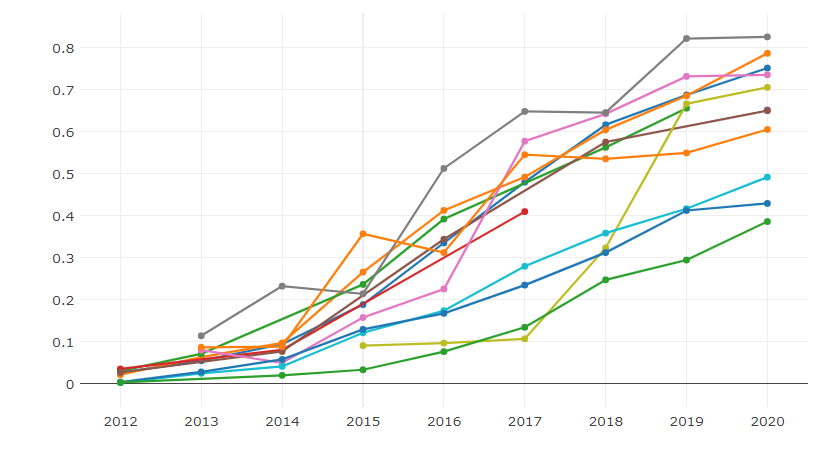

1 各大会议论文发表情况

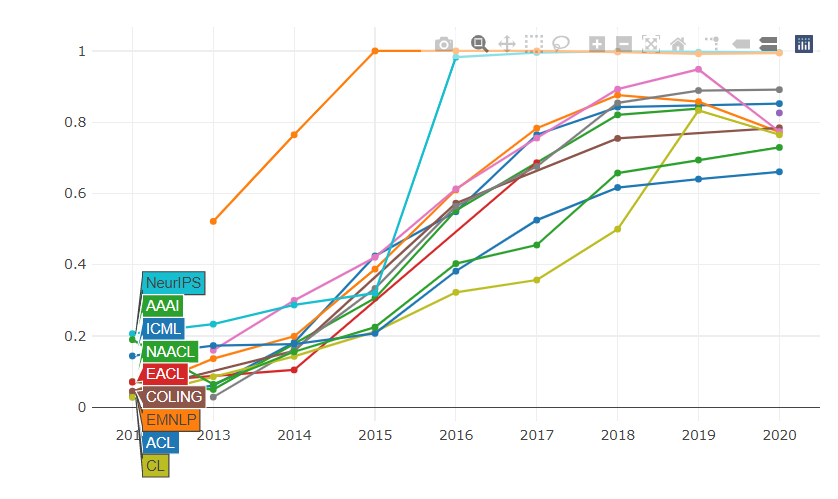

几乎所有顶会发表论文的数量都在2020年破了纪录,尤其是NeurIPS呈现指数上升趋势,在各大顶会位居榜首;AAAI在2020年也开始“提速”,不过自然语言处理领域的ACL和EMNLP在2020年增幅稍微放缓。

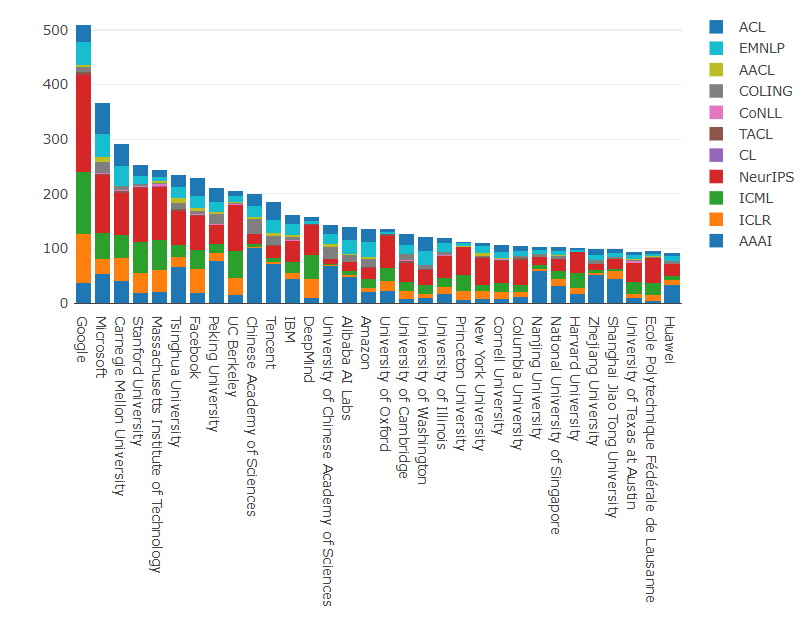

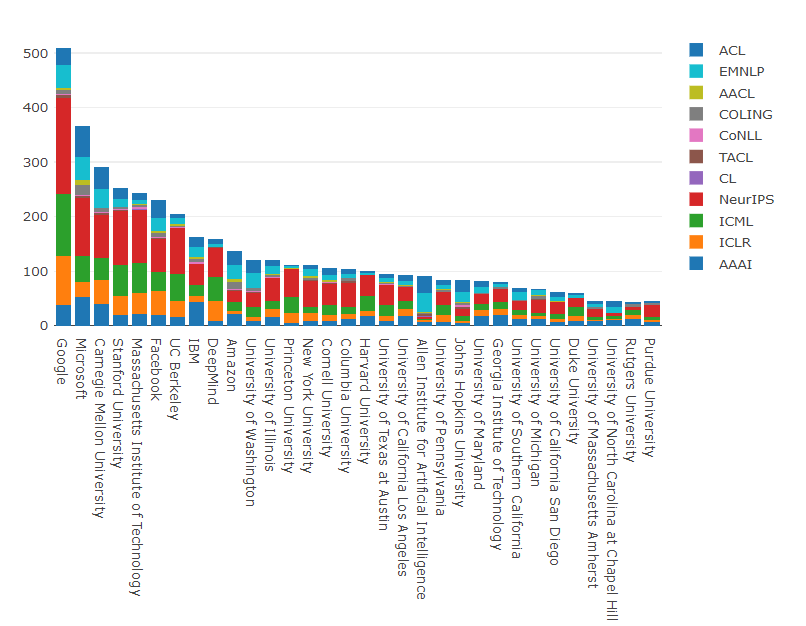

2 组织机构论文统计

2020年论文发表数量最多的机构是哪个呢?

其中谷歌顺利占据了领先地位,在各个领域都发表了大量的论文。例如,在NeurIps上,谷歌发表的论文数量是紧随其后的微软近两倍。微软和 CMU 也发表了大量的研究成果,在所有会议上发表的论文数总量分别排在第二、第三。

而清华大学、北京大学、中国科学院,则是中国进入各大会议论文数总量前十的三所研究机构,分别排在第六、第八、第十。其中,清华大学比去年上升一个位次,在ACL上发表了23篇,在Neurips上发表了65篇,在AAAI上发表了67篇,EMNLP上发表了20篇,ICML上21篇,ICLR上18篇。这也说明了近年来中国高校在学术论文上的影响力日益攀升。

九年磨一剑:微软、谷歌

纵观整个2012-2020年期间的统计数据,前三名势均力敌:微软仍以1580篇领先,谷歌以1570人紧随其后,CMU以1537排名第三。在中国方面,清华大学和北京大学分别排名第八名,第九名。

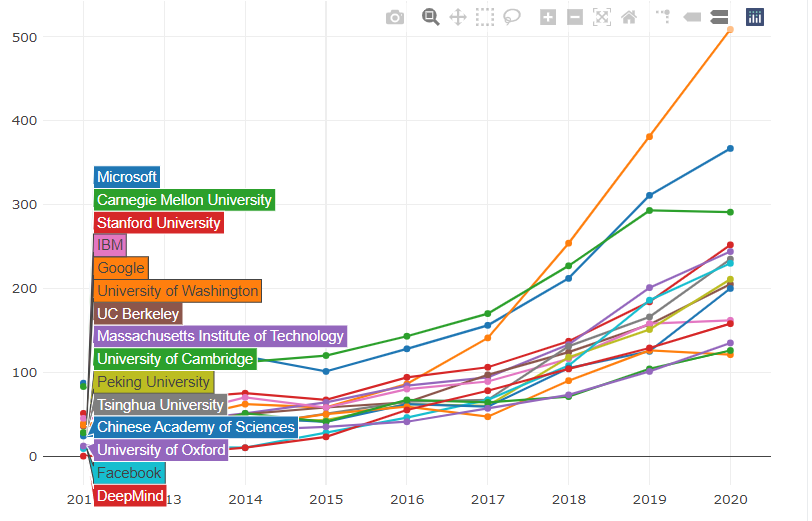

为了更清晰趋势,作者用一个线性的图表对这些机构每年的论文发表数进行展示。再过去几年里谷歌的论文发表数量趋势呈现一条45度的直线,CMU在今年开始走“下坡”,以后是否继续上升,我们不得而知。

另外,虽然在 2012年至2016年,谷歌发表的论文总数要比CMU和微软的少得多,但是从2018年开始,它的论文发表数就开始远超包括CMU和微软在内的其他所有机构。

其中,中国机构表现最突出的清华大学,虽然论文发表数量在前几年中都一直较大地落后于国外机构,但在所有机构总体上升的趋势下,有高于平均上升趋势的幅度。

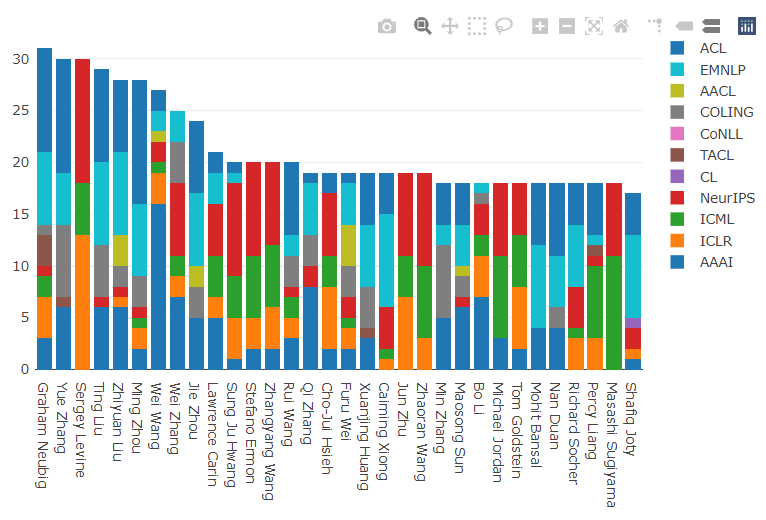

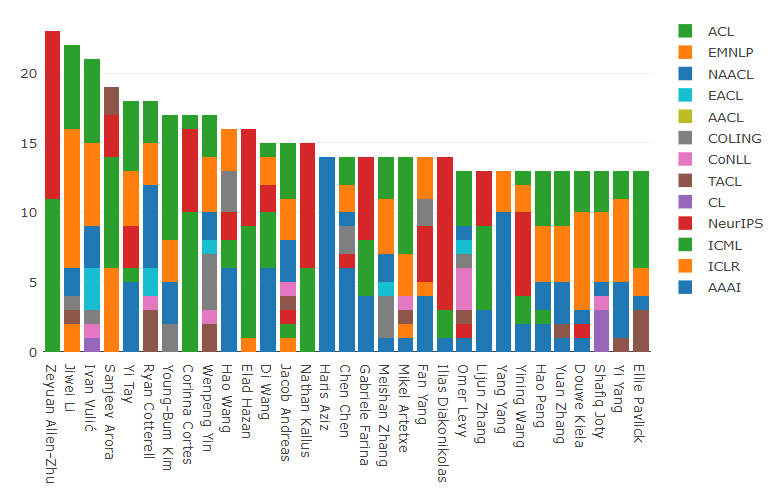

3 论文作者统计

就个人作者而言,CMU的GrahamNeubig在2020年总共发表了31篇论文,其中在ACL上10篇,EMNLP上7篇,TACL上3篇, NeurIPS上1篇,ICML上2篇,ICLR上4篇,AAAI上3篇。

来自西湖大学的张岳学者,在2019年统计的时候排名12,2020直接跳到了第2位,2020年一共发表了30篇文章;伯克利的 Sergey Levine从去年的第一“掉”到了今年的第三。哈工大刘挺(29),创新工场首席科学家,之前是微软亚研院副院长的周明(28)、清华刘知远(28)排名分别是第四、第五、第六。

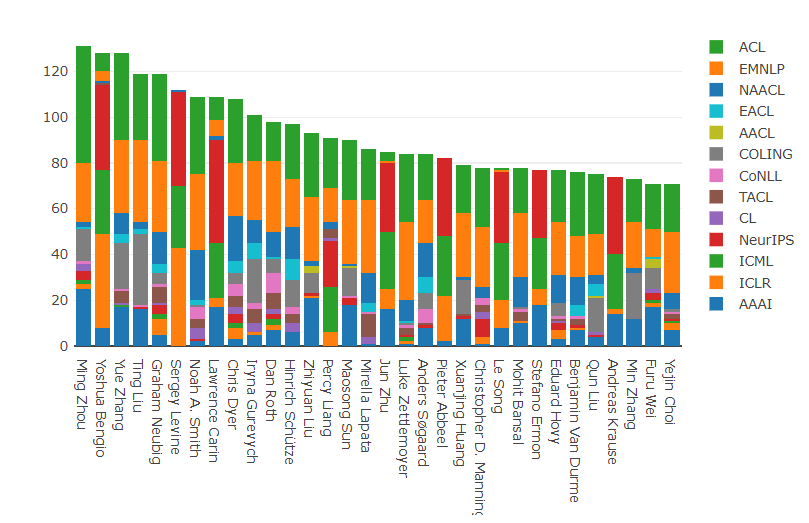

通过比较2012年至2020年整体的数量,周明大佬占据榜首,九年期间共发表了128篇论文。在2019年统计期间,周明还排名第二,由于2020年他发表了28篇论文,在加上Yoshua Bengio和Chris Dyer在2020年大幅度缩减了论文数量,因此周明一跃成为榜首。

相比较于去年,张岳和刘挺的整体排名都有所提高,得益于去年在论文发表方面的成功。

现在来看一作,上面亮相的,大多是一个研究团队的领头人,而只有一作,才是实际做研究、做实验写论文的人。

论文第一作者:朱泽园占据榜首

作者说,以往每年都会绘制一张图表用来展示当年的第一作者情况,但是由于研究者重名现象比较严重,而且没有方法消除这些名字的歧义,所以今年直接省略了这一步,直接看2012-2020年期间的总体统计数据。

朱泽园目前在位于雷德蒙德的微软机器学习与优化组工作,他作为第一作者分别在NeurIPS、ICML上发表了12篇和11篇,

据说,朱泽园可小到大都是保送,小学毕业被保送南外,高一被保送清华;国际比赛都是金牌,2005、2006两年蝉联国际信息学奥赛金牌;2009年ACM总决赛亚军,清华毕业后他去MIT读完了硕士和博士,做了两年博士后之后,2017年就进入了微软。

香侬科技的李纪为发表数量第二,22篇一作;再然后是剑桥大学的Ivan Vulić发了20篇。值得一提的是,朱泽园论文多发机器学习研究论文,李纪为和Ivan Vulić多研究自然语言处理。

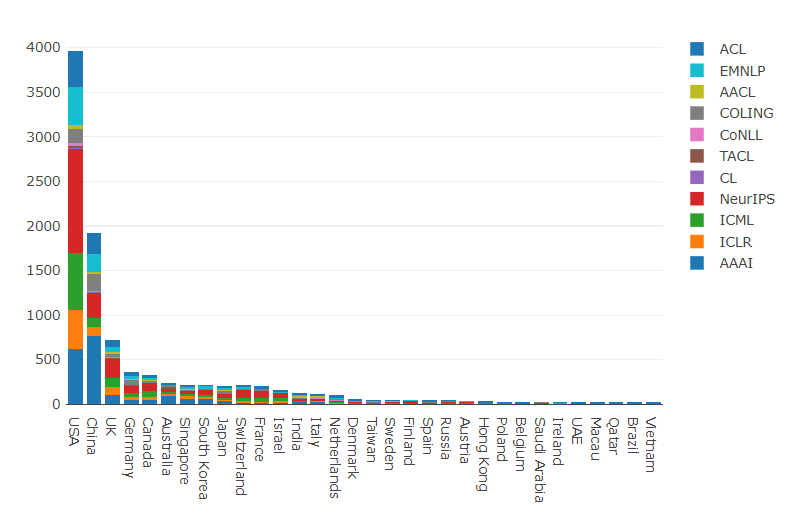

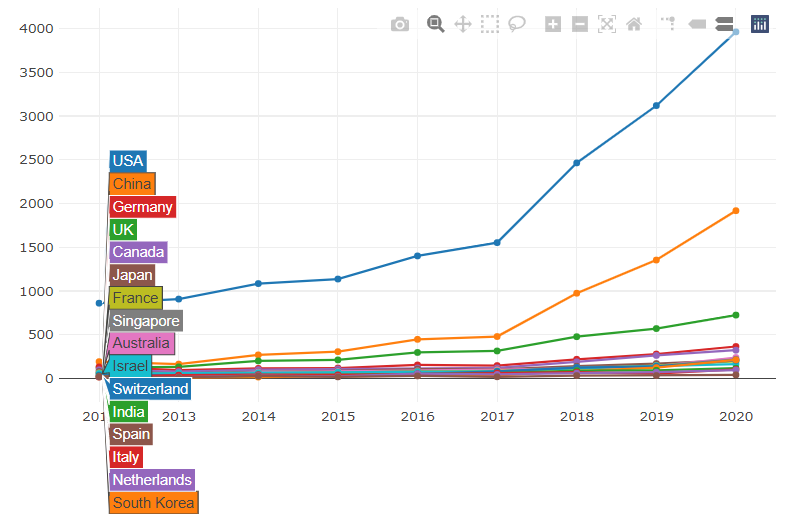

4 国家研究实力一览

上面这张统计图展示了美国在 AI 领域“力压群山”的主导地位,不过中国、英国、德国和加拿大在该领域所发挥的影响力也不容小觑。

总体而言,论文增多是一个总的趋势,大多数国家都在继续增加科学产出。虽然中国的论文发表数肯定每年都在增加,但美国似乎仍然想办法扩大了“研究实力”,大大领先中国的论文发表数量。另外,英国虽然在论文发表数量以及增长幅度上不及美国和中国,也还是牢牢锁住了第三的位置。

美国:企业主导

由于美国2020年的论文发表数量在所有国家和地区中占据了遥遥领先的主导地位,因而上面这张美国2020年论文发表数量统计图整体情况与各大机构2020年论文发表数量统计图差不多,谷歌依旧遥遥领先,而微软和CMU 依旧排在第二、第三。

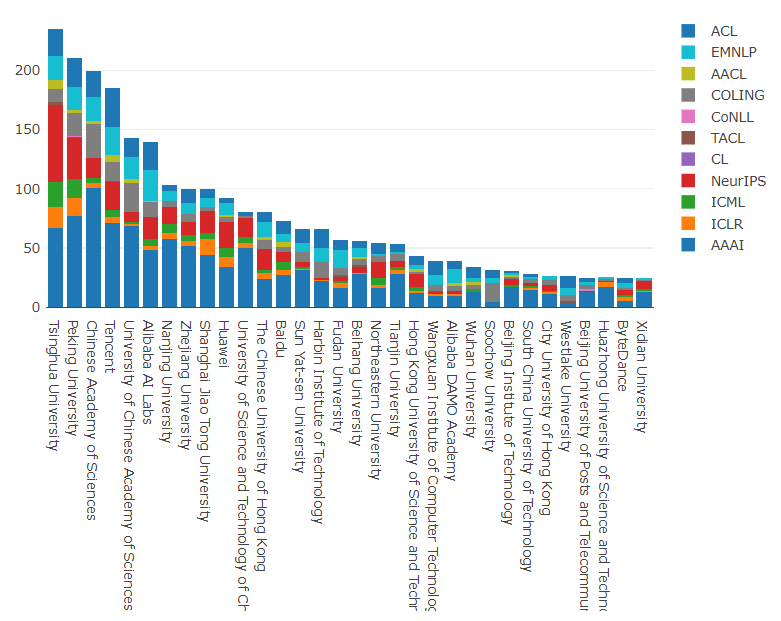

中国:高校领先

在中国,高校是论文发表的中坚力量,排在前十的有九所高校,仅有两家企业。

清华大学和北京大学分别锁住了第一、第二的宝座,二者在国际舞台上的表现同样不菲,是中国进入全球各机构论文发表排行榜前十仅有的两所高校,近年来对于 AI 领域的整体发展做出了较大的贡献和推动作用。

中国科学院、中国科学院大学、南京大学是论文发表数量排在第三、第五、第七的高校,三所高校在 中国乃至全球 AI 领域扮演的角色同样出类拔萃,不仅有该领域的领军人物坐镇,如周志华等,还有为 AI 领域培养了一大批人才,如中科院计算所等机构。

而企业同样是中国论文发表的一只辅助力量,其中腾讯、阿里巴巴、华为也“打”进前十,分别成立了科研性的实验室,近年来也发表了大量的科研论文。

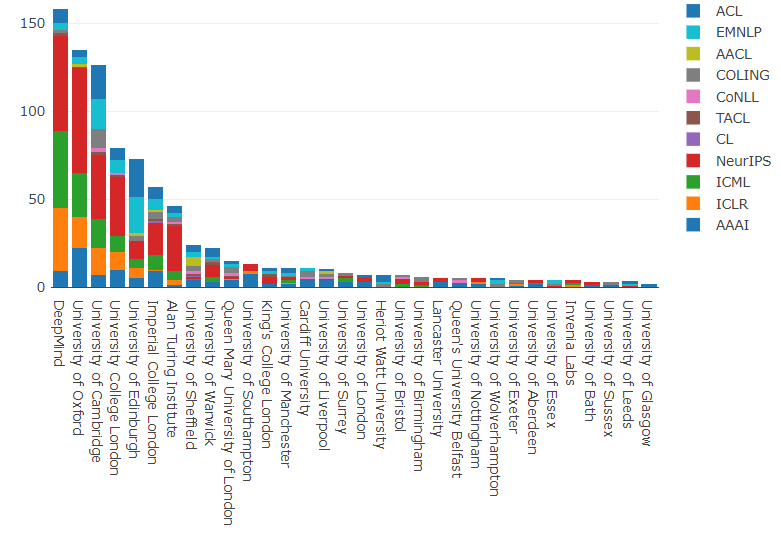

英国:DeepMind的传奇

在英国, 谷歌麾下的DeepMind 遥遥领先,其后是牛津大学、剑桥大学、伦敦大学学院、爱丁堡大学、帝国理工大学和阿兰图灵机构。

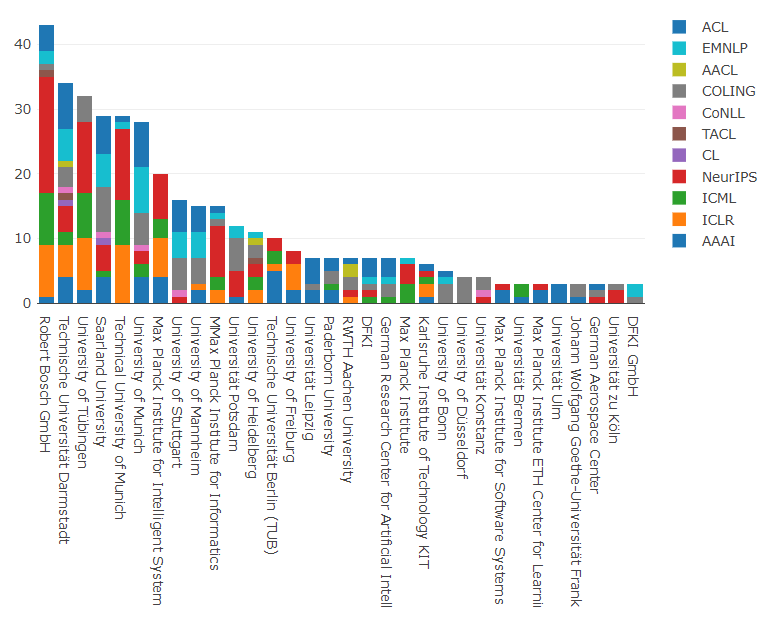

德国:NLP一家独大

在德国,罗伯特·博世有限公司总体论文发表数量排在第一,在今年的NeurIPS上取得了丰硕的成绩;达姆施塔特工业大学是论文发表数量排在第二,对NLP情有独钟;图宾根大学以和达姆施塔特工业大学相差不多的成绩排名第三。

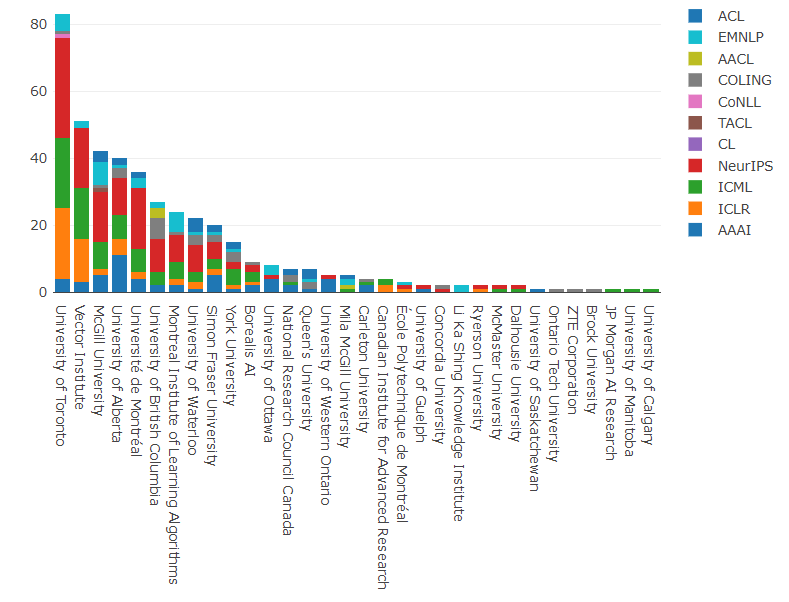

加拿大:多伦多大学一骑绝尘

在加拿大,多伦多大学的论文发表数量是各机构中最出类拔萃的,排在第一,随后是Vector 人工智能研究院、麦吉尔大学,分别排第二、第三。

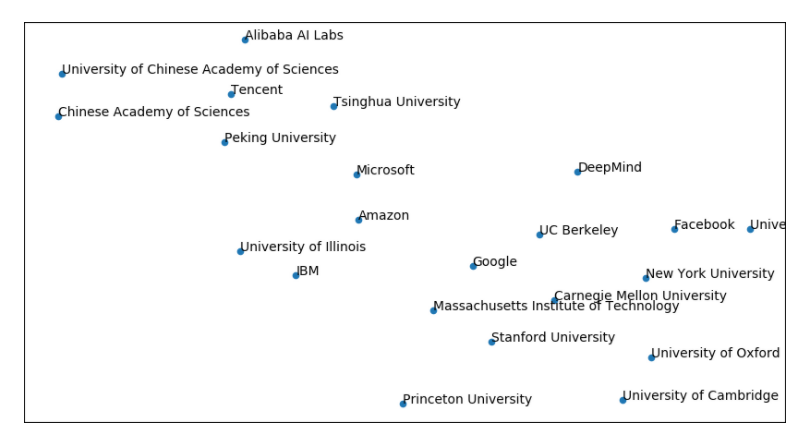

此外,Marek 也做了另外一项分析,即根据论文研究课题进行相似性分析,得出一些有意思的结论:

首先是组织之间的相似性,从下图可以看出,来自中国的大学主要集中在图的上部分,美国大学主要在图的右侧,微软、IBM、谷歌等企业在中间。因此可以看出研究课题即是非常具有区域性的,高校之间的相互合作受地域影响很大,而企业则相对就比较灵活。

5 OMT:关键词分析与有趣的统计

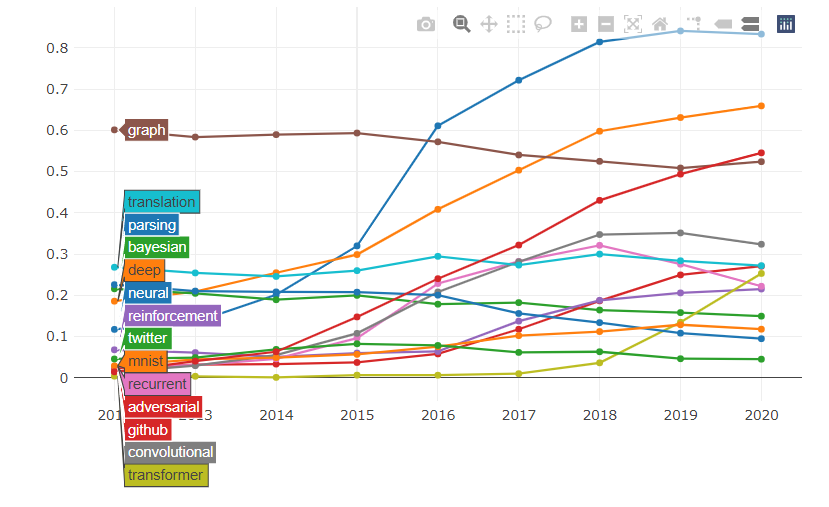

有趣的是,这些年来“神经”一词如何越来越流行,目前已稳定在所有论文的80%以上。“递归”和“卷积”方向朝下,而“变压器”则具有陡峭的上升轨迹。很高兴看到“ github”逐渐兴起,这意味着更多的论文正在使它们的源代码可用。

仅查看关键字“ neural”,ICLR和NeurIPS中的大多数论文都提到了它。在其他会议中,这一比例也一直很高。有趣的是,近年来EMNLP,CoNLL和CL实际上减少了使用neural关键词的比例。

至少在CoNLL中,其中一些“神经”已被“贝叶斯”代替。对于EMNLP,趋势更加稳定。对于大多数会议,“贝叶斯”比例总体上似乎略有下降趋势,但CoNLL和ICLR除外。

“github”一词确实表明,会议论文公开源代码正变得越来越普遍。与所有机器学习会议相比,自然语言处理会议在这方面的表现仍然要好得多,TACL和EMNLP的论文中有近80%提到了github。相比之下,ICLR约为60%,而AAAI最低,为40%。

“Task-Oriented Dialogue as Dataflow Synthesis” 一文有45位作者合力完成,荣获在合作者数量方面荣获历史第二位。

论文名字最长的是ACL 2020上的“Code-Switching Patterns Can Be an Effective Route to Improve Performance of Downstream NLP Applications: A Case Study of Humour, Sarcasm and Hate Speech Detection ”。

名字最短的当属NeurIPS的论文“Ode to an ODE ”。

参考资料:

https://www.marekrei.com/blog/ml-and-nlp-publications-in-2020/

推荐阅读

2021-03-07

2021-03-06

2021-03-05

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

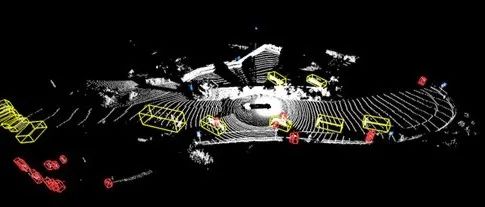

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~