大模型(LLM)下载的四种方式

作者:江流儿的NLP

文章地址:https://zhuanlan.zhihu.com/p/662017962

因为大模型动辄十几GB的大小,因为对于开发人员来说,环境搭好了,模型还要好几个小时。

模型下载的四种方式:

1、Hugging http://face.cn上手动下载模型及其文件,需挂vpn下载

因为外网下载,所以速度依赖于你的外网网速

https://huggingface.co/baichuan-inc/Baichuan2-13B-Chat-4bits/tree/main-inc/Baichuan2-13B-Chat-4bits/tree/main

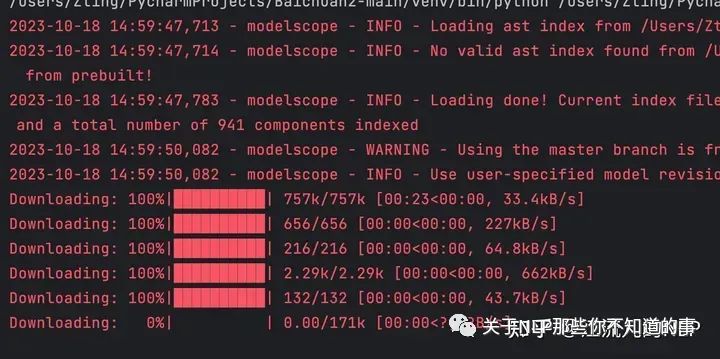

2、阿里的modelscope上下载,无需vpn,如果你的网速还行,建议这种方式

首先需要安装modelscope

pip install modelscope# 从modelscope上下载模型from modelscope.hub.snapshot_download import snapshot_downloadmodel_dir = snapshot_download('baichuan-inc/baichuan-7B', cache_dir='./model', revision='master')如果你网速很好,下载就很快,如果是kb/s,那么大文件下载会失败。

modelscope下载模型ing

3、huggingface的镜像网站aliendao网站下载,无需vpn,非开发者需手动下载

互链高科 (非开发者或者怕麻烦可以直接去网站手动下载)

开发者在aliendao的下载器上下载 https://github.com/git-cloner/aliendao

# 开发者可以直接看这里,这里的操作是在你已经有了一个python3.7以上的环境下,可以直接下述操作# 如果你没有的话,移步 https://github.com/git-cloner/aliendaogit clone https://github.com/git-cloner/aliendaocd aliendaopip install -r requirements.txt -i https://pypi.mirrors.ustc.edu.cn/simple --trusted-host=pypi.mirrors.ustc.edu.cn# 带上mirror参数,优先从aliendao.cn镜像下载python model_download.py --mirror --repo_id baichuan-inc/Baichuan2-13B-Chat-4bits

让公司的运维测了,aliendao的带宽很慢,即便你的网速很快,速度也非常一般,而且这个网站模型不全。

aliendao方式下载模型

4、huggingface的镜像网站

https://hf-mirror.com/baichuan-incinc

网速很快,公司运维有测到4M/s,非常推荐用这个网站直接下载

最后,也可以参考小五哥:如何快速稳定地从huggingface下载模型去更快速地下载你的模型。

上述几种方式可以都试试,找到最适合自己的,和朋友聊的时候,朋友说其实最快的方式是让别人给你下好了,直接传给你。这也不失为一种高效下载的方式,而且很受用。来自朋友的力量。

huggingface的镜像网站下载llama2系列模型如何加认证的信息啊?

加 huggingface access token 就可以下载,wget --header="Authorization: Bearer <hf_token>" url ,如果是git clone,则提示输密码时输入access token。

评论