分析 | 激光雷达vs纯计算机视觉 自动驾驶的两大流派

激光雷达流派和纯计算机视觉流派一直在自动驾驶技术中的感知层解决方案上喋喋不休。激光雷达派认为纯视觉算法在数据形式和精度上的不足;纯视觉流派则认为激光雷达不必要且过于昂贵。本文将对激光雷达、摄像头以及毫米波雷达等主流传感器、各自动驾驶公司的解决方案以及传感器市场格局作介绍。

特斯拉CEO马斯克近日在“自动驾驶日”推出了全自动驾驶计算机”(full self-driving computer),即之前所说的Autopilot硬件3.0。

与上一代由英伟达芯片驱动的Autopilot相比,新硬件每秒帧数处理能力提高了21倍,且相比Autopilot 2.5版本,每辆车的硬件成本降低约20%。

与其他自动驾驶公司不同的是,特斯拉的Autopilot一直是感知层中视觉主导方案的拥簇,另一种方案的主导则是激光雷达(Lidar),代表是除特斯拉外的绝大多数公司。

实际上,激光雷达流派和纯计算机视觉流派一直在自动驾驶技术中的感知层解决方案上喋喋不休。一个被激光雷达派接受的观点是,考虑到纯视觉算法在数据形式和精度上的不足,L3 级以上的自动驾驶乘用车必须要采用激光雷达。

特斯拉FSD的发布意味着其纯视觉方案也可更进一步,甚至有可能率先达到“机器开车人辅助”甚至“机器开车”的L3、L4级别自动驾驶。

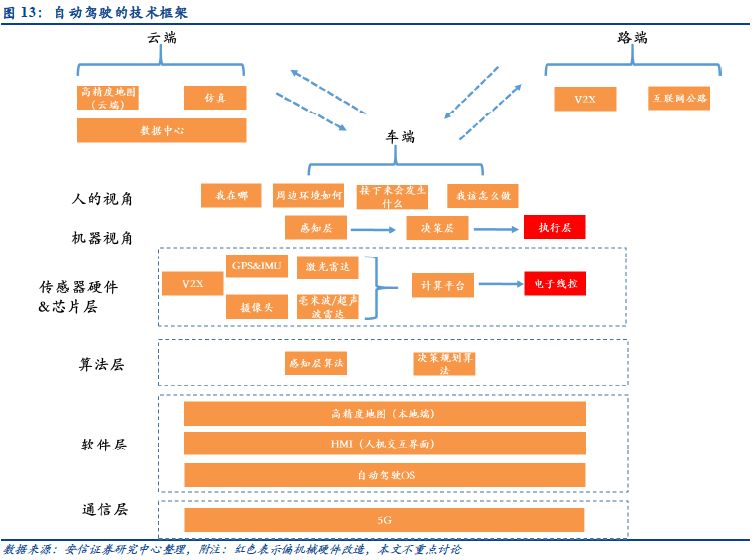

那这两大流派究竟争得是什么呢?首先需要说明自动驾驶技术的基本原理。

自动驾驶技术基本原理是:感知层的各类硬件传感器捕捉车辆的位置信息以及外部环境信息。决策层的大脑基于感知层输入的信息进行环境建模,形成对全局的理解并作出决策判断,发出车辆执行的信号指令。最后执行层将决策层的信号转换为汽车的动作行为。

也就是说,上述的激光雷达方案和纯视觉方案都是自动驾驶车辆对外界环境感知的一种方式,但感知的主导不同。视觉主导方案以摄像头为主导,配合毫米波雷达、超声波雷达、低成本激光雷达;激光雷达主导方案以激光雷达为主导,配合毫米波雷达、超声波传感器、摄像头。也有人认为还有第三种方案,即两者都是主导。

需要注意的是,特斯拉在视觉主导方案中显得更为极端,它甚至完全弃用了激光雷达。马斯克甚至扬言,“傻子才用激光雷达,现在谁要还是靠激光雷达,那就要完蛋(doomed),注定完蛋!”

激光雷达和摄像头的技术原理

激光雷达顾名思义,其工作原理是利用激光进行探测和测距技术,通常位于汽车顶部,可以360度监测。在其内部,每一组组件都包含一个发射单元与接收单元。

探测距离的原理是基于光返回的时间,激光二极管发出脉冲光,脉冲光照射到目标物后反射一部分光回来,在二极管附近安装一个光子探测器,它可以探测出返回来的信号,通过计算发射和探测的时间差就可以计算出目标物的距离。

脉冲距离测量系统一旦被激活就能收集到大量的点云。如果点云中有目标物,目标物就会在点云中呈现出一个阴影。通过这个阴影可以测量出目标物的距离和大小。通过点云可以生成周围环境的三维模型。点云密度越高,图像越清晰。

总体而言,我们可以认为激光雷达最重要的两个属性是测距和精度。与摄像头不同的是,它是“主动视觉”。激光雷达可以主动探测周围环境,即使在夜间仍能准确地检测障碍物。因为激光光束更加聚拢,所以比毫米波雷达拥有更高的探测精度。

相比之下,摄像头的工作原理很容易理解,就像人眼那样,物体反射的光通过镜片在传感器上成像。它没有激光雷达那用强大的测距能力,且受环境光照的影响很大;但摄像头有一个极大的优势,在于人眼就能看懂摄像头拍摄的内容,使其非常适用于物体分类。

特斯拉人工智能和自动驾驶视觉总监 Andrej Karpathy就表示,世界是为视觉识别而构建的,激光雷达很难分辨塑料袋和轮胎的区别。“某种意义上,Lidar(激光雷达) 是一个捷径。它回避了对自动驾驶非常重要的视觉识别基本问题,给人一种虚假的技术进步了的感觉”。

此外,较为主流的传感器还包括雷达(Radar),又可分为毫米波雷达和超声波雷达。前者的特点是探测距离最远,可超200米,同时不受天气情况和夜间影响,其几乎是自动驾驶系统的标配;后者的探测距离最小,负责3米以内的近距离监测,用于盲区探测,变道、泊车辅助等。

两大流派究竟争的是什么?

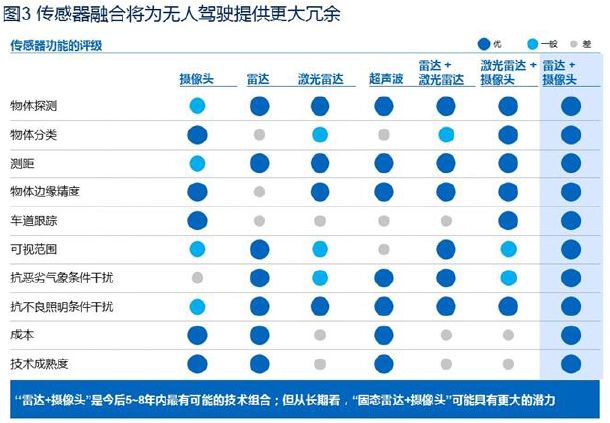

激光雷达、摄像头、雷达等不同传感器侧重点不尽相同。实际上,早期的自动驾驶公司感知以激光雷达为中心,如今大多以多传感器融合为主,也有少数公司以计算机视觉为主。

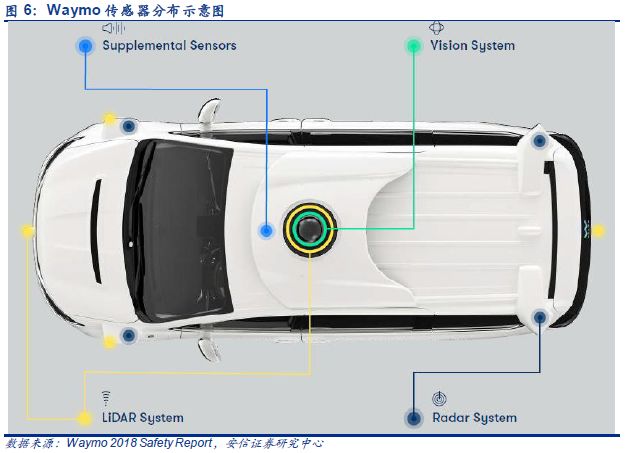

我们以当前自动驾驶水平最高的Waymo为例,其搭载了摄像头、毫米波雷达、激光雷达、音频探测系统等传感器。

Waymo的视觉系统由几组高分辨率的相机组成,设计用于在长距离、日光和低光照条件下工作;毫米波雷达则使用波长来感知物体和运动,能够在白天、黑夜、雨雪天气中有效工作;激光雷达则用于360度的测距。

然而,只有特斯拉完全不使用激光雷达。相对于激光雷达的超强的探测能力,首先需要说明其一个显著缺点,即成本,据中信建投报告,Lidar成本高于2万,而摄像头最多仅2000,雷达则更便宜。这与现阶段Lidar技术还不够成熟有关,也导致设备影响整车的外型。

不过,近日外媒报道称苹果正与至少四家公司谈判,希望能够寻找到比当前更小、更便宜、更容易批量生产的自动驾驶汽车的下一代Lidar传感器;也有知情人士表示苹果可能正在自主研发Lidar传感器。

特斯拉CEO马斯克则曾解释过弃用激光雷达的技术原因,在与视觉相结合上,马斯克认为一些公司会用错误的波长来做主动质子发生系统,他称4mm的波长是合适的,而400 nm - 700 nm 的范围内的主动质子发生器很愚蠢。

这是马斯克与当前整个行业的分歧。但进一步而言,以摄像头作为传感器的主导实际上得到了行业的认可。在所有传感器中,摄像头拥有最丰富的线性密度,其数据量远超其他类型的传感器。基于图像信息密度最高的优势,使得它处于整个感知融合的中心地位。

问题在于,现有的无人驾驶公司认为,视觉潜力巨大,激光雷达也许有一天会退出历史舞台,但今天的计算机视觉和 AI 发展发展成熟度绝无可能独立完成感知。而马斯克则认为激光雷达的加入会让技术路线误入歧途,所有人的终极目标都是摄像头实现感知。

特斯拉与其纯视觉流派

如上所述,特斯拉不使用激光雷达的底气在哪里呢?

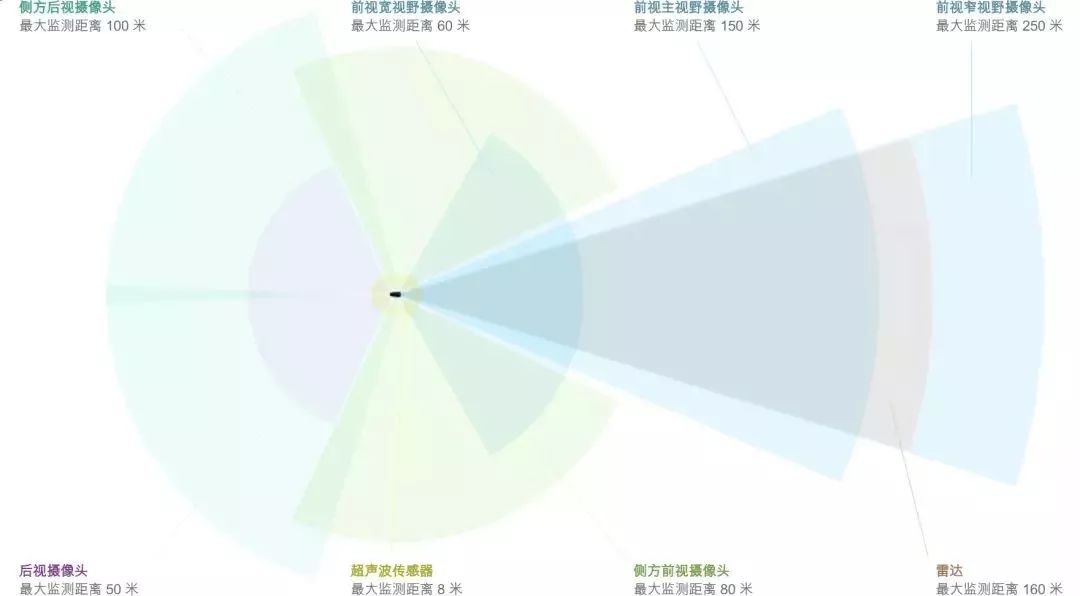

首先需要说明其自动驾驶系统的配置。特斯拉Autopilot的感知工作主要依赖3个前置摄像头、2个侧方前视摄像头、2个侧方后视摄像头、1个后视摄像头、12个超声波传感器、1个毫米波前置雷达。

车辆可以通过这8个摄像头360度检测周围环境,雷达则负责探测前方障碍物的距离及行进速度,且不受天气影响;这几乎在功能上取代了激光雷达传感器,同时降低了自动化系统的成本。

更为重要的是特斯拉的神经网络图像识别算法,基于其自研的计算机芯片以及大量配套的软件算法。实际上,特斯拉的每一位司机其实都参与到了神经网络的训练中,每一个新手都将为特斯拉的自动驾驶系统喂入新的数据。

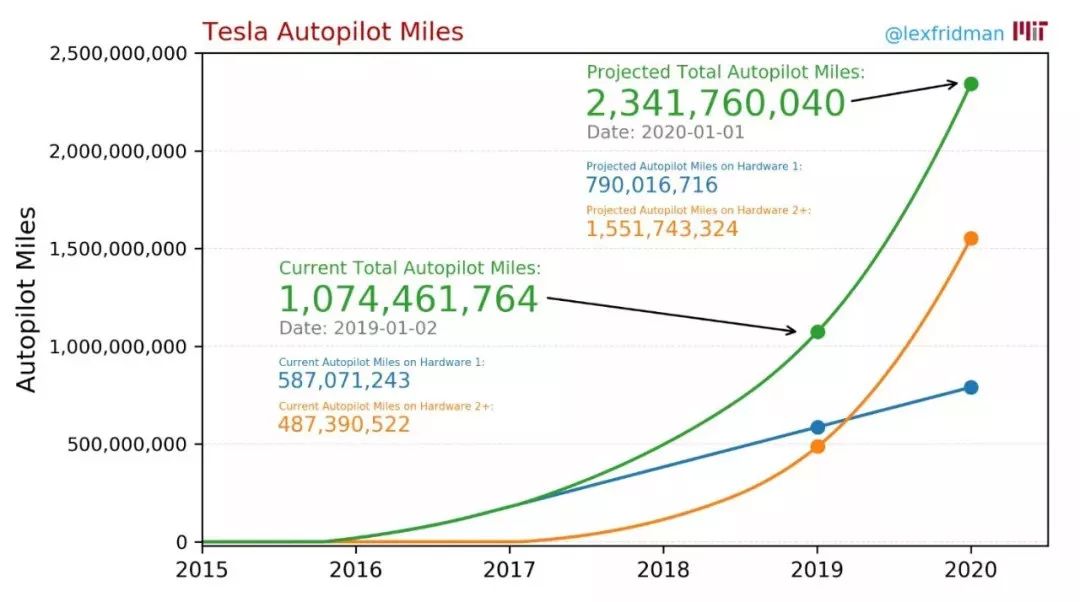

MIT 按照特斯拉公布的交付量、特斯拉汽车平均行驶里程和 AP 启动状态下行驶里程计算,到 2019 年,特斯拉累计路测数据已经达到 4.8 亿英里,到 2020 年(估算)将突破 15 亿英里。按照 Elon 的说法,特斯拉路测数据占全行业总路测数据的 99%。

Andrej Karpathy指出,特斯拉的 AI 软件能够处理来自视觉传感器收集到的车道线、交通、行人等信息,将这些信号与已知的物体进行匹配再最终作出决策。

同时,在数据的标注上,特斯拉也正在尝试本地自动化标注提高识别率。只有出现摄像头完全无法理解或引起混乱的图像,才会上传到云端,由工程师进行标注,导入神经网络进行训练,直到神经网络掌握对该场景的识别。

此外,全球各地不同国家有着完全不同的路况、交规、暴雨、冰雹、大雾、甚至洪水、火灾、火山等罕见的长尾场景。每一次 AP 启用状态下的人为介入接管,系统都会记录下该场景的信息和数据,并自行学习人类的决策和驾驶行为。

传感器的市场空间

最后需要说明当前产业中摄像头、激光雷达、雷达的市场格局。

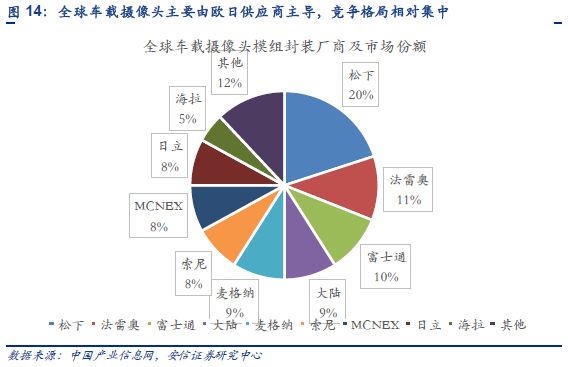

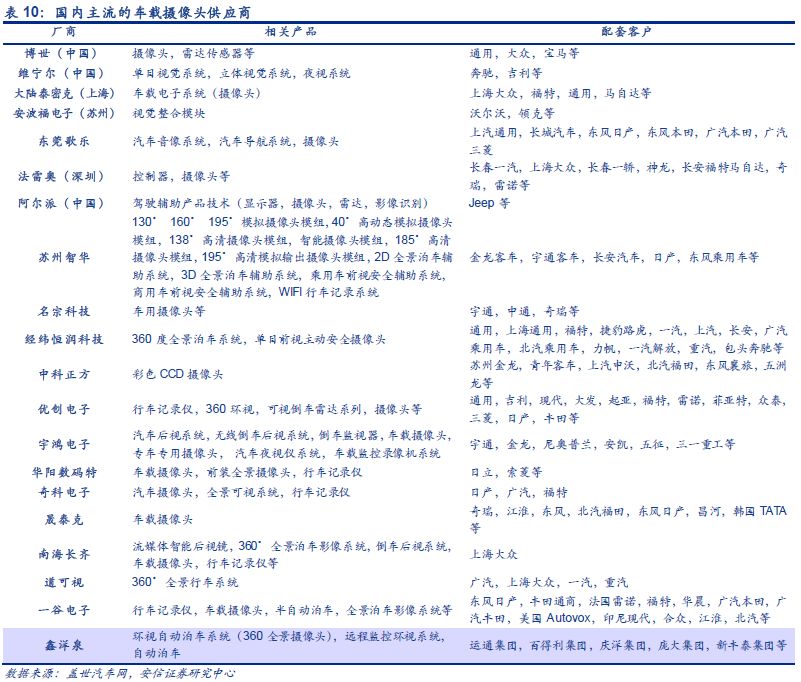

摄像头方面,车载摄像头的壁垒主要在于模组封装和客户壁垒,目前来看,国际上松下、索尼等占据了较大的市场份额,但是总体的竞争格局并不是很集中,除了松下占据了20%的市场份额以外,其后的8名主要竞争对手市场份额相互差距都不大,国内舜宇光学、欧菲光、德赛西威等已开始全面进入车载摄像头模组封装制造中。

当前外资供应商占据主流地位,未来,随着自主供应商技术不断成熟,规模日渐扩大,凭借着快速响应和性价比的传统优势,将有望开启对外资供应商的替代。

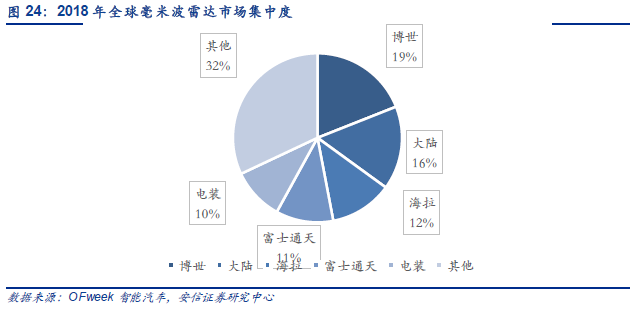

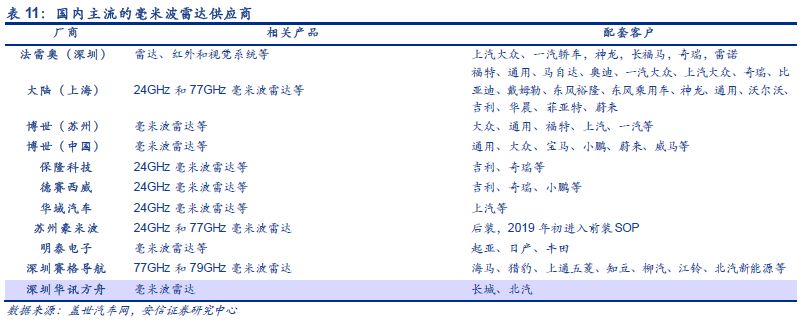

毫米波雷达方面,全球市场基本被以博世为首的外资汽车零部件巨头垄断,其中博世以77GHz毫米波雷达为主。

据OFweek的统计数据显示,目前中国24GHz车载雷达市场主要由法雷奥、海拉和博世等主导,合计出货量占比高达60%以上。中国77GHz车载雷达主要由大陆集团、博世和德尔福等主导,合计出货量占比高达80%以上。综合来看,中国市场当前仍在外资寡头的垄断之下。

国内的毫米波雷达市场当前被大陆、德尔福、博世等国外零部件巨头垄断,并且也在不断推出更新更好的产品。安信证券称,当单品性能和价格不足以和国外供应商拉开差距,打包做解决方案是比较好的突围路径,包括整个系统有多少冗余,提供定制化服务。

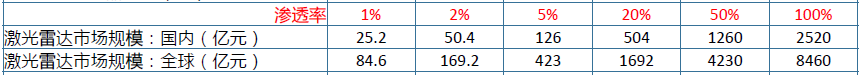

激光雷达虽然在汽车领域是还不够成熟的技术,但在军事、气象等领域早有广泛应用,然而需求并不大。随着当前对L3级别自动驾驶的需求,激光雷达或开始渗透进消费领域。

对激光雷达厂商而言,需要追求的厂商追求仍是在保证基本性能的情况下,尽可能降低成本。只有这样才能真正进入消费级市场。