GPU底层优化 | 如何让Transformer在GPU上跑得更快?

来源:计算机视觉研究院

计算机视觉研究院专栏

作者:Edison_G

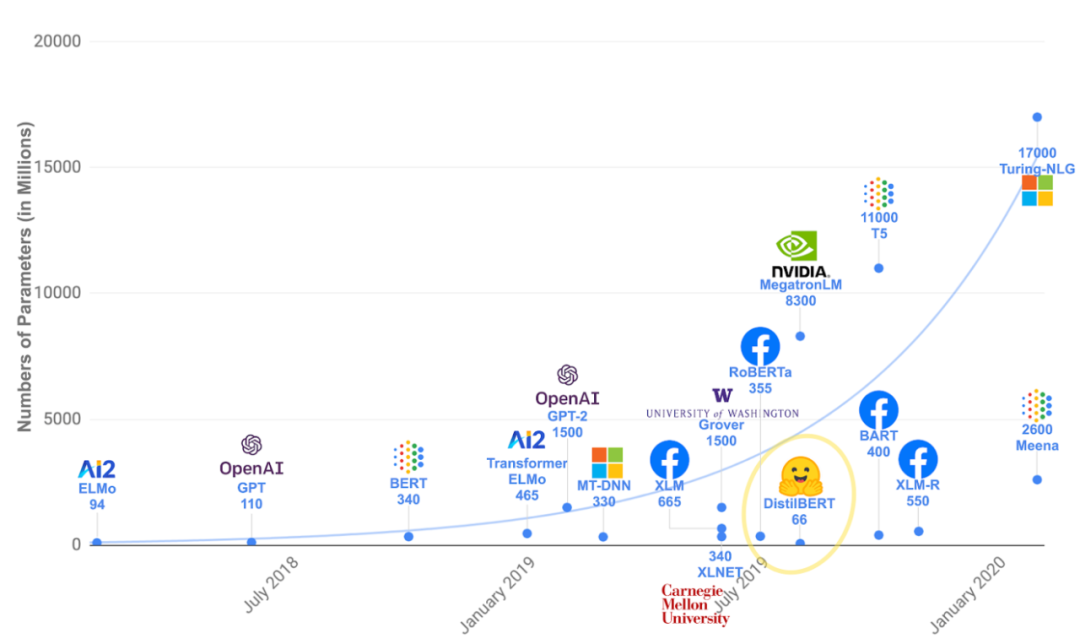

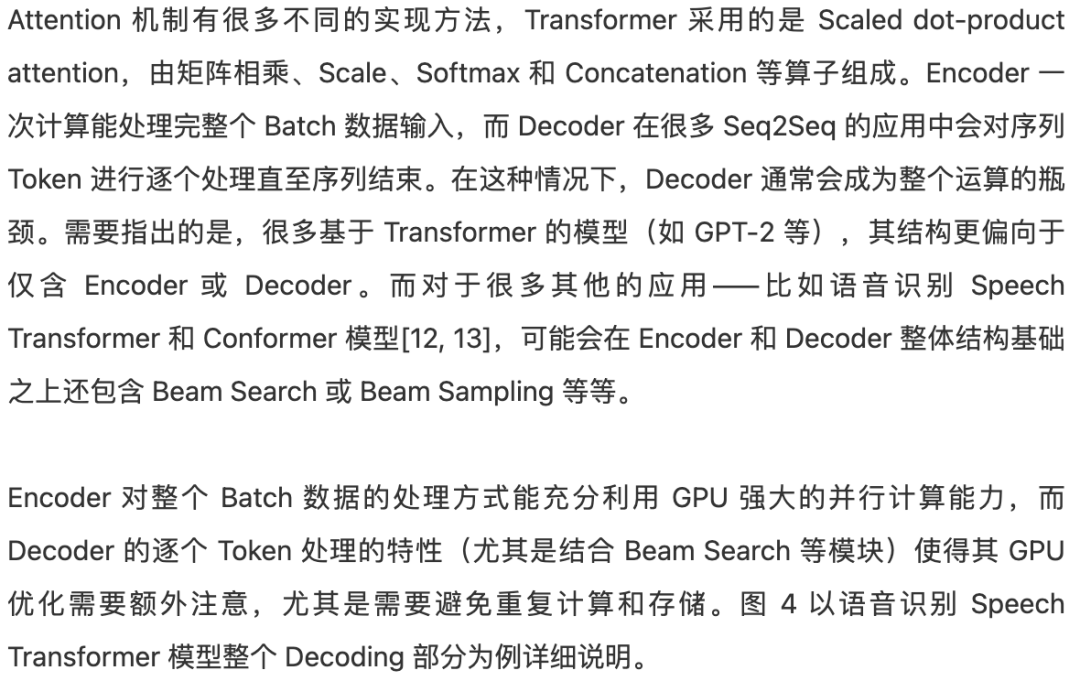

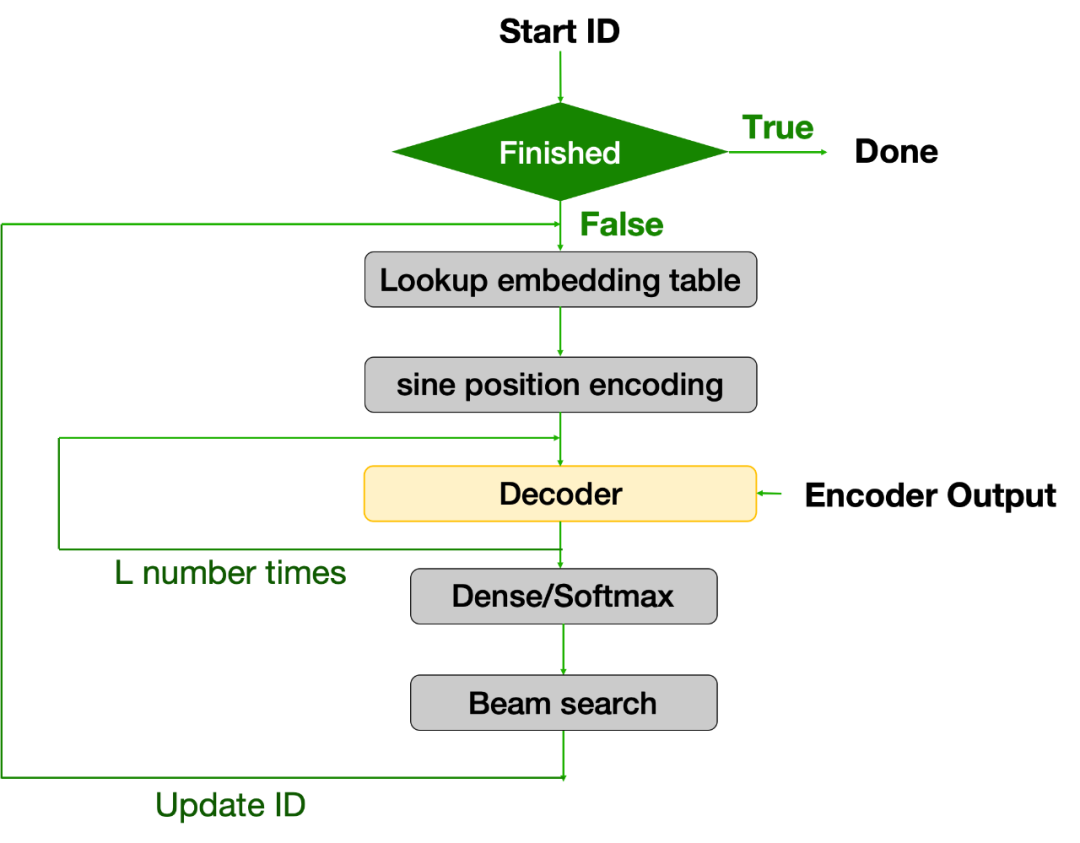

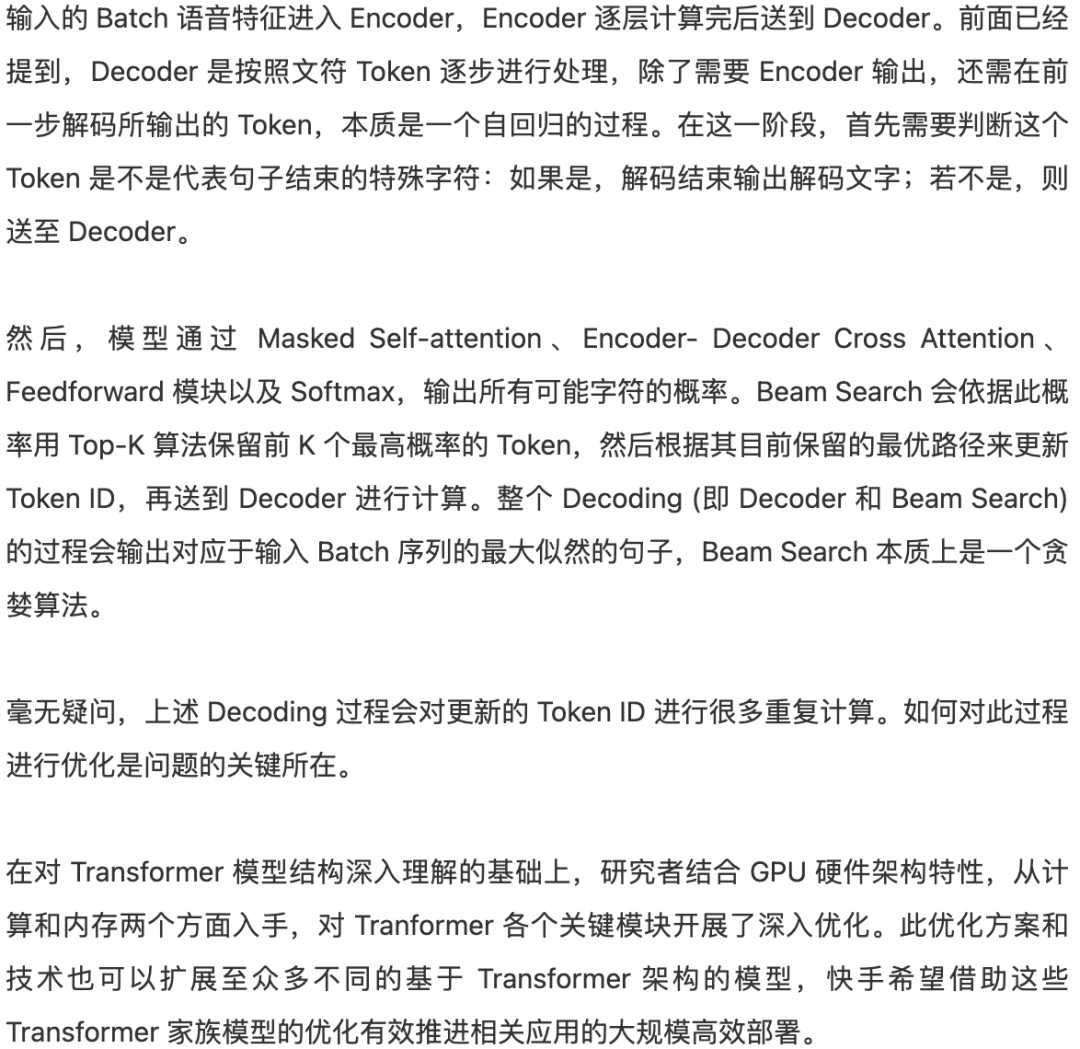

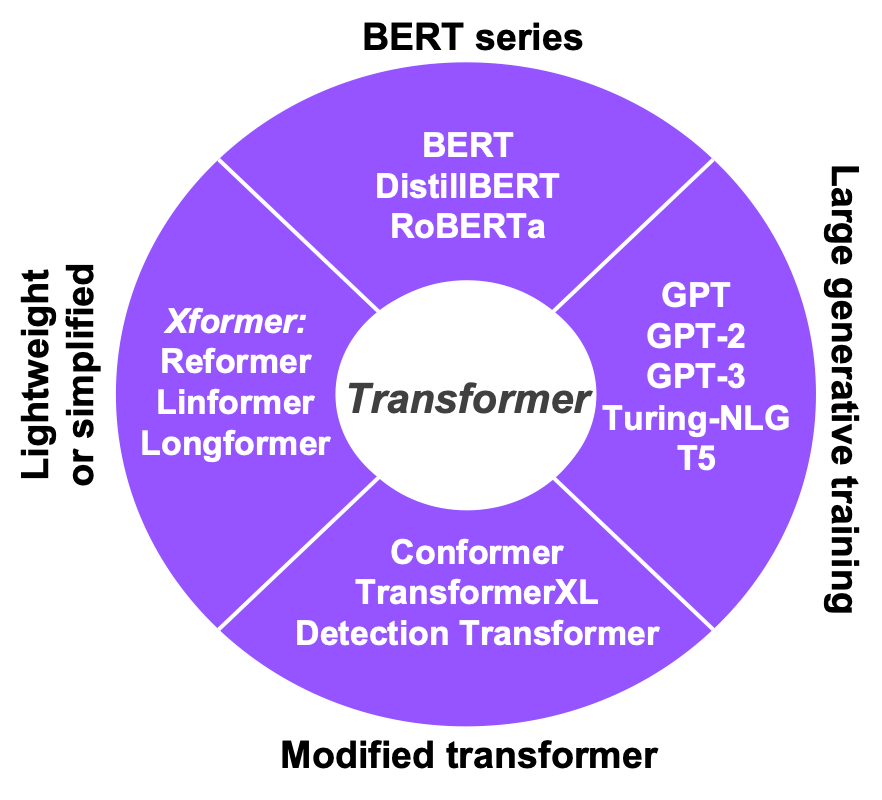

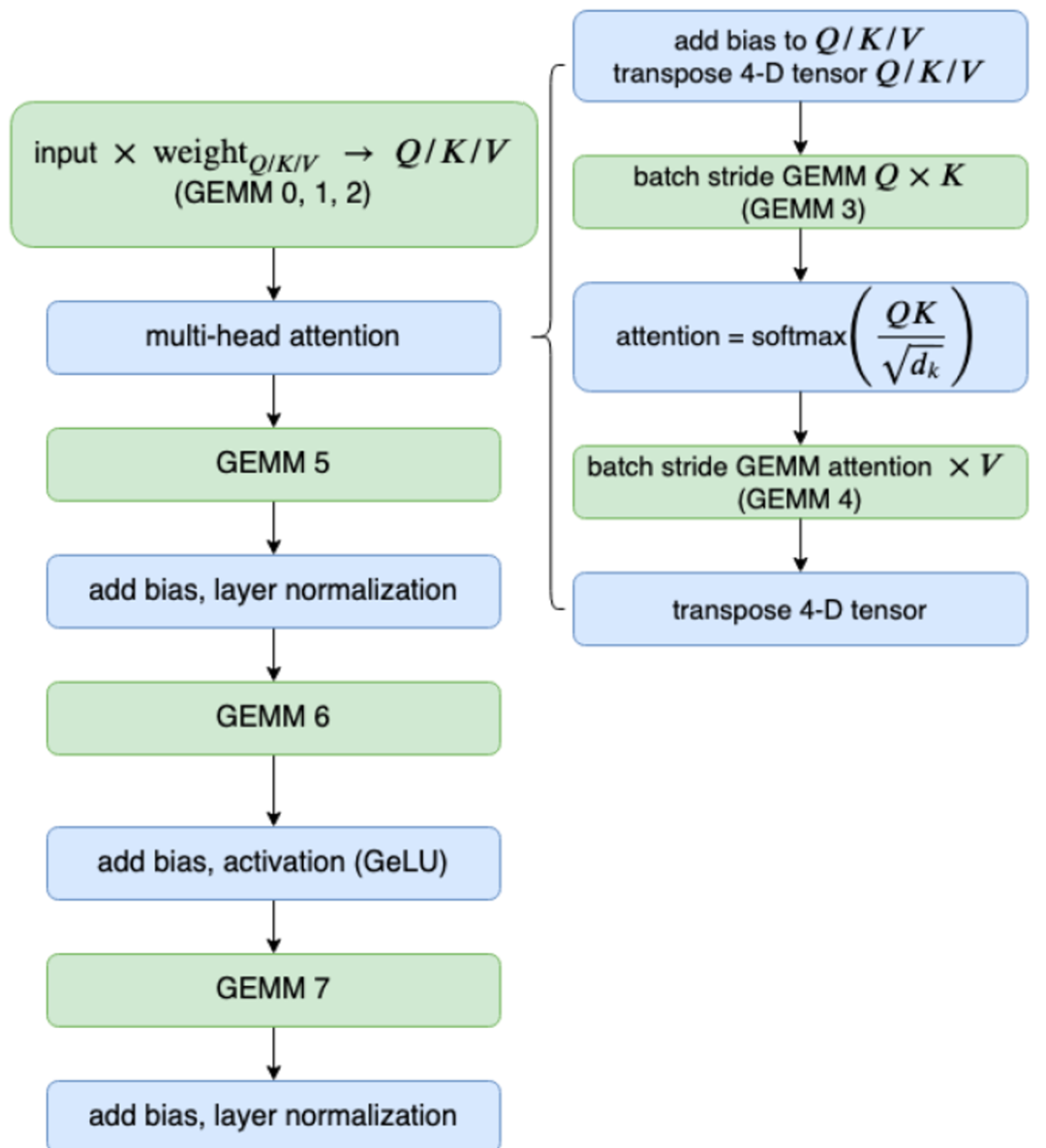

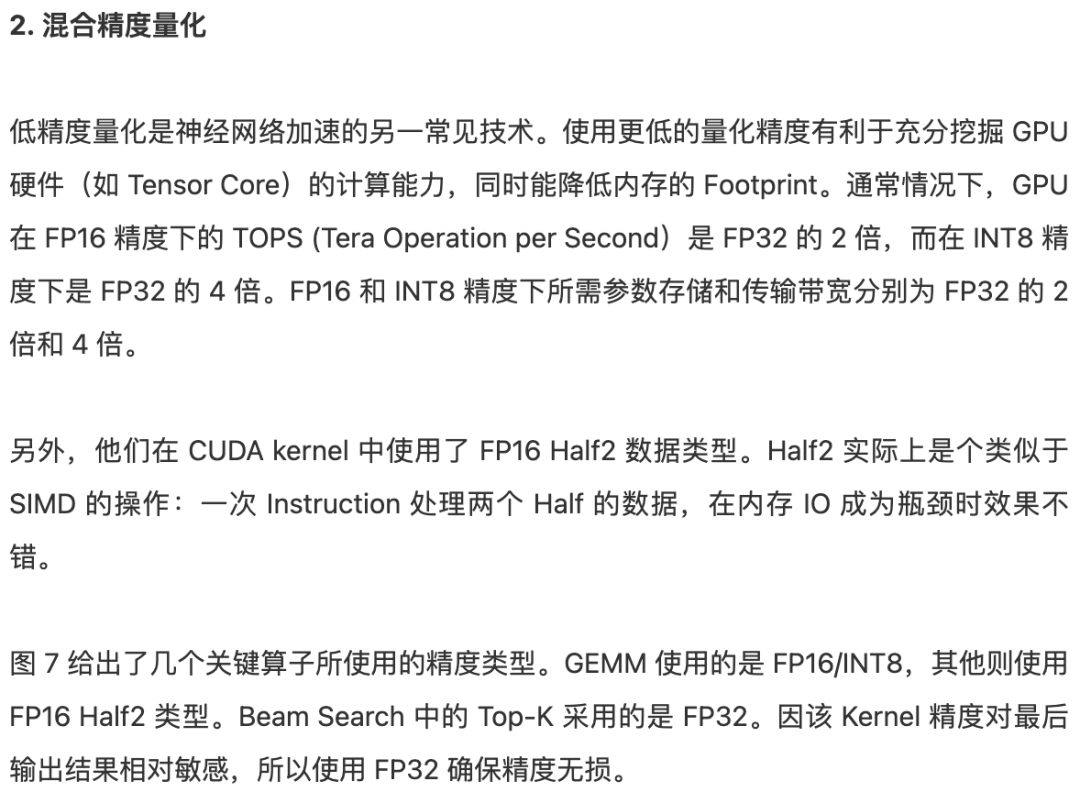

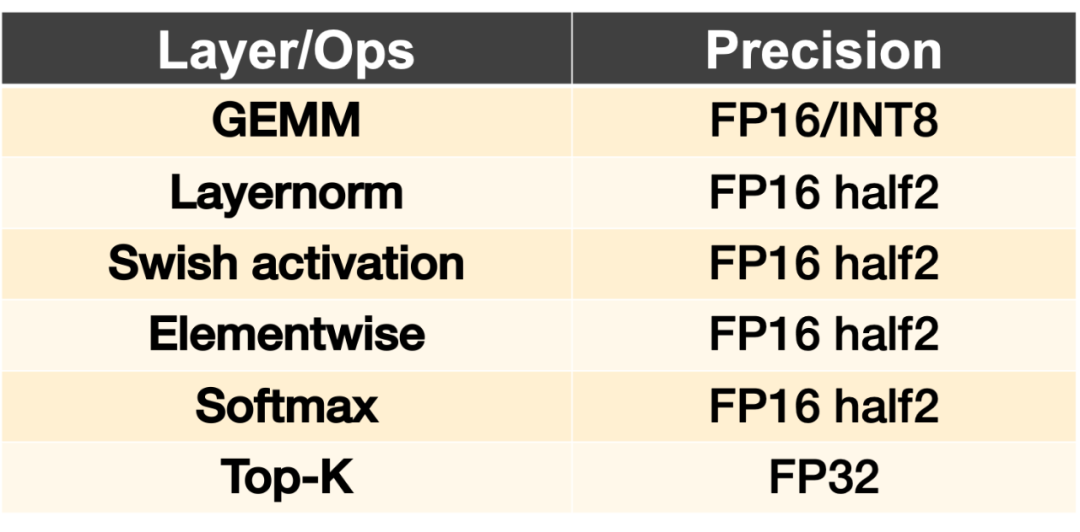

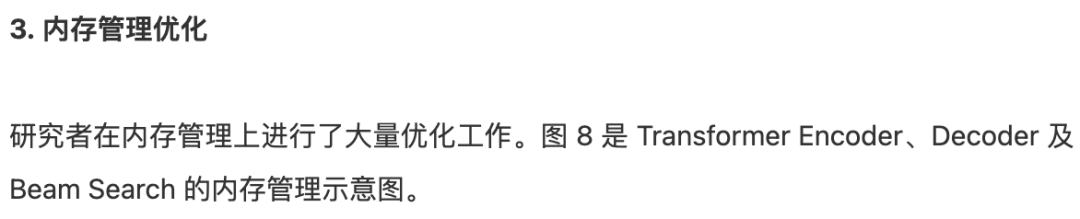

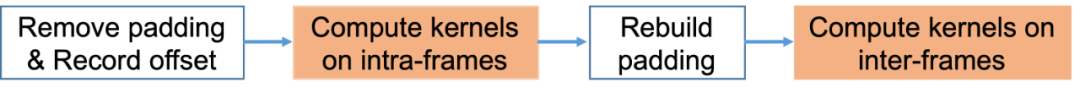

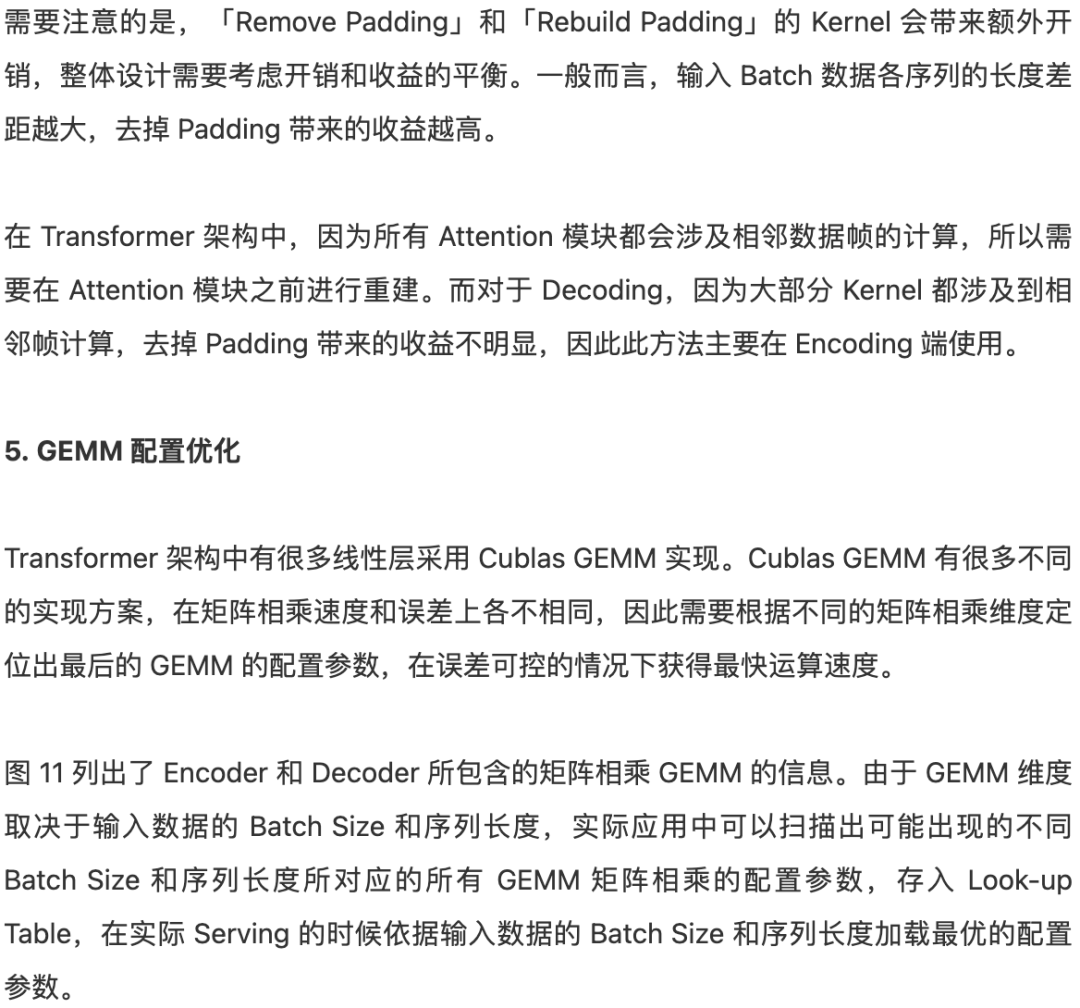

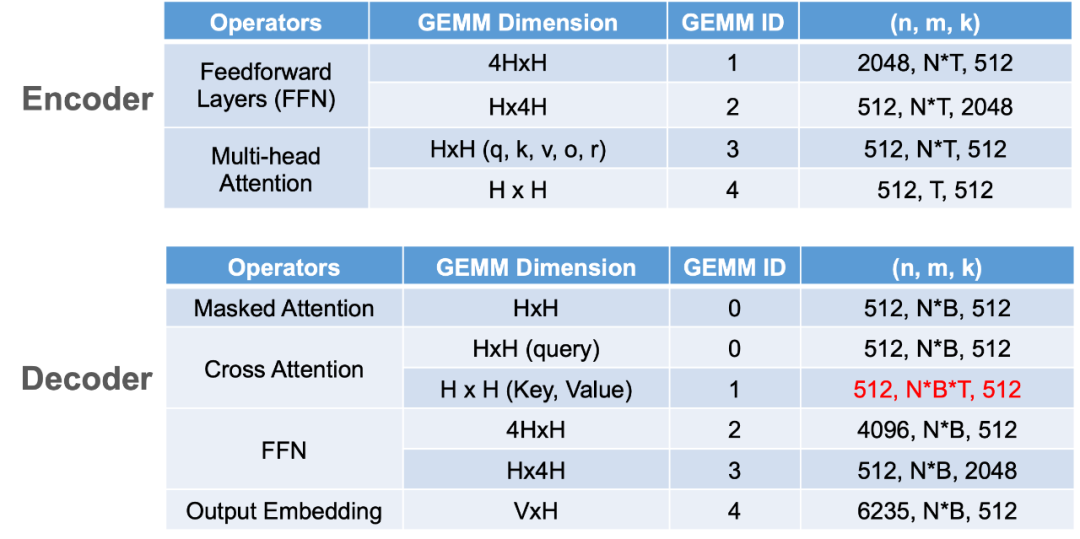

Transformer 对计算和存储的高要求阻碍了其在 GPU 上的大规模部署。在本文中,来自快手异构计算团队的研究者分享了如何在 GPU 上实现基于 Transformer 架构的 AI 模型的极限加速,介绍了算子融合重构、混合精度量化、先进内存管理、Input Padding 移除以及 GEMM 配置等优化方法。

© THE END

推荐阅读

如何看待Transformer在CV上的应用前景,未来有可能替代CNN吗?

评论