TIP 2021论文速递:多曝光图像融合及超分辨的联合实现

极市导读

本文介绍了来自北京航空航天大学徐迈教授课题组发表在TIP2021上的最新工作,该工作首次将通常被视作两种独立的视觉任务的图像超分辨和多曝光图像融合进行有机结合,提出了耦合反馈神经网络。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

TIP 2021论文速递:多曝光图像融合及超分辨的联合实现

本文详细介绍了来自北京航空航天大学徐迈教授课题组发表在IEEE Transactions on Image Processing (TIP) 2021上的最新工作“Deep Coupled Feedback Network for Exposure Fusion and Image Super-Resolution”。该工作首次将通常被视作两种独立的视觉任务的图像超分辨(Super-resolution)和多曝光图像融合(Multi-exposure Image Fusion)进行有机结合,提出了耦合反馈神经网络(Coupled Feedback Network,CF-Net),对输入的一对过曝光和曝光不足的图像同时进行图像融合及超分辨。该论文提出的方法在图像客观质量指标PSNR,SSIM以及融合质量评价指标MEF-SSIM上均远超过对比算法。

论文链接:

https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=9357931ieeexplore.ieee.org

论文源码:

https://github.com/ytZhang99/CF-Netgithub.com

一、研究背景

手机和数码相机等移动设备的普及使得人们越来越习惯于用照片来记录生活。由于设备的硬件限制,拍摄出的图像往往具有低动态范围和低分辨率的特点,而多曝光图像融合技术和图像超分辨技术分别是常用于解决上述两种问题的技术。

现有的研究仅针对多曝光图像融合或者超分辨方法中的一种进行,但实际上图像融合和超分辨任务是具有互补性的,良好的融合效果能够提高超分辨的效果,而良好的超分辨结果有助于得到良好的图像融合结果。

本文探究了多曝光图像融合和超分辨方法之间存在的内在互补性和关联性,联合实现多曝光图像融合和超分辨,并取得了良好的效果,并有望落地实际应用。

二、技术方法

1、网络结构设计

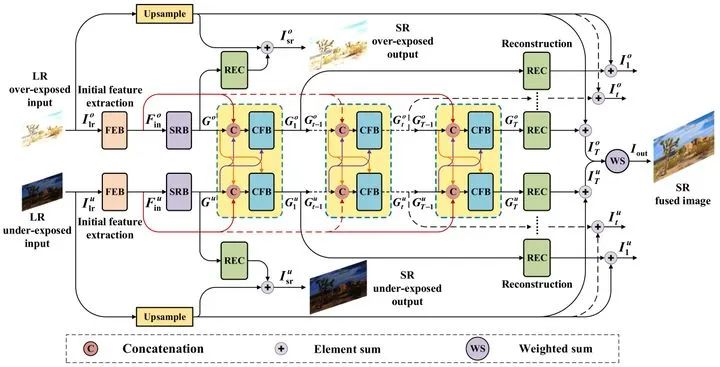

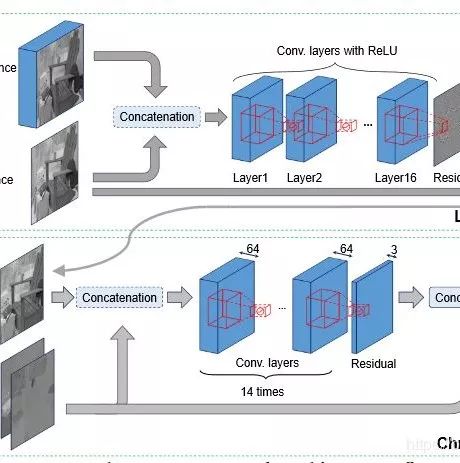

本文提出的CF-Net网络结构如图1所示,CF-Net由上下两支耦合的循环子网络构成,两个子网络分别以低分辨率的曝光过度或曝光不足的图像作为输入。

图 1 CF-Net结构

每支子网络由一个特征提取模块,一个超分辨模块以及数个耦合反馈模块(Coupled feedback block,CFB)构成。特征提取模块由两个卷积层构成,用于初步提取输入图像的特征,超分辨模块则使用连续上下采样的结构获得高层次的特征并对图像进行分辨率的提升。耦合反馈模块是CF-Net网络结构中最重要的部分,其结构如图2所示。

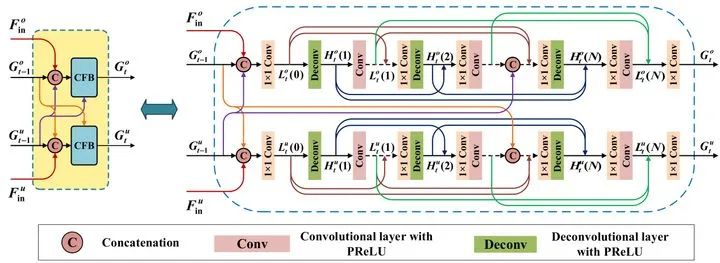

图 2 耦合反馈模块CFB结构

耦合反馈模块的设计采用了耦合结构并引入了反馈机制,通过连续上下采样获取高层次的特征并进行融合。以CF-Net的上部子网络为例,上部子网络的第t个耦合反馈模块接收三个输入:上部子网络中特征提取模块提取的基本特征以及分别来自上下两个子网络中第(t-1)个耦合反馈模块的反馈特征。耦合结构使得耦合反馈模块能够同时获取曝光过度和曝光不足图像的特征进行融合,连续上下采样提高了图像超分辨的效果,促使图像融合和超分辨两个任务彼此互补与提升。

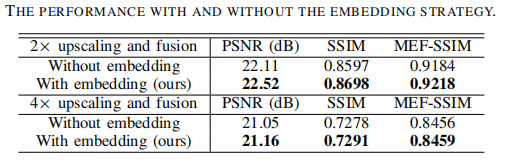

在实验过程中我们发现,随着耦合反馈模块中连续上下采样映射组数量的增加,图像融合和超分辨的效果逐步提升,但提升的速度逐渐变慢。这是由于从另一子网络中第(t-1)个耦合反馈模块输入的反馈特征在这个过程中被逐渐遗忘。因此在耦合反馈模块的设计中又引入了embedding的策略,即在映射组内部再次加入另一子网络中第(t-1)个耦合反馈模块的反馈特征对网络记忆进行“重新刺激”,表1所示实验结果证明了embedding的有效性。

表 1 使用embedding策略的结果

2、损失函数

本文中采用的是MSSIM损失函数作为损失函数对CF-Net进行端到端训练。

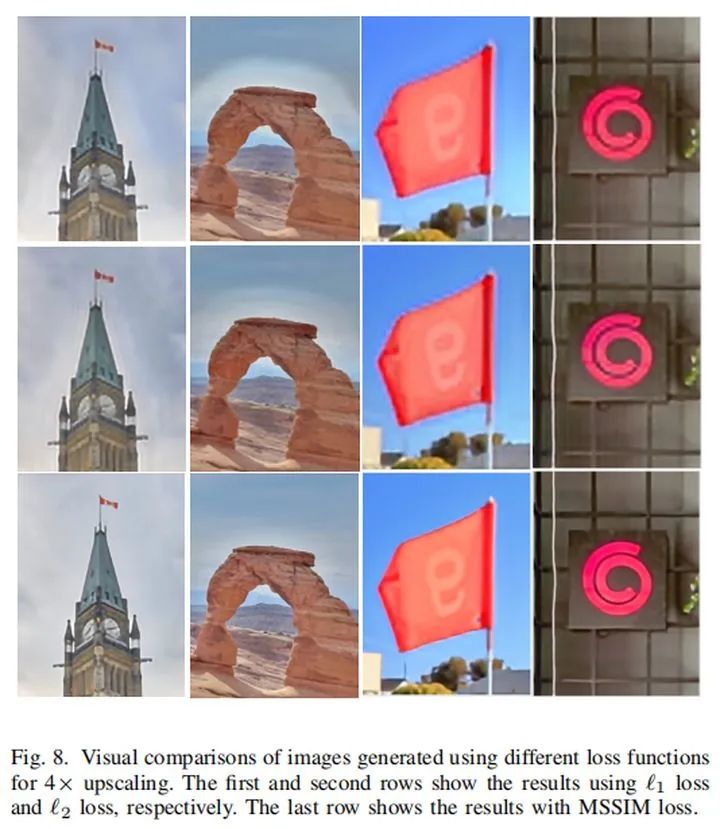

在此之前尝试使用了均方误差损失函数以及L1和L2 loss作为损失函数进行训练,但是实验结果中存在明显的光晕现象,如图3所示。而使用MSSIM损失函数训练则能够得到主观上图像边缘明显,客观上指标优秀的实验结果,具体指标可以参考论文正文部分。

图 3 不同损失函数对实验结果影响

3、实验结果

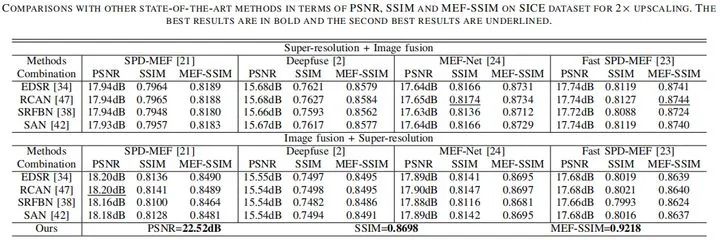

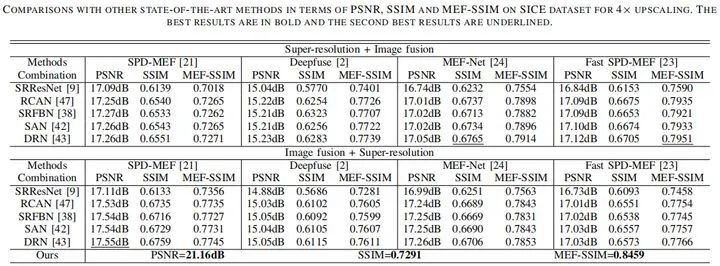

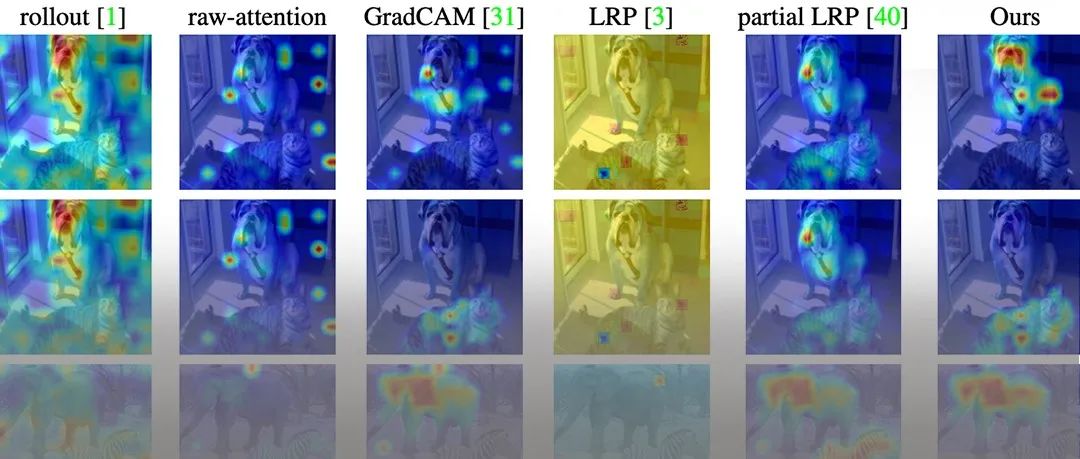

在对比算法的选择上,本文将目前先进的多曝光图像融合方法及超分辨方法按照不同顺序进行组合测试,例如DeepFuse + SAN,DRN + MEF-Net等。测试集分别来自SICE数据集以及PQA-MEF数据集。部分定量的实验结果如表2所示,CF-Net在PSNR、SSIM以及MEF-SSIM三项指标上均远超对比算法。

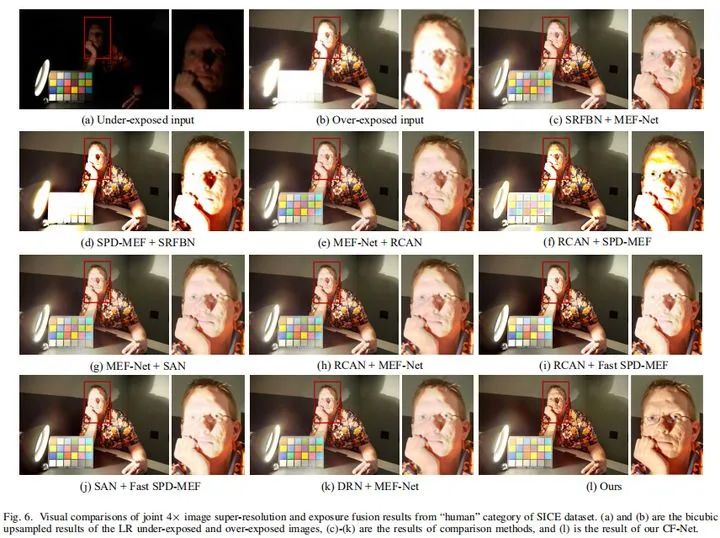

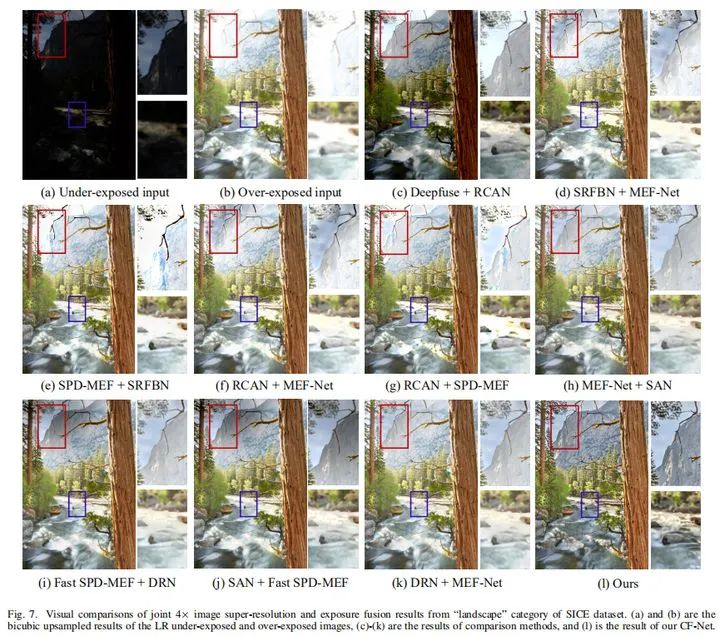

部分定性实验结果如图4所示,从图中可以看到CF-Net的实验结果无论是在图像的细节恢复上,还是在色彩饱和度、图像对比度上都优于其他的对比算法。

表 2 定量实验结果

图 4 定性实验结果

欢迎引用:

@article{deng2021deep,

title={Deep Coupled Feedback Network for Joint Exposure Fusion and Image Super-Resolution},

author={Deng, Xin and Zhang, Yutong and Xu, Mai and Gu, Shuhang and Duan, Yiping},

journal={IEEE Transactions on Image Processing},

volume={30},

pages={3098--3112},

year={2021},

publisher={IEEE}

}

推荐阅读

2020-02-14

2021-03-08

2021-03-07

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~