对待数据的三大致命错误

· 译者注 ·

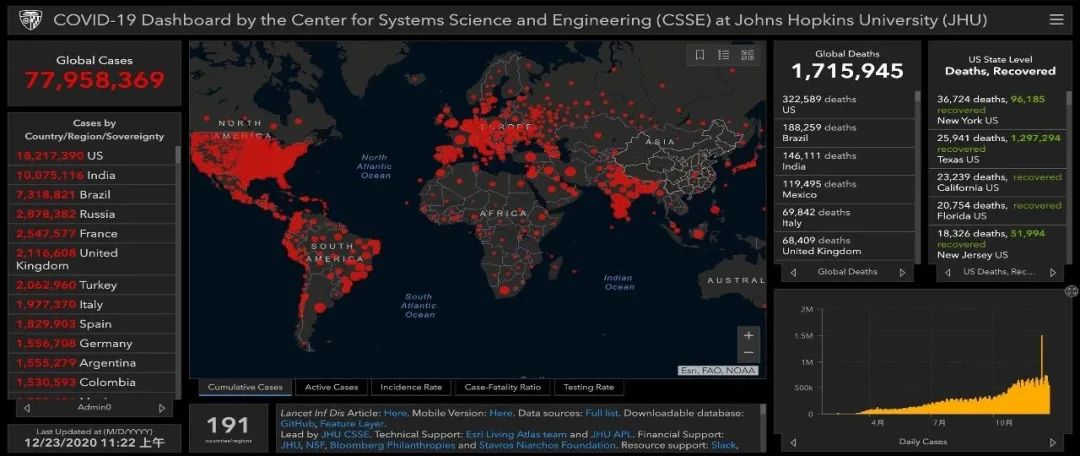

本文节选自The Atlantic(大西洋月刊)官网于3月16日发布的一篇文章,文章的两位作者是疫情数据追踪项目COVID Tracking Project的联合发起人。回顾过去一年的经历,他们在直指美国政府和相关机构抗疫不力的同时,也反思了对待疫情数据的三大误区。

这些误区在其他数据应用场景中也同样可能发生。我们翻译了文章的主要内容,希望能为大家带来一些启发。

2020年3月4日零点前的几分钟,我们发邮件给美国各州以及哥伦比亚特区政府,询问一个简单的问题:经过新冠病毒检测的人到底有多少?

当时,美国已有差不多150人确诊、11人死亡。而CDC(美国疾病控制与预防中心)却停止了公开发布全国检测数据。没有这部分数据,也就无法对确诊病例数据进行解读——是只有很少的人病了?还是只有很少的人做了检测?令人震惊的是,我们发现得到检测的人非常有限。

我们意识到,缺乏检测的结果可能是灾难性的。于是我们发起了The Atlantic的疫情数据追踪项目。去年春天开始,项目志愿者每天从美国的每个州和区域收集疫情数据。我们以为政府已经拥有这些数据,希望通过一些报道来督促政府公开这些数据。

但随后,我们发现CDC的数据非常不完善,而白宫甚至在使用我们项目的数据。长达几个月的时间,美国政府完全不知道到底有多少人确诊、多少人住院、多少人死亡。而这个临时的、志愿的数据追踪项目,却成为了事实上的全美疫情数据来源。

数据可能看上去是一个太技术的迷思。如果把疫情造成几十万人死亡的原因归结于数据,看上去更像甩锅。但是,政府正是通过数据来了解现状的。某种意义上,数据就是联邦政府眼中的现实。当想象中应该存在的数据,与实际上存在的数据之间出现了巨大的鸿沟,就把全美国的抗疫政策与行动带到了沟里。

(截止文章发出前一周)疫情数据追踪项目统计了全美国范围内3.63亿例检测、2800万例确诊和51.5148万例死亡。过去一年教训不断,我们知道了美国公共卫生政策痴迷于数据,却又远离数据。我们知道了这些政策背后的数据可能既无法理解,又不能指导行动。我们知道了疫情数据的产生方式,决定着我们到底是否能全面了解疫情。

而改变看待数据的方式,就能够防止灾难再一次发生。

在2020年3月之前,美国并不缺疫情应对预案,很多预案还强调数据驱动决策制定的重要性。但是这些预案大多建立在详细、可靠的数据已经存在的基础上。他们很少关心这些数据是如何产生的。

去年3月份,政府停止公开病毒检测数据。当我们开始汇总各州的数据,很快就发现检测做的一团糟。首先,由于CDC最初发放的新冠病毒检测盒存在缺陷,并对什么人才能接受检测制定了过于严格的标准,导致各州基本检测不了多少人。

除了这些问题外,还存在一大困扰。数据系统需要经过精确的校准,才能产生详细的统计数据。但是在美国,各州分别“创造”了各自的数据并上报联邦政府。这些数字在某种意义上可能都是“准确”的,但是各州数据间的不统一,使得极难直接统计出全美国的数据。

疫情数据追踪项目最初的工作,就是去理解数据中的不一致并进行调整,让各州的数据可以统一起来。因为每一项疫情数据的产生都经过了曲折的过程。像检测数据,最初只是玻璃瓶或实验室机器中的分子反应,之后要经过数层人类观测、键盘输入、计算机处理,然后才到达政府。在从市、到州再到联邦数据库的过程中,数据可能经过了各种不同方式的处理。经过这个过程,最终形成了看似金玉其外却可能败絮其中的数据。

理想的疫情应对措施,建立在这些数据完全可靠、输入到高度优化的流行病学模型中、并能指导行动的前提下。“CDC的缺位让我们在数周里因为缺少必要的检测而盲目行事,”退伍军人事务部的一位医学顾问表示,“模型与现实的区别是,在模型中我们根据已知情况来设定参数,而现实中的参数却是一本糊涂账。”

后续的学术研究发现,早期的确诊病例数只是实际数量的10%、甚至5%。尽管已经有现成预案可以进行数据分析,但政府(错误的)认为这些数据很容易获得,导致没能够在一开始就将实际情况暴露出来。

去年春末,疫情数据追踪项目开发出一种简单的可视化方式,来一览疫情数据——通过一排四个图表来分别体现检测数、住院数、死亡数。

图:美国全国新冠疫情统计(七天平均线)

四个维度分别为(从左至右):日检测数、日病例数、当前住院数、日死亡数

这个图表看起来权威并且全面。但这些数据的产生过程教育我们,每个维度的数据都只能代表某一个特定时刻。当你看着这些图表,你看到的不是当下的实况,而是对过去某个瞬间的记录。

项目研究发现,不同维度的数据是按照不同速度发展的。以病例数和检测数为例,根据这两个数据可以算出“检测阳性率”,像封城、重启等抗疫措施经常是基于这一数据做出的。但是,病例数可能会增长很快,检测为阴性的数据变化的则慢一些。除此之外,检测与确诊的日期也可能并不一致。独立的州比较容易校正这类问题,但是跨州之间就比较难。更甚,当检测为阴性的结果出来的有所延迟,会让检测阳性率看上去比实际情况更高,影响学校和商业的重启。

死亡数也会受到上报系统流程的影响,而很多人可能都没有意识到这一点。根据CDC的预估,死亡中位数可能要在人死亡了20天之后才会汇报到州政府,中间存在巨大的时间差。约四分之一的死亡病例会在6天之内上报,但也有另外四分之一的上报时间是在45天之后。而且,根据一位流行病学家对加利福尼亚州数据的研究,这种延迟还不是恒定的。数据反映的可能是好几周前的情况,这个问题让疫情爆发期的实际死亡人数难以得到准确评估。

我们最信任、也认为不会有大问题的数据,是受到卫生与公共服务部监管的住院数据。实际上,目前所有医院都被要求汇报给卫生与公共服务部,我们可以很好的了解到全美范围内有多少新冠患者被收治入院。

这让联邦政府可以针对性提供帮助,为最有需要的医院提供人员、药品和防护用品。这才是用精准数据帮助政策制定者的良好范例。

数据似乎极大程度上代表了真相。政策制定者以“数据驱动”为荣,并发誓要“遵循科学”。但花了一年深入数据后,我们认为数据没什么特别的。

数据只是以定量方法得出的定性结论。数据驱动思维并不一定比其他形式的推论更精确,尤其是当没搞清楚数据从何而来,数据中的不一致甚至会产生误导。

这个问题从一开始就为抗疫带来了阻碍。在去年三月初,很明显新冠病毒应该已经扩散到美国。而CDC还在严格控制什么人才能接受检测,缺乏清晰检测数据,意味着政府根本还没认清现实。

今天,问题依旧存在。在2021年3月1日举办的记者会上,CDC主任提醒公众注意病毒新变种。她暗示,全美国范围内的病例数和死亡数都在上升,可能就是由于病毒新变种。但是通过疫情数据追踪项目,我们知道这个“新变种引发疫情新高潮”的说法并不成立。如果死亡数现在上升,说明病例数的上升应该在一个月前。而实际上,一个月前的病例数是快速下降的,这并不相符。

相反,通过对数据的密切跟进可以了解到,由于要检查死亡证明,很多州的数据上报存在严重延迟。同时,德州等地又被暴风雪击垮了。这使得他们的上报数据直线下降,死亡数反常的快速减少,而当工作完全恢复后,数据便又快速反弹。不出所料,CDC主任发言后,日均死亡数很快就回落了25%。

换句话说,并不是这些州的疫情在2月份变糟了,而是从12月延续到1月的高峰期远比当时认为的更严重。不应该在没有充分考虑数据产生背景的情况下,就直接解读眼前的数据。

数据是极具魅力的。你看着图表或者表格,可能会感觉自己像掌握了制胜密码一样无所不能。但事实上,你更像是一个清洁工,看着水从下水道流向污水处理厂。当然,久而久之你也能知道哪个下水道口格外难闻,而哪个离污水处理厂更近,但你不应该自欺欺人,以为自己了解水里都有什么。

为了避免下一次数据灾难,除了花精力塑造未来,我们的公共卫生系统也必须要花同样的精力去理解当下。疫情或任何危机的管理,就在于根据尽可能好的信息,做出尽可能不坏的决策。这些信息可能是各种形式的,不是只有数据。但一旦你要参考数据,就一定要知道数据是如何产生的,不然就很有可能会被误导。

原文来源:The Atlantic 翻译:TalkingData

原文标题:《Why the Pandemic Experts Failed——We’re still thinking about pandemic data in the wrong ways.》

原文链接:https://www.theatlantic.com/science/archive/2021/03/americas-coronavirus-catastrophe-began-with-data/618287

作者:Robinson Mayer、Alexis C. Madrigal(The Atlantic撰稿人,疫情数据追踪项目COVID Tracking Project联合发起人)

推荐阅读:

TalkingData——用数据说话

每天一篇好文章,欢迎分享关注