[IJCV 2022] PageNet: 面向端到端弱监督篇幅级手写中文文本识别(已开源)

一、背景

手写中文文本识别是一个具有广泛应用场景的研究方向。目前该领域的相关研究通常关注文本行级的手写中文识别,不考虑在实际应用中因为文本行检测带来的误差。近年来,也有部分研究关注篇幅级的文本识别,但是它们要么仅考虑简单的版面结构,要么需要极为细致的标注信息(文本行级甚至单字级的边界框)。同时,领域内对于阅读顺序的研究较少,而实际应用中会出现多方向文本、弯曲文本等复杂的阅读顺序。为了解决上述问题,这篇文章中提出一种新型的端到端弱监督篇幅级手写中文文本识别方法PageNet。该方法抛弃文本行检测+文本行识别的传统流程,先检测识别单字再预测单字间的阅读顺序,这使得PageNet可以轻松处理复杂的板式和阅读顺序。对于真实数据,PageNet仅需要文本标注,但是可以输出文本行级和单字级的检测和识别结果,省去了标注文本行级和单字级边界框的巨额成本(表1)。实验证明PageNet优于现有的弱监督和全监督篇幅级文本识别方法。

表1 现有方法需要的标注信息和模型输出结果的对比(L: 文本行级,W: 单词级,C:单字级)。PageNet仅需要文本标注即可得到文本行级和单字级的检测和识别结果。

二、方法

2.1 算法框架

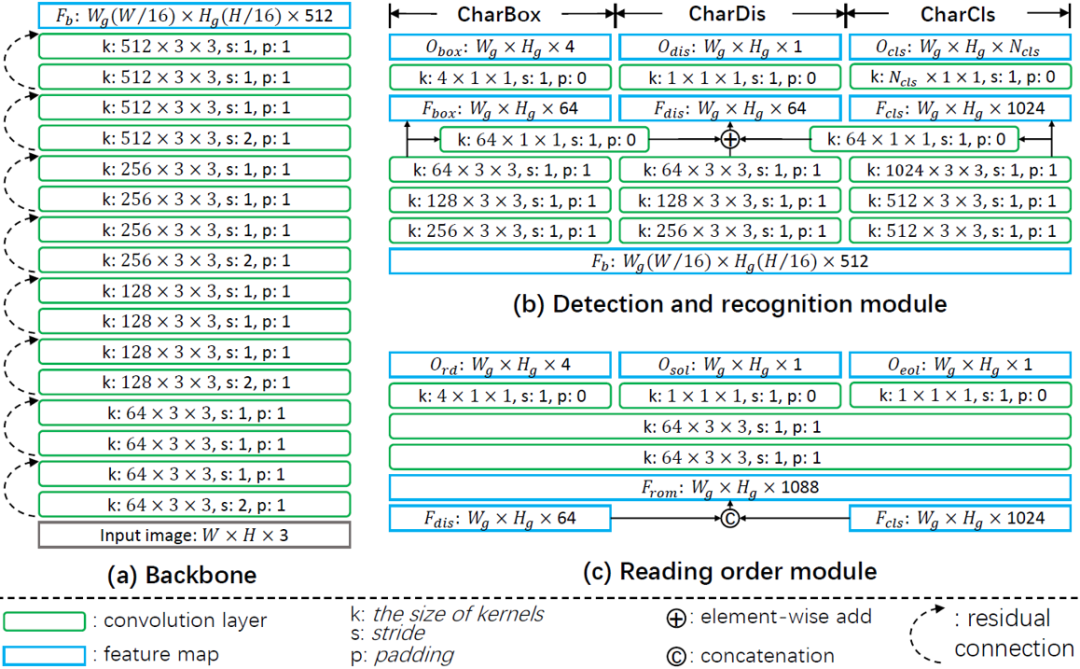

PageNet方法的整体框架如图1所示,包括四个部分:(1)主干网络提取输入图像的高维特征;(2)检测和识别模块完成单字的检测识别;(3)阅读顺序模块预测单字间的阅读顺序;(4)基于图的解码算法结合单字的检测识别结果和阅读顺序,得到最终的篇幅级结果。该结果包含文本行级和单字级的检测识别结果。

此外,为了省去人工标注单字和文本行边界框的成本,文章中提出了一种新型的弱监督学习方法 (图4)。借助该方法,仅需要对真实数据标注各行的文本信息即可训练PageNet。

2.2 主干网络

主干网络采用多个残差模块堆叠的结构。对于高为H、宽为W的输入图片,主干网络输出形状为 512的特征图。为了方便下文叙述,将

512的特征图。为了方便下文叙述,将 分别标记为

分别标记为 。

。

2.3 检测和识别模块

检测和识别模块参考文献[1]和[2],在主干网络提取的特征的基础上分为三个分支,分别为CharBox、CharDis和CharCls分支。首先将输入图片分为 个网格并将第i列第j行的网格标记为

个网格并将第i列第j行的网格标记为 。CharBox分支输出形状为

。CharBox分支输出形状为 的单字边界框预测

的单字边界框预测 ,其中

,其中 可转换为网格

可转换为网格 中的单字边界框坐标

中的单字边界框坐标 。CharDis分支预测形状为

。CharDis分支预测形状为 的字符分布

的字符分布 ,其中

,其中 为网格

为网格 中存在单字的置信度。CharCls分支预测形状为

中存在单字的置信度。CharCls分支预测形状为 的字符分类结果

的字符分类结果 ,其中

,其中 为网格

为网格 中单字的

中单字的 类分类概率。

类分类概率。

2.4 阅读顺序模块

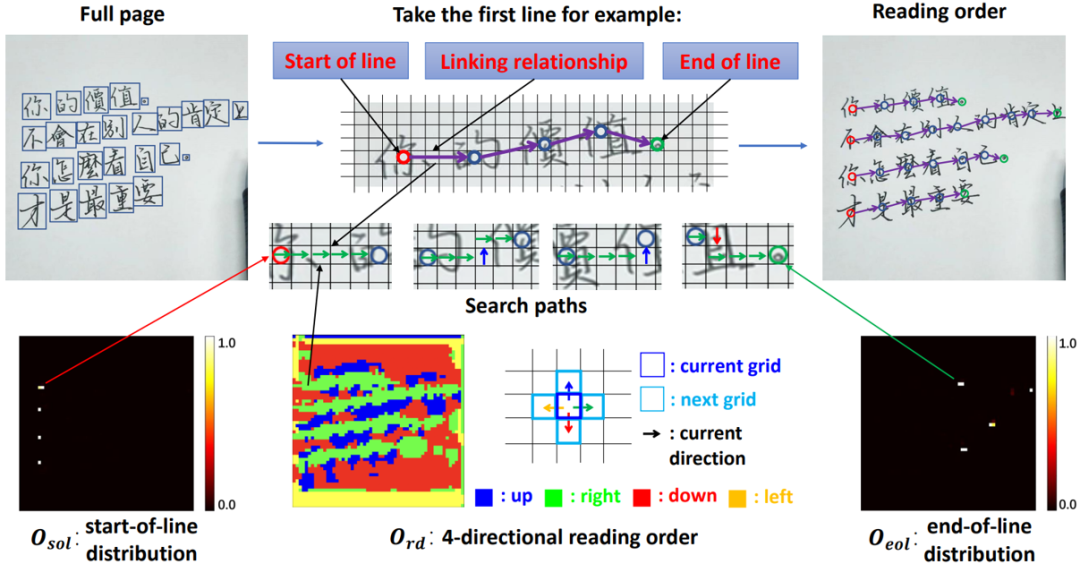

阅读顺序模块的整体流程如图2所示。该模块将阅读顺序预测问题分解为:(1)文本行开始字符预测;(2)根据字符间的连接关系逐步找到阅读顺序中的下一个字符;(3)行结束字符预测。其中,字符间的连接关系定义为字符间搜索路径上网格的转移方向(上下左右之一)。

对应地,该模块分别预测:(1)行开始分布 ,其中

,其中 为网格

为网格 中单字为行开始的置信度;(2)四方向阅读顺序

中单字为行开始的置信度;(2)四方向阅读顺序 ,其中

,其中 为网格

为网格 在阅读顺序中向其四个相邻网格的转移方向;(3)行结束分布

在阅读顺序中向其四个相邻网格的转移方向;(3)行结束分布 为网格

为网格 中单字为行结束的置信度。

中单字为行结束的置信度。

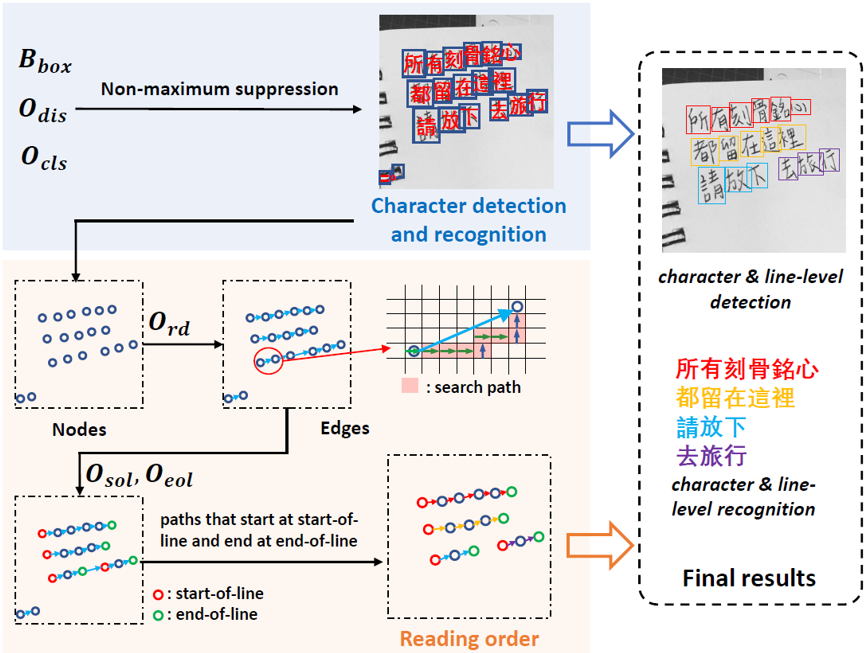

2.5 基于图的解码算法

基于图的解码算法流程如图3所示。该算法结合检测识别模块和阅读顺序模块的输出,得到最终的单字级和文本行级的检测和识别结果。首先,检测识别模块中三个分支的输出 经过非极大值抑制(NMS)得到单字的检测和识别结果;然后,每个单字视为图结构中的一个节点。每个节点根据相应单字框中心点的坐标对应一个网格。接下来,基于四方向阅读顺序

经过非极大值抑制(NMS)得到单字的检测和识别结果;然后,每个单字视为图结构中的一个节点。每个节点根据相应单字框中心点的坐标对应一个网格。接下来,基于四方向阅读顺序 ,可以逐步根据网格的转移方向找到每个节点在阅读顺序中的下一节点。这种连接关系构成图结构的边。下一步,根据行开始分布

,可以逐步根据网格的转移方向找到每个节点在阅读顺序中的下一节点。这种连接关系构成图结构的边。下一步,根据行开始分布 和行结束分布

和行结束分布 ,判定行开始节点和行结束节点。最后,保留开始于行开始节点并且结束于行结束节点的路径,得到每个文本行的阅读顺序图。将图中的节点替换为对应的单字检测和识别结果,即可得到单字级和文本行级的检测识别结果。

,判定行开始节点和行结束节点。最后,保留开始于行开始节点并且结束于行结束节点的路径,得到每个文本行的阅读顺序图。将图中的节点替换为对应的单字检测和识别结果,即可得到单字级和文本行级的检测识别结果。

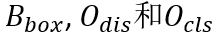

2.6 弱监督学习方法

弱监督学习方法的整体流程图如图4所示。输入数据包括仅有各行文本标注的真实数据和有完整标注的合成数据。为了验证弱监督学习方法的泛化性,合成数据采用将字体文件生成的汉字贴到简单背景上的方法,因此与真实数据存在较大的差异。弱监督学习方法需要将合成数据中学习到的检测识别能力迁移到多种多样的真实场景中。

三、 实验

3.1 实验数据集

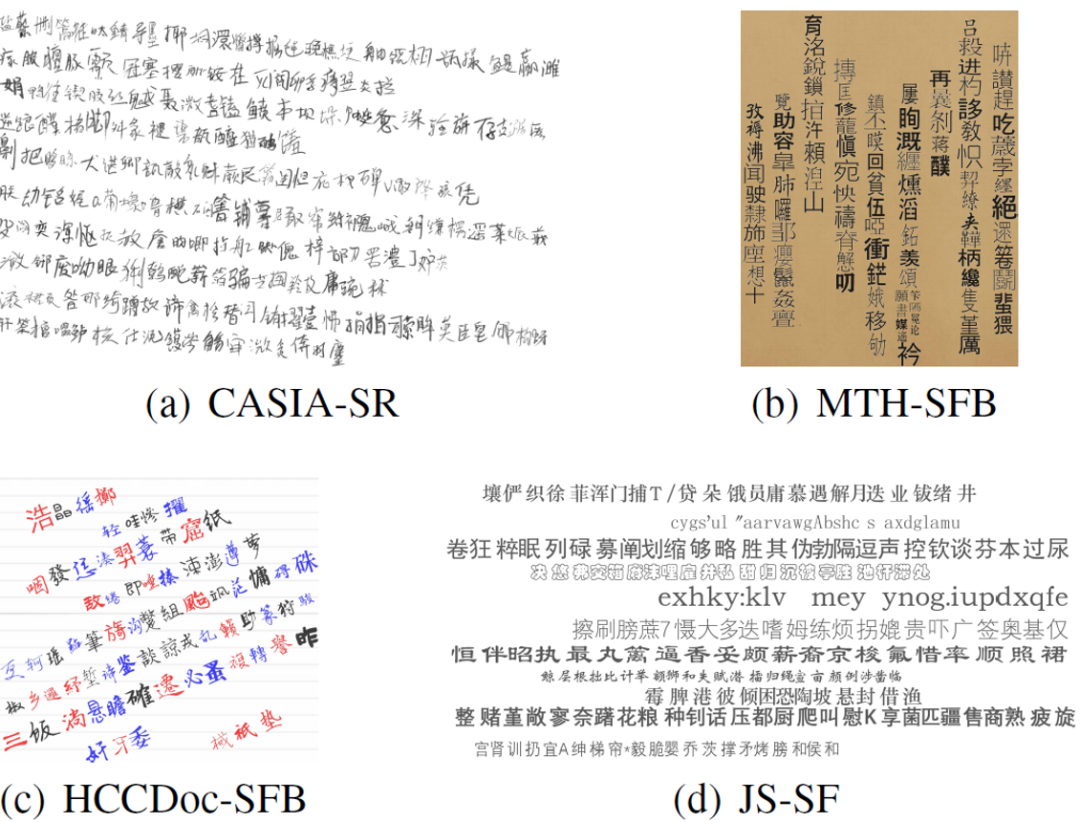

(1)CASIA-HWDB手写中文数据集,包括篇幅级数据集CASIA-HWDB2.0-2.2(5091张图片)和单字数据集CASIA-HWDB1.0-1.2(389万个单字)。

(2)ICDAR2013手写中文比赛测试集,包括篇幅级数据集ICDAR13(300张图片)和单字数据集ICDAR13-SC(22万个单字)。

(3)MTHv2中文古籍数据集,包括3199张古籍图片,分为2399张训练集和800张测试集。

(4)SCUT-HCCDoc拍照手写数据集,包括12253张图片,分为9801张训练集和2452张测试集。

(5)JS-SCUT PrintCC中英文印刷文档数据集,包括398张图片,分为348张训练集和50张测试集。

(6)合成数据集采用真实单字数据或字体生成的单字数据和网络获取的简单纸张背景进行合成。首先将单字组成文本行,再将文本行以一定倾斜度贴在背景上。数据合成不涉及任何语料和其他复杂的光照、视角和扭曲变换等处理。合成数据的示例如图5所示。

3.2 模型结构

模型结构如图6所示。

图6 模型具体结构图

图6 模型具体结构图3.3 评测指标

针对仅标注各行文本内容的弱监督情况,提出了AR*和CR*指标。这两种指标首先将模型预测文本行和标注文本行根据AR进行匹配。对已经匹配的文本行对,计算插入错误、删除错误和替换错误并累积。对于没有被匹配的预测文本行,其中所有单字均视为插入错误。对于没有被匹配的标注文本行,其中所有单字均视为删除错误。最后,采用类似于AR和CR的计算方式,得到AR*和CR*指标。

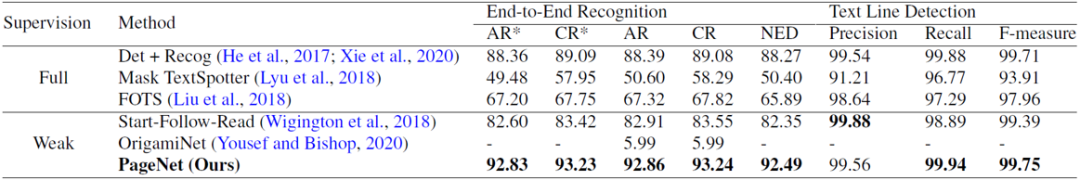

3.4 ICDAR13数据集

PageNet在ICDAR13篇幅级手写中文数据集上的端到端识别指标和文本行检测指标及其与现有方法的对比如下表所示。可以看出,PageNet超过了现有的全监督和弱监督方法,取得SoTA的端到端篇幅级识别指标。

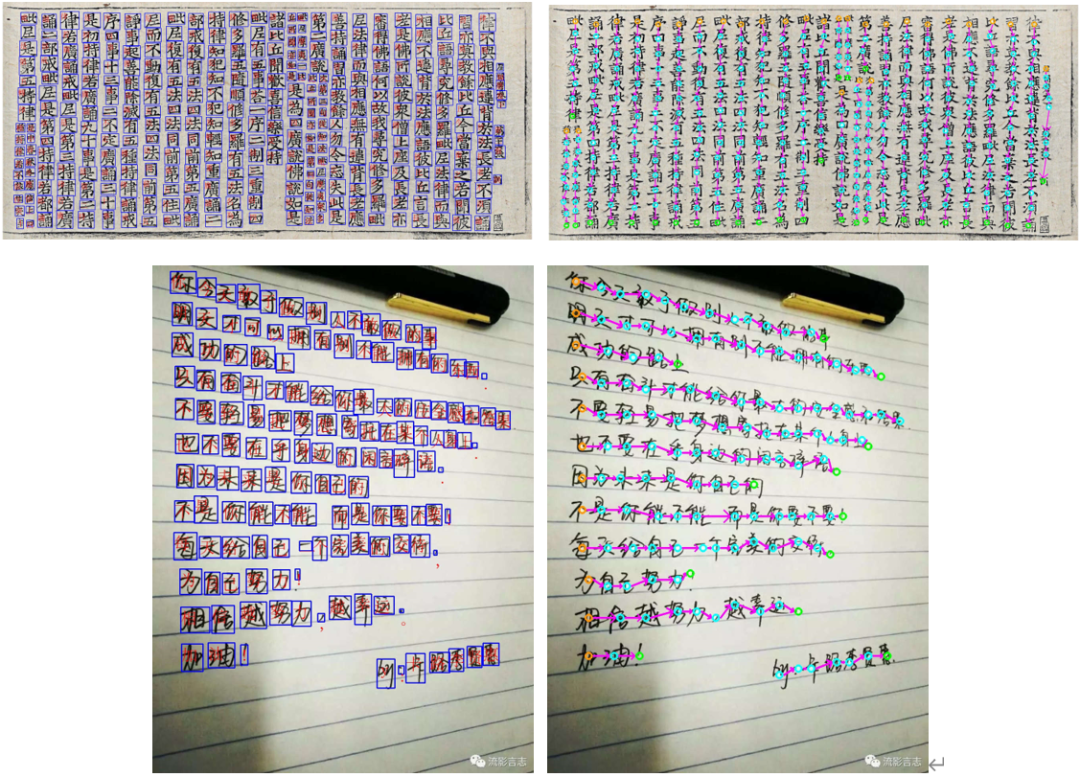

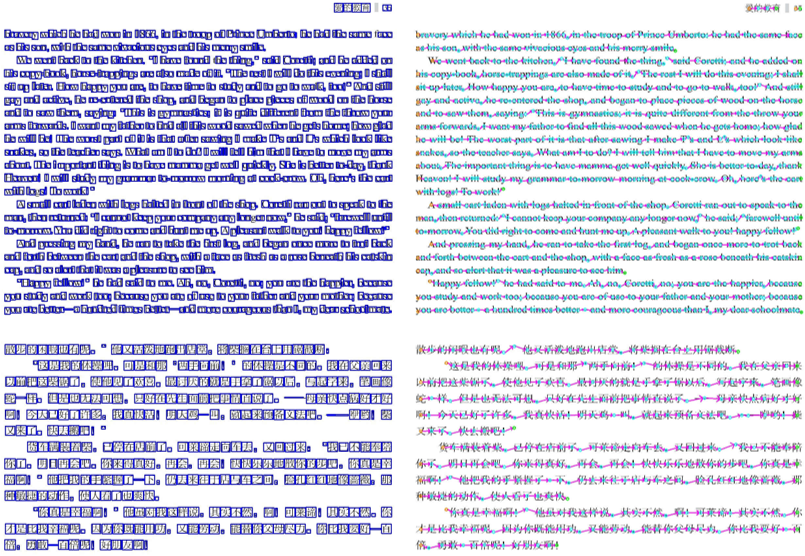

3.5 MTHv2、SCUT-HCCDoc和JS-SCUT PrintCC数据集

PageNet与现有方法在MTHv2、SCUT-HCCDoc和JS-SCUT PrintCC数据集上的端到端识别指标对比如下表所示。可以看出,在MTHv2数据集上,PageNet取得了与最佳的全监督模型相近的端到端识别指标。在SCUT-HCCDoc数据集上,因为该数据集涉及复杂的版面和光照、拍照角度等干扰,这对无真实场景文本位置信息监督的PageNet提出了很大挑战。但是借助合理设计的弱监督学习方法,PageNet大幅度超过了其他弱监督方法且与最佳的全监督模型指标较为接近。在JS-SCUT PrintCC数据集上,PageNet取得了最高的端到端识别指标,证明该方法可以处理中英文混合的文档场景。

表3 PageNet与现有方法在MTHv2、SCUT-HCCDoc和JS-SCUT PrintCC数据集上的对比

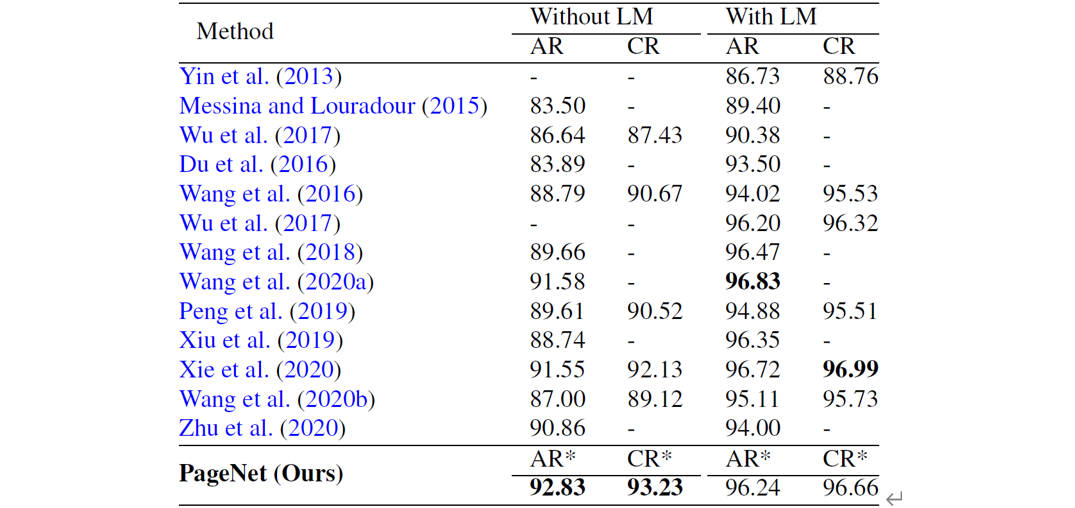

3.6 ICDAR13文本行级数据

PageNet与现有方法在ICDAR13文本行数据集(根据标注切出文本行)上的识别指标对比如下表所示。可以看出,虽然PageNet是在篇幅级进行识别且AR*和CR*需要考虑到文本行检测的准确度,但是PageNet的指标仍然超过了现有的文本行级识别方法。这一结果证明了基于单字检测和识别的方法相较于流行的基于CTC/Attention方法更加适合于中文文本识别。

表4 PageNet与现有方法在ICDAR13文本行数据集上的对比

3.7 单字检测识别指标

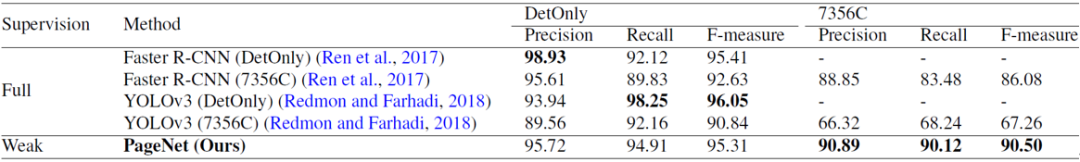

PageNet与经典检测方法Faster R-CNN和YOLOv3在ICDAR13数据集上的单字检测识别指标如下表所示。可以看到弱监督的PageNet在同时考虑单字检测和识别时(7356C)取得了远超全监督的Faster R-CNN & YOLOv3的指标。

表5 PageNet与Faster R-CNN和YOLOv3在ICDAR13数据集上的单字检测识别指标对比

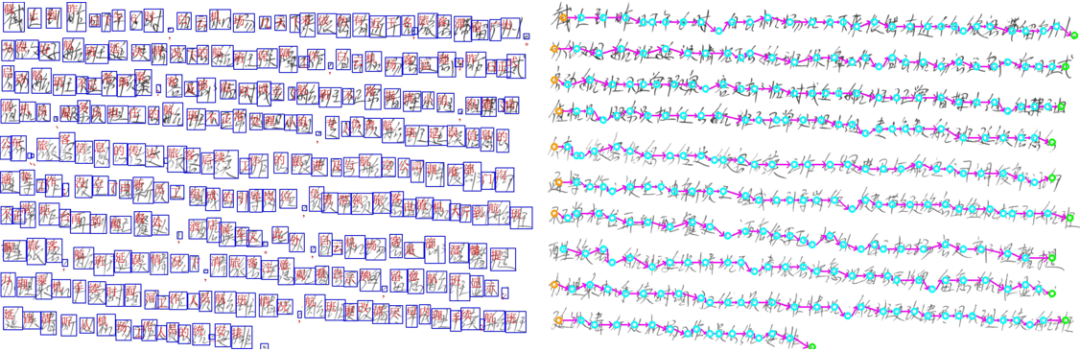

3.8 实验结果可视化

部分可视化结果如下图所示,图中左侧为单字检测识别结果,右侧为阅读顺序预测结果。更多可视化结果请参见原文。

3.9 其他实验

四、 总结及讨论

五、 相关资源

论文地址1:https://arxiv.org/abs/2207.14807

论文地址2:https://link.springer.com/article/10.1007/s11263-022-01654-0

代码地址:https://github.com/shannanyinxiang/PageNet

参考文献

[1] Dezhi Peng, et al. “A fast and accurate fully convolutional network for end-to-end handwritten Chinese text segmentation and recognition.” Proceedings of International Conference on Document Analysis and Recognition. 2019.

[2] Dezhi Peng, et al. “Recognition of handwritten Chinese text by segmentation: A segment-annotation-free approach.” IEEE Transactions on Multimedia. 2022.

[3] Dezhi Peng, et al. “PageNet: Towards end-to-end weakly supervised page-level handwritten Chinese text recognition” International Journal of Computer Vision. 2022.

撰稿:彭德智

编排:高 学

审校:殷 飞

发布:金连文

免责声明:(1)本文仅代表撰稿者观点,撰稿者不一定是原文作者,其个人理解及总结不一定准确及全面,论文完整思想及论点应以原论文为准。(2)本文观点不代表本公众号立场。