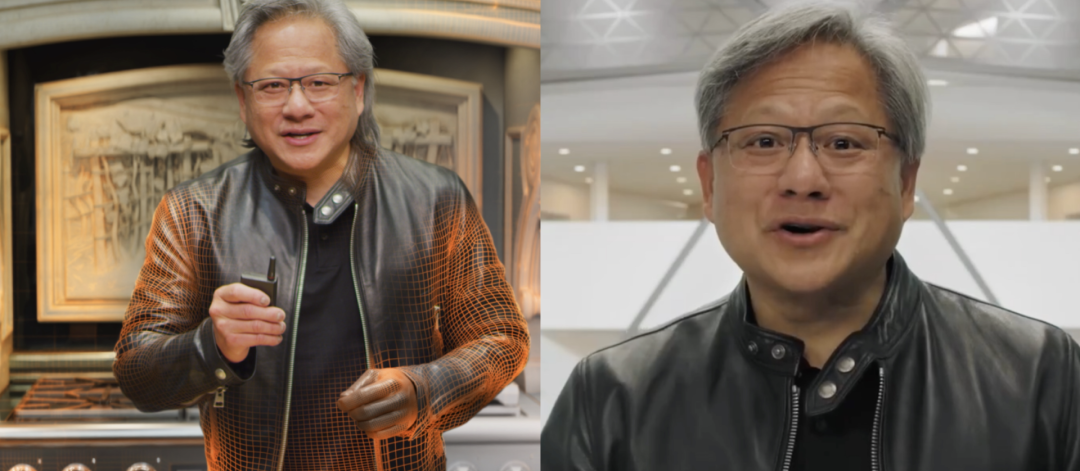

11月9日下午4点,英伟达GTC 2021开始了。还是那个厨房,那身皮衣,但老黄这回是AI生成的吗?不过这次虽然没有假身,又多了一个老黄的Avatar。刚刚,黄仁勋重磅发布了会对话的虚拟形象 Toy-Me。黄仁勋表示,「你会看到这个虚拟形象是基于目前训练的最大语言模型的语言处理打造,包括声音也是用我自己的语音进行合成,还可以看到实时基于光线追踪的精美图像。」黄仁勋演示3个人分别让虚拟形象回答关于气候变化、天文学以及生物蛋白质等棘手的问题,这个可爱的小家伙回答行云流水。先是Facebook改名,后是微软把MR平台Mesh融入到Teams中。此次,英伟达还推出了自己的虚拟人,更加证明了全力布局「元宇宙」势不可挡。Omniverse Avatar发布,全力拥抱「元宇宙」

英伟达在GPU技术大会上正式发布了Omniverse Enterprise,这是一个模拟和协作平台。按照英伟达的说法,该平台“充当物理上精确的3D虚拟世界的结缔组织”。Omniverse Enterprise利用英伟达芯片为企业客户构建强大的计算系统,起售价为每年9000美元,通过戴尔和联想集团等合作伙伴销售。

英伟达首席执行官黄仁勋在主题演讲中表示,通过Omniverse,“我们现在拥有了创建新的3D世界或模拟我们的物理世界的技术。”

在英伟达发布的产品当中,其中就包括了用于生成交互式人工智能化身的技术平台Omniverse Avatar。该平台集合了英伟达在语音人工智能、计算机视觉、自然语言理解、推荐引擎和模拟技术方面的技术,为创建人工智能助手打开了大门,可以帮助处理数十亿的日常客户服务互动,带来更大的商业机会和提高客户满意度。

“你们会看到一个不变的主题--如何使用Omniverse来模拟仓库、厂房和工厂、物理和生物系统、5G边缘、机器人、自动驾驶汽车,”黄仁勋说。

可以看出,英伟达在这次GTC大会上进一步坚定了「进军元宇宙」的决心!其中,人工智能阿凡达平台(NVIDIA Omniverse Avatar)带来了一些令人振奋功能。正如前面所提到的,Omniverse Avatar是一款基于语音、计算机视觉、自然语言理解、推荐引擎和模拟方面的技术生成的交互式AI化身。Avatar是具有光线跟踪3D图形的互动角色,可以看到、说话、就广泛的主题进行交谈,并理解自然对话的意图。Omniverse Avatar为创建人工智能助手打开了大门,这些助手几乎可以为任何行业轻松定制。这些可以帮助处理数十亿的日常客户服务互动,包括餐厅订单、银行交易、进行个人预约和预订等等。比如这个餐厅客户服务Avatar就可以同时和两个顾客进行交谈和理解。黄仁勋表示:「Omniverse Avatar结合了英伟达的基础图形、模拟和人工智能技术,使一些有史以来最复杂的实时应用程序得以诞生。协作机器人和虚拟助手的使用案例令人难以置信,影响深远。」Avatar的语音识别基于英伟达Riva,这是一个软件开发工具包,可以识别多种语言的语音。Riva还被用来利用文本到语音功能生成类似人类的语音反应。Avatar的自然语言理解是基于Megatron 530B大型语言模型,可以识别、理解和生成人类语言。Megatron 530B预训练模型在各种自然语言任务如:完形填空、阅读理解、常识推理、自然语言推理、词义消歧中纷纷实现SOTA。

除了可以回答问题、总结长而复杂的故事,还可以在没有经过专门训练的领域处理相应的问题。Avatar的推荐引擎由NVIDIA Merlin提供,该框架允许企业建立能够处理大量数据的深度学习推荐系统,以提出更智能的建议。 Avatar的感知能力由NVIDIA Metropolis提供,这是一个用于视频分析的计算机视觉框架。Avatar的头像动画由NVIDIA Video2Face和Audio2Face(二维和三维AI驱动的面部动画和渲染技术)驱动。Omniverse Avatar将这些技术组成一个应用程序,并使用NVIDIA统一计算框架进行实时处理。Showroom是一个包含演示和示例应用程序,展示了Omniverse核心技术。Farm一个系统层,用于协调跨多个系统、工作站、服务器和虚拟化批作业处理,可以用于批量渲染,AI合成数据生成或分布式计算。Omniverse AR可以将将图形串流到手机或者AR眼镜。Omniverse VR是英伟达首款全帧交互式光线追踪VR。英伟达还推出了下一代 InfiniBand 网络平台Quantum-2,该平台可提供云计算提供商和超级计算中心所需的极致性能、广泛的可访问性和强大的安全性。作为有史以来最先进的端到端网络平台,NVIDIA Quantum-2是一个400Gbps InfiniBand网络平台,由NVIDIA Quantum-2交换机、ConnectX-7网络适配器、BlueField-3数据处理单元(DPU)和所有支持新架构的软件。NVIDIA Quantum-2的推出,正值超级计算中心向越来越多地用户开放之际,其中许多用户来自这些计算中心之外。与此同时,全球的云服务提供商也开始为客户提供更多的超算服务。凭借400Gbps的高带宽,NVIDIA Quantum-2 InfiniBand让网络速度加倍,网络端口数量增加了3倍。性能提高了3倍,对数据中心结构交换机的需求减少了6倍,同时降低了数据中心功耗,数据中心占用的空间也减少了7%。与上一代技术相比,NVIDIA Quantum-2 SHARPv3网络计算技术为AI应用程序提供了32倍的加速引擎。Quantum-2平台的核心是新的Quantum-2 InfiniBand交换机。它搭载570亿个晶体管,比拥有540亿个晶体管的NVIDIA A100 GPU略大。它具有64个400Gbps端口或128个200Gbps端口,并将在各种交换机系统中提供,多达 2,048个400Gbps端口或4,096个200Gbps 端口。交换能力是上一代Quantum-1的5倍以上。在网络速度、交换能力和可扩展性上,InfiniBand都非常适合构建下一代巨型HPC系统。NeMo Megatron框架:发力大型语言模型开发

NVIDIA 今天还打开了开发和部署大型语言模型 (LLM) 的大门,推出了用于训练具有数万亿个参数的语言模型的NVIDIA NeMo Megatron框架、可针对新领域和语言进行训练的Megatron 530亿参数的可定制大型语言模型,以及具有多 GPU、多节点分布式推理功能的NVIDIA Triton推理服务器。这些工具提供了一个完备的企业级解决方案,简化了大型语言模型的开发和部署。NVIDIA NeMo Megatron以Megatron项目为基础,Megatron是一个由英伟达研究人员领导的开源项目,旨在大规模研究大型转换器语言模型的高效训练。该框架使用数据处理库自动处理LLM复杂训练,可以获取、管理、组织和清理数据。它使用先进的数据、张量和管道并行化技术,使大型语言模型的训练能够高效地分布在数千个GPU上。NVIDIA Triton推理服务器中的多GPU、多节点功能使LLM推理负载可以实时、跨多个GPU和节点进行扩展。使用Triton推理服务器,Megatron 530B可以在两个NVIDIA DGX系统上运行,将CPU服务器上的处理时间从一分钟多缩短到0.5秒,从而实现在应用程序上快速、实时地部署大型语言模型。Jetson AGX Orin:最小巧、最节能的「AI超算」

Jetson AGX Orin基于NVIDIA Ampere架构,保持与其前身 Jetson AGX Xavier的外形和引脚的兼容性,但处理能力扩大至6倍,每秒可提供200万亿次操作,它类似于支持GPU的服务器,但大小仅相当于人的手掌。Jetson AGX Orin Arm Cortex-A78AE CPU,以及下一代深度学习和视觉加速器,搭载高速接口、更快的内存带宽和多模式传感器,具备处理多个并发AI应用管道的能力。新的 Jetson 计算机可加速完整的 NVIDIA AI 软件栈,使开发人员能够部署最大、最复杂的模型,以解决自然语言理解、3D 感知、多传感器融合等边缘 AI 和机器人任务。同时有消息称,Drive Hyperion 8自动平台现已准备投入生产车辆。GTC大会上,英伟达还宣布了2项新人工智能驱动软件技术——Nvidia Drive Concierge 和 Drive Chauffeur。

Nvidia Drive Concierge 是一个AI助理,它结合了语音辅助、驾驶员监控和自动停车技术。然而,最酷的是它与 Nvidia Drive AV 自动驾驶技术的集成,提供按需代客泊车。Drive Concierge 可以执行从简单到复杂的自然语音命令,比如打电话预订,并且根据每个乘客的声音进行个性化设置,为每个乘客提供自己的虚拟助手。

来源:新智元、腾讯科技

参考资料:

https://www.nvidia.cn/gtc-global/keynote/

行业交流、合作请加微信:icsmart01

芯智讯官方交流群:221807116