本文为论文介绍,建议阅读5分钟

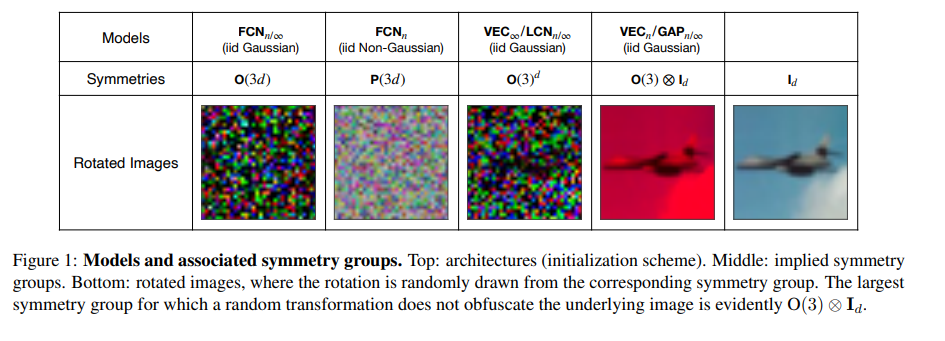

当这些对称性与数据分布的对称性相容时,学习效率最高。

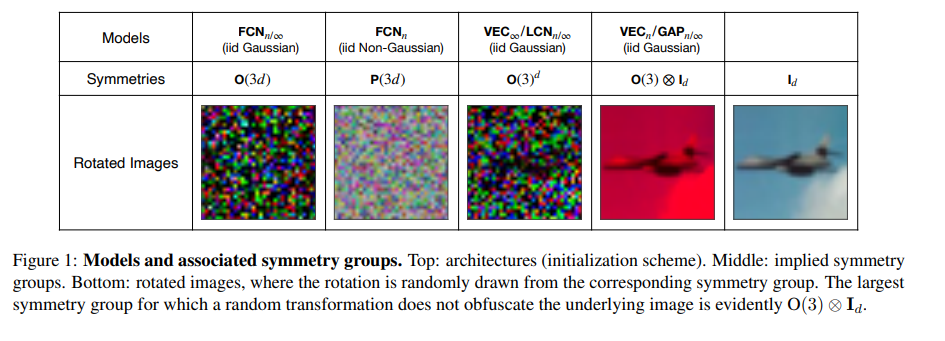

尽管人们普遍认为高维学习面临维数灾难,但现代机器学习方法往往表现出惊人的能力,可以在不使用大量数据的情况下解决各种具有挑战性的现实世界学习问题。这些方法究竟是如何打破这一诅咒的,仍然是深度学习理论中一个根本的开放问题。虽然以前的努力通过研究数据(D)、模型(M)和推理算法(I)作为独立模块来研究这个问题,但在本文中,我们将三元组(D, M, I)作为一个集成系统来分析,并识别有助于减轻维度诅咒的重要协同作用。我们首先研究了与各种学习算法(M, I)相关的基本对称性,重点关注深度学习中的四种原型架构:全连接网络(FCN)、本地连接网络(LCN)和带池化和不带池化的卷积网络(GAP/VEC)。我们发现,当这些对称性与数据分布的对称性相容时,学习效率最高,而当(D, M, I)三元组中的任何成员不一致或次优时,学习效率显著下降。

https://arxiv.org/pdf/2207.04612.pdf

下载APP

下载APP