谷歌给NeRF动了个小手术,2D变3D,照片视角随心换

新智元报道

新智元报道

来源:arxiv等

编辑:白峰

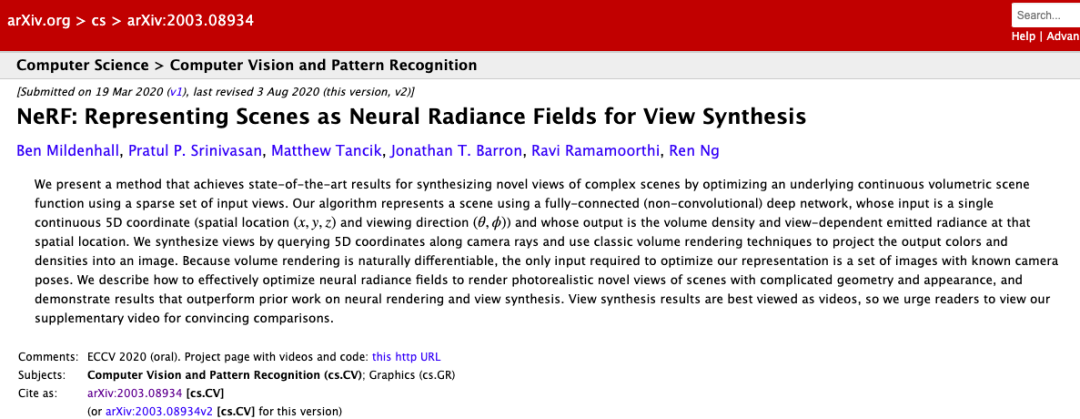

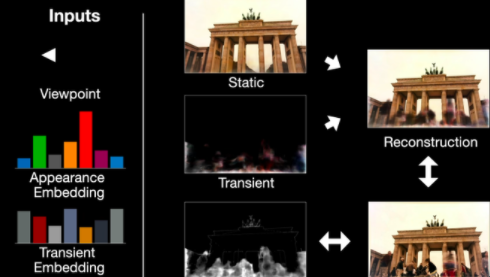

【新智元导读】近日,Google研究人员又开发了一个3D场景转换的新模型,该模型基于之前大火的神经辐射场,可以在变化的场景和遮挡下重构出逼真的3D动态场景。

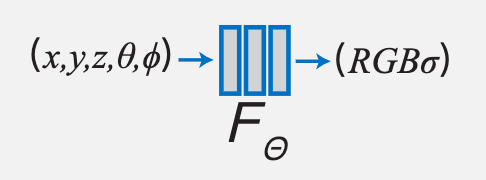

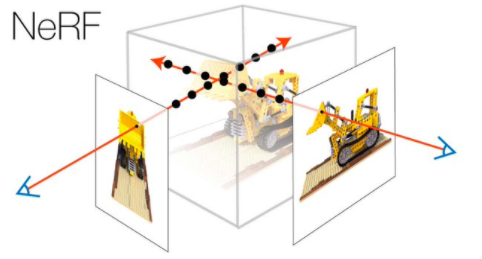

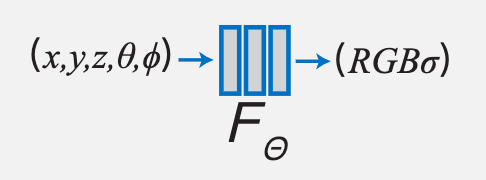

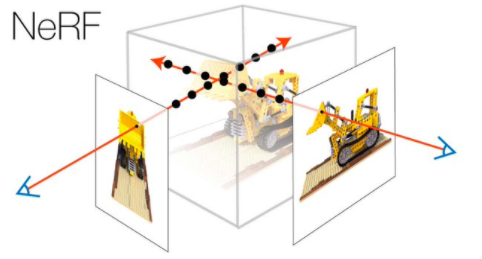

3D场景重构神器:神经辐射场

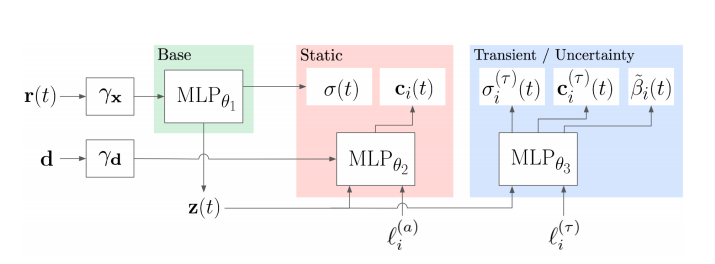

对NeRF动个小手术,让它适应变化的场景

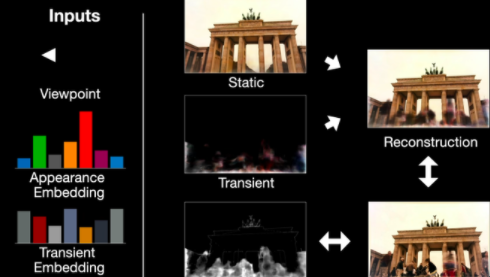

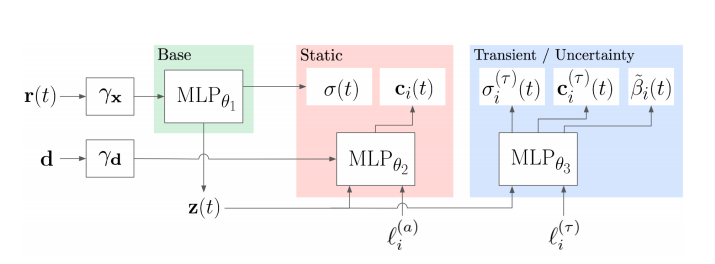

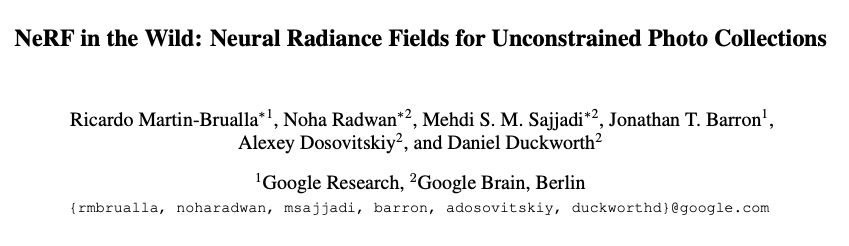

NeRF-W架构

NeRF-W架构

评论

下载APP

下载APP

新智元报道

来源:arxiv等

编辑:白峰

NeRF-W架构

NeRF-W架构