呜啦啦啦啦啦啦啦大家好,原AI Scholar Weekly改版,融合AI时事新闻内容再度来袭!AI大事件是AI领域的综合性专栏,致力于为你带来最新潮、最全面、最深度的AI行业概览,从硬核的学术内容到精品产业新闻,为你一网打尽每周AI的前沿资讯。

本周关键词:Waymo无人出租车、LSTM VS BERT、自然语言理解

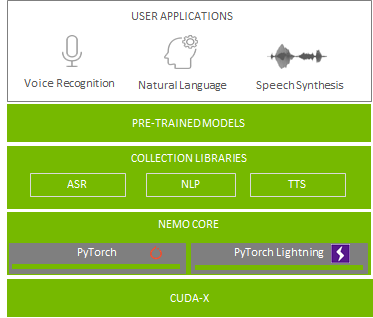

使用三行代码快速编写和训练复杂的、最先进的神经网络体系结构。http://cur.at/VDqBxbA?m=web

Papers with Code日前宣布,arXiv现在将允许研究人员在提交研究论文的同时提交代码,这使得计算机科学家可以简单地与其他研究人员分享自己的代码,从而能够更好地分析、审查或复制人工智能研究的新进展。https://venturebeat.com/2020/10/08/arxiv-now-allows-researchers-to-submit-code-with-their-manuscripts/?utm_campaign=AI%20Weekly&utm_medium=email&utm_source=Revue%20newsletterWaymo在亚利桑那州菲尼克斯市的机器人出租车服务现在已经向公众开放了。https://venturebeat.com/2020/10/08/waymos-robo-taxi-service-opens-to-the-public-in-phoenix/美国国会对亚马逊、苹果、Facebook和谷歌进行的调查发现,为了保持其在互联网行业的竞争力,可能需要反垄断法改革。https://www.getrevue.co/profile/AI_Weekly/issues/ai-weekly-october-9-2020-283293

建立在BERT架构上的文献呈现了很多破纪录的结果。然而,这样的模型往往需要非常大的数据集来调整和预训练。但如果我们只有一个小数据集呢?研究人员将LSTM模型与BERT模型在以任务为导向的小数据集上进行了比较。他们选择了一个意图分类任务,使用一个用于构建聊天机器人的小数据集。研究人员使用不同的LSTM架构进行了实验。在测试中他们发现,最简单的LSTM架构最适合这个数据集。与BERT相比,LSTM在验证数据和测试数据方面具有更高的准确性,在统计学上表现显著。此外,实验结果表明,对于较小的数据集,BERT比简单的LSTM结构更适合。https://arxiv.org/pdf/2009.05451v1.pdf?utm_campaign=AI%20Scholar%20Weekly%20&utm_medium=email&utm_source=Revue%20newsletter本研究介绍了任务型对话中的自然语言理解基准——DialoGLUE,可以促进和鼓励基于表征迁移、领域适应和样本有效任务学习的对话研究。任务对话系统可以通过文本、语音、图形、手势等与人类进行交流。他们可以解决许多问题,如订票、下订单、安排电话和帮助用户处理请求等等。因此,DialoGLUE系统在自动化各种业务流程方面具有巨大的潜力,其中包括提高运营速度、个性化客户服务、降低劳动力成本、提升全天候可用性等等。通过对DialoGLUE基准的几种基线方法的评价,研究人员验证了大规模开放域对话预训练和任务自适应自监督训练的有效性。结果表明,DialoGLUE尚有很大的改进空间。DialoGLUE基准测试是开源的,并向研究社区提供了排行榜。https://arxiv.org/pdf/2009.13570v1.pdf?utm_campaign=AI%20Scholar%20Weekly%20&utm_medium=email&utm_source=Revue%20newsletter实习/全职编辑记者招聘ing

加入我们,亲身体验一家专业科技媒体采写的每个细节,在最有前景的行业,和一群遍布全球最优秀的人一起成长。坐标北京·清华东门,在大数据文摘主页对话页回复“招聘”了解详情。简历请直接发送至zz@bigdatadigest.cn