去年,来自上海科技大学和腾讯 AI Lab 的研究者的研究论文《Liquid Warping GAN: A Unified Framework for Human Motion Imitation, Appearance Transfer and Novel View Synthesis》入选计算机视觉顶会 ICCV 2019。经过一年的努力,该论文所提方法的改进版诞生了。先来看看效果如何?

不如跳舞:只需要一张或多张人物图像,再提供一个跳舞视频,原本静止的人物就能轻松学会跳舞。衣服等细节信息一致性良好,就是脚步有点飘……

如下视频所示,舞蹈的转身和面向背后的动作合成效果都有所提升。据新论文《Liquid Warping GAN with Attention: A Unified Framework for Human Image Synthesis》介绍,改进版的优势在于源图像的数量从一张变为一组。以动作合成为例,源图像是一组不同视角的图像,因此合成结果从多个角度看起来效果更好。

论文地址:https://arxiv.org/pdf/2011.09055.pdf

GitHub 地址:https://github.com/iPERDance/iPERCore

项目主页:https://www.impersonator.org/work/impersonator-plus-plus.html

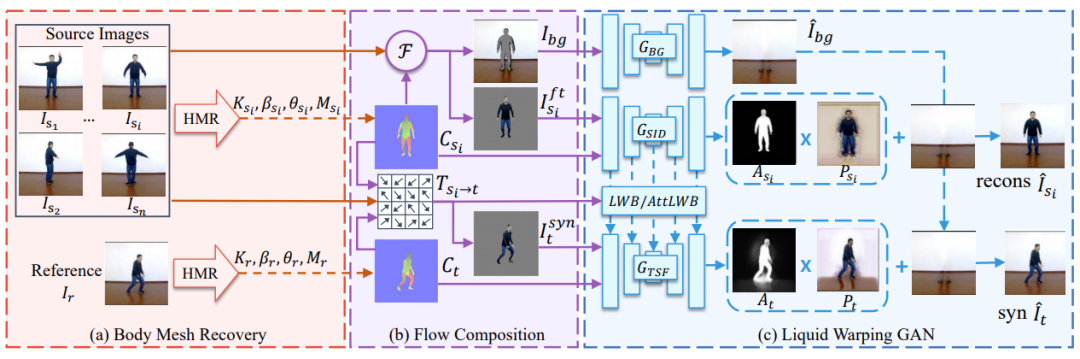

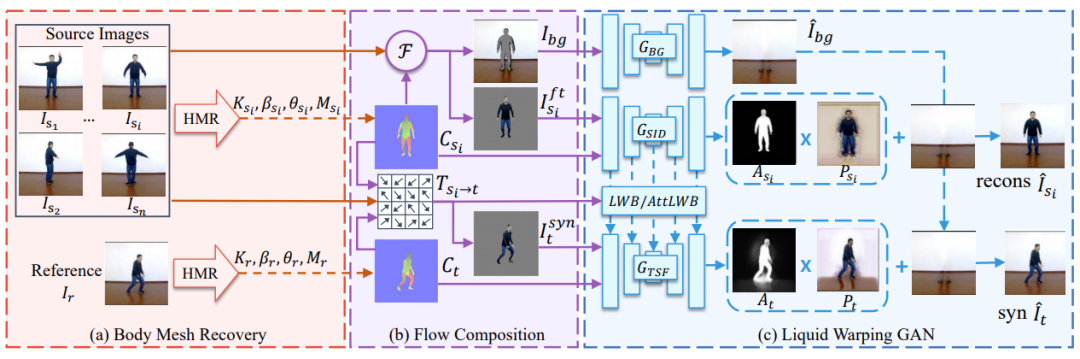

该研究在一个统一的框架内处理人体图像合成,包括人体动作模仿、外观迁移以及新视图合成。经过训练的模型,能够处理这些任务。现有的任务特定方法多数使用 2D 关键点(姿态)来估计人体结构。然而,此类方法只表达位置信息,既无法表征人物的个性化姿态,也不能对肢体旋转进行建模。针对以上问题,该研究提出使用 3D 人体网格复原模块来解析人体姿态和形状,这样不仅可以对人体关节位置和旋转进行建模,还可以表征个性化的人体形状。为了保存源信息(如纹理、风格、颜色、人脸身份信息),该研究提出了一个新模型 Attentional Liquid Warping GAN,它包含 Attentional Liquid Warping Block (AttLWB),能够在图像和特征空间中将源信息传播到合成参考中。具体而言,为了较好地表征源图像的识别性信息,该研究采用去噪卷积自动编码器提取源特征。此外,该方法还可以支持来自多源的更灵活的 warping。为了进一步提高未知源图像的泛化能力,该研究采用了 one/few-shot 对抗学习。具体来说,它首先在一个广泛的训练集中训练一个模型。然后,通过 one/few-sho 未知图像以自监督的方式进行模型优化,得到高分辨率(512 × 512 和 1024 × 1024)的生成结果。同时,该研究还建立了一个新的数据集,即 Impersonator(iPER)数据集,用于评估人体运动模仿、外观迁移和新视图合成。大量的实验证明了本文所用方法在保持面部信息、形态一致性和衣服细节方面的有效性。该方法包含 3 个部分:人体网格复原(body mesh recovery)、流组成(flow composition)、带有 Liquid Warping Block(LWB)或 Attentional Liquid Warping Block(AttLWB)的 GAN,如下图 3 所示:

训练流程如下:从视频中随机采样一组图像,将源图像和参考图像分别表示为 I_s_i 和 I_r。人体网格复原模块估计每个图像的 3D 网格,并渲染对应图 C_s 和 C_t。

流组成模块首先基于两张对应图及其在图像空间中的投影顶点来计算变换流 T。然后它将源图像 I_s_i 分离成前景图 I_s_i^ft 和背景蒙版 I_bg。最后该模块基于变换流 T 对源图像进行处理,生成扭曲(warped)图像 I_syn。

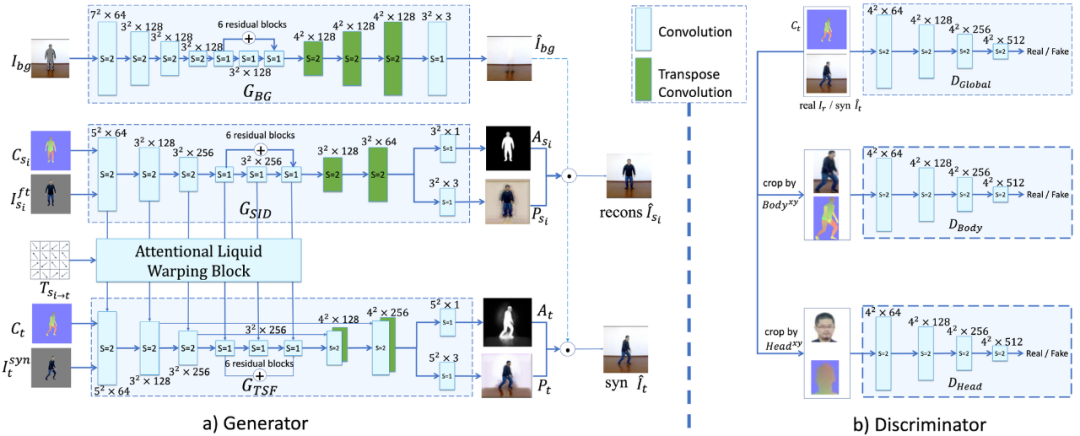

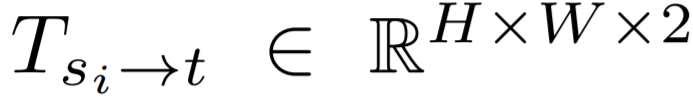

在 GAN 模块,生成器由 3 个流组成:生成背景图像的 G_BG、重建源图像的 G_SID、在参考条件下合成目标图像的 G_TSF。

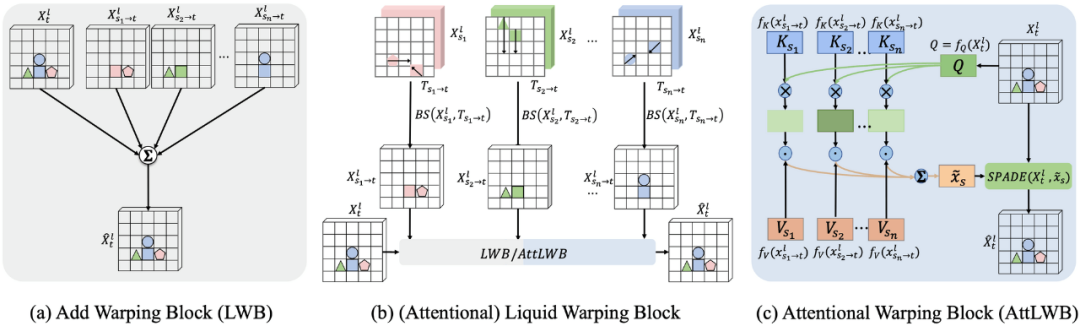

为了保留源图像的细节,该研究提出了一种新型的 LWB 和 AttLWB,其中 AttLWB 将 G_SID 的源特征在几层中传递到 G_TSF,并保留源信息(例如纹理、样式风格和颜色)。

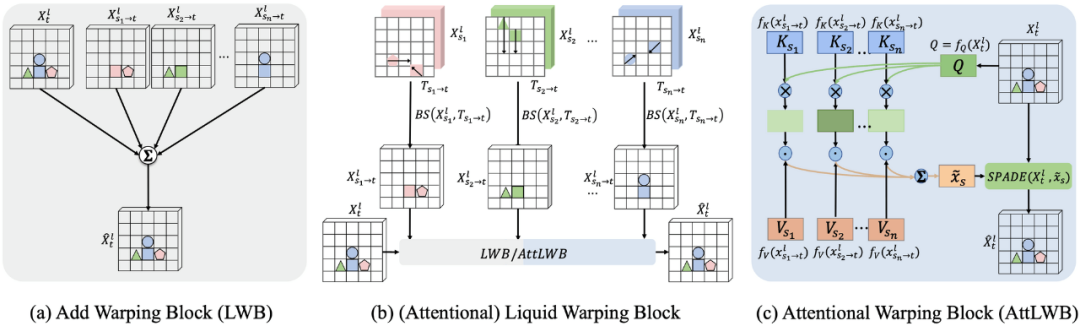

LWB 和 AttLWB 的结构。它们有如图(b)所示的相同结构。(a)是 AddWB 的结构,(b)是 (Attentional) Liquid Warping Block 的共有结构,(c) 是 AttWB 的架构。

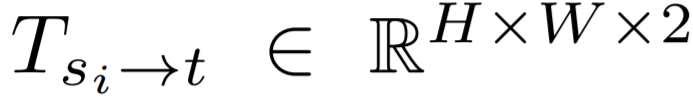

值得注意的是,Attentional Liquid Warping Block 相比于 Liquid Warping Block,解决了多源问题。如上图所示,以模仿人类动作为例,该框架支持多个输入源,将源图像表示为{I_s_1,I_s_2,...,I_s_n},参考图像是 I_r。其中,s_n 是源图像的数目。如图 3 (a)所示,给定源图像 I_s_i 和参考图像 I_r,该阶段的作用是预测运动姿态 (肢体的旋转) 和形态参数,以及每个图像的 3D 网格。为了在准确率和效率之间取得良好的平衡,该研究采用 HMR 作为 3D 姿态和形态估计器。在已有估计的基础上,该研究首先利用相机视图,为每个源网格和参考网格渲染一个对应关系图和权重索引图。这个步骤主要使用完全可微的渲染器神经网格渲染器(NMR)来完成。然后,计算每个网格 face 的重心坐标,得到 。接下来,该方法通过匹配源对应图与其网格 face 坐标 f_s_i 之间的对应关系,来计算变换流

。接下来,该方法通过匹配源对应图与其网格 face 坐标 f_s_i 之间的对应关系,来计算变换流 ,并以同样的方法计算参考对应图的变换流。这样就得到了前景图像 I_s_i^ft 和蒙版背景图像 I_s_i^bg,并随机选择一个蒙版背景图像充当 I_bg。最后,通过变换流将每个源图像的可见纹理扭曲(warp)到所需条件,从而得到合成图像 I_t^syn。Attentional Liquid Warping GAN在 Attentional Liquid Warping GAN 阶段,该方法在理想条件下合成高保真的人体图像。更具体地说,包括 3 个部分:

,并以同样的方法计算参考对应图的变换流。这样就得到了前景图像 I_s_i^ft 和蒙版背景图像 I_s_i^bg,并随机选择一个蒙版背景图像充当 I_bg。最后,通过变换流将每个源图像的可见纹理扭曲(warp)到所需条件,从而得到合成图像 I_t^syn。Attentional Liquid Warping GAN在 Attentional Liquid Warping GAN 阶段,该方法在理想条件下合成高保真的人体图像。更具体地说,包括 3 个部分:合成背景图像;

根据可见部分预测不可见部分的颜色;

从 SMPL 的重建中生成衣服、头发等像素。

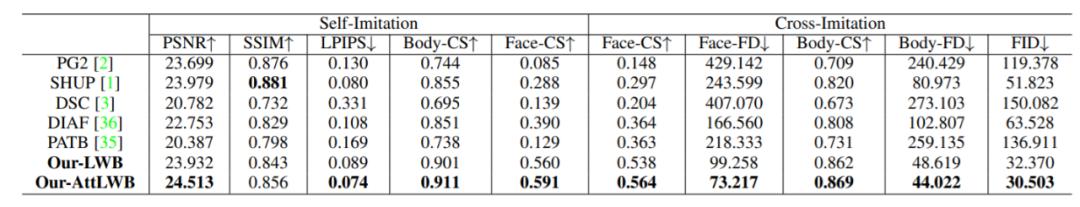

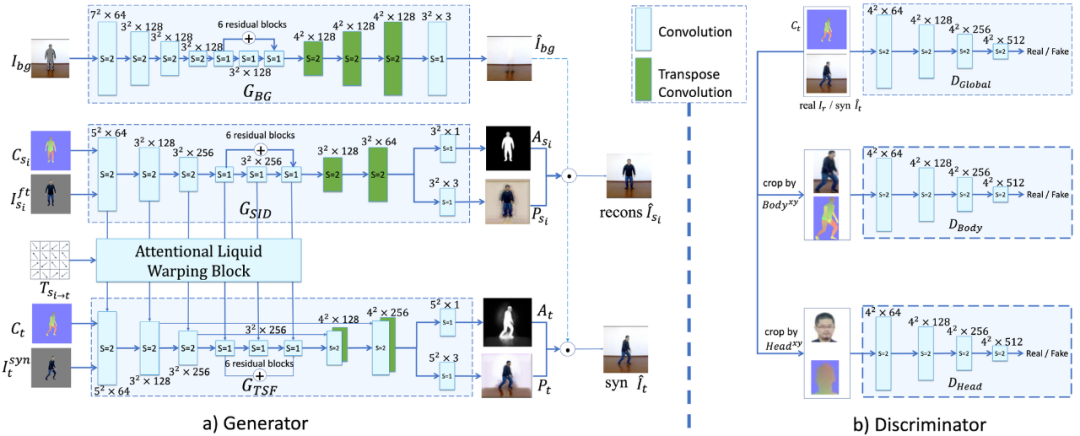

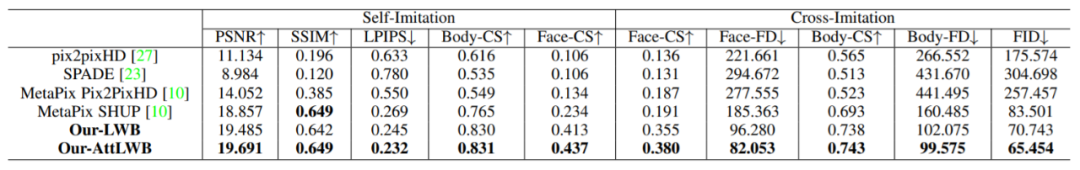

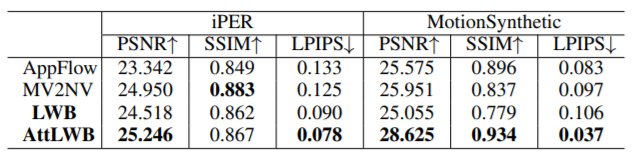

Attentional Liquid Warping GAN 网络架构的具体细节,包括生成器和鉴别器。其中 s 表示卷积和转置卷积中的步长(stride)大小。为了评估所提方法在动作模仿、外观迁移以及新视图合成几项任务上的性能,该研究在 4 个数据集 Impersonator(iPER)、MotionSynthetic、FashionVideo 和 Youtube-Dancer-18 上进行了实验。其中,Impersonator(iPER)数据集为包含不同服装风格的视频数据集,有 30 名受试者的体型、身高和性别各不相同。每个受试者穿着不同的衣服,表演一个 A-pose 视频和一个随机动作的视频。总共有 103 件衣服;MotionSynthetic 数据集是该研究为评估该方法在外观迁移和新视角合成任务上的性能所合成的数据集。下表给出了该研究在 iPER、MotionSynthetic 和 FashionVidieo 数据集上采用不同方法进行人体动作模仿的单样本平均结果。↑代表越大越好,↓反之。但较高的 SSIM 值并不意味着图像质量更好。

如表 2 所示:在 Youtube-Dancer-18 数据集上,对不同方法的人体动作模仿的少样本结果。源图像 s_n 的数目为 2。↑表示越大越好,↓表示越小越好。

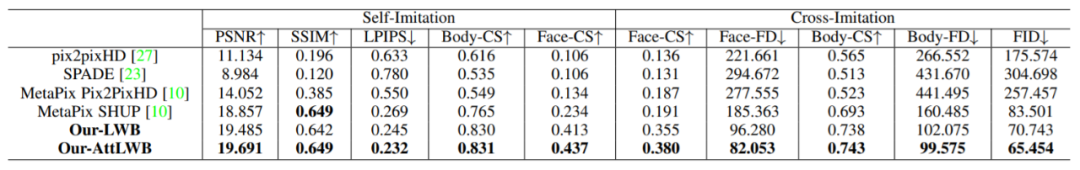

如表 3 所示:该研究在 iPER 数据集上,列出了对 LWB 以及 AttLWB 在外观迁移的结果,这里报告了 PSNR、SSIM、lpip, Body-CS 和 Face-CS。↑表示越大越好。更大的 SSIM 可能并不意味着图像质量更好[63]。

下表给出了在新视图合成任务上,基于 iPER 和 MotionSynthetic 数据集,几种方法的合成结果,包括 AppFlow、MV2NV、LWB 和 AttLWB,可以看到,新方法的 AttLWB 表现良好。

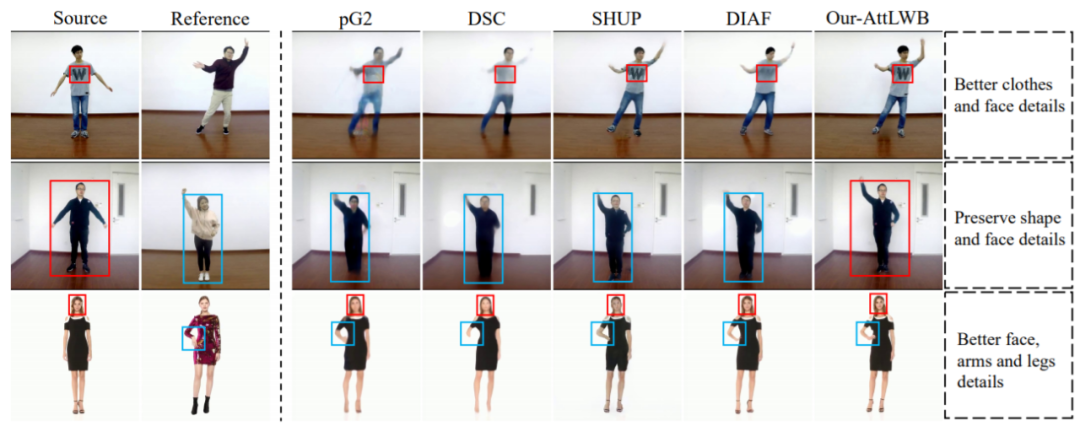

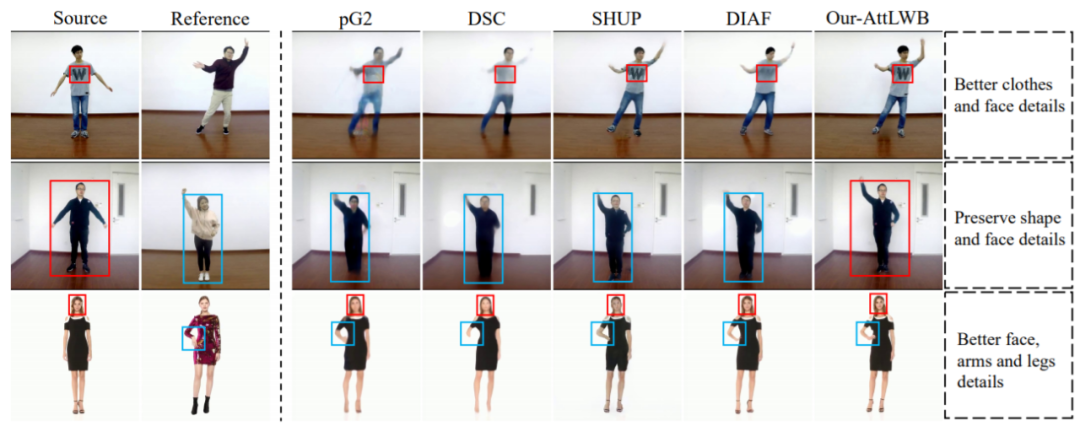

图 9:基于 iPER 和 FashionVideo 数据集,该方法与其他动作模仿合成方法的比较。所有结果的分辨率都为 512×512。用红色和蓝色矩形突出显示细节。微信扫描关注,查看更多内容

。

。 ,并以同样的方法计算参考对应图的变换流。

,并以同样的方法计算参考对应图的变换流。